RLChina2020:强化学习学习资料汇总

强化学习课程

-

David Silver《深度强化算法》 www.bilibili.com/video/BV1kb… 系统介绍强化学习的发展、基本概念以及近年来主流深度强化学习算法。

-

港中文周博磊《强化学习纲要》space.bilibili.com/511221970/c… 介绍强化学习领域基础知识,包括课程概览、马尔科夫决策过程、无模型预测及控制、on-policy 和 off-policy 学习、值函数近似、策略优化基础、策略优化现状、基于模型的强化学习等内容。

-

OpenAI Spinning Up openai.com/blog/spinni… 从RL基础概念讲解,到各重要算法 VPG(Vanilla Policy Gradient), TRPO(Trust Region Policy Optimization), SAC(Soft Actor-Critic) 的原理讲解与代码实现,OpenAI 出品,讲解清晰、代码质量高

-

交大ACM班强化学习课程 www.boyuai.com/RL 本课程为付费课程。为了帮助大家更高效地学习RLChina夏令营老师的课程。我们将于2020年7月19日-8月1日,为大家限时免费开放课程基础部分(强化学习简介-A3C代码实践)并由志愿者们组织集体学习(视频有效期3个月,集体学习活动时间14天)。

机器学习、深度学习基础与代码实践

- 《动手学深度学习》官方网址:zh.gluon.ai/ ——面向中文读者的能运行、可讨论的深度学习教科书。

- 《动手学深度学习PyTorch版代码实践讲解》www.boyuai.com/elites/cour… 《动手学深度学习》是2019年国内最受欢迎的人工智能学习教材之一,伯禹教育携手上海交通大学团队,以此书的知识架构为基础,沿用了其中的原理讲解文档,并将代码框架由MXNET迁移至PyTorch,还对这些优质的实践代码制作了讲解视频。其中部分PyTorch代码来自GitHub开源仓库:github.com/ShusenTang/…

通过这门课程的学习,你将可以对深度学习中常见的方法以及相关的应用有一个从原理到实践的全面了解。

强化学习论文解读-10 mins paper

B站视频:10 Mins Paper RL相关 DQN www.bilibili.com/video/BV1H4…

DDPG www.bilibili.com/video/BV18E…

TD3 www.bilibili.com/video/BV1nE…

PPO www.bilibili.com/video/BV1pE…

Soft Actor-Critic www.bilibili.com/video/BV1pE…

QMIX www.bilibili.com/video/BV1pE…

VDRL www.bilibili.com/video/BV1nE…

Nash Q-Learning www.bilibili.com/video/BV1mE…

RL with Deep Energy-Based Policies www.bilibili.com/video/BV1pE…

Interactive Teaching Algorithm for IRL www.bilibili.com/video/BV1mE…

Least-Squares Temporal Difference Learning www.bilibili.com/video/BV1nE…

IntelliLight 强化学习控制信号灯 www.bilibili.com/video/BV1K4…

图文:《10 Mins Paper:经典强化学习算法专题》

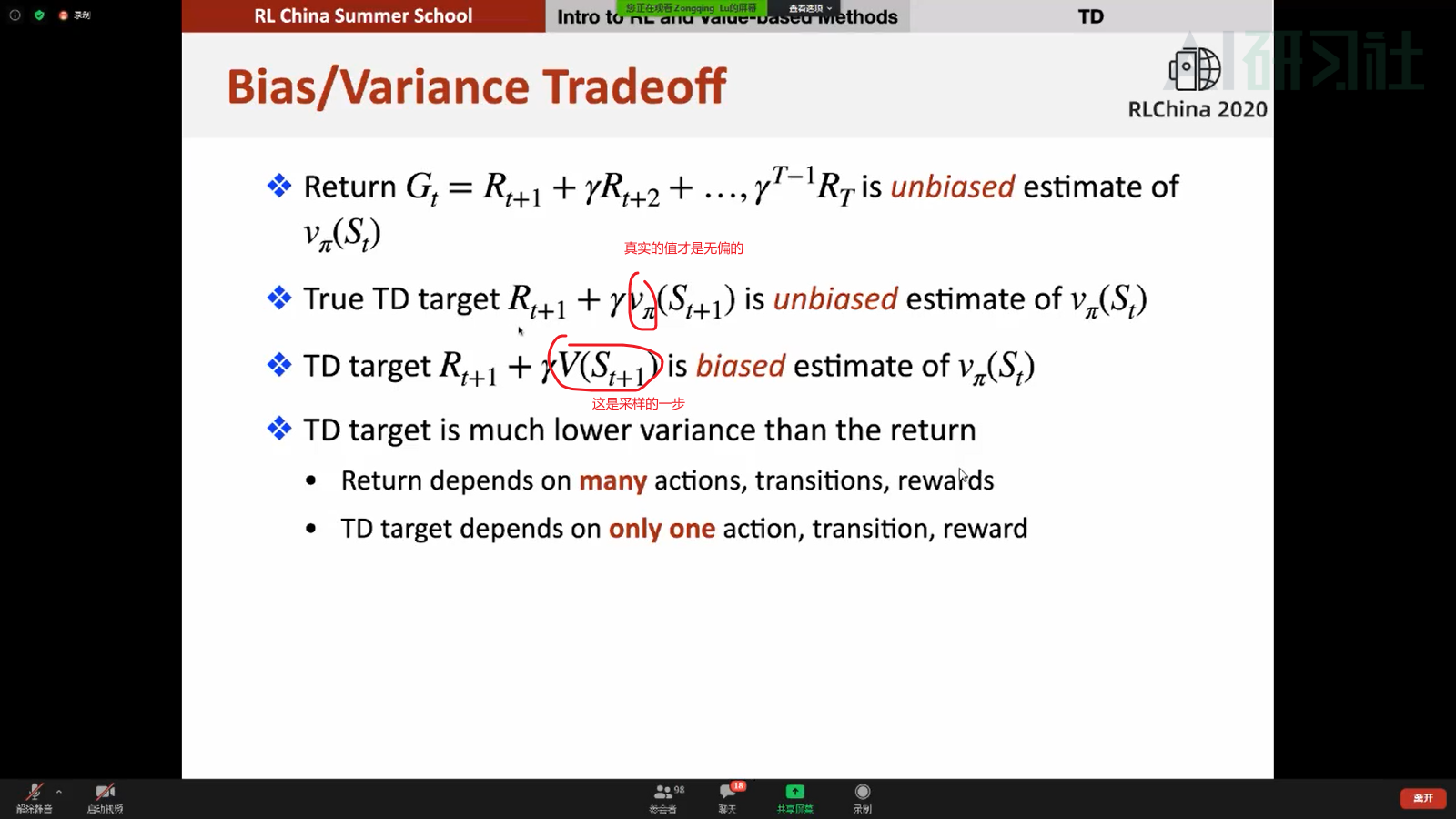

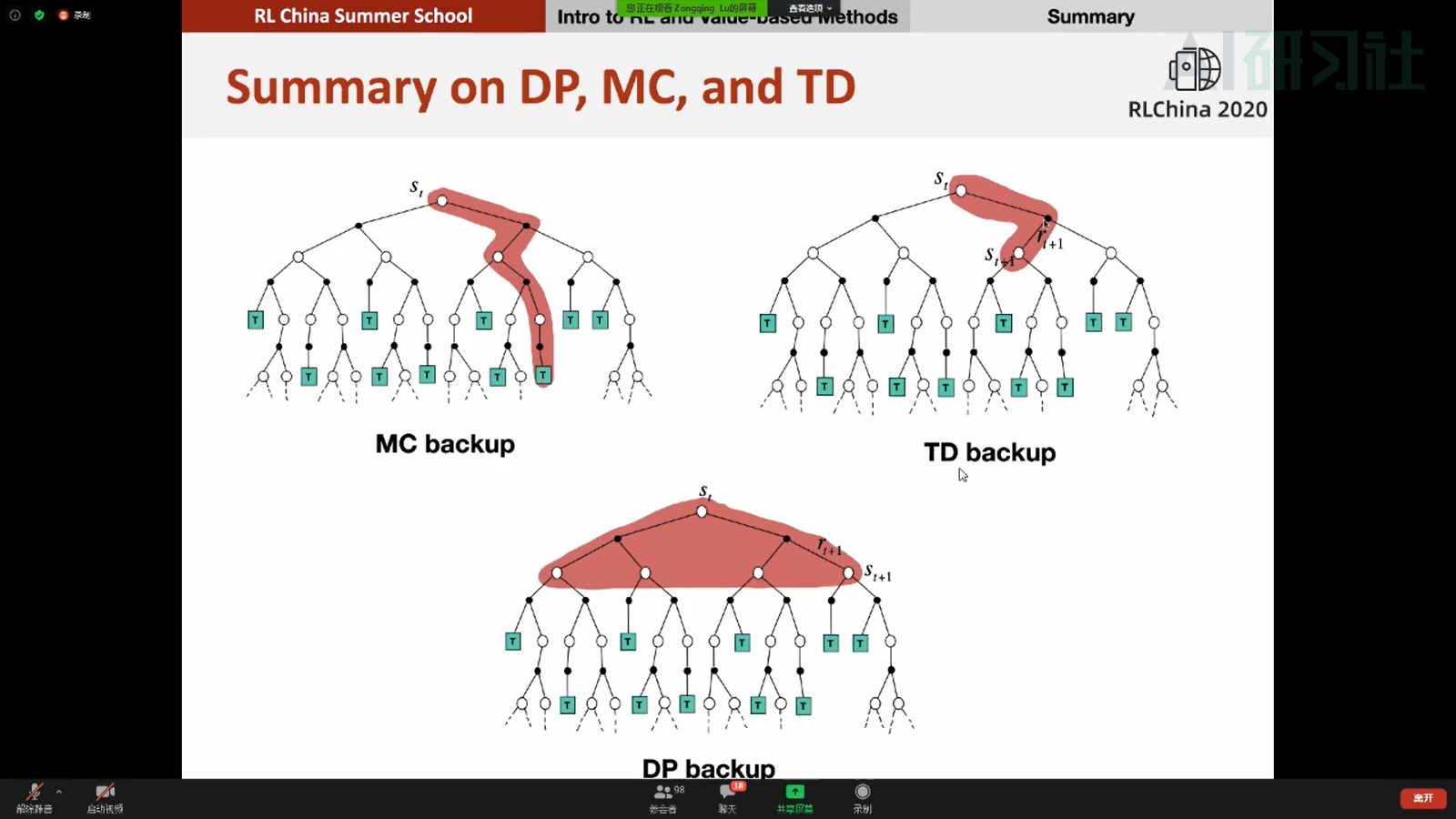

1.Temporal Difference Learning

2.Off-Policy Maximum Entropy Deep Reinforcement Learning with a Stochastic Actor

3.Off-policy maximum entropy deep reinforcement learning with a stochastic actor

- Addressing Function Approximation Error in Actor-Critic Methods

强化学习讲座视频

长文+视频:《强化学习入门讲座及答疑 |附讲座视频》 mp.weixin.qq.com/s/wYYBFLj4x…

工智能科研学习心得与指导

长文:《张伟楠老师教你如何搞科研、写论文》 mp.weixin.qq.com/s?__biz=MzU…

长文:《严骏驰老师与你一起探讨科研与实践结合问题》 mp.weixin.qq.com/s?__biz=MzU…

长文:《“Re-search是不怕失败的坚持探索 ”,屠可伟老师与你分享10年NLP科研心得》 mp.weixin.qq.com/s?__biz=MzU…

长文:《AI学习:从理论到实践,原来你也踩过这些”坑“(内附博士生导师建议)》 mp.weixin.qq.com/s?__biz=MzU…

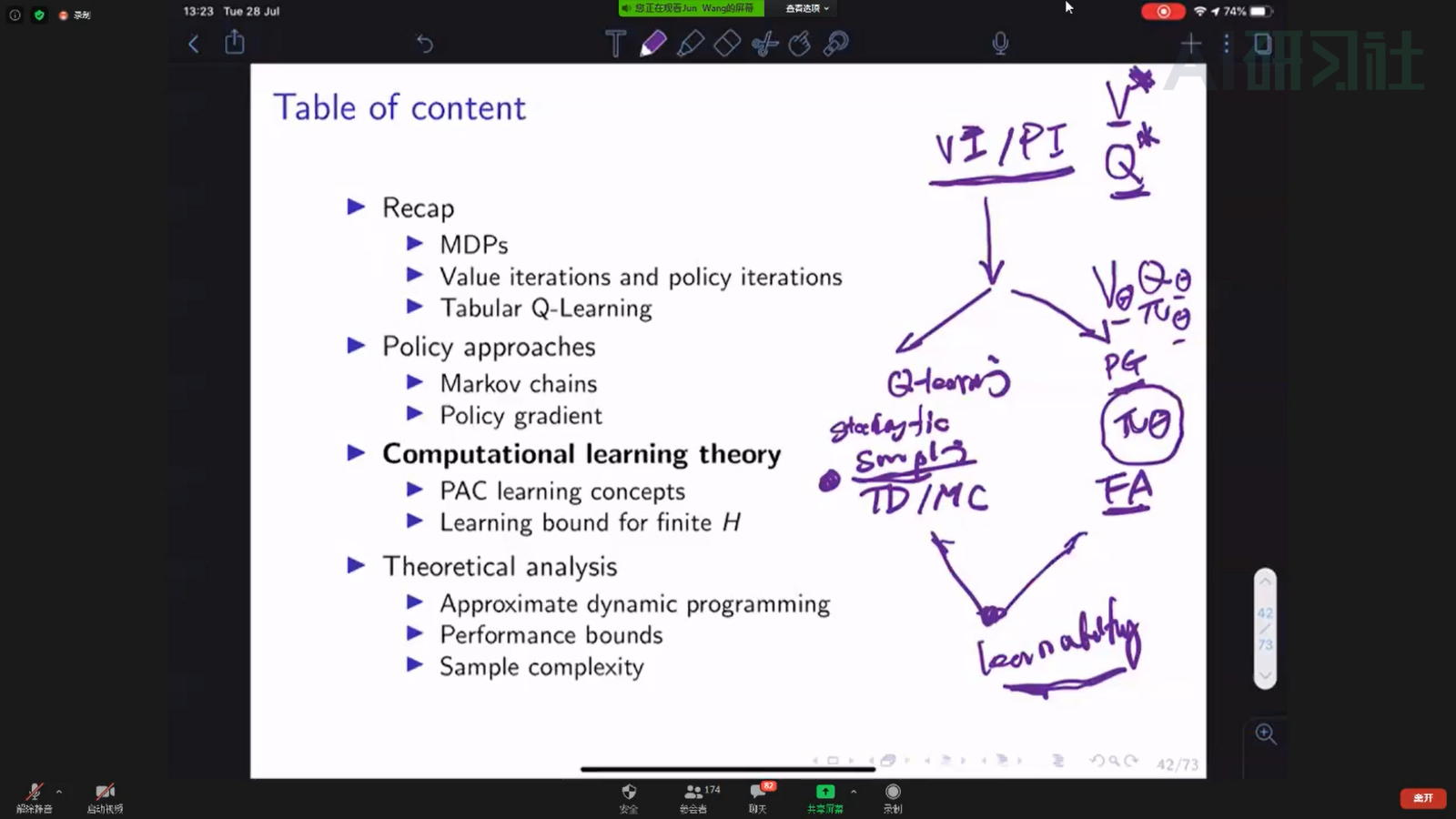

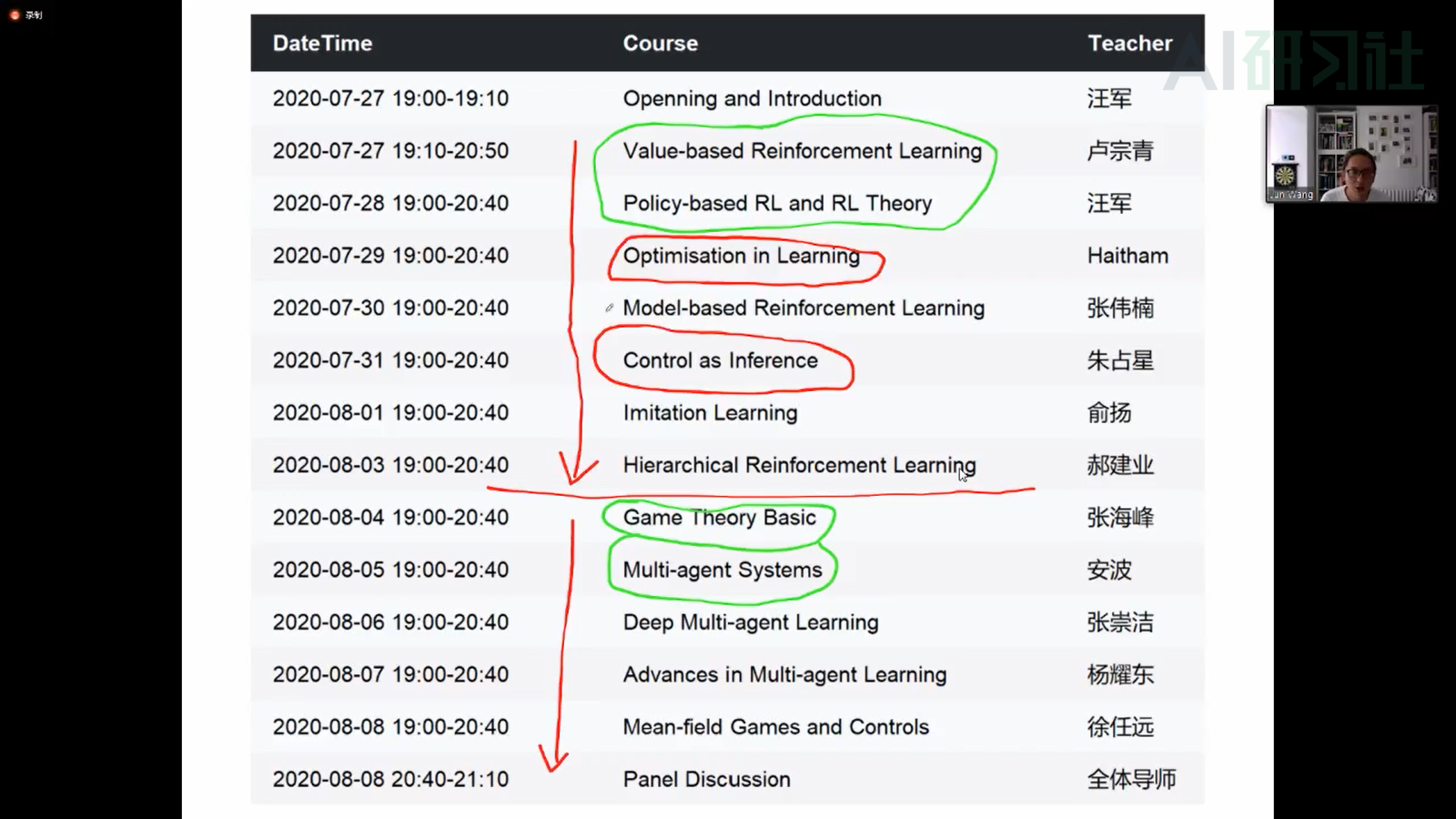

课程介绍

- 绿色:基础

- 其他:进阶

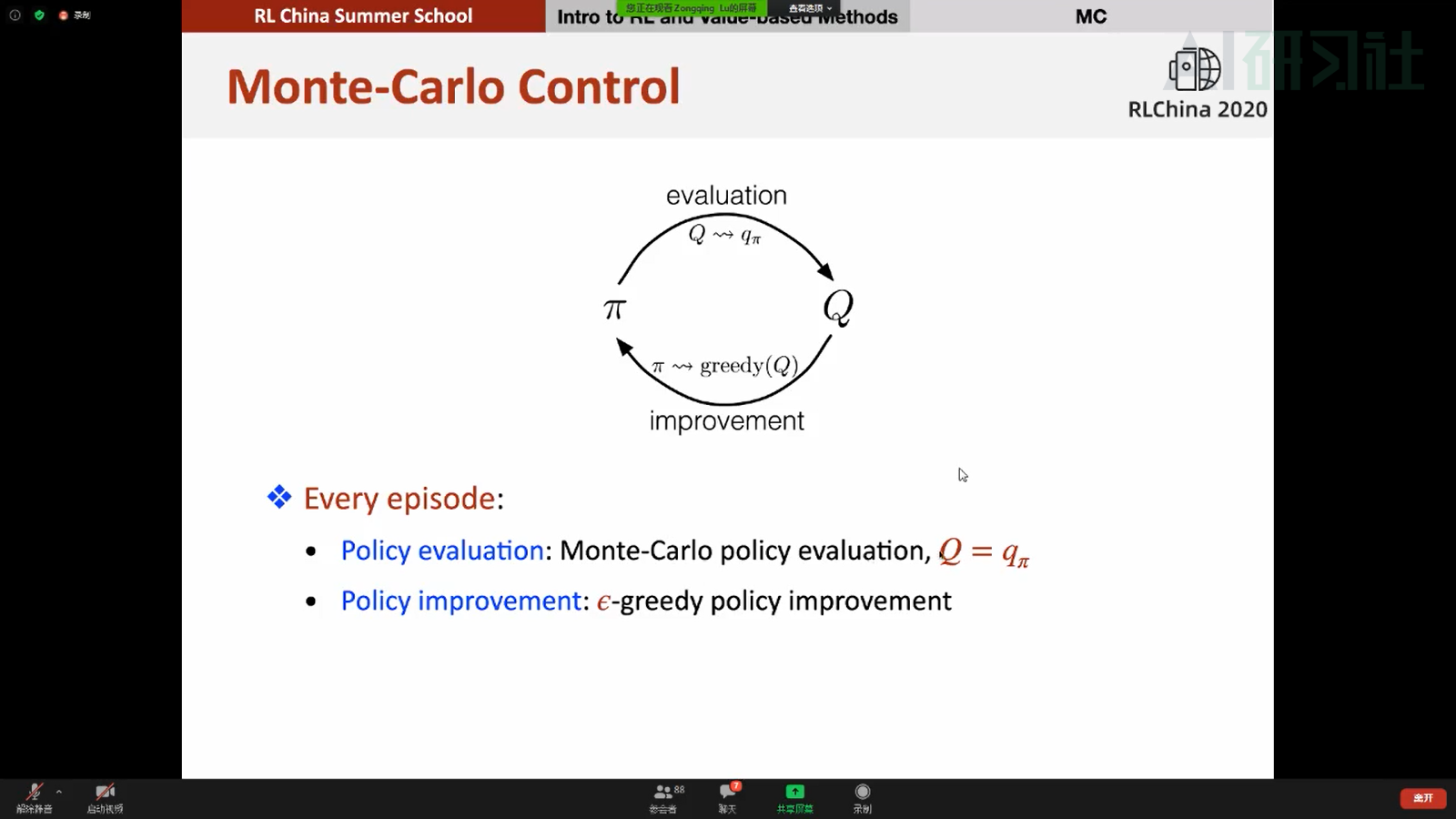

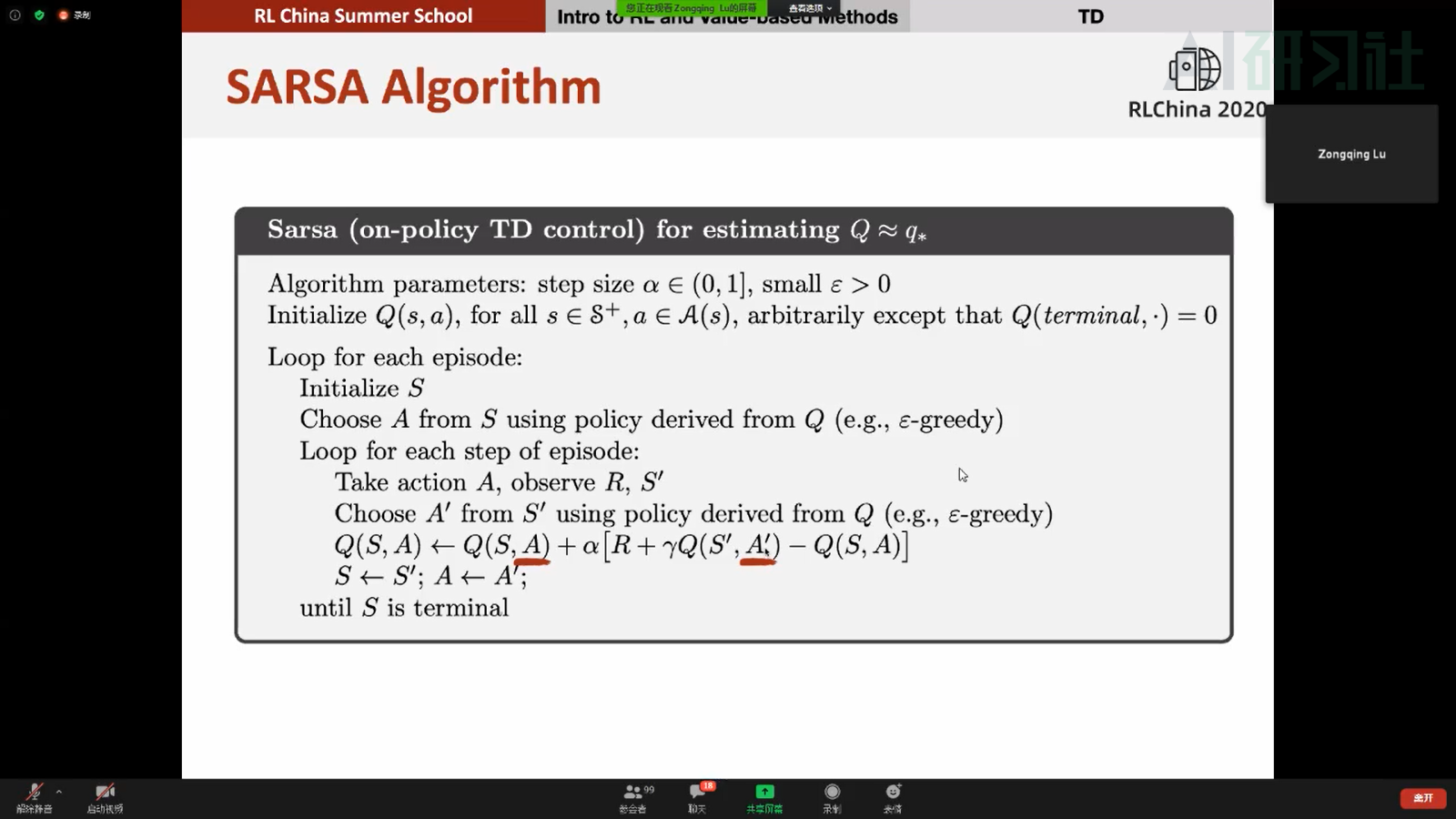

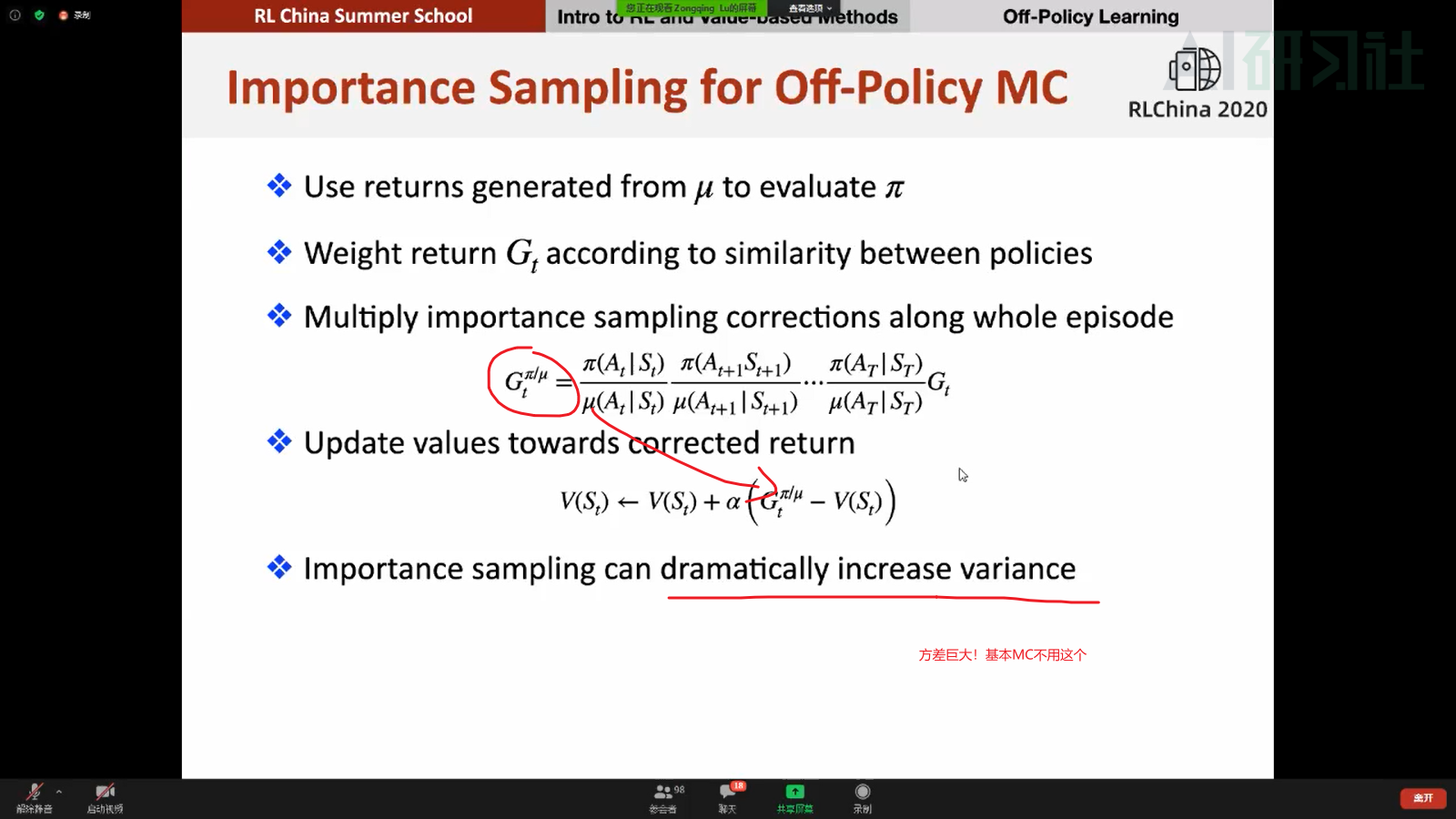

Lecture1 Value-based Methods

折扣因子可以保证强化学习算法的收敛性

k指的是迭代的次数,和t不同(书上)

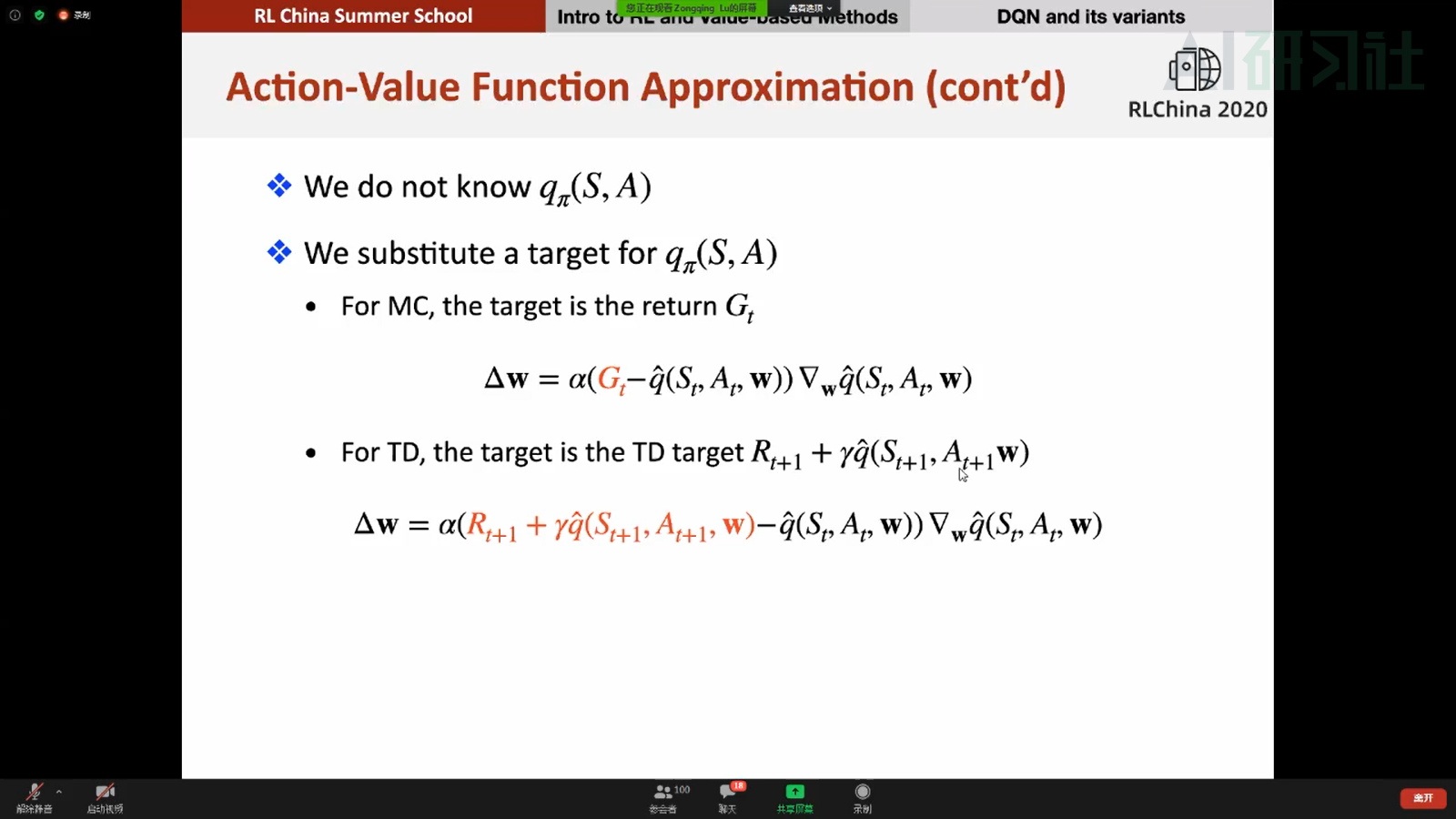

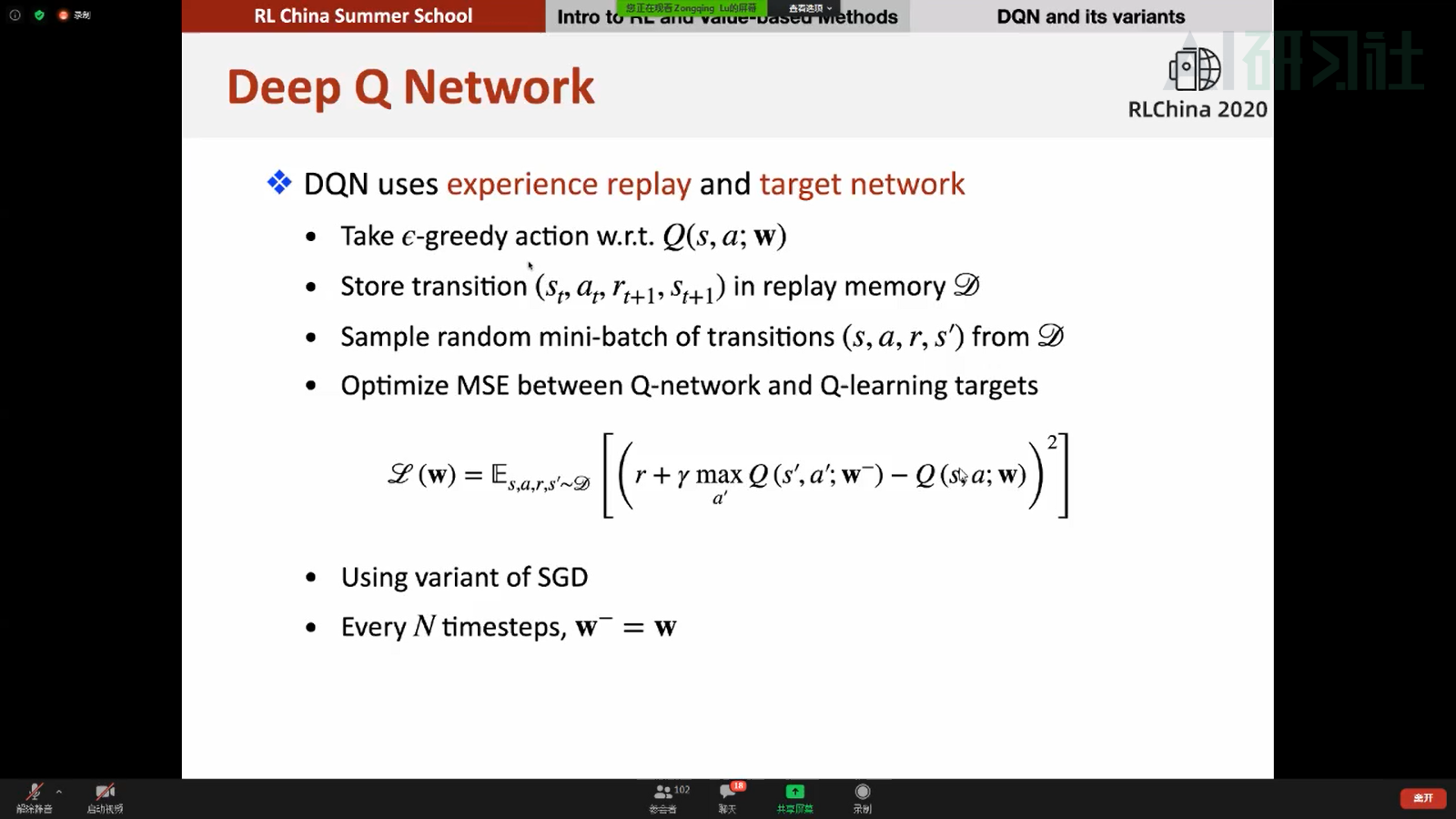

♥直接用神经网络存在的问题:

- online去做得到的state是非常相关的,不符合监督学习的一些假设(数据相关性太强无法计算梯度)------experience replay

- Target Value一直都在变(真正的真实值是不会变的)-----target network(没n步更新一次,n步内是不会变的,作为一个近似真实值的作用)

DQN解决上面两个问题:

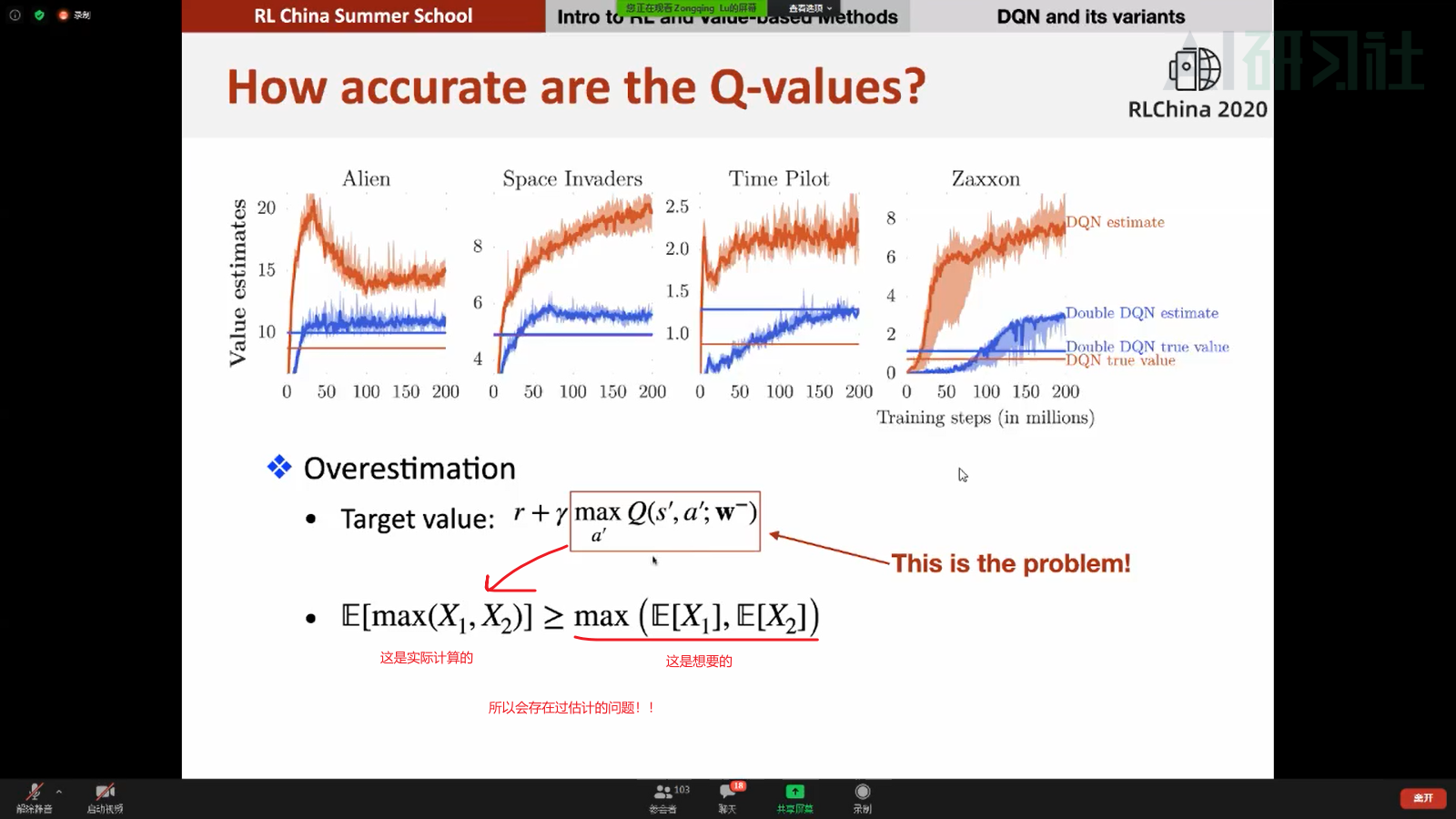

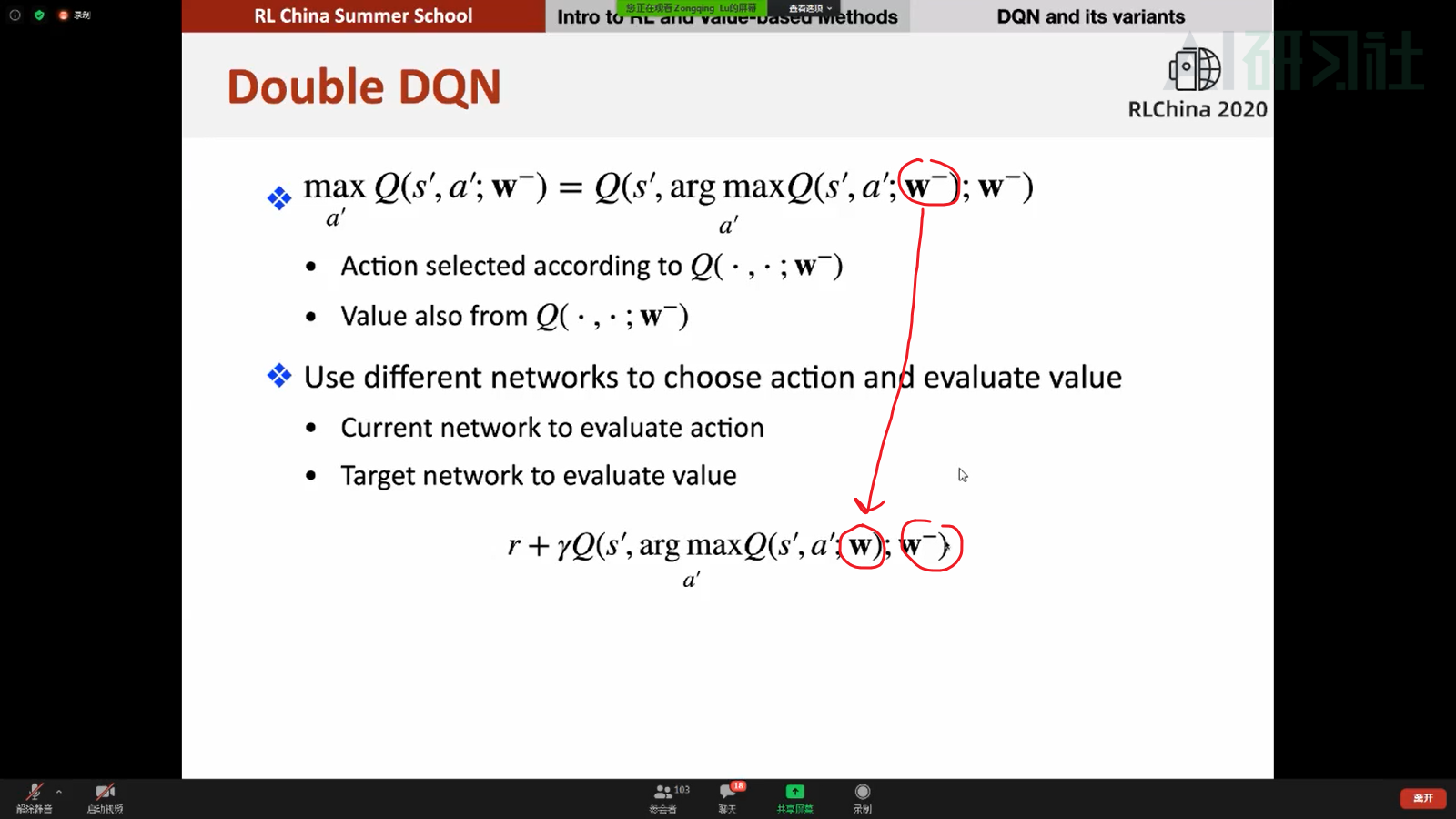

DDQN:减轻over_extimate的问题

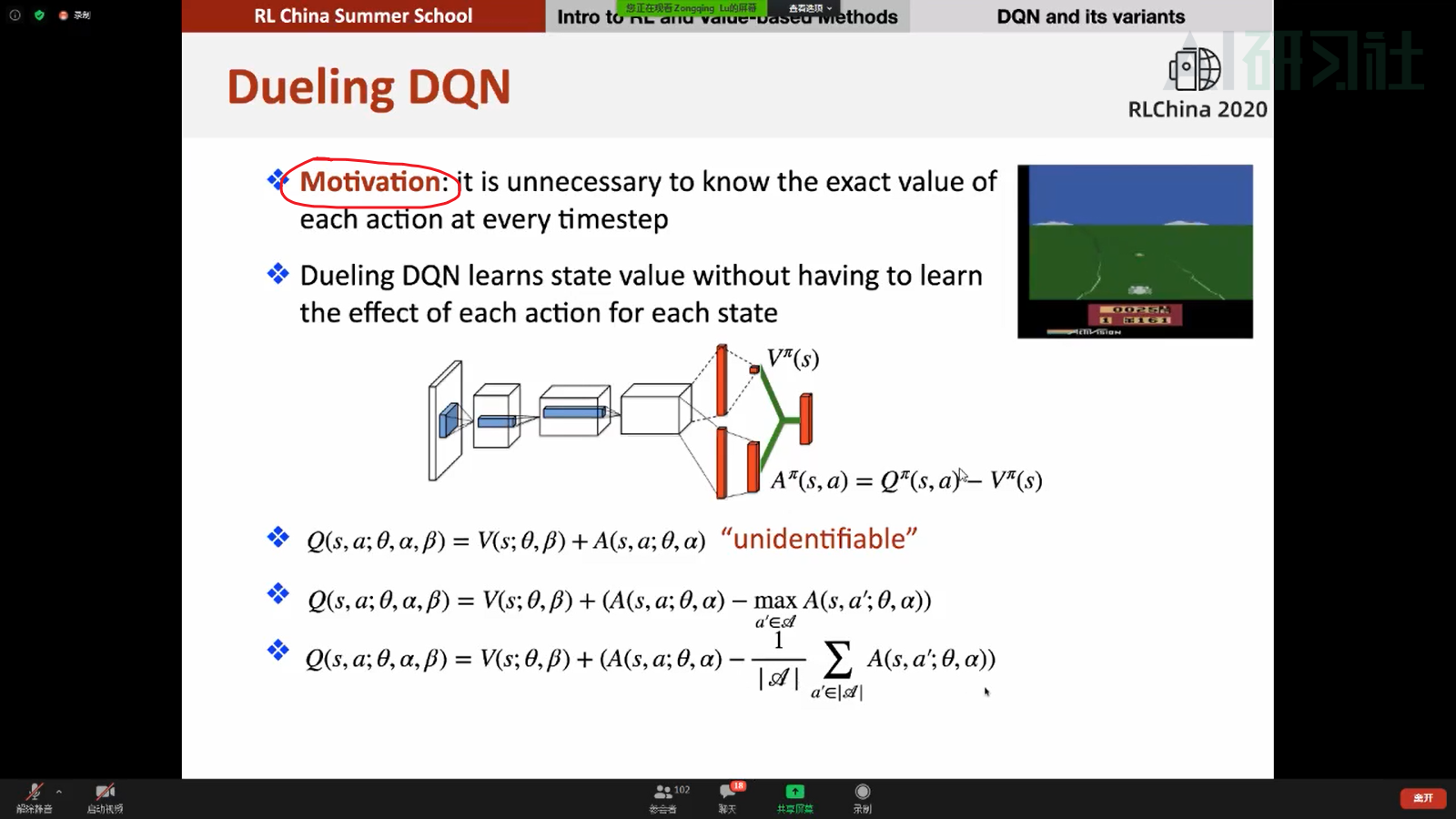

Dueling DQN:

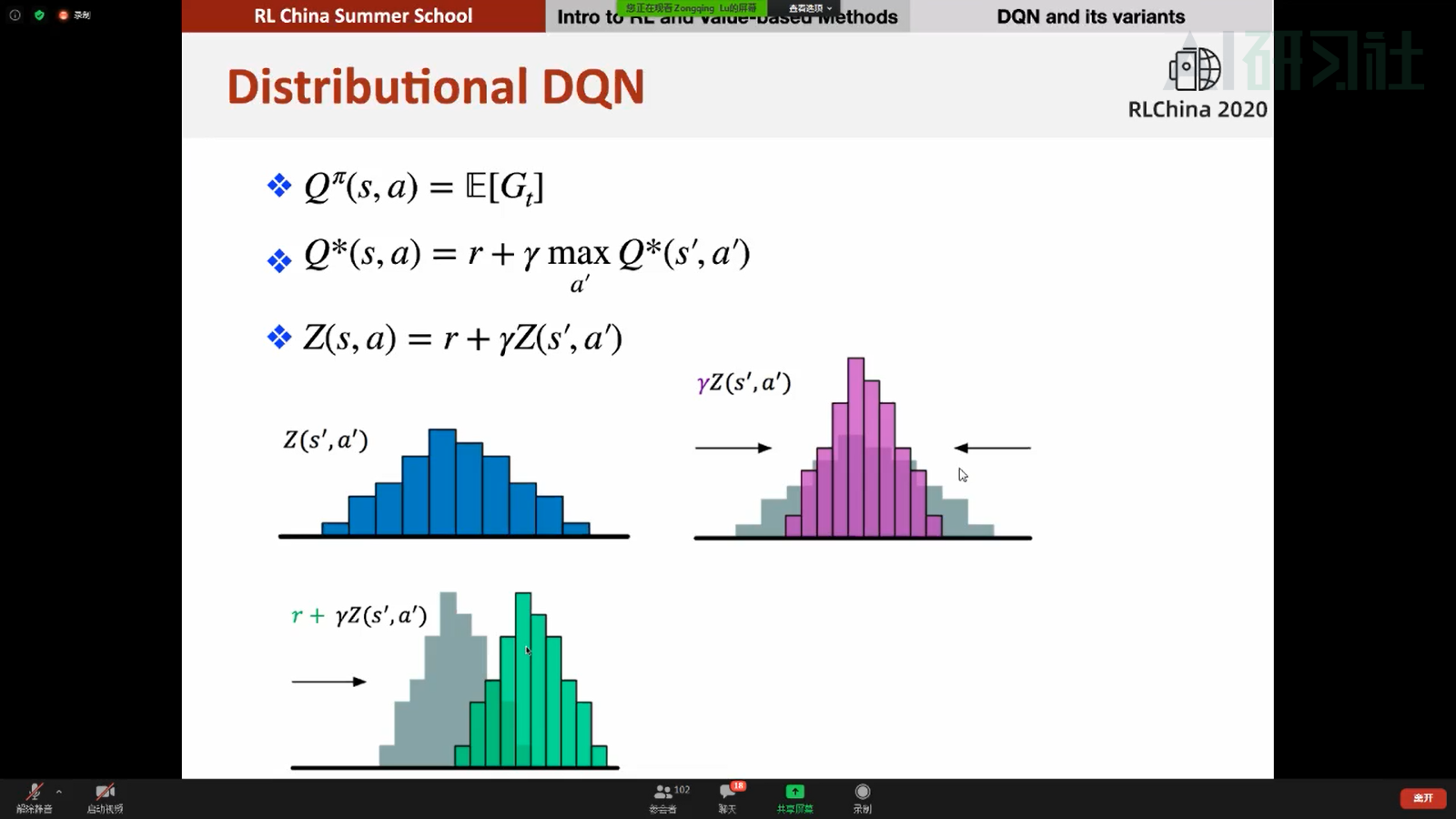

Distributional DQN:(直接学习分布)

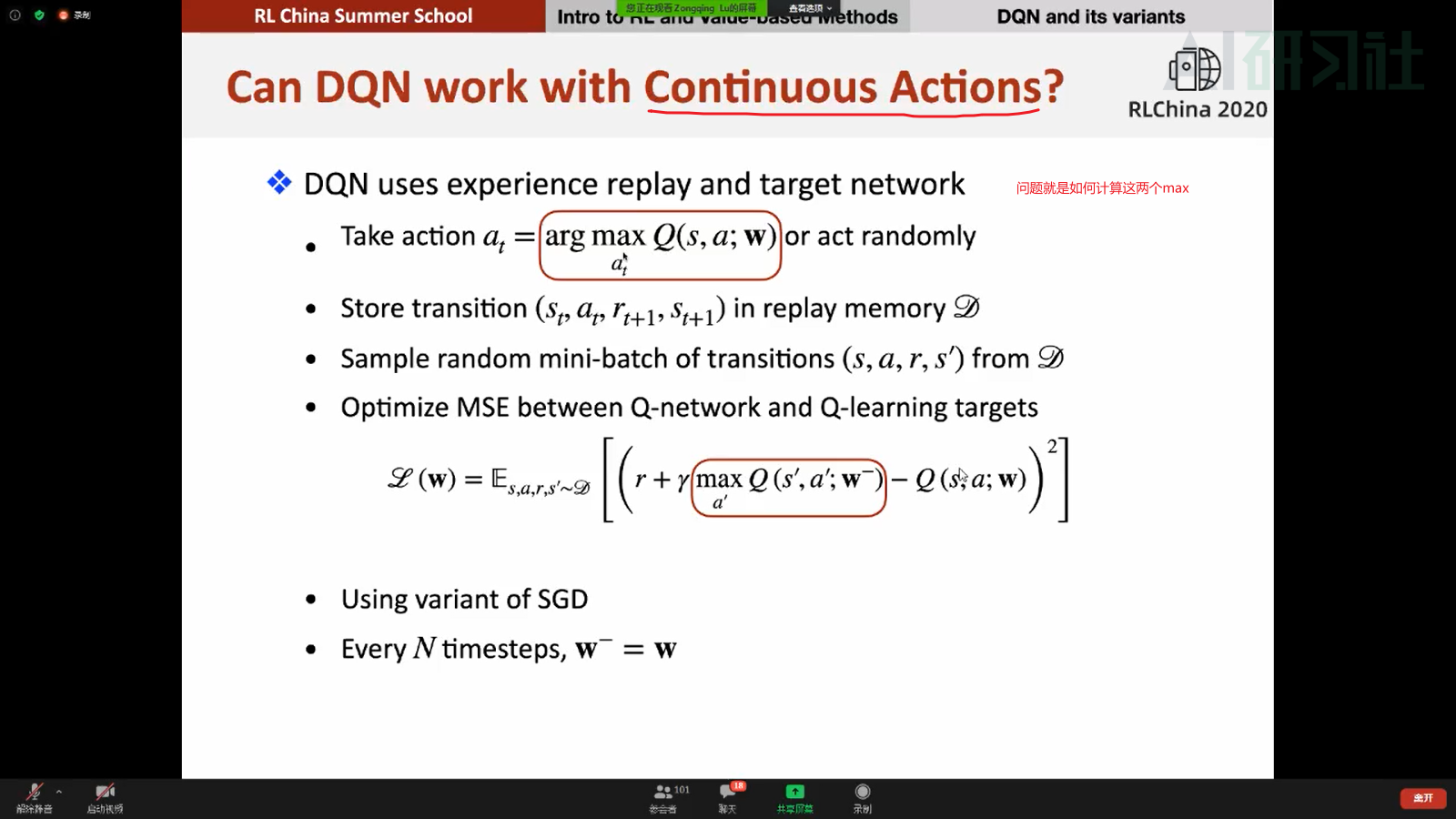

Continuous action:

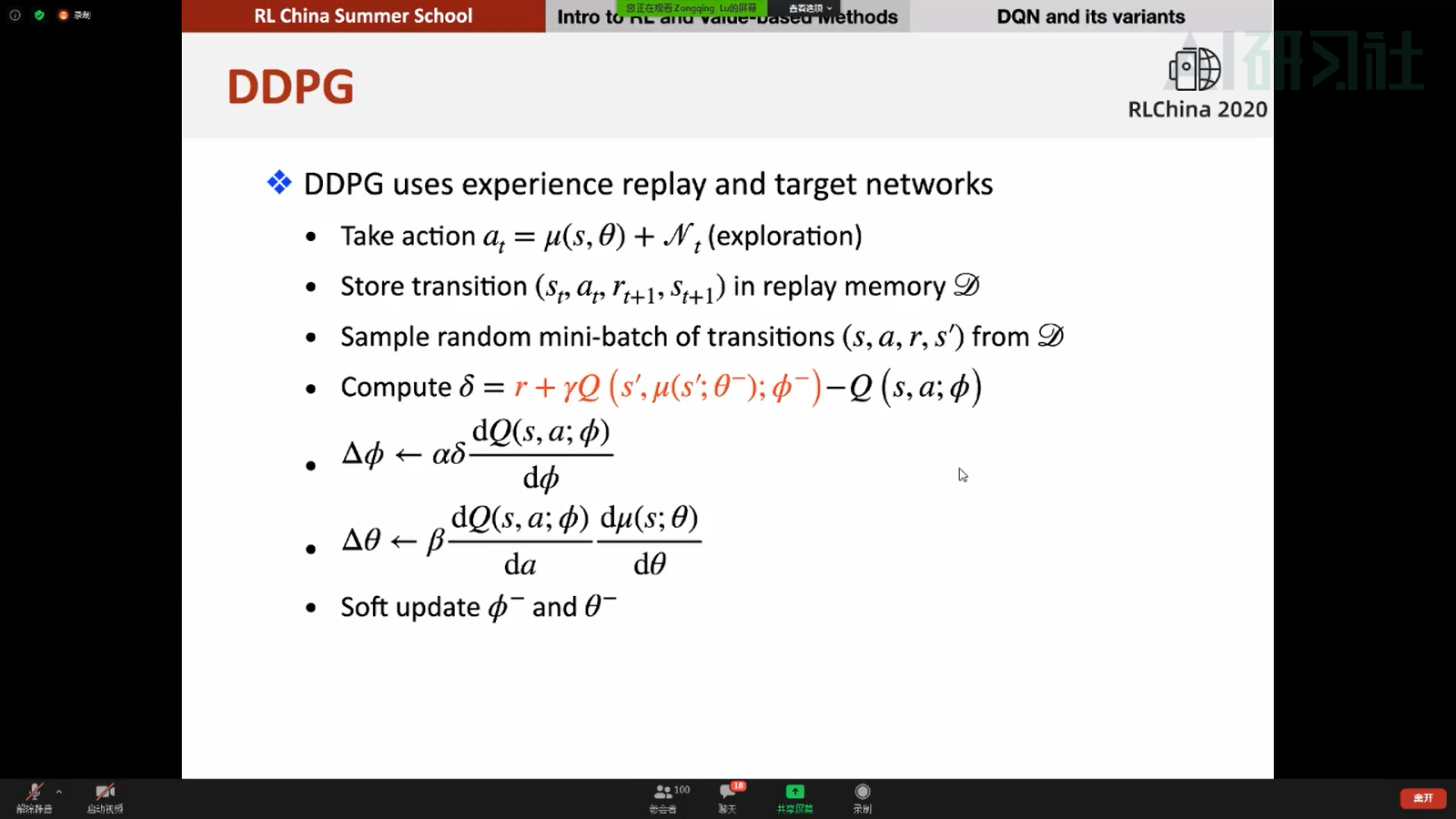

DDPG:

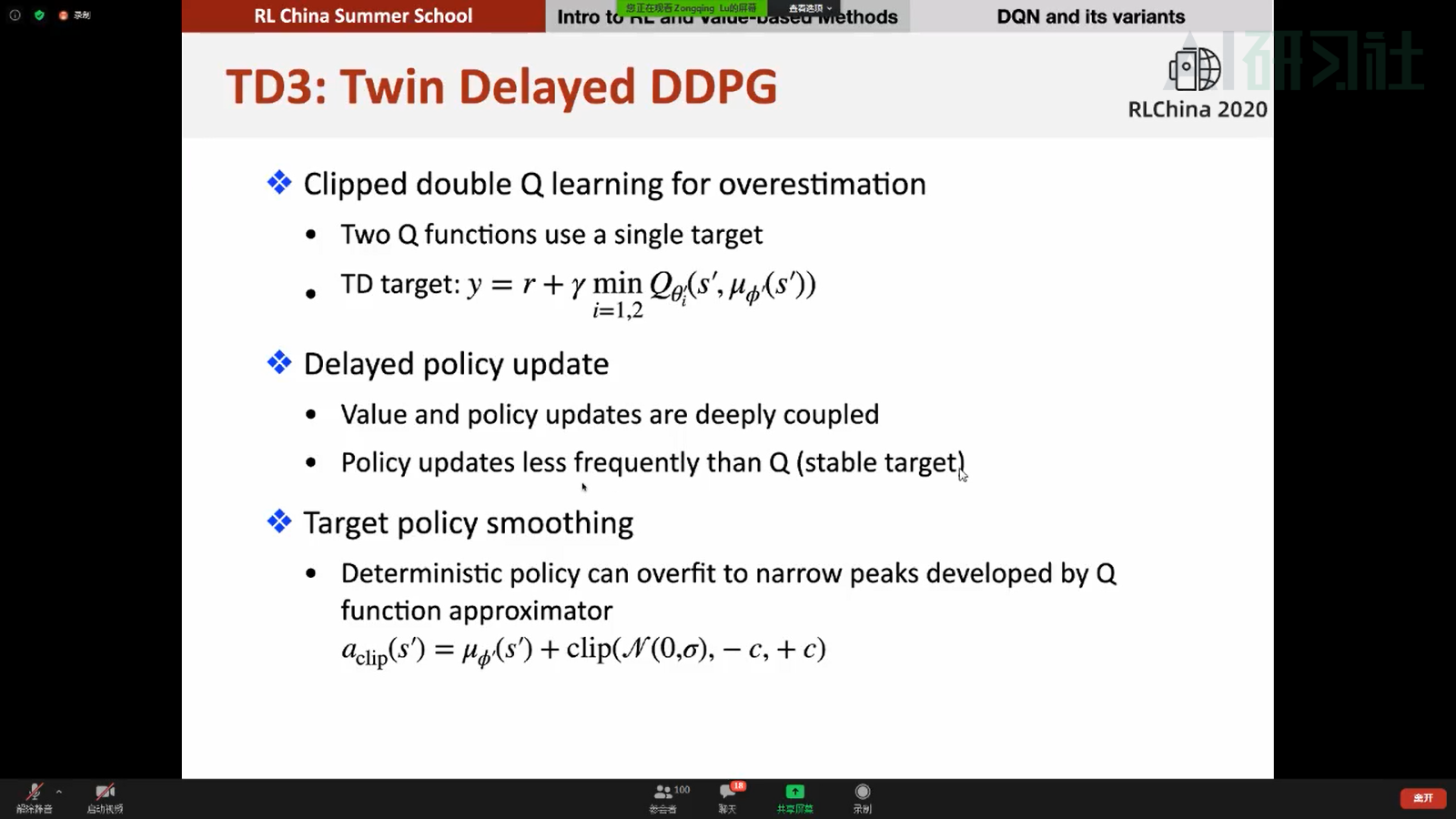

TD3:解决DDPG中的一些问题,包括过估计、narrow peaks等

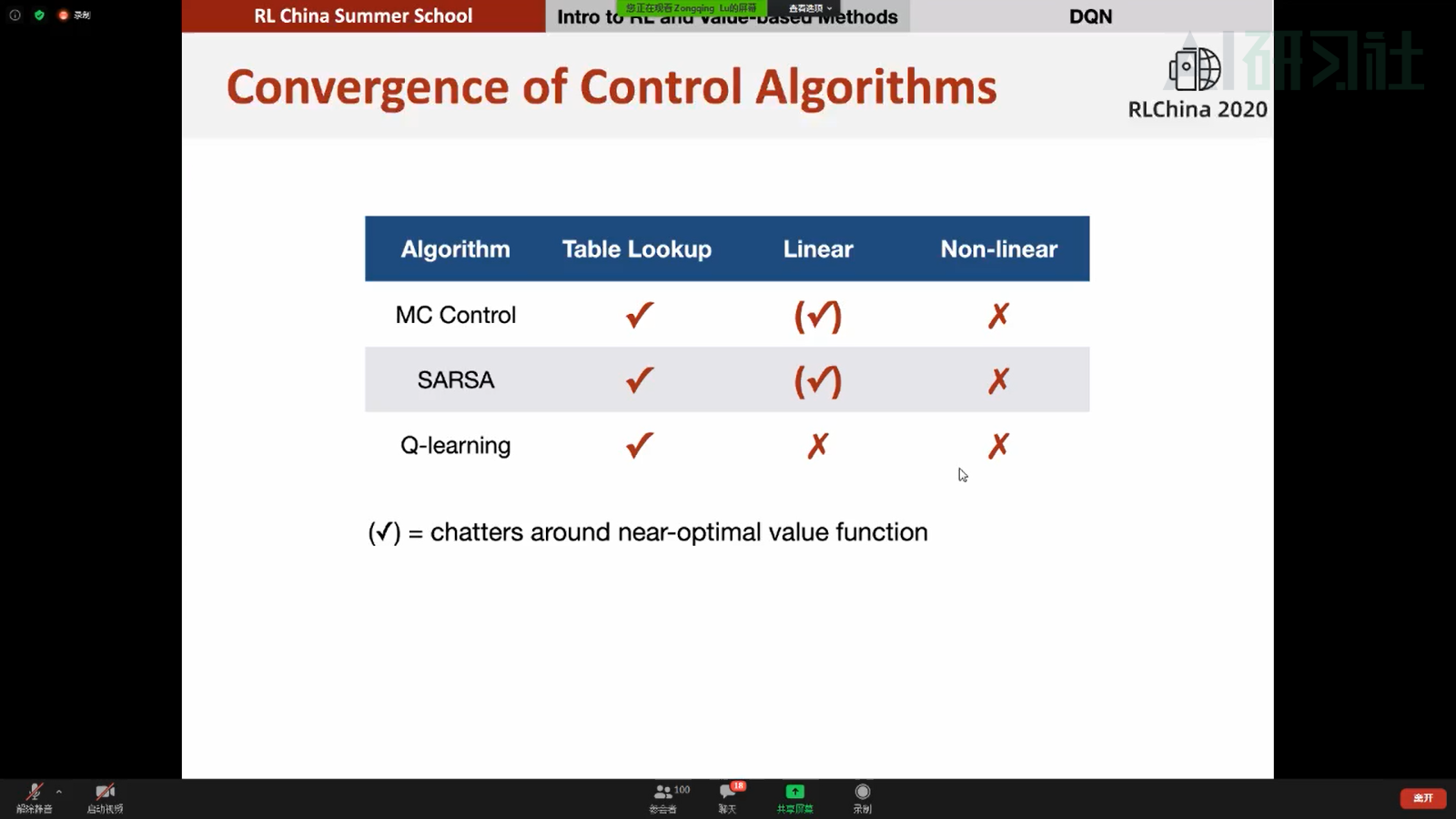

收敛性:

问题:

- 为什么最优策略一定存在,因为最优动作值函数存在,那取个argmax,就是最优策略,故存在

- Q-learning的复杂度是mn^2,n个state,m个action,n个下一时刻的state

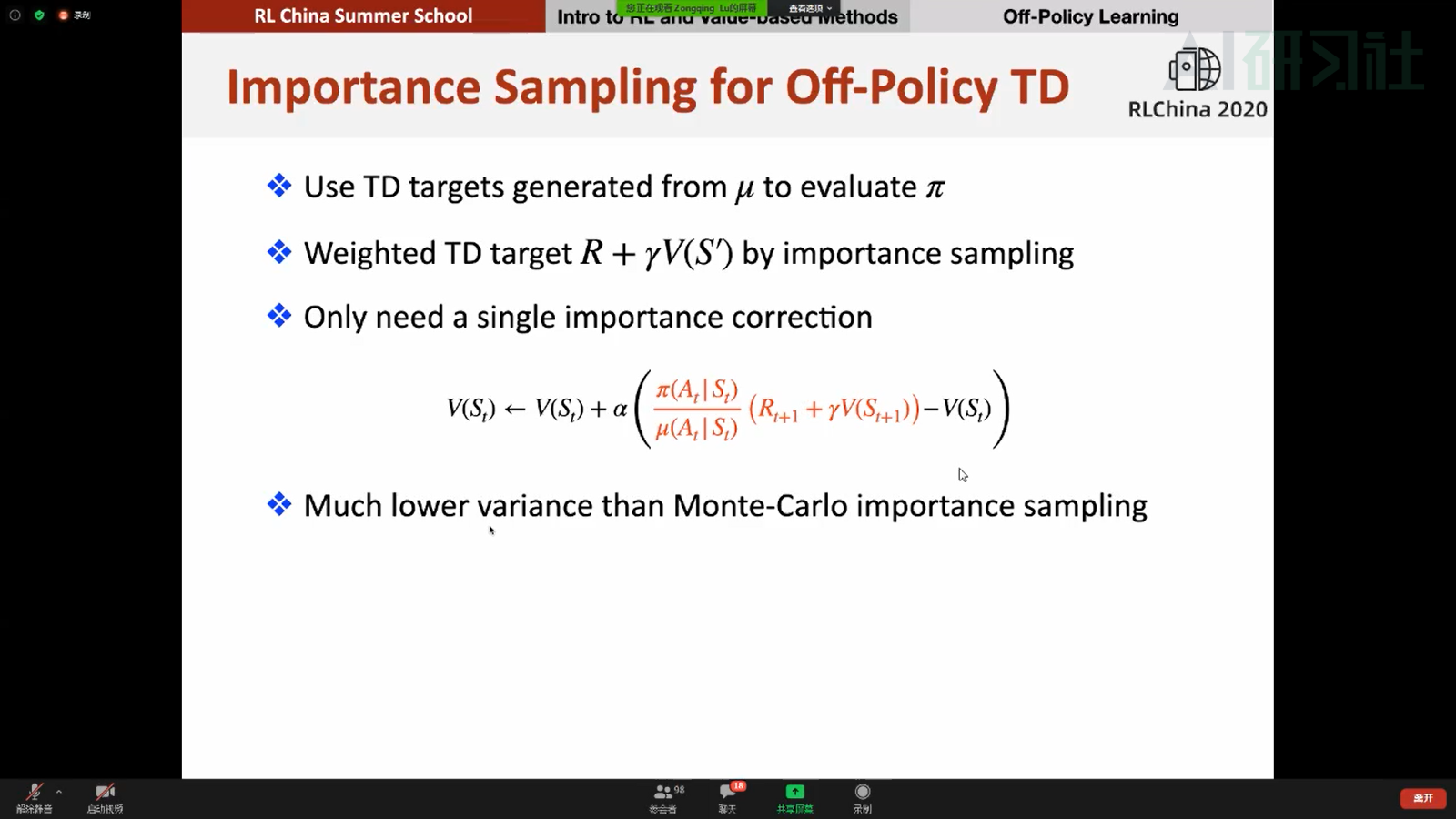

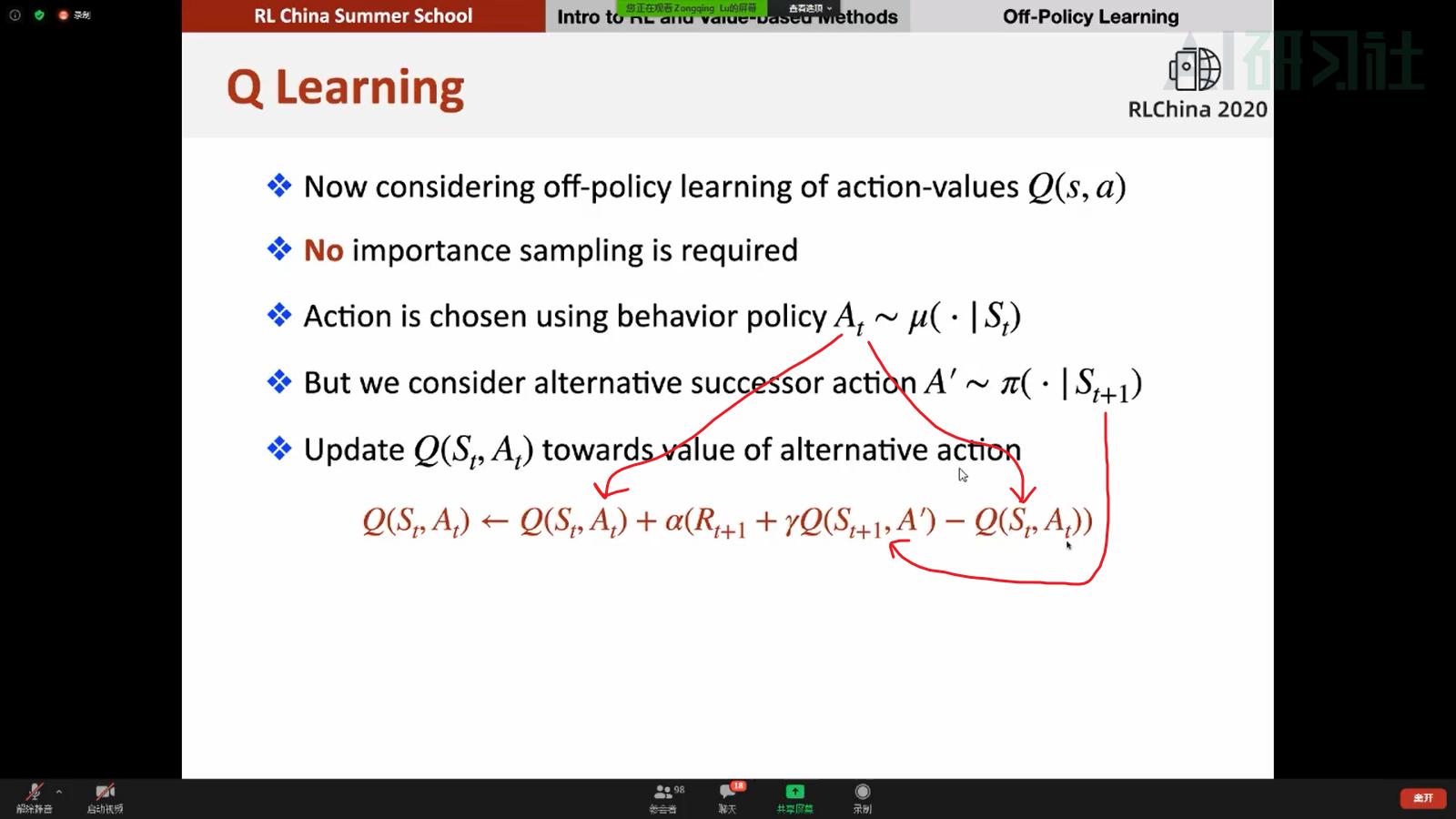

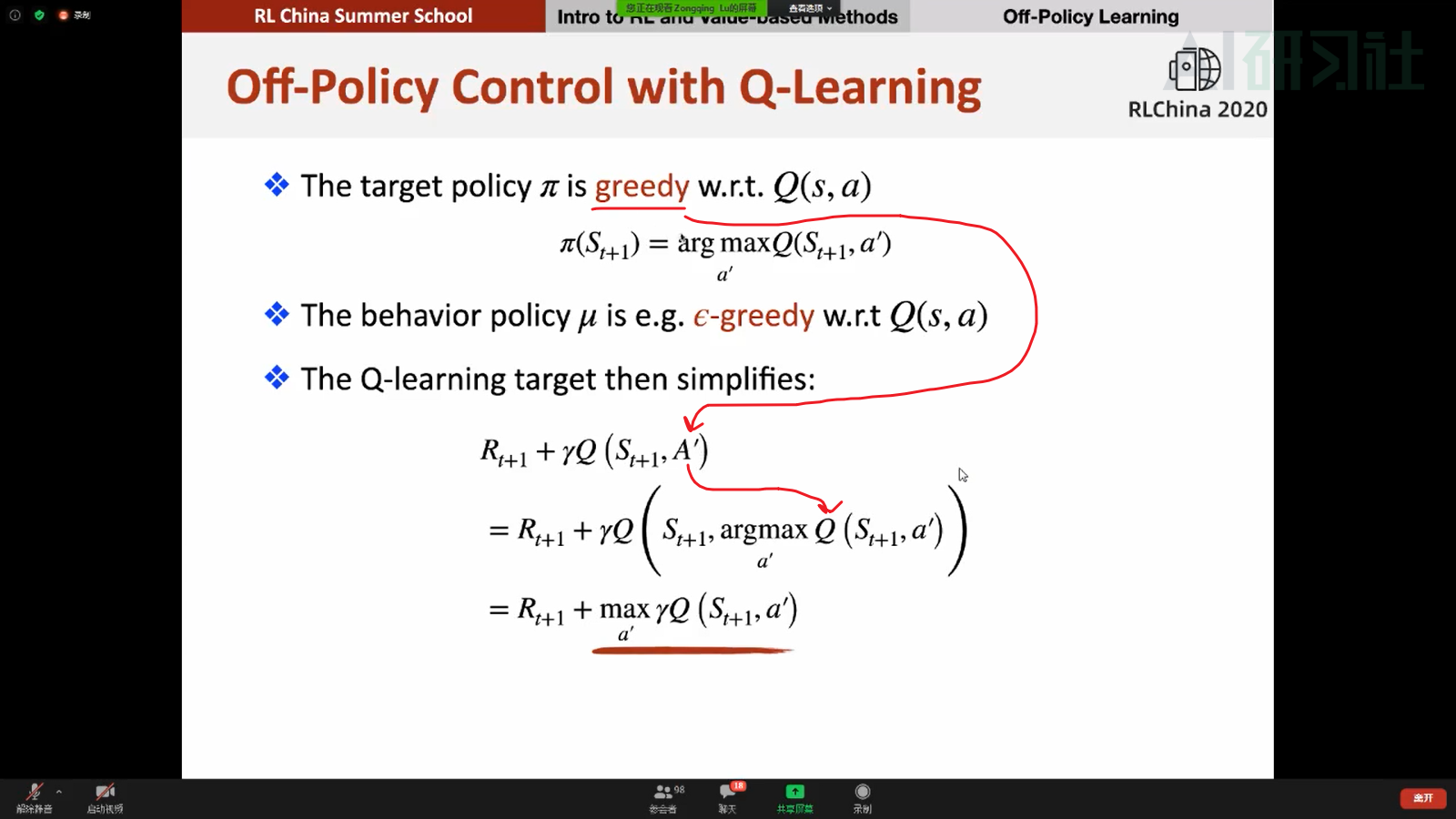

- Q-learning不用重要性采样的原因是因为可以证明它可以收敛

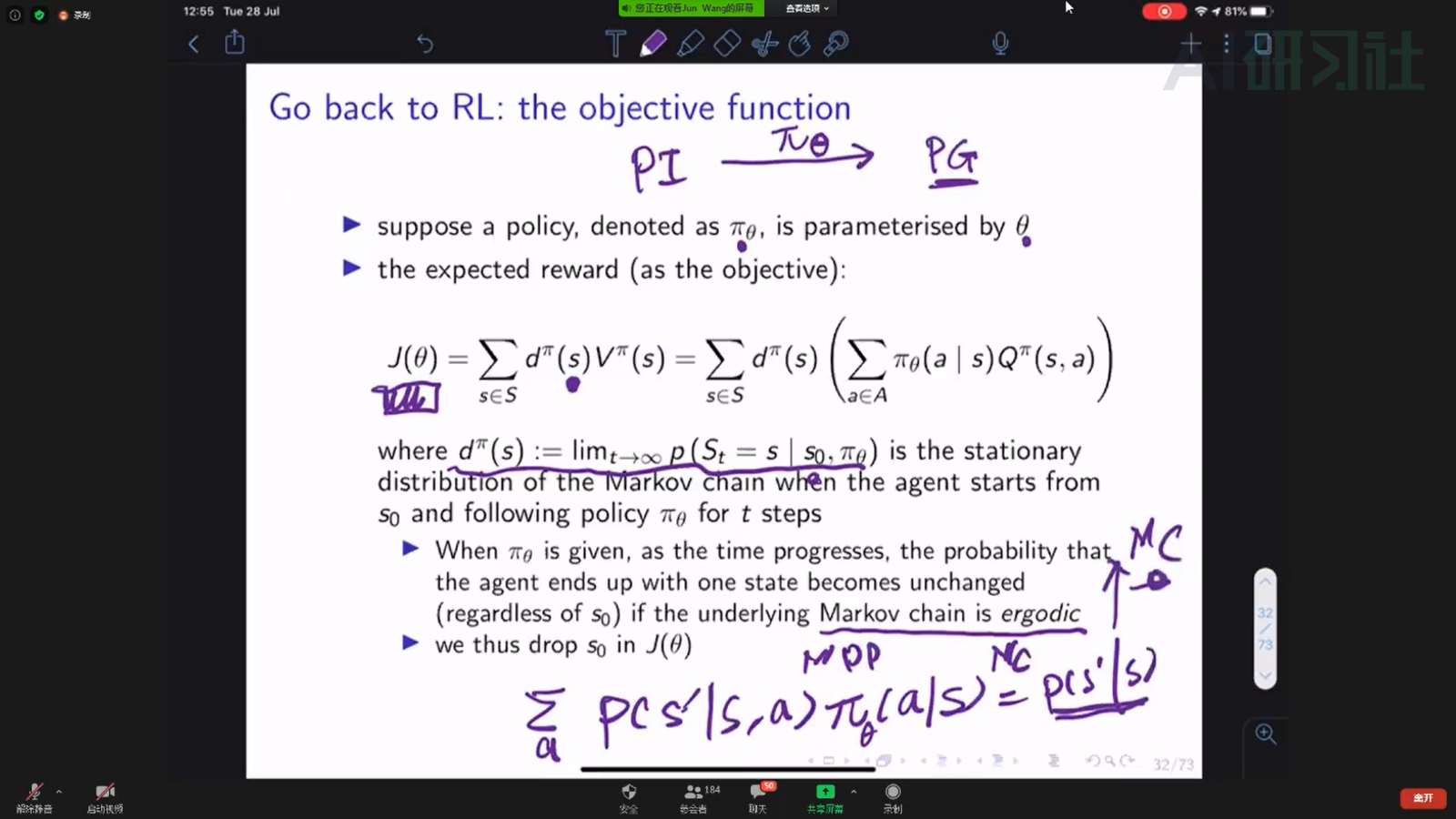

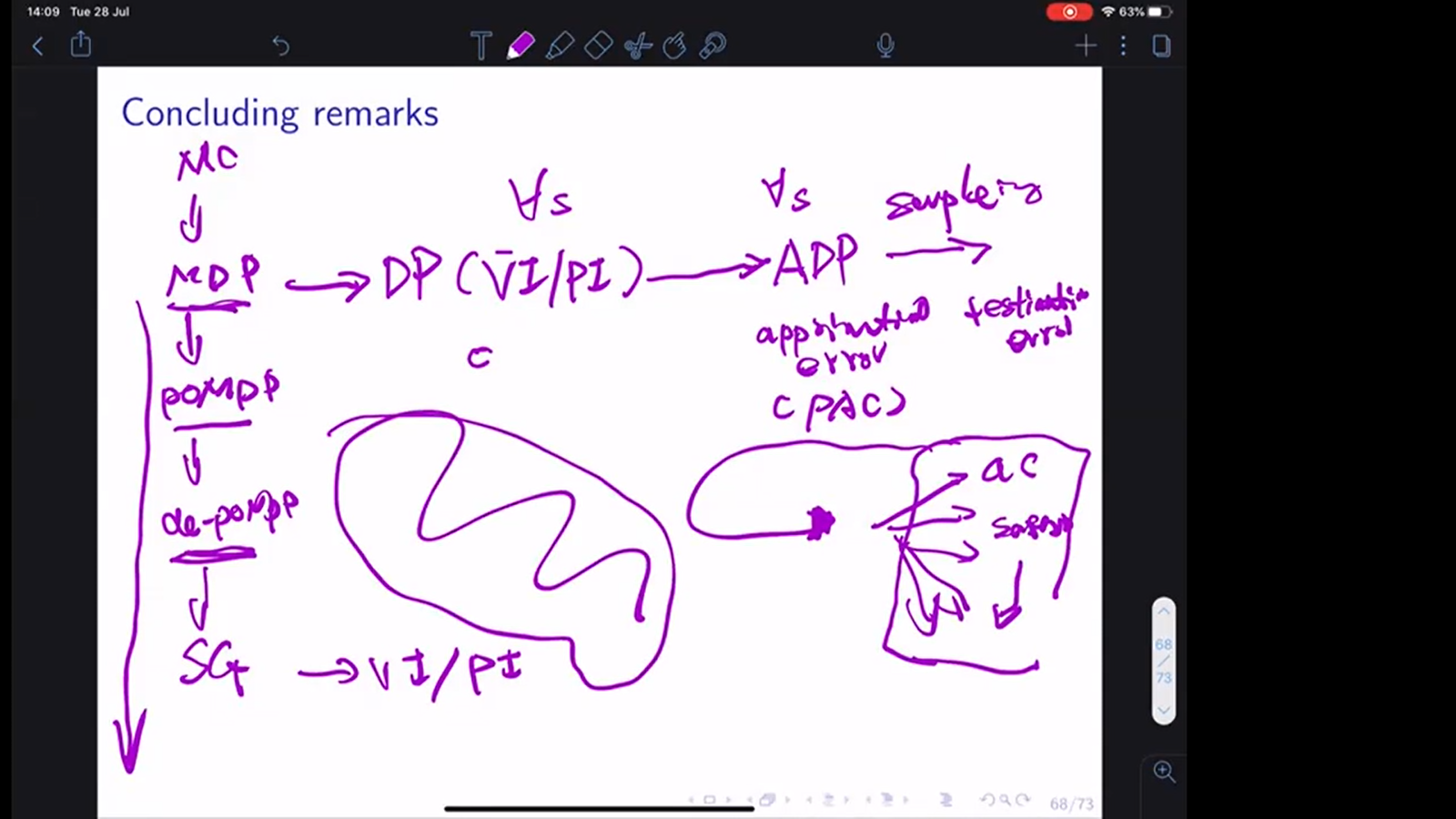

Lecture 2: Foundations of ReinforcementLearning| from policy methods to PAC bounds analysis