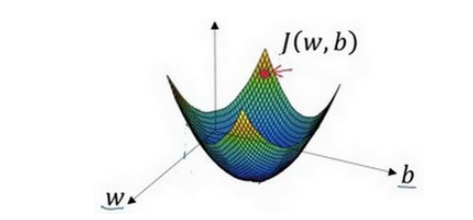

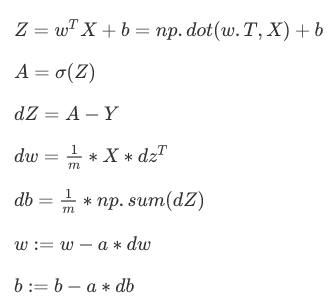

梯度下降法:

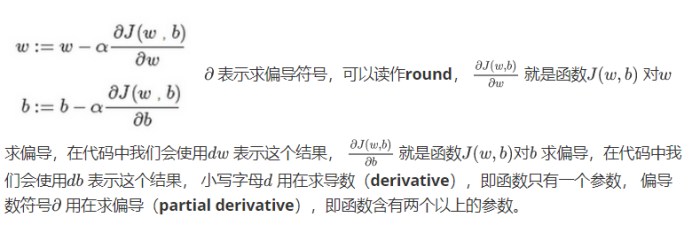

通过最小化代价函数(成本函数)来训练的参数w和b

步骤:

1、初始化w和b 无论在哪里初始化,应该达到同一点或大致相同的点

2.朝最陡的下坡方向走一步,不断地迭代

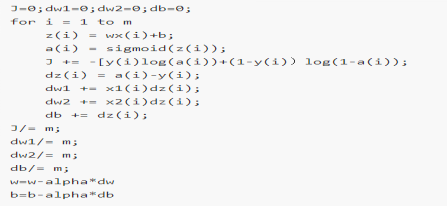

向量化:代替for循环 向量化实现将会非常直接计算

u=np.log是计算对数函数()、 np.abs() 是计算数据的绝对值、np.maximum() 计算元素中的最大值,你也可以 np.maximum(v,0) 、 代表获得元素y每个值得平方

不用for循环做法:

广播

A.sum(axis = 0)中的参数axis。axis用来指明将要进行的运算是沿着哪个轴执行,在numpy中,0轴是垂直的,也就是列,而1轴是水平的,也就是行