这两天,整个技术圈仿佛都在玩一场盛大的“剧本杀”。

一个名为 Pony Alpha 的神秘模型,没有任何发布会,没有公司认领,仅仅凭借几个 API 接口,就在海外各大评测榜单上杀疯了。有人猜是 DeepSeek V4,有人猜是 Claude 的秘密升级版,甚至连腾讯都被拉出来“点名”。

就在昨天(2月12日),谜底终于揭晓。这个让外网集体陷入侦探模式的“黑马”,正是国产大模型 GLM-5。

作为一个每天和代码打交道的博主,我必须第一时间带大家拆解一下:为什么 GLM-5 能被称为“开源 SOTA”?当它遇上 OpenClaw,能为我们的开发工作流带来怎样的核爆级升级?

一、 痛点终结者:OpenClaw 到底解决了什么?

如果你是一名开发者,你一定经历过这种“绝望时刻”:

你让 AI 帮你写一个网页,它给你吐了一堆漂亮的代码。然后呢?你得自己建文件夹、自己粘贴代码、自己配置环境、自己 Debug……一旦项目稍微复杂一点,你就在“复制粘贴”和“修 Bug”之间反复横跳,AI 哪怕只有 5% 的错误率,剩下的 95% 的正确代码也会把你折腾得精疲力竭。

这就是传统的“Vibe Coding”(氛围感编程)——看着爽,用着累。

OpenClaw 的出现,就是为了打破这个“半成品”魔咒。

它不仅仅是一个代码生成器,更是一个工程级执行框架。如果说 GLM-5 是一个拥有超高智商的“大脑”,那么 OpenClaw 就是那双灵巧的“双手”。

OpenClaw 解决的核心需求非常明确:从“写代码”到“做工程”的跨越。

- 全链路闭环:它不再是零散地输出代码片段,而是能够理解系统工程。你只需要下达指令,它能自主完成环境搭建、代码编写、调试运行、甚至部署上线。

- 长程任务不掉线:面对需要分多步、跨时域的复杂任务,OpenClaw 能盯住目标一直干到底,不会写到一半就“失忆”或跑题。

- 工具调用能力:它能像真正的工程师一样,熟练调用终端、文件系统、联网检索等工具,真正实现了 Agentic Engineering(智能体工程)。

简单来说,以前你是 AI 的“保姆”,现在 OpenClaw 让你真正成了“项目负责人”。

二、 GLM-5:强悍性能,极致性价比

OpenClaw 的强大离不开背后的模型支持,而这次的主角 GLM-5,无疑是当前开源界最耀眼的明星。

1. 性能直逼 Claude Opus 4.5,开源第一 根据智谱 AI 在 2 月 11 日的发布数据,GLM-5 在参数规模上扩展到了惊人的 744B(激活 40B),预训练数据量高达 28.5T。 在 SWE-bench-Verified 和 Terminal Bench 2.0 等权威评测中,GLM-5 斩获了 77.8 和 56.2 的高分,稳居开源第一,甚至超越了 Gemini 3 Pro,真实编程体验逼近 Claude Opus 4.5 的水平。

这意味着什么?意味着你用开源的成本,享受到了顶级闭源模型的智商。

2. 成本“大杀器”:DeepSeek 稀疏注意力机制 GLM-5 最大的杀手锏之一,是集成了 DeepSeek Sparse Attention (DSA) 机制。 对于开发者而言,这简直是福音。它显著降低了部署成本,却依然保持了长时域上下文处理能力。配合智谱自研的 Slime 异步强化学习框架,GLM-5 在训练效率上大幅提升,让模型既“聪明”又“省钱”。

强悍的性能 + 极低的部署成本,这就是 GLM-5 给整个开发者社区交出的答卷。

三、 实战教学:如何在 OpenClaw 中驾驭 GLM-5

既然 GLM-5 已经开源,OpenClaw 也提供了强大的执行环境,我们该如何将这两者结合,打造自己的超级 AI 工程师呢?

目前,通过 OpenClaw 部署 GLM-5 已经变得非常“傻瓜化”,只需 10 分钟即可完成。

步骤 1:获取 GLM-5 的“钥匙” 首先,你需要获取 GLM-5 的 API 权限。目前官方针对新用户有非常给力的福利政策。 👉 点击这里注册/登录 BigModel:www.bigmodel.cn/glm-coding?… (划重点:通过此链接注册的新用户,可以直接获得免费体验模型的额度,不仅能体验到 GLM-5 的基座能力,还能解锁 Coding 专属特权,白嫖党狂喜!)

步骤 2:配置 OpenClaw 环境 OpenClaw 支持飞书、钉钉等多平台部署,这里以本地或云端部署为例: 前置条件: Node.js 22 或更新版本(必需) 一、安装 OpenClaw 方式 1:安装脚本(推荐) macOS / Linux:

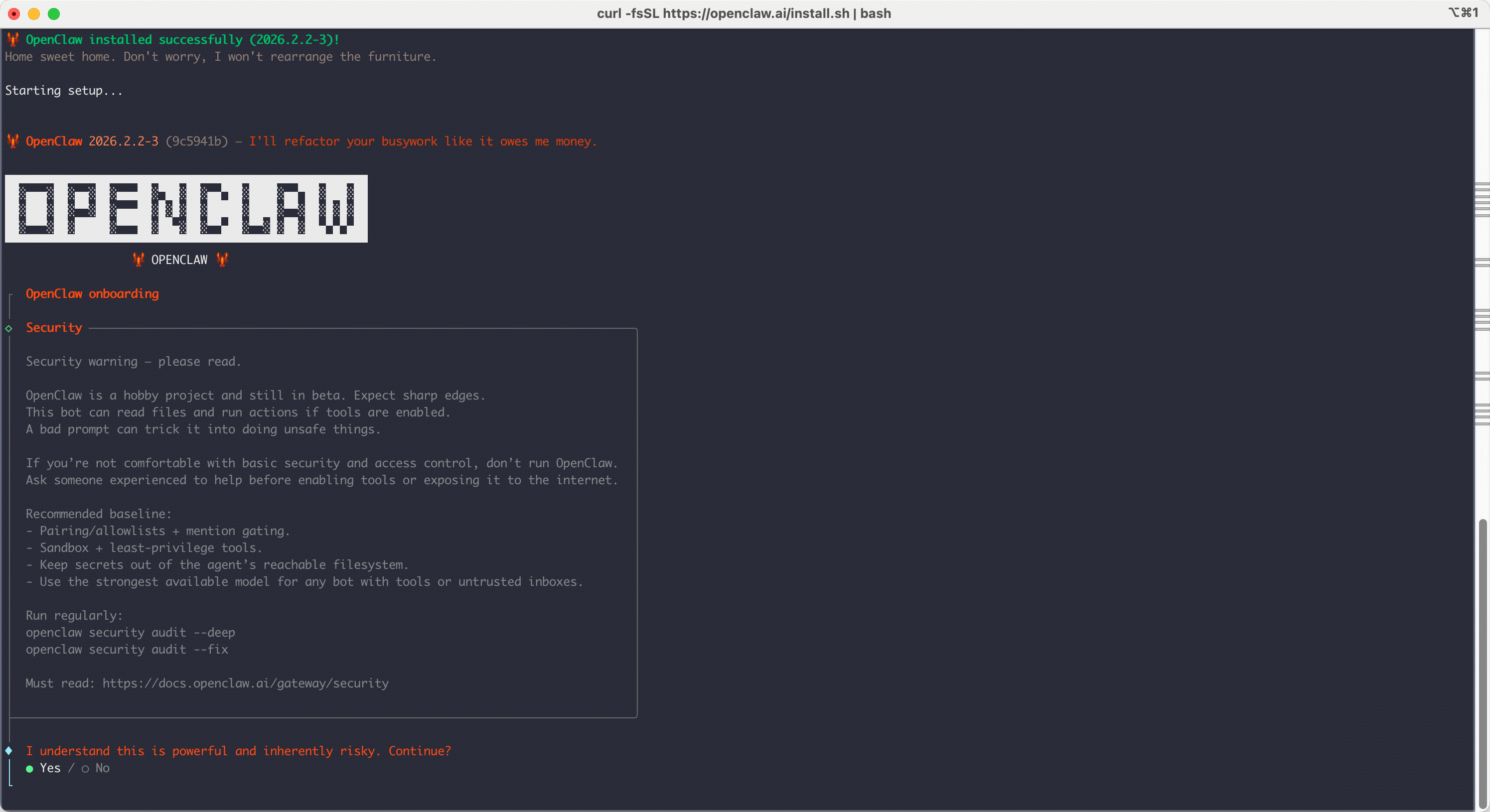

curl -fsSL https://openclaw.ai/install.sh | bash

Windows (PowerShell):

iwr -useb https://openclaw.ai/install.ps1 | iex

方式 2:手动安装 使用 npm:

npm install -g openclaw@latest

使用 pnpm(推荐):

pnpm add -g openclaw@latest

pnpm approve-builds -g

二、配置 OpenClaw 连接 GLM-5 运行配置命令:

openclaw onboard --install-daemon

开始配置:

*

开始配置:

* I understand this is powerful and inherently risky. Continue? | 选择 ● Yes

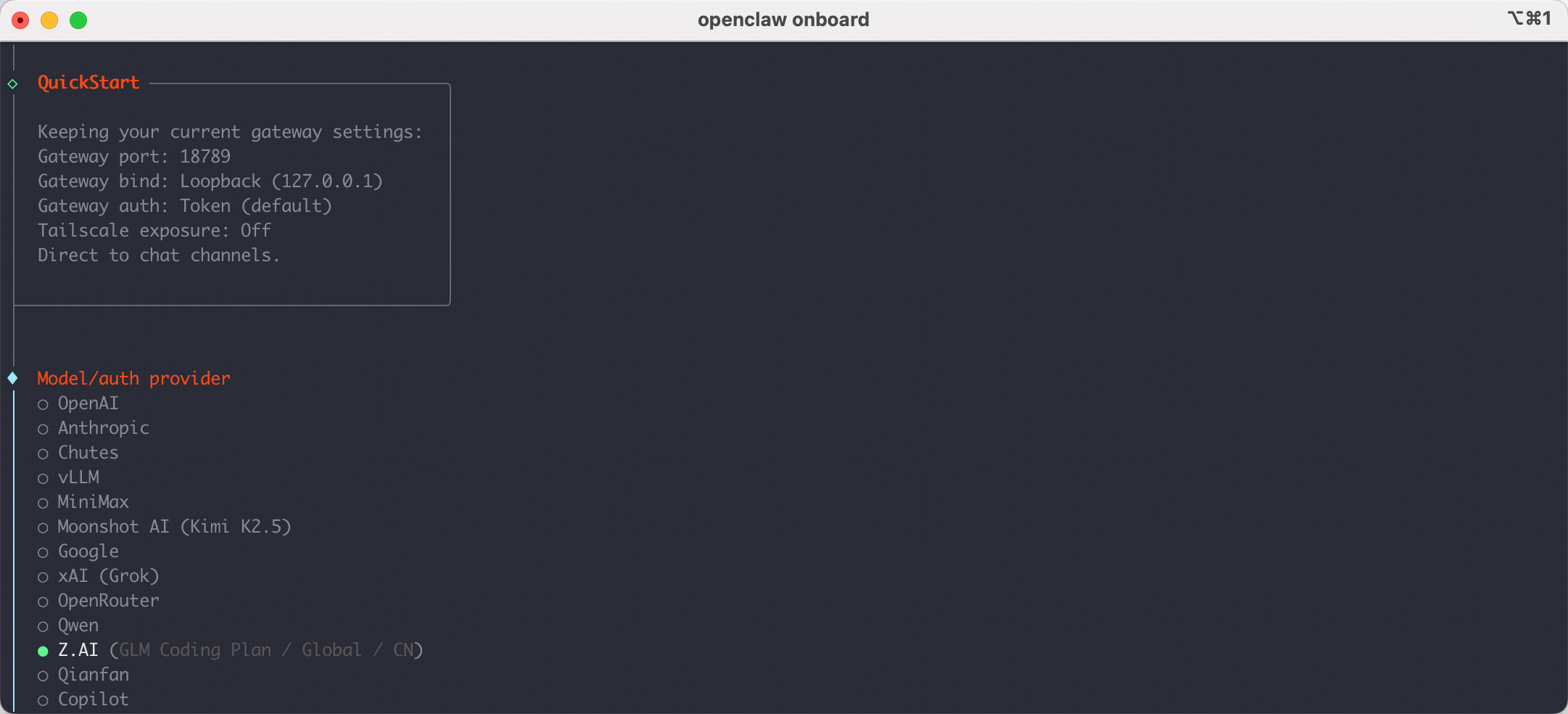

* Onboarding mode | 选择 ● Quick Start

* Model/auth provider | 选择 ● Z.AI

配置 Z.AI 提供商

选择

配置 Z.AI 提供商

选择 Z.AI 作为 Model/auth provider 后,选 Coding-Plan-CN,系统会提示您输入 API Key。

粘贴您的智谱Api Key并按 Enter 键,然后选择您想要使用的模型 zai/glm-5。在这里获取 ApiKey

三、完成设置并启动

- 选择频道:选择并配置您需要的消息平台频道

- 安装技能:选择并安装需要的技能

- 开始使用:选择 Hatch in TUI (recommended) 即可在终端界面开始聊天

✅ 验证安装 安装完成后,可以使用以下命令检查状态:

openclaw doctor # 检查配置问题

openclaw status # 查看网关状态

openclaw dashboard # 浏览器打开管理面板

步骤 3:见证奇迹时刻 配置完成后,你就可以开始你的 Agentic 之旅了。 试着输入一个复杂的指令:

“帮我写一个带有用户登录功能的博客网站,前端用 Vue3,后端用 Python Flask,并生成对应的 Docker-compose 文件。”

看着 OpenClaw 调用 GLM-5,自主地在终端里创建目录、编写文件、安装依赖、甚至自动修复初次的报错,那种“见证未来”的爽感,真的只有亲身体验过才知道。

四、 总结

2026 年的开源大模型市场,注定因为 GLM-5 而被重新划分。

它不再满足于做一个只会“聊天”的 AI,而是真正向“系统工程”发起冲击。对于个人开发者和中小企业来说,GLM-5 + OpenClaw 的组合,提供了一个极具性价比的超级助手方案。

与其在枯燥的 CRUD 工作中消磨热情,不如现在就点击链接,拥抱这个 Agentic 的新时代。

🔗 限时福利入口:www.bigmodel.cn/glm-coding?…

注:新用户注册即可体验,名额有限,手慢无! ht