Hi,我是猫叔。

昨天半夜,我在逛 GitHub 的时候发现个狠货,整个人瞬间就不困了。

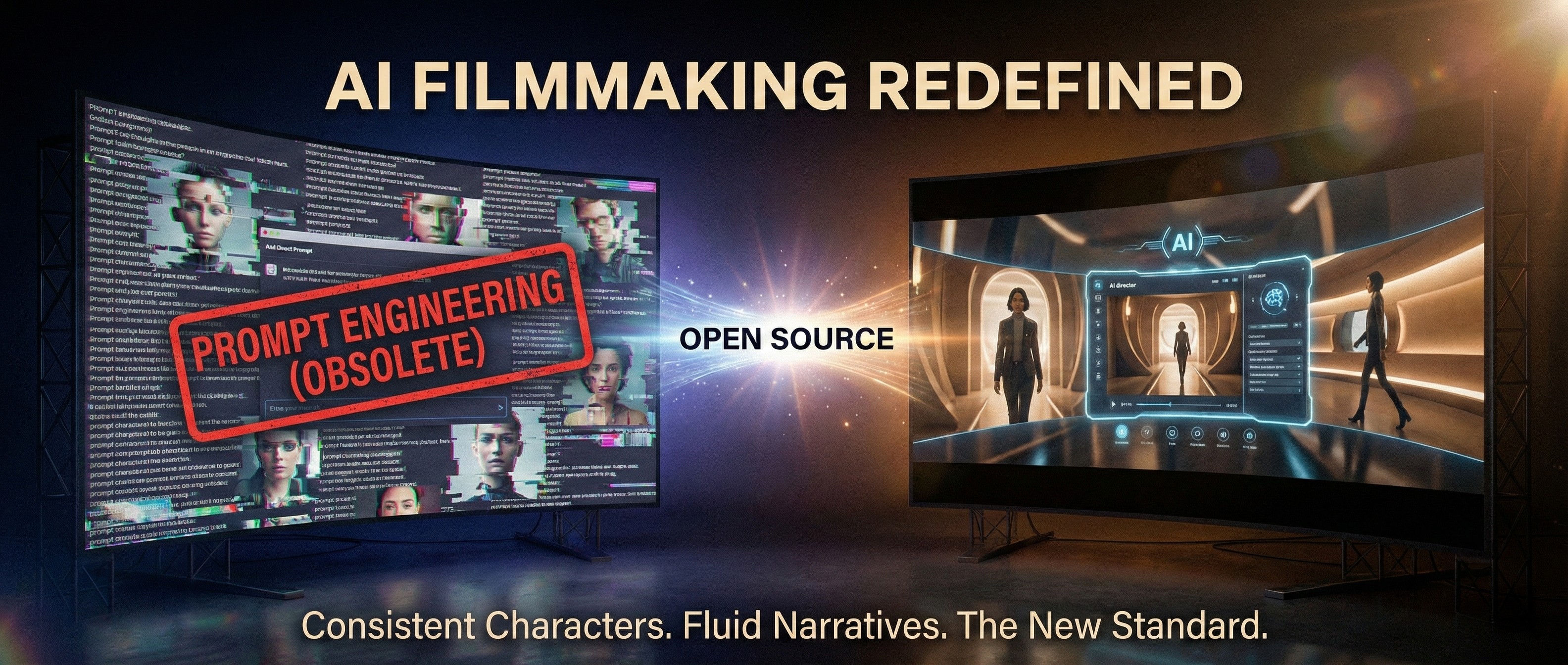

大家玩 AI 视频生成,最大的痛点是什么?

不是画质不够高,也不是生成太慢,而是薛定谔的主角。

上一秒主角还是个精神小伙,下一秒镜头一转,直接换了张脸,甚至衣服都变了。这就导致现在的 AI 视频,大多只能做几秒钟的空镜,根本没法讲故事。

但是,字节跳动这次联合南洋理工大学,搞了个大事情。

他们开源了一个叫 StoryMem 的框架。

简单说,这东西就是给 AI 视频模型装了一个脑子。

它能把现有的单镜头模型,直接升级成能讲长故事的“导演”,自动生成超过 1 分钟、包含多个镜头切换、而且角色和场景高度连贯的视频。

这就有点意思了。

我就在想,它是怎么做到的?

以前的模型是“走一步看一步”,生成下一个镜头时,往往忘了上一个镜头长啥样。

但这哥们的逻辑完全不同。

它引入了一种类似人类记忆的机制,叫 Memory-to-Video (M2V)。

你可以把它想象成一个剧组的场记。

它会维护一个动态的“记忆库”。每生成一个镜头,它就把关键帧存进去;等到生成下一个镜头时,它会把这些记忆注入到模型里。

就像是有人在旁边时刻提醒 AI:“哎,注意看,主角穿的是蓝衣服,背景是咖啡馆,别画歪了!”

这就确保了不管镜头怎么切,角色的长相、场景的风格,都能保持惊人的一致。

重点来了。

根据他们的数据,StoryMem 在跨镜头一致性上,比现有方法提升了整整 29%。

这意味着什么?

意味着 AI 视频终于从“玩具”向工具迈进了一大步。

我仔细研究了一下它的应用场景,发现这里面全是搞钱的机会。

对于做营销和广告的朋友来说,这简直是神技。

以前做个分镜脚本,得画师画半天。现在?扔进脚本,几秒钟就能生成一整套动态分镜,还能快速做 A/B 测试。

对于影视前期的剧组,它能极大降低概念设计的成本,把文字脚本直接可视化。

这还没完。

社区的反应速度快得吓人。

项目才发布几天,就已经有大佬在研究 ComfyUI 的工作流了。也就是说,我们普通人很快就能在本地跑起来,用它做那种真正有剧情、有人物弧光的短片。

最后,给想折腾的朋友划个重点:

- 核心优势: 1分钟长视频、多镜头、角色不崩。

- 技术门槛: 基于 LoRA 微调,不需要你是算力土豪。

- 搞钱方向: 动态分镜服务、短剧快速样片制作、独立动画短片。

这种能解决实际痛点的技术,往往就是下一波红利的开始。

如果你觉得有用,欢迎转发关注➕点赞,感谢你的支持~