人工智能之核心基础 机器学习

第二章 监督学习

2.1 监督学习的定义与特点

📌 什么是监督学习?

监督学习就像“有老师教学生”的过程。 你给计算机一堆已经知道答案的例子(比如:“这张图是猫”、“那封邮件是垃圾邮件”),让它从这些例子中学会规律,然后用学到的规律去预测新数据的答案。

✅ 核心关键词:有标签的数据(labeled data) “标签”就是每个样本的正确答案。比如:

- 图片 + “猫” → 标签是“猫”

- 房屋信息 + “300万元” → 标签是价格

🔍 监督学习的特点

| 特点 | 说明 |

|---|---|

| 需要标签 | 每条训练数据都必须带有“标准答案” |

| 目标明确 | 学会输入(特征)和输出(标签)之间的映射关系 |

| 可评估性能 | 因为有真实标签,可以计算预测对不对 |

| 应用广泛 | 分类、回归等大多数实际问题都属于监督学习 |

💡 打个比方: 你教小孩认水果——给他看100张带名字的水果照片(“这是苹果”“这是香蕉”)。之后你给他一张新照片,他就能说出是什么水果。这就是监督学习!

2.2 监督学习的核心任务

监督学习主要解决两类问题:

1️⃣ 分类任务(Classification)

目标:预测离散的类别标签(有限个选项)

✅ 例子:

-

判断邮件是不是垃圾邮件(是 / 否)

-

识别图片中的动物(猫 / 狗 / 鸟)

-

医疗诊断(患病 / 健康)

📌 关键点:输出是类别,不是数字大小。

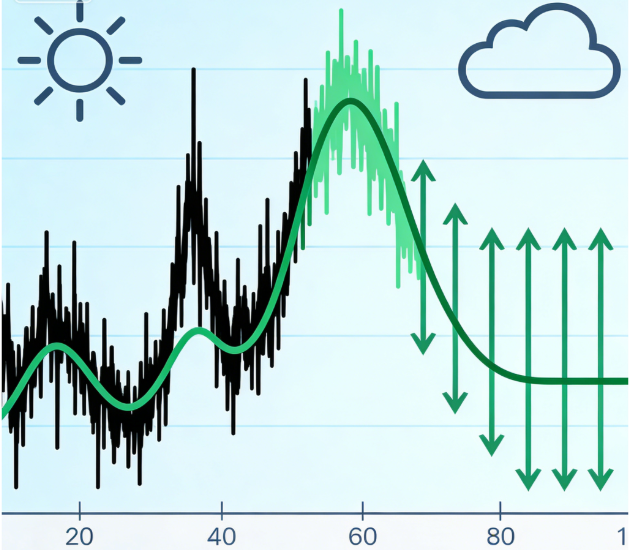

2️⃣ 回归任务(Regression)

目标:预测连续的数值(可以是任意实数)

✅ 例子:

- 预测房价(比如 285.6 万元)

- 预测明天的气温(23.7℃)

- 预测销售额(12,345.8 元)

📌 关键点:输出是数字,而且关注数值的大小和误差。

🧠 一句话区分:

如果答案是“是什么”(类别)→ 分类 如果答案是“是多少”(数值)→ 回归

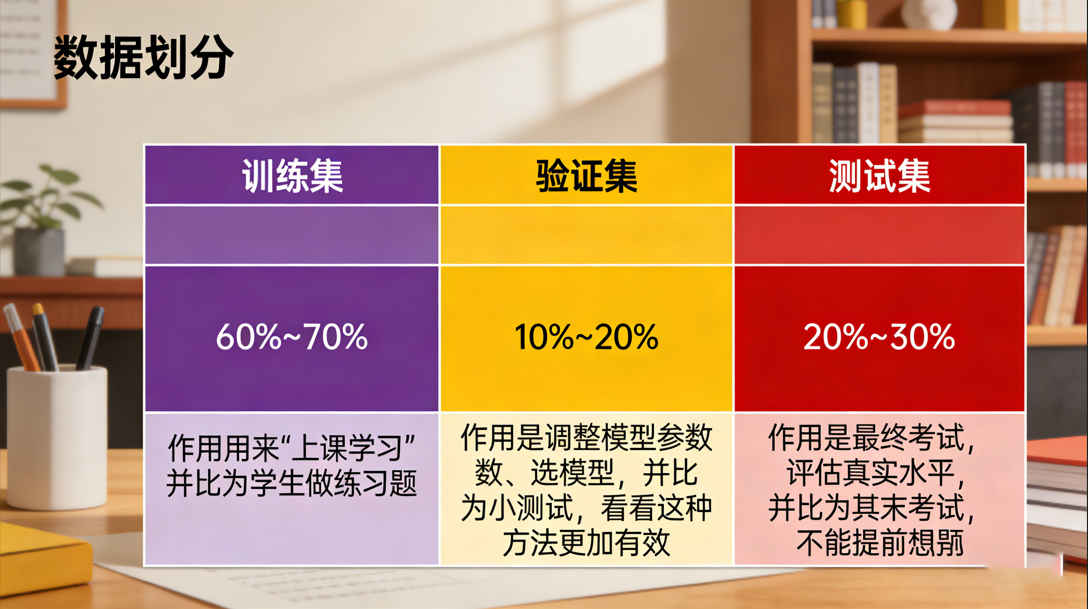

2.3 数据集划分:训练集、验证集、测试集

为了让模型既学得好,又不会“死记硬背”,我们需要把数据分成三份:

| 数据集 | 占比(常见) | 作用 | 类比 |

|---|---|---|---|

| 训练集(Training Set) | 60%~70% | 用来“上课学习” | 学生做练习题 |

| 验证集(Validation Set) | 10%~20% | 调整模型参数、选模型 | 小测验,看看哪种方法更有效 |

| 测试集(Test Set) | 20%~30% | 最终考试,评估真实水平 | 期末考试,不能提前看题! |

🛑 重要原则:

- 测试集绝对不能参与训练或调参! 否则就像“提前看了考题”,评估结果会虚高。

- 划分要随机且有代表性,避免偏差(比如所有猫都在训练集,狗全在测试集)。

- 常用划分方法:

train_test_split(Scikit-learn库函数)

🎯 小技巧: 对于小数据集,可以用交叉验证(Cross-Validation)来更充分地利用数据。

2.4 模型评估指标

光说“模型好不好”不够,得用数字说话!不同任务用不同指标。

🔹 分类任务常用指标

假设我们做一个“是否患癌”的预测模型:

| 实际 \ 预测 | 预测“患病” | 预测“健康” |

|---|---|---|

| 真实患病 | 真阳性(TP) | 假阴性(FN) |

| 真实健康 | 假阳性(FP) | 真阴性(TN) |

1. 准确率(Accuracy)

所有预测中,猜对的比例 ✅ 适合类别平衡的情况(比如男女各一半) ❌ 不适合不平衡数据(比如99%健康,1%患病——瞎猜“健康”也能99%准确!)

2. 精确率(Precision)

预测为“阳性”的人里,真正阳性的比例 👉 关注:别乱报阳性(比如垃圾邮件过滤,别把正常邮件当垃圾)

3. 召回率(Recall / Sensitivity)

所有真实阳性中,被找出来的比例 👉 关注:别漏掉真阳性(比如癌症筛查,千万别漏诊!)

4. F1值(F1-Score)

精确率和召回率的调和平均(兼顾两者) ✅ 当你不知道该优先看精确率还是召回率时,就看F1!

5. ROC曲线 & AUC值

- ROC曲线:画出不同阈值下“真正率(TPR)” vs “假正率(FPR)”的曲线

- AUC(Area Under Curve):ROC曲线下面积,越大越好(最大为1) ✅ AUC能衡量模型在所有分类阈值下的整体表现,不受类别不平衡影响!

🔸 回归任务常用指标

假设真实房价是 300 万,模型预测了 280 万,误差 = 20 万。

1. MAE(Mean Absolute Error,平均绝对误差)

平均每个预测错多少 ✅ 单位与原数据一致,好解释(比如“平均差5万元”)

2. MSE(Mean Squared Error,均方误差)

先平方再平均(放大较大误差的影响) ⚠️ 单位是“平方”,不好直接理解

3. RMSE(Root Mean Squared Error,均方根误差)

MSE 开平方,回到原始单位 ✅ 既保留了MSE对大误差敏感的优点,又便于理解

4. R²(决定系数,R-squared)

模型比“瞎猜均值”好多少?

- R² = 1:完美预测

- R² = 0:和猜平均值一样差

- R² < 0:比猜平均值还差!(模型有问题)

✅ R²最常用,因为它无量纲,便于比较不同模型。

🎯 本章总结

- 监督学习 = 用带答案的数据教模型

- 分类预测“是什么”,回归预测“是多少”

- 数据要分训练/验证/测试三份,测试集是“期末考”

- 分类看准确率、精确率、召回率、F1、AUC

- 回归看MAE、RMSE、R²

💡 建议:先掌握准确率、MAE、R²这三个最直观的指标,再逐步深入其他指标!

资料关注

公众号:咚咚王 gitee:gitee.com/wy185850518…

《Python编程:从入门到实践》 《利用Python进行数据分析》 《算法导论中文第三版》 《概率论与数理统计(第四版) (盛骤) 》 《程序员的数学》 《线性代数应该这样学第3版》 《微积分和数学分析引论》 《(西瓜书)周志华-机器学习》 《TensorFlow机器学习实战指南》 《Sklearn与TensorFlow机器学习实用指南》 《模式识别(第四版)》 《深度学习 deep learning》伊恩·古德费洛著 花书 《Python深度学习第二版(中文版)【纯文本】 (登封大数据 (Francois Choliet)) (Z-Library)》 《深入浅出神经网络与深度学习+(迈克尔·尼尔森(Michael+Nielsen)》 《自然语言处理综论 第2版》 《Natural-Language-Processing-with-PyTorch》 《计算机视觉-算法与应用(中文版)》 《Learning OpenCV 4》 《AIGC:智能创作时代》杜雨+&+张孜铭 《AIGC原理与实践:零基础学大语言模型、扩散模型和多模态模型》 《从零构建大语言模型(中文版)》 《实战AI大模型》 《AI 3.0》