用可视化工作流驱动 QQ、微信、飞书、钉钉、Telegram、Discord 等多平台聊天机器人,无需写代码。

LangBot 是一个开源的即时通讯机器人平台,支持将 Langflow、n8n、Dify、FastGPT、Coze 等 AI 工作流引擎接入微信、QQ、飞书、钉钉、Telegram、Discord、Slack、LINE 等平台。本文展示如何使用 Langflow 的可视化工作流作为 LangBot 的对话引擎。

为什么选择这个方案

- 真正的多平台:一套工作流同时支持 8+ 个即时通讯平台

-

- 可视化编排:拖拽式设计对话流程,支持条件分支、多轮对话、外部 API 调用

-

- 灵活的 AI 模型:支持 OpenAI、Claude、Gemini、DeepSeek 等多种 LLM 和本地模型

-

- 完全开源:LangBot 和 Langflow 都是开源项目,可自由部署和定制

准备工作

- Python 3.10+

-

- Docker(推荐用于快速部署)

-

- OpenAI API Key 或其他 LLM 服务的 API Key

第一步:部署 LangBot

使用 uvx 一键启动:

uvx langbot

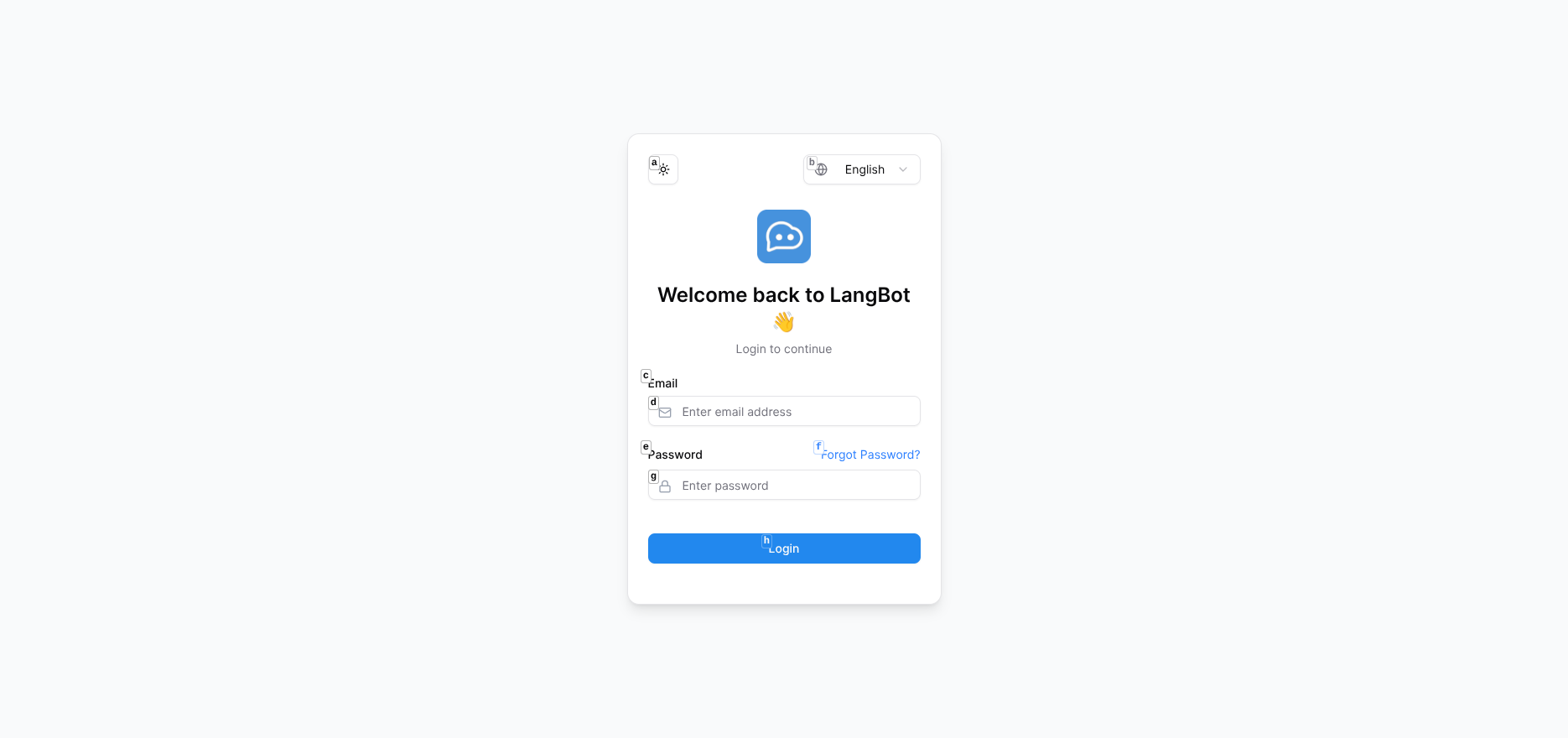

首次运行会自动初始化并打开浏览器访问 http://127.0.0.1:5300。

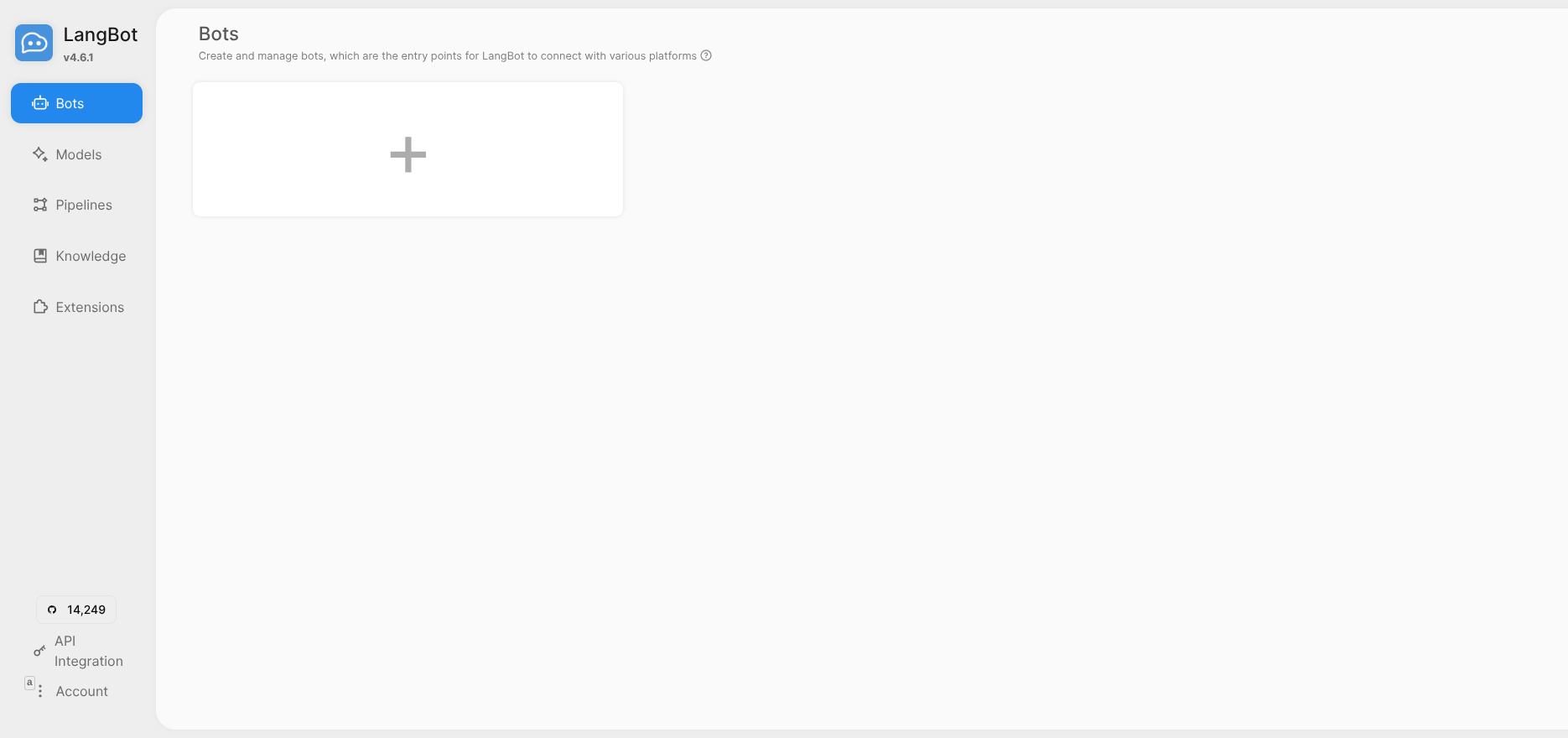

完成注册后登录,进入控制面板:

第二步:部署 Langflow

使用 Docker 快速部署:

docker run -d --name langflow -p 7860:7860 langflowai/langflow:latest

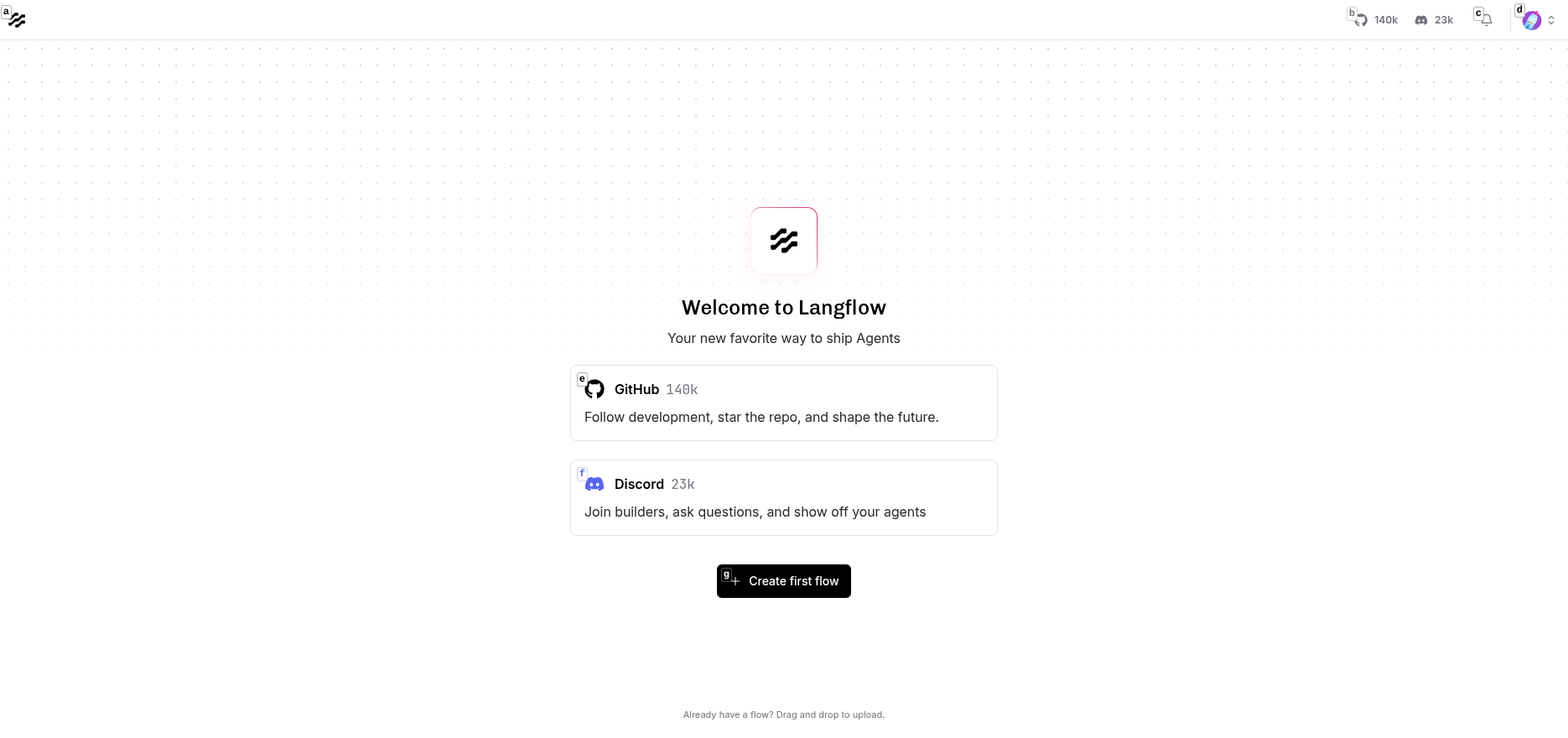

访问 http://localhost:7860 进入 Langflow:

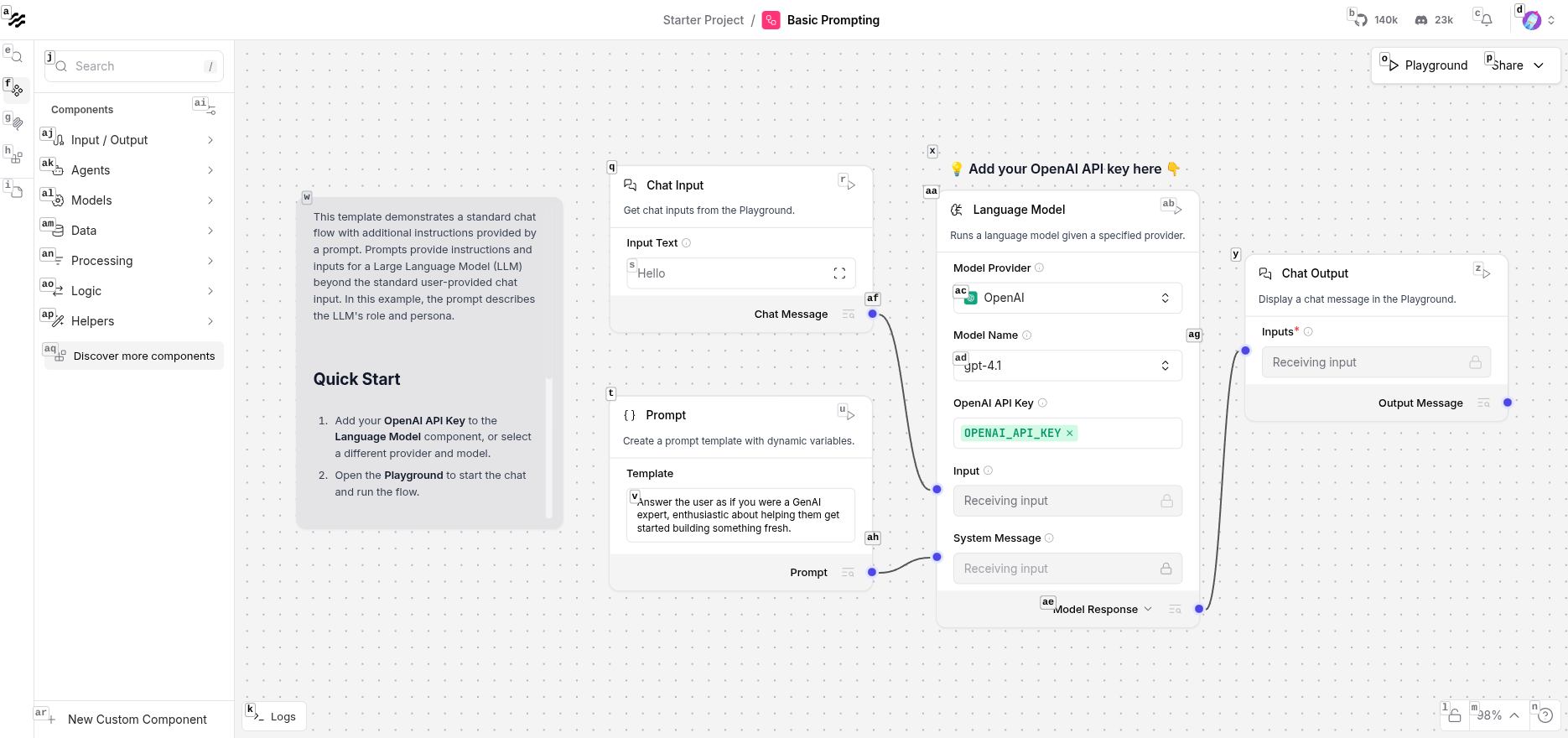

第三步:创建 Langflow 工作流

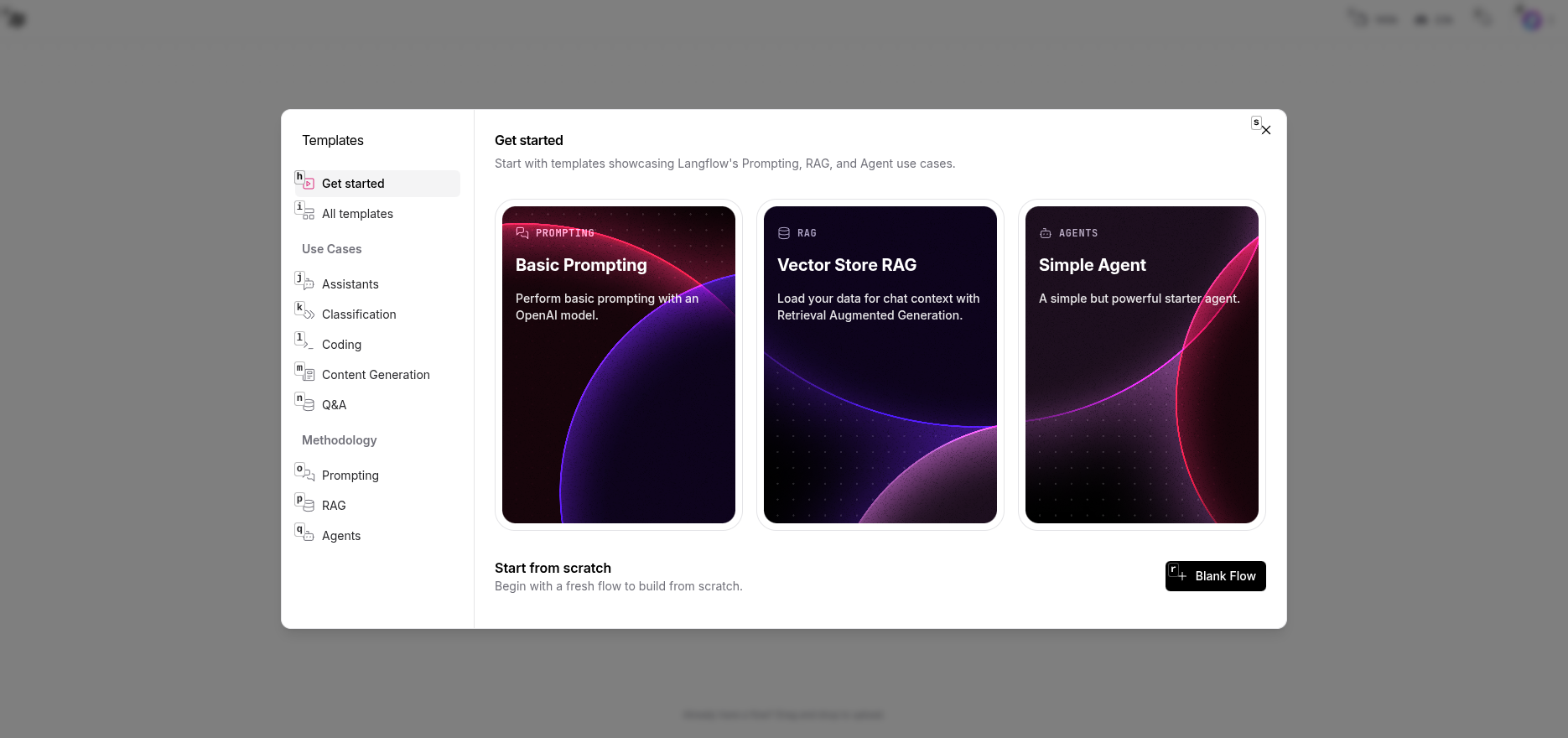

在 Langflow 中选择 "Basic Prompting" 模板快速开始:

这个模板包含四个基础组件:

- Chat Input:接收用户输入

-

- Prompt:设置系统提示词

-

- Language Model:调用 LLM 生成回复

-

- Chat Output:返回结果

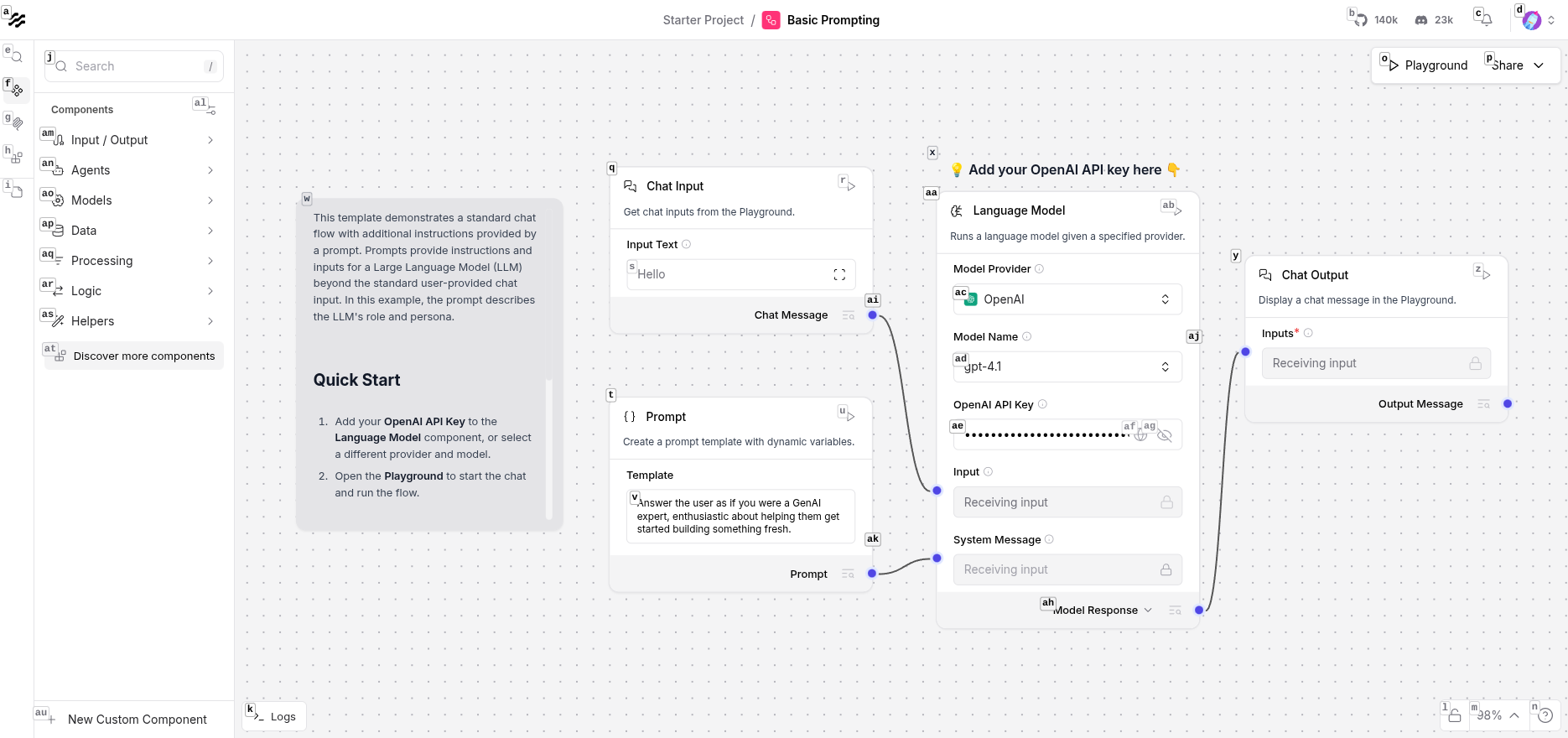

配置 Language Model

点击 Language Model 组件,配置:

- Model Provider: 选择 OpenAI(或其他兼容的提供商如 SiliconFlow、New API)

-

- Model Name: 选择 gpt-4o-mini 或 deepseek-chat

-

- OpenAI API Key: 输入你的 API Key

提示:可以使用 OpenAI 兼容的 API 服务,如 SiliconFlow、New API 等,只需修改 Base URL 即可。

配置完成后保存工作流。

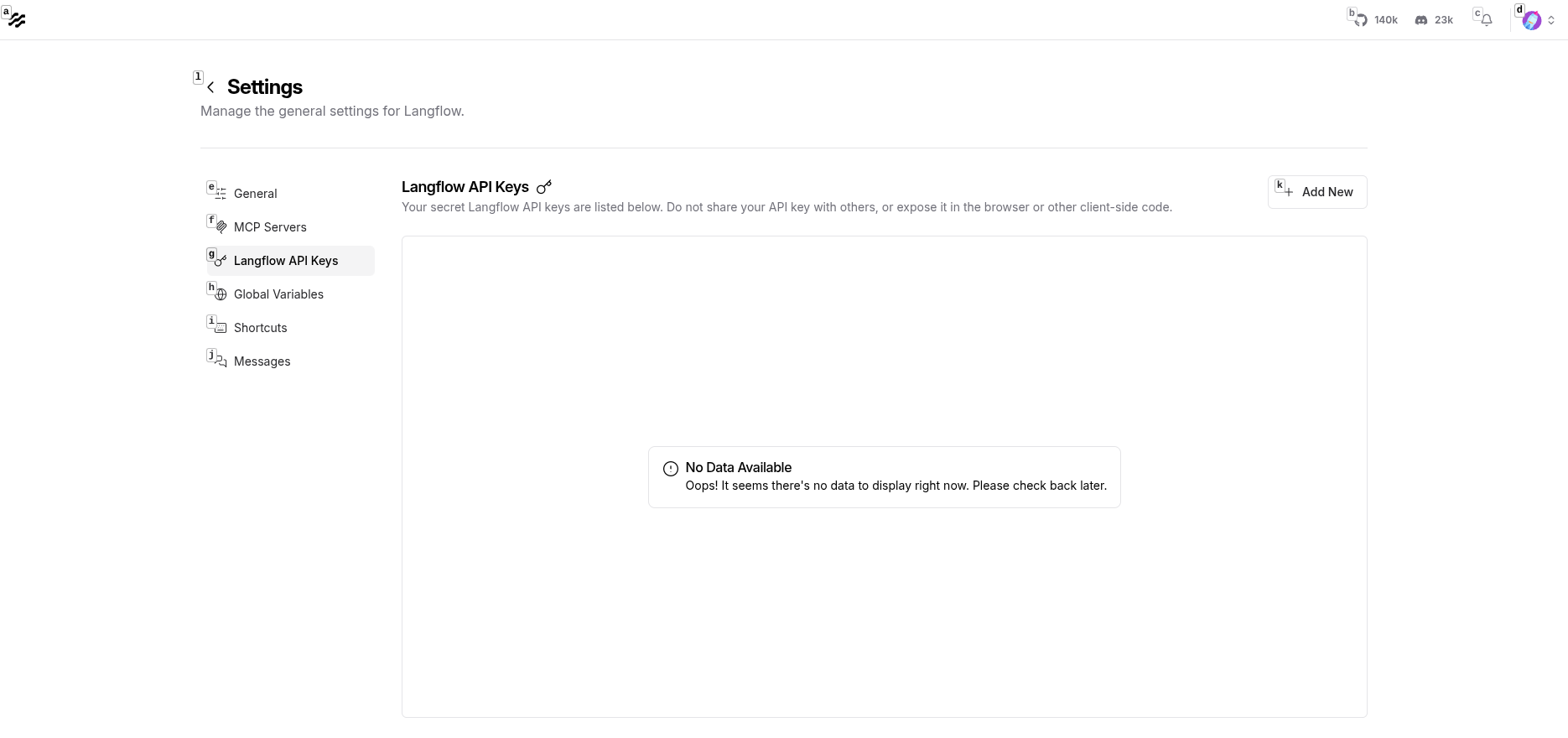

第四步:获取 Langflow API 信息

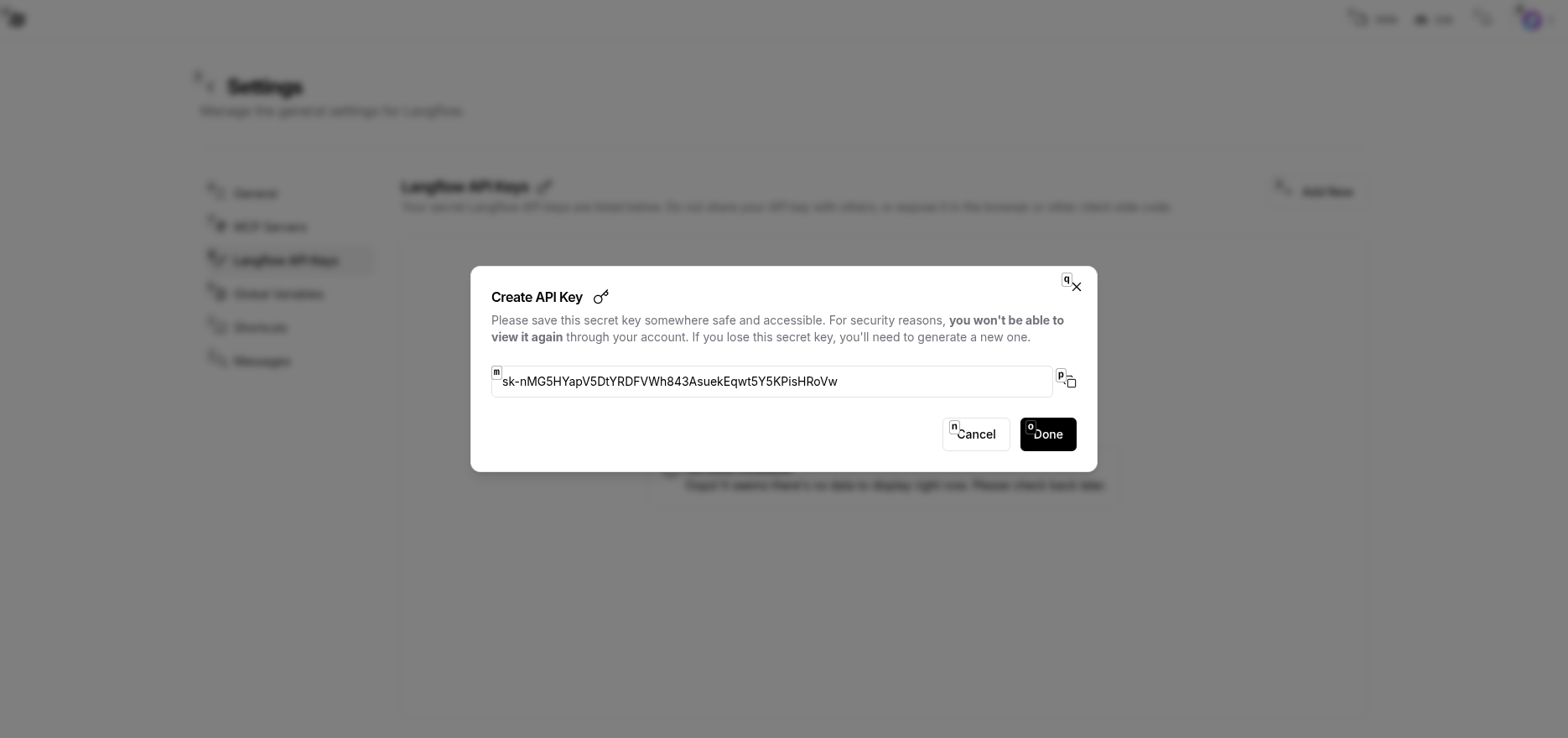

生成 API Key

在 Langflow 右上角:设置 → API Keys,进入 API Keys 页面:

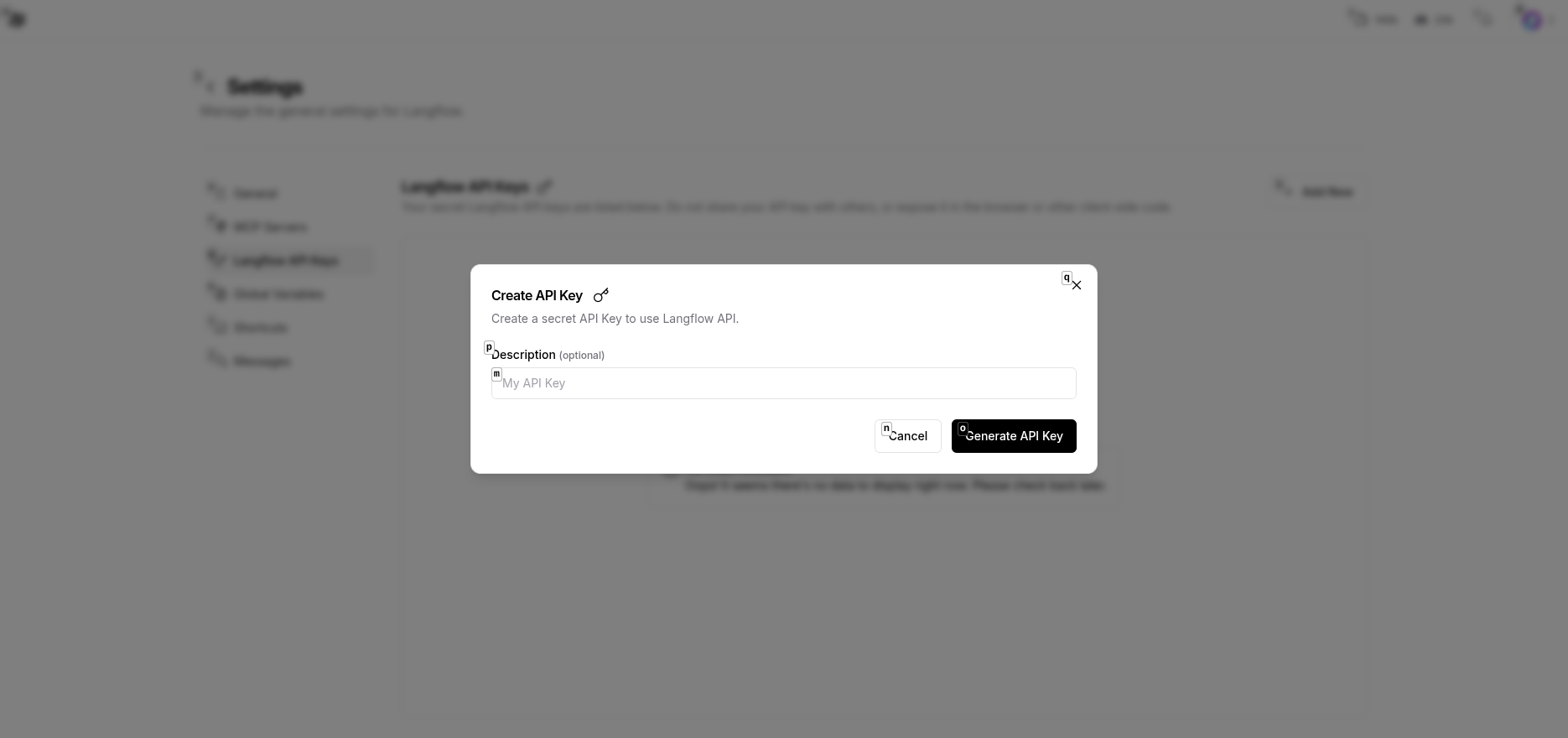

点击 Create New Key:

生成并保存 API Key:

格式:sk-xxxxxxxxxxxxxxxxxxxxxxxx

获取 Flow ID

从流程编辑器的 URL 中获取:

http://localhost:7860/flow/{flow-id}

记录这个 flow-id。

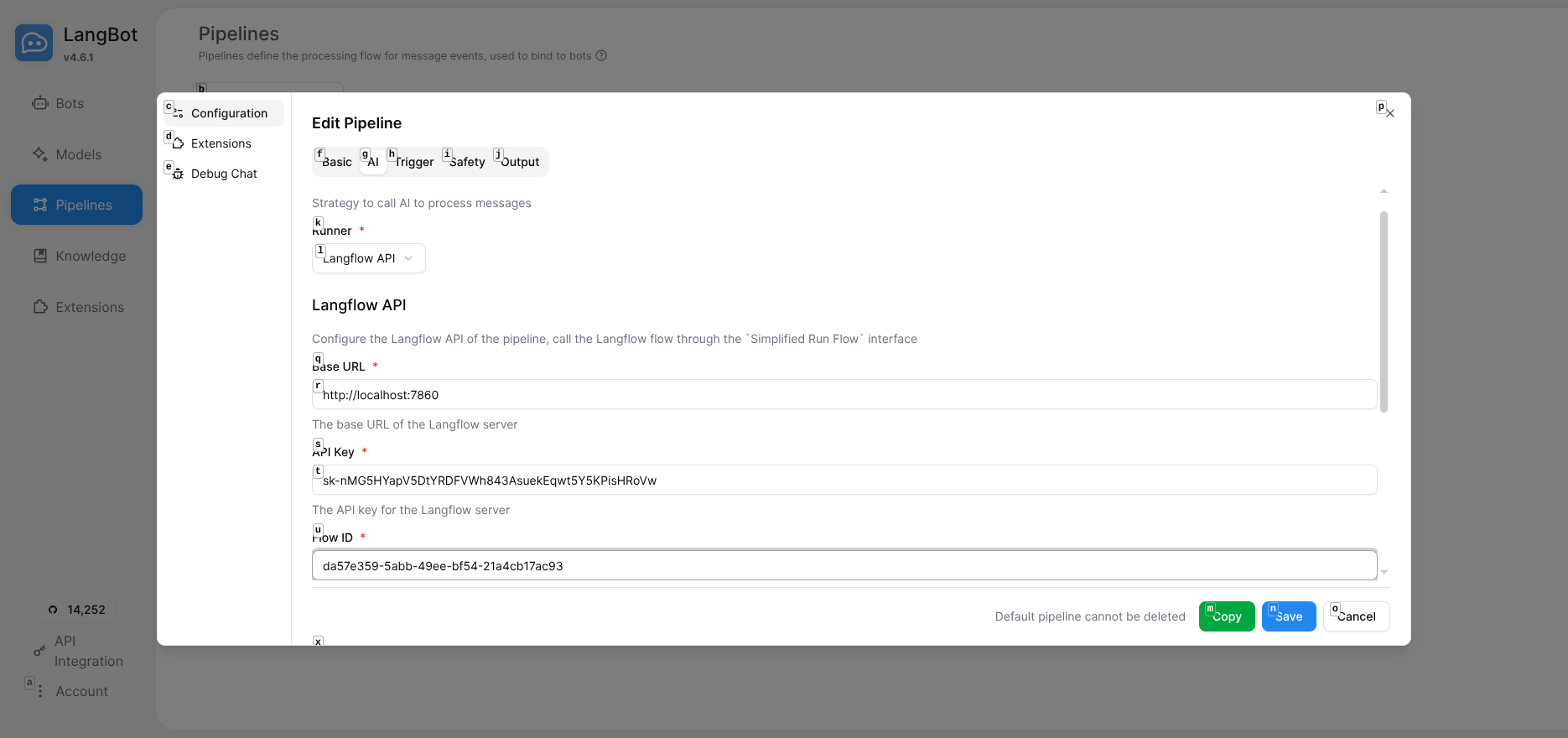

第五步:在 LangBot 中配置 Langflow

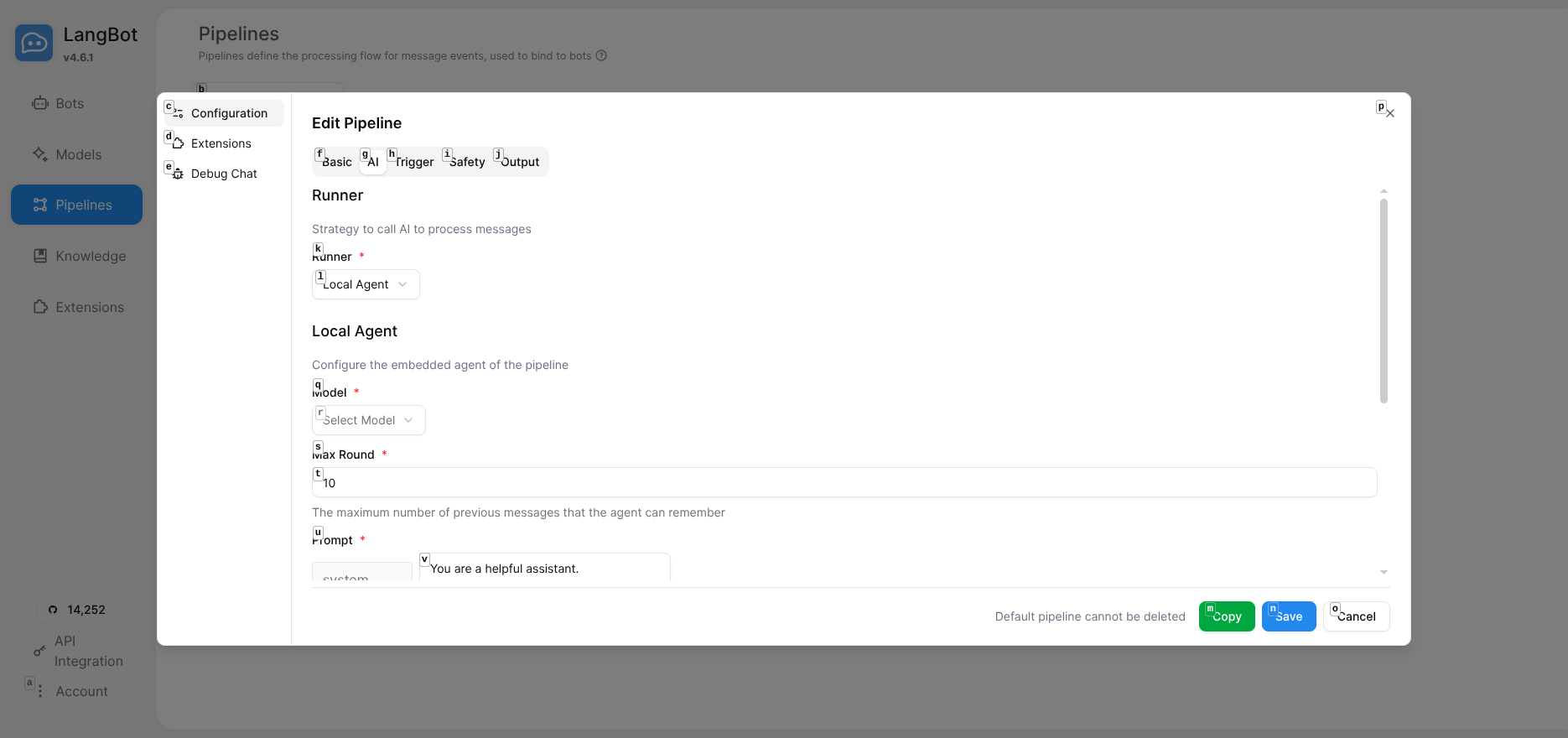

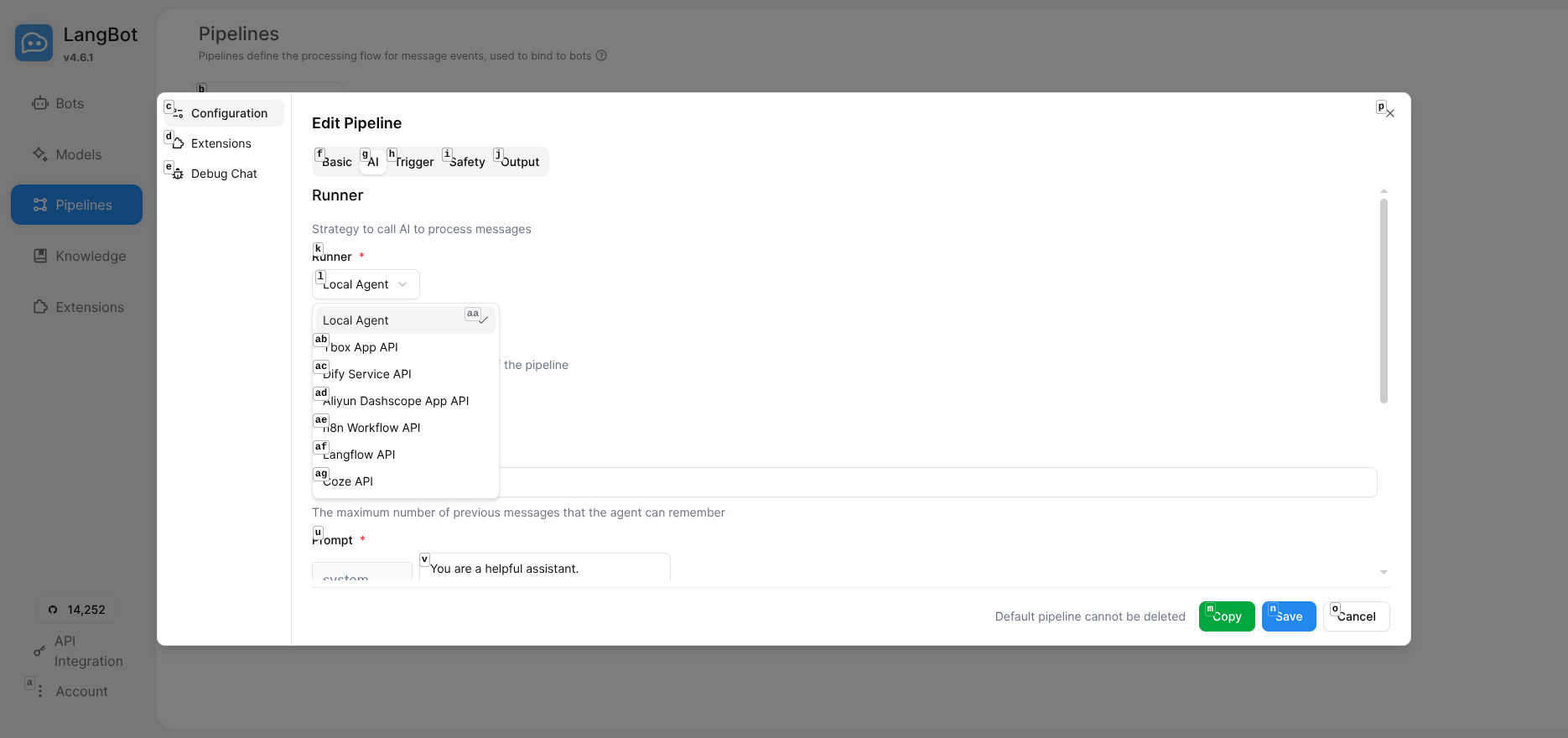

回到 LangBot 控制面板,进入 Pipelines 页面。

点击 ChatPipeline 进入编辑,在 AI 选项卡中:

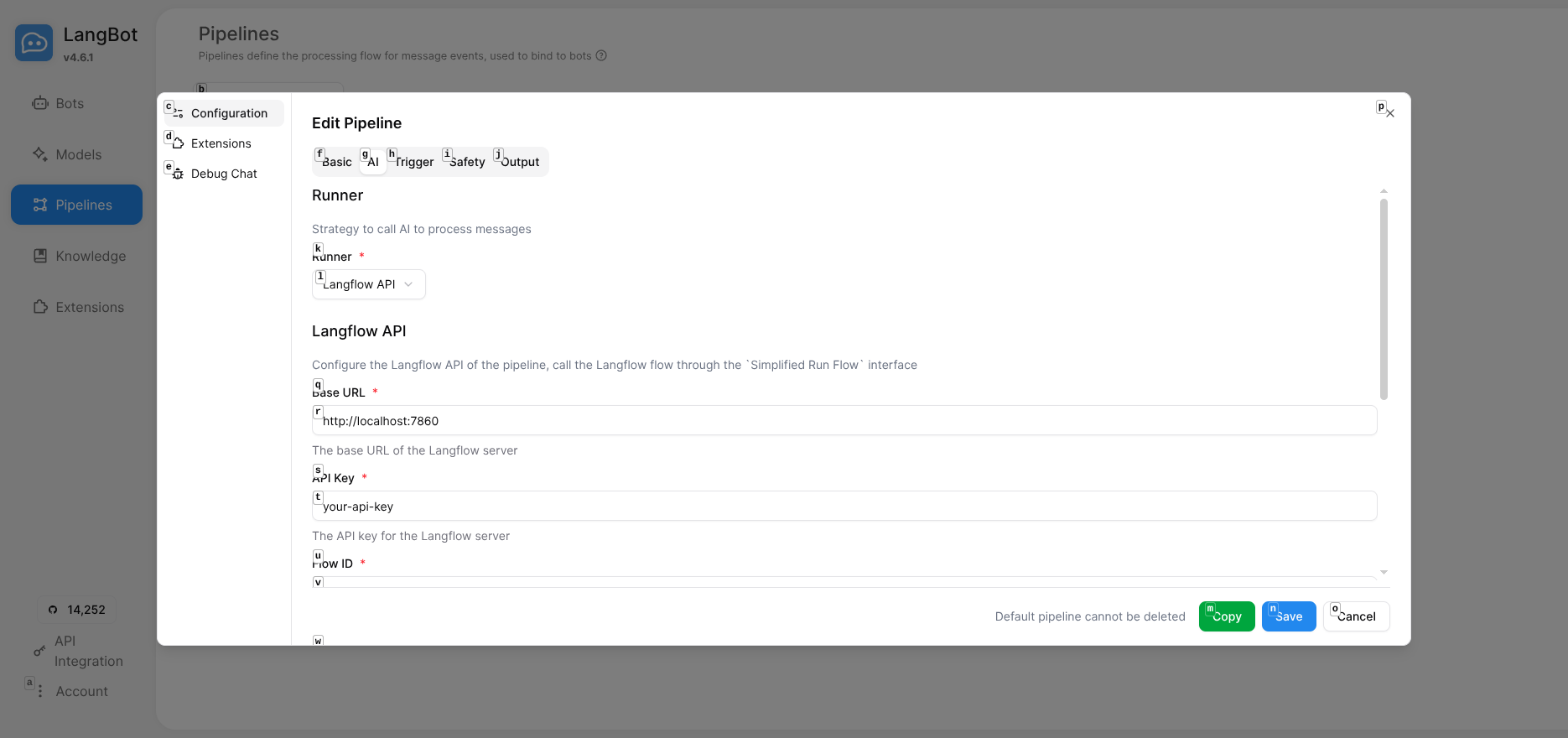

配置 Runner,选择 Langflow API:

填写 Langflow 配置:

配置项说明:

- Base URL:

http://localhost:7860(本地部署)或http://langflow:7860(Docker 网络) -

- API Key: Langflow 生成的 API Key

-

- Flow ID: 之前记录的 Flow ID

Docker 提示:如果两个服务都在容器中,确保它们在同一网络,Base URL 使用容器名称。

点击 Save 保存配置。

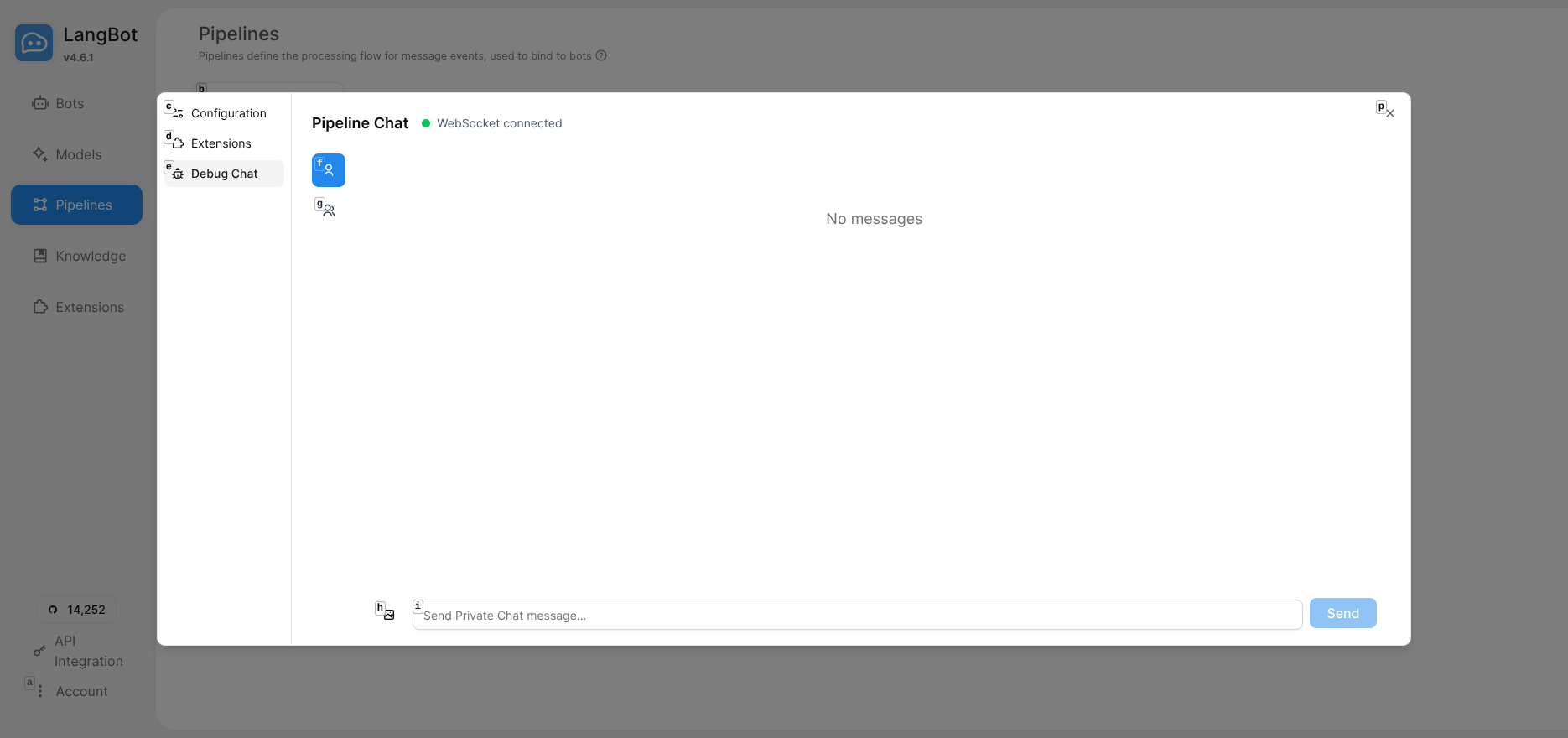

第六步:测试对话

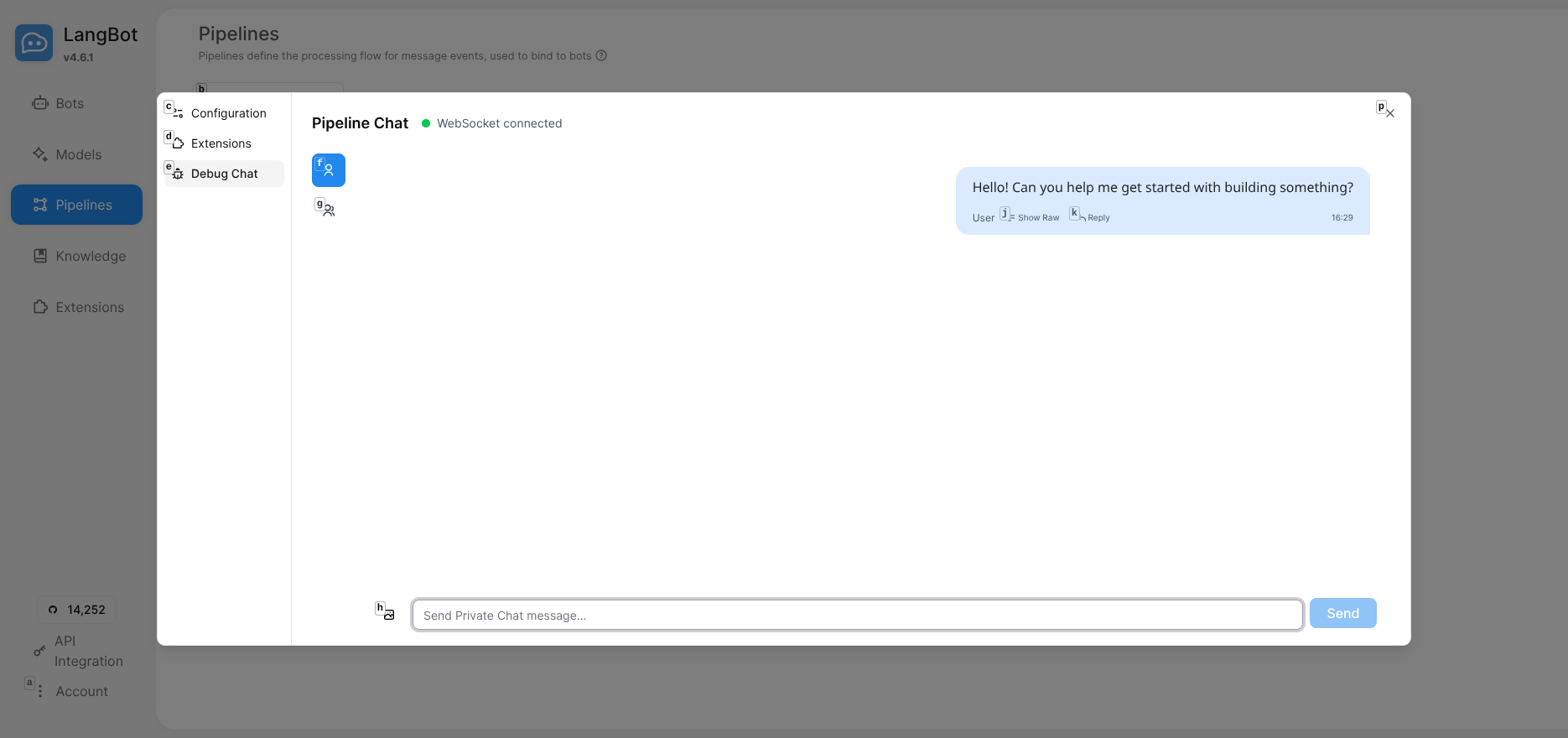

在 Pipelines 页面点击 Debug Chat,进入调试聊天界面:

输入测试消息如 "Hello",查看 AI 回复:

工作原理

- 用户在即时通讯平台发送消息

-

- LangBot 接收并传递给 Pipeline

-

- Pipeline 调用 Langflow API

-

- Langflow 执行工作流:接收输入 → 添加提示词 → 调用 LLM → 返回结果

-

- LangBot 将回复发送给用户

常见问题

Langflow 无法连接?

检查 Base URL。Docker 部署时确保容器在同一网络:

docker network create langbot_network

docker network connect langbot_network langflow

docker network connect langbot_network langbot

使用容器名称:http://langflow:7860

API 调用失败?

- 确认 API Key 和 Flow ID 正确

-

- 检查 Langflow 中的 Language Model 是否配置了有效的 LLM API Key

进阶玩法

Langflow 的强大之处在于可视化编排复杂的 AI 工作流:

- 多轮对话记忆:添加 Memory 组件实现上下文理解

-

- 条件分支:根据用户输入执行不同逻辑

-

- 外部 API 集成:连接数据库、搜索引擎、第三方服务

-

- 多 Agent 协作:让多个 LLM 模型协同工作

-

- RAG 应用:集成向量数据库实现知识库问答

这些都可以通过拖拽完成,无需编写代码。

总结

通过 LangBot + Langflow 的组合,你可以快速构建功能强大的多平台 AI 聊天机器人。Langflow 提供可视化的工作流编排能力,LangBot 负责接入各种即时通讯平台,两者配合实现从工作流设计到多平台部署的完整闭环。

这个方案特别适合:

- 需要在多个平台部署相同 AI 能力的场景

-

- 希望快速迭代和测试不同对话流程的团队

-

- 想要构建复杂 AI 应用但不想深入编码的开发者

相关资源

- LangBot 官网 | 文档 | GitHub

-

- Langflow 官网 | 文档 | GitHub

本文基于 LangBot 最新版本编写。LangBot 支持与 Dify、n8n、FastGPT、Coze 等多种 AI 平台集成,可根据需求选择最适合的工作流引擎。