PaddleOCR-VL技术深度解析:0.9B参数实现SOTA文档解析

大家好,我是AI算法工程师七月,曾在华为、阿里任职,技术栈广泛,爱好广泛,喜欢摄影、羽毛球。目前个人在烟台有一家企业星瀚科技。

我会在这里分享关于 编程技术、独立开发、行业资讯,思考感悟 等内容。爱好交友,想加群滴滴我,wx:swk15688532358,交流分享

如果本文能给你提供启发或帮助,欢迎动动小手指,一键三连 (点赞、评论、转发),给我一些支持和鼓励,谢谢。

作者:七月 链接:julyblog 来源:七月 著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

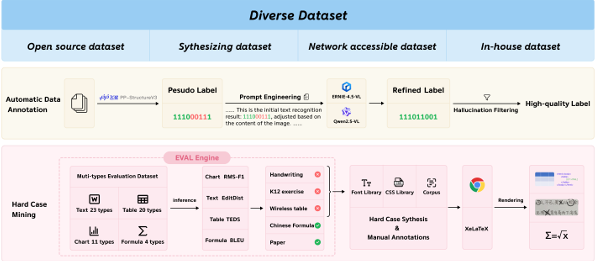

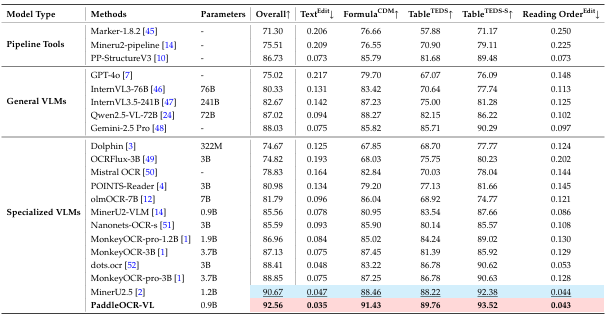

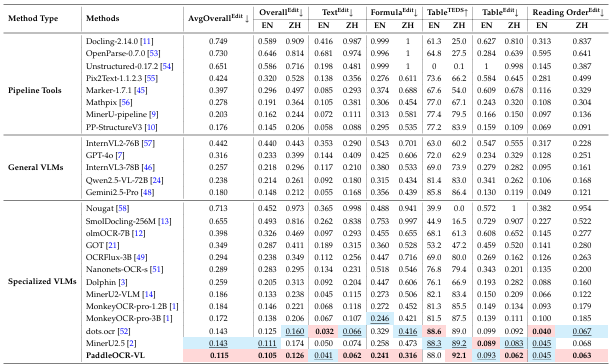

添加图片注释,不超过 140 字(可选)

PaddleOCR-VL发布开源

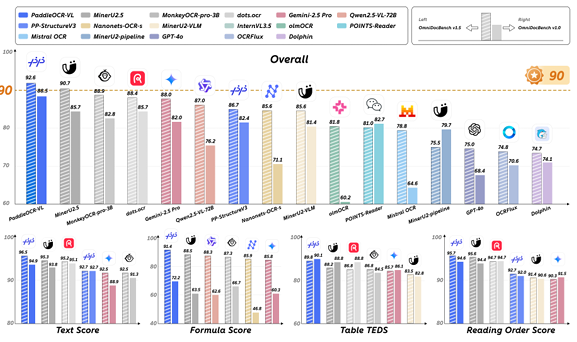

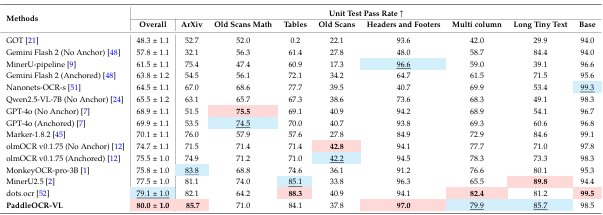

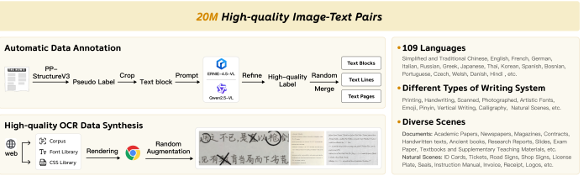

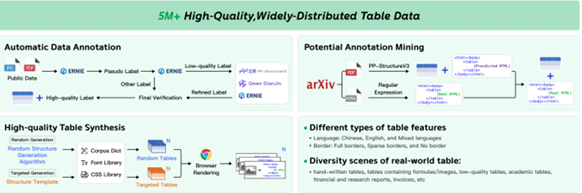

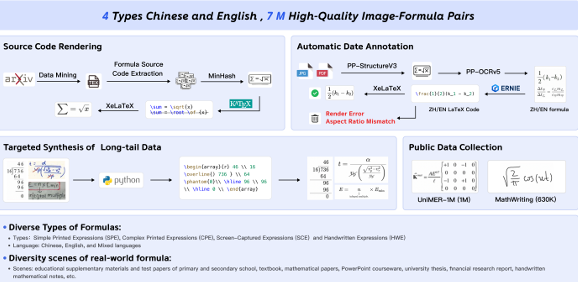

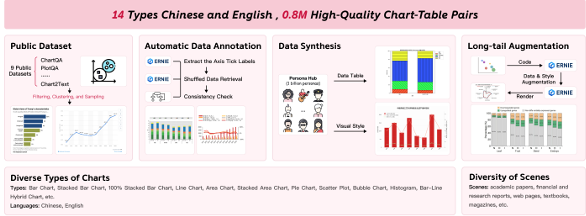

PaddleOCR-VL是百度飞桨团队开源的多模态文档解析模型,参数量仅0.9B,专为低算力设备优化。在国际权威评测OmnidocBench V1.5中以92.6分登顶全球第一,超越GPT-4o等主流模型。模型采用双阶段架构:PP-DocLayoutV2负责版面分析,PaddleOCR-VL-0.9B完成内容识别,支持109种语言,能精准处理表格、公式、图表等复杂元素,输出结构化Markdown/JSON数据。轻量化设计使其适合本地部署,尤其适合医疗报告、古籍识别等对隐私要求高的场景。

值得一提的是,PaddleOCR-VL是文心4.5最强衍生模型,它基于ERNIE-4.5-0.3B语言模型训练而来,参数量仅为0.9B,展现了轻量高效的卓越特性。它支持100+种语言文字、手写文字的识别、竖版文字识别、表格中公式识别等多种功能,堪称"PDF之神",是文档的"照相机",更是信息的"翻译官",能将杂乱的版面直接"翻译"成规整的结构化数据。

PaddleOCR-VL在开源后16h,登顶HuggingFace Trending全球第一。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

老规矩先放传送门:

- 项目官网:PaddleOCR-VL:通过 0.9B 超紧凑视觉语言模型增强多语种文档解析

- HuggingFace模型库:huggingface.co/PaddlePaddl…

- arXiv技术论文:arxiv.org/pdf/2510.14…

- 在线体验Demo:huggingface.co/spaces/Padd…

- 官方体验地址:应用中心-飞桨AI Studio星河社区

深度解析PaddleOCR-VL

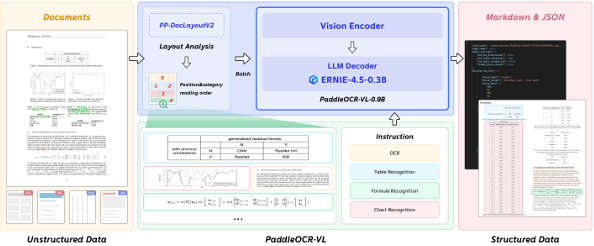

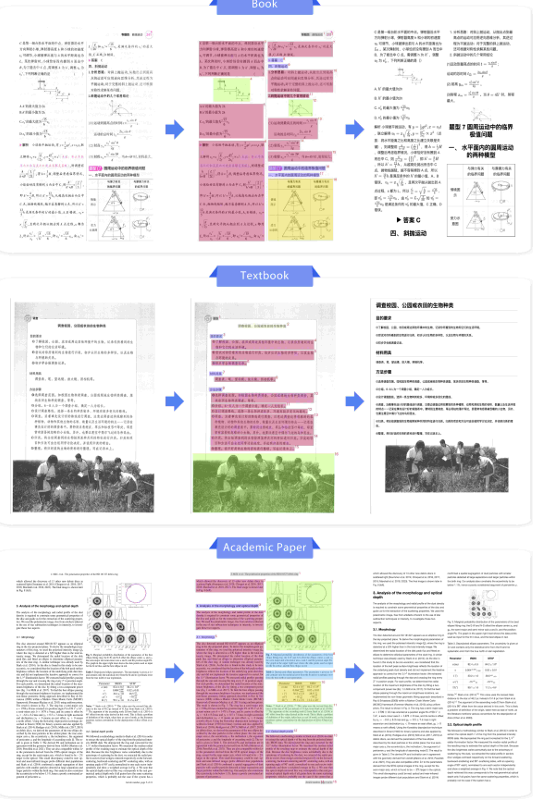

PaddleOCR-VL 将复杂的文档解析任务分解为两个阶段。第一阶段 PP-DocLayoutV2 负责版面分析,定位语义区域并预测其阅读顺序。随后,第二阶段 PaddleOCR-VL-0.9B 基于这些版面预测,对文本、表格、公式和图表等多样化内容进行细粒度识别。最后,轻量级后处理模块聚合两阶段输出,并将最终文档格式化为结构化的 Markdown 和 JSON。

版面分析------PP-DocLayoutV2

在文档解析的第一阶段,PP-DocLayoutV2负责执行精细的版面分析,包括对文档中的语义区域进行定位,并预测其正确的阅读顺序。这一阶段的关键在于其解耦设计,避免了大型VLM在处理长序列时可能出现的延迟、高内存消耗和"幻觉"问题,尤其在多栏或图文混排布局中表现更稳定。

添加图片注释,不超过 140 字(可选)

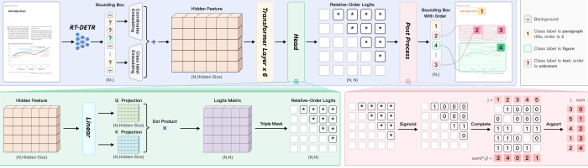

PP-DocLayoutV2主要由两部分组成:

- 基于RT-DETR的目标检测模型:该模型负责精确地检测并分类文档中的各种元素,如文本块、表格、公式、图表、图片、页眉页脚等,并输出它们的边界框位置。

- 轻量级指针网络(Pointer Network) :在检测到所有元素后,一个包含六层Transformer的指针网络会根据元素的几何位置和语义信息,预测出符合人类阅读习惯的阅读顺序。该网络还融入了几何偏置机制(Geometric Bias Mechanism),以显式建模元素间的成对几何关系,并通过确定性累积解码算法(Win-Accumulation Decoding Algorithm)恢复拓扑一致的阅读顺序。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

通过这种分而治之的策略,PaddleOCR-VL在版面分析方面展现出高度的准确性和稳定性,为后续的精准内容识别奠定了坚实基础。

元素级识别------PaddleOCR-VL-0.9B

在第二阶段,PaddleOCR-VL-0.9B基于PP-DocLayoutV2生成的版面结构预测结果,进一步完成对多种内容类型的细粒度识别,涵盖文本、表格、数学公式以及图表等。该模型仅有0.9B的参数量,却展现出卓越的性能,其核心在于以下几点:

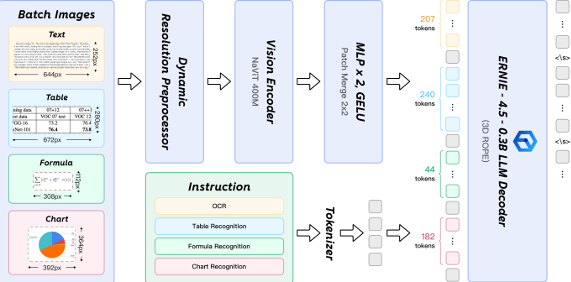

- NaViT风格的动态高分辨率视觉 编码器 :传统的VLM在处理高分辨率图像时常面临计算量大、信息失真等问题。PaddleOCR-VL-0.9B采用了NaViT(Native Vision Transformer)风格的视觉编码器,支持原生动态分辨率输入。这意味着模型可以处理任意分辨率的图像而无需进行缩放或切片,有效避免了信息损失和失真,极大地增强了对密集文本和低质量图像的识别能力。

- ERNIE-4.5-0.3B语言模型 :作为语言模型的核心,PaddleOCR-VL-0.9B集成了轻量级的ERNIE-4.5-0.3B。该模型在保持较小参数量的同时,提供了强大的语言理解能力,确保了高效的推理速度。

- 双层 MLP 投影器:负责高效地将视觉编码器提取的特征映射到语言模型的嵌入空间,实现视觉与语言信息的无缝融合。

这种视觉与语言模型的紧密结合,使得PaddleOCR-VL-0.9B不仅能"看懂"文字,更能"理解"表格、公式、图表等非文本元素的内在结构和语义,实现了从视觉信息到结构化数据的智能转换。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

后处理融合模块

两阶段结果通过轻量级后处理模块实现聚合整合,核心解决三个关键问题:一是元素边界框的精确校准,通过 IOU(交并比)匹配修正检测与识别结果的空间偏差;二是跨元素语义关联,例如将图表标题与图表数据关联存储;三是格式标准化,支持输出 Markdown、JSON、Excel 等多种格式,直接适配 RAG(检索增强生成)、数据录入等下游任务。在政务文档处理场景中,该模块使结构化输出的人工修正率从 23% 降至 4.5%。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

动态分辨率与轻量化设计

PaddleOCR-VL的轻量化设计是其另一大亮点。整体模型仅0.9B参数,可在CPU上高效运行,推理速度较同类模型提升14.2%~253.01。这种轻量化设计主要得益于两个关键因素:

- NaViT编码器的动态分辨率调整:支持根据文档复杂度自适应分配计算资源,避免了不必要的计算开销。

- 高效的多任务统一框架:通过指令驱动机制统一处理文本、表格、公式、图表等元素识别,无需针对不同任务切换模型,显著降低了部署复杂度。

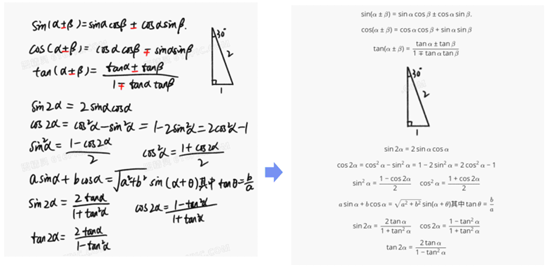

这使得PaddleOCR-VL在处理特殊元素方面具有独特优势。例如,在识别数学公式时,它不仅能够准确识别公式中的符号和数字,还能理解公式之间的逻辑关系,确保输出的结构化数据保持公式的完整性和准确性。同样,在处理表格时,模型能够准确识别表格的行列结构,合并单元格,以及表头和表体的关系,确保输出表格数据的完整性和可读性。

添加图片注释,不超过 140 字(可选)