字数 2547,阅读大约需 13 分钟

AI健带你读论文|🔥 Chain-of-Zoom:2025年最新AI超分辨率技术,实现256倍图像放大!

微信公众号:[AI健自习室]

关注Crypto与LLM技术、关注AI-StudyLab。问题或建议,请公众号留言。

论文信息

论文:Chain-of-Zoom: Extreme Super-Resolution via Scale Autoregression and Preference Alignment

作者:Bryan Sangwoo Kim, Jeongsol Kim, Jong Chul Ye (KAIST AI)

GitHub:github.com/bryanswkim/…

你是否曾经想要放大一张低分辨率图片,却发现它变得模糊不清?现有的AI超分辨率技术通常只能实现4倍放大,但如果你想要更高的放大倍数呢?本文为你详解最新的Chain-of-Zoom技术,它能将普通图片放大到原来的256倍,同时保持惊人的清晰度和细节!无论你是摄影爱好者、设计师还是技术研究者,这项突破性技术都将彻底改变你处理图像的方式。

🤔 为什么我们需要新的超分辨率技术?

你可能已经使用过一些图像放大工具,但你有没有发现,当放大倍数太大时,图像质量就会急剧下降?这不是你的错,而是当前技术的局限性。

现有超分辨率技术的瓶颈

现代的单图像超分辨率(SISR)模型面临两大关键挑战:

- 1. 超出训练范围就崩溃 📉 - 当你尝试将图像放大到超过模型训练范围(通常是4倍)时,结果会变得模糊且充满伪影

- 2. 重新训练成本高昂 💰 - 为每个更高的放大倍数专门训练新模型既耗时又低效

想象一下,你有一把只能放大4倍的"放大镜",当你想要看得更清楚时,你需要购买一个全新的、更强大的放大镜,而不是简单地叠加使用已有的工具。

Chain-of-Zoom:突破性解决方案

这就是为什么KAIST AI的研究团队提出了一个基本问题:

💡 如何有效利用超分辨率模型探索远高于其原始训练分辨率的分辨率?

他们的回答就是 Chain-of-Zoom(简称CoZ)—— 一个能够将标准4×超分辨率模型扩展至256×极限放大的突破性框架!

🧩 Chain-of-Zoom技术原理解析

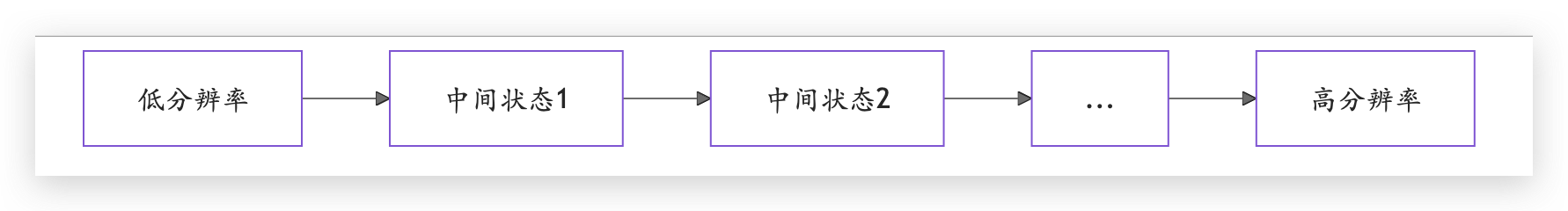

核心思想:尺度自回归链

Chain-of-Zoom的核心思想非常巧妙,它就像是"放大镜的放大镜"。具体来说,CoZ将一次性大幅放大的任务分解为多个小步骤的连续放大过程:

- 1. 🔍 首先从低分辨率图像开始

- 2. 🔄 使用现有的4×超分辨率模型进行第一次放大

- 3. 📝 利用AI生成描述性文本提示,帮助保持图像内容的语义一致性

- 4. 🔁 将上一步的输出作为新的输入,再次放大

- 5. 🚀 重复这个过程,直到达到目标放大倍数

Chain-of-Zoom就像是爬楼梯而不是一步登天。每次只爬一小步,但最终能达到极高的高度!

三大技术支柱

CoZ框架由三个关键组成部分支撑:

1️⃣ 中间尺度状态建模

传统方法尝试直接从低分辨率跳到高分辨率,而CoZ则引入了"中间尺度状态"的概念:

这种方法将复杂的条件概率分解为更易处理的子问题,使模型能够逐步构建细节,而不是一次性生成。

2️⃣ 多尺度感知提示提取

随着放大倍数增加,原始图像中的视觉信息变得越来越稀疏。为解决这个问题,CoZ使用视觉-语言模型(VLM)从多个尺度状态生成描述性文本提示:

👉 例如:当放大一张狗的照片时,VLM可能会生成这样的提示:

- • 低放大倍数:"

棕色拉布拉多犬,站在水边,嘴里叼着木棍" - • 高放大倍数:"

前景:棕色拉布拉多犬叼着木棍;背景:平静的湖水与远处的树木;细节:狗毛上的水珠与阳光反射"

这些文本提示为超分辨率模型提供了语义指导,帮助它生成更准确的细节。

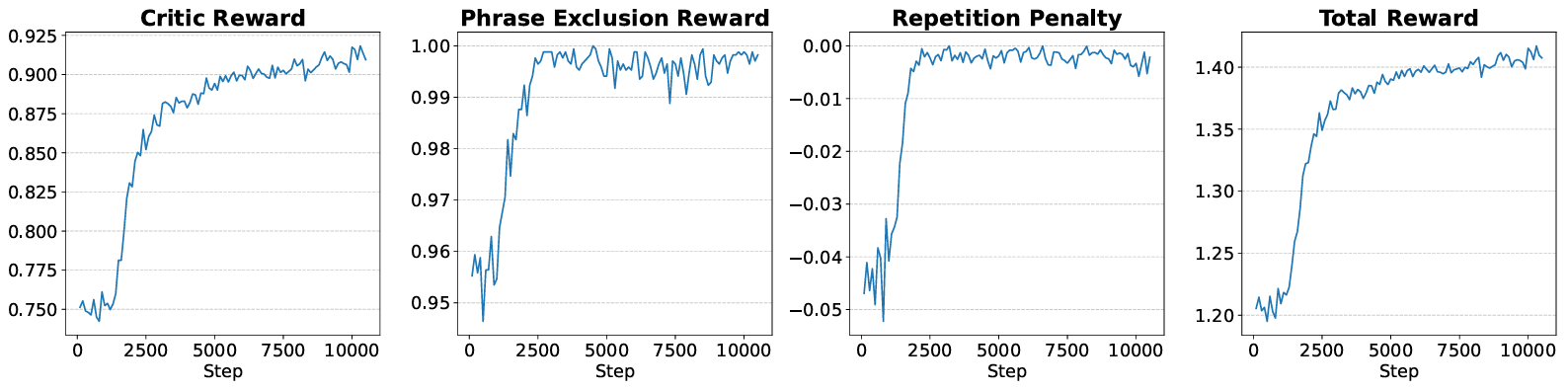

3️⃣ 偏好对齐训练

为了确保生成的文本提示真正有用,研究团队使用了广义奖励策略优化(GRPO)来微调提示提取VLM:

- 1. 📊 评论家VLM评估提示质量

- 2. 🚫 排除无用的视点标记(如"第一张图像")

- 3. 🔄 减少重复内容

- 4. 🎯 通过这些奖励信号,持续改进提示质量

📊 惊人的实验结果

质量对比:传统方法vs CoZ

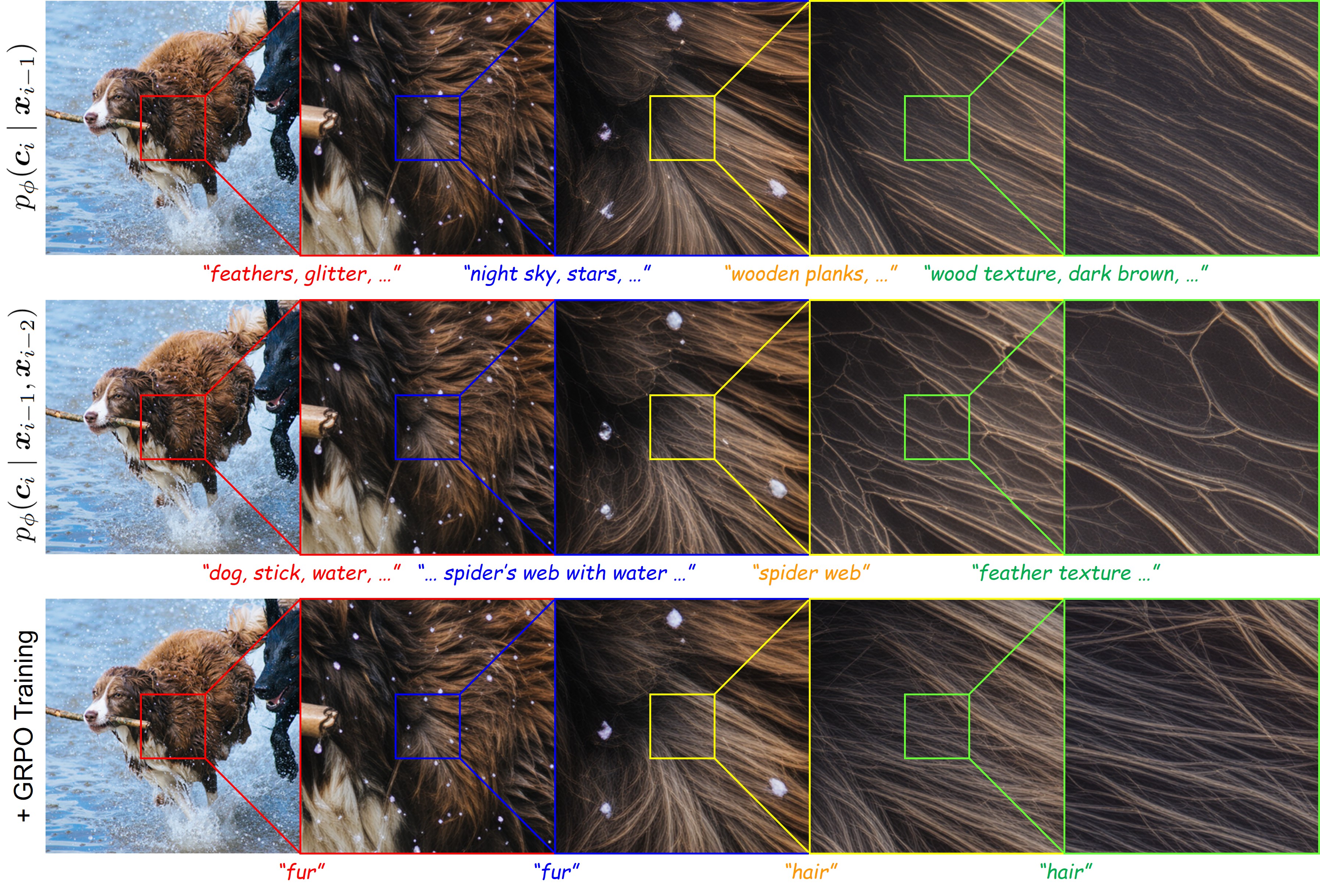

研究团队在多个数据集上进行了严格测试,结果令人震惊!看看下面的对比图:

你能看出差别吗?从上到下分别是:

- • 顶部:基础VLM仅从低分辨率输入生成提示,导致不必要的幻觉

- • 中部:多尺度图像提示在低尺度有效但高尺度失败

- • 底部:经GRPO对齐的VLM(我们的方法)生成的提示能有效引导生成高质量结果

数据说话:定量评估

在不同放大倍数下,CoZ显著优于传统方法,特别是在64×和256×等极限放大倍数下:

| 放大倍数 | 方法 | NIQE↓ (越低越好) | MUSIQ↑ (越高越好) |

|---|---|---|---|

| 4× | 最近邻插值 | 12.13 | 39.96 |

| 4× | 直接SR | 4.73 | 67.00 |

| 4× | CoZ (VLM) | 4.66 | 67.10 |

| 64× | 最近邻插值 | 27.41 | 37.69 |

| 64× | 直接SR | 16.59 | 22.54 |

| 64× | CoZ (VLM) | 8.23 | 52.13 |

| 256× | 最近邻插值 | 34.85 | 27.01 |

| 256× | 直接SR | 16.17 | 28.89 |

| 256× | CoZ (VLM) | 9.83 | 47.83 |

💡 小知识点:NIQE是一种无参考图像质量评估指标,数值越低表示图像质量越好;MUSIQ是一种机器学习图像质量评分,数值越高表示质量越好。

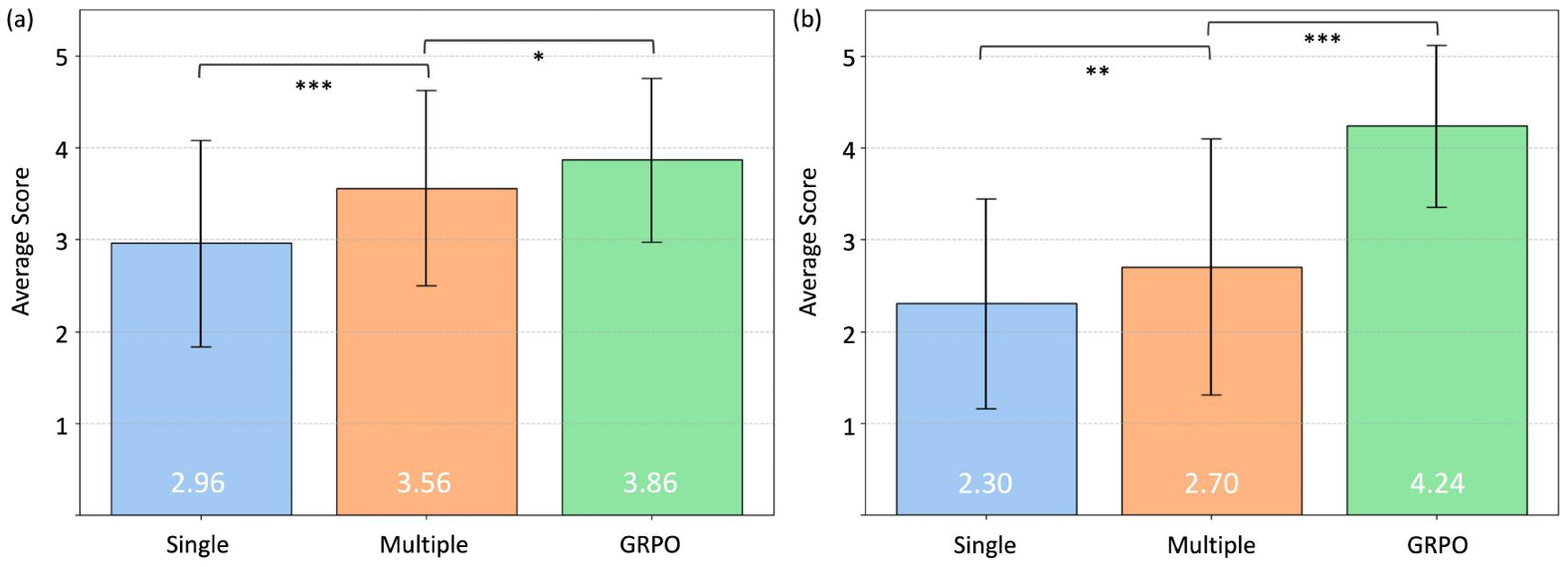

用户研究:人类也认可的质量

不仅仅是机器指标认可CoZ的效果,人类评价也同样如此!研究团队进行的平均意见分数(MOS)测试显示,使用CoZ框架处理的图像获得了更高的人类评分:

💻 如何使用Chain-of-Zoom?

想亲自体验这项突破性技术吗?以下是基本步骤:

环境配置

# 克隆仓库

git clone https://github.com/bryanswkim/Chain-of-Zoom.git

cd Chain-of-Zoom

# 创建环境

conda create -n coz python=3.10

conda activate coz

pip install -r requirements.txt

运行示例

python inference_coz.py \

-i samples \

-o inference_results/coz_vlmprompt \

--rec_type recursive_multiscale \

--prompt_type vlm \

--lora_path ckpt/SR_LoRA/model_20001.pkl \

--vae_path ckpt/SR_VAE/vae_encoder_20001.pt \

--pretrained_model_name_or_path 'stabilityai/stable-diffusion-3-medium-diffusers' \

--ram_ft_path ckpt/DAPE/DAPE.pth \

--ram_path ckpt/RAM/ram_swin_large_14m.pth;

硬件需求提示

⚠️ 注意:CoZ需要较高的计算资源。推荐使用两个GPU以获得最佳性能。如果你只有一个GPU(至少24GB VRAM),可以使用--efficient_memory参数,但会显著增加处理时间。

结果示例

使用CoZ处理后,你可以获得像这样惊人的结果:

🚀 潜在应用领域

Chain-of-Zoom技术不仅仅是学术研究,它有着广泛的实际应用前景:

医疗影像增强 🏥

放大医学图像的细节,帮助医生发现更多诊断线索:

- • MRI和CT扫描增强

- • 病理切片的高分辨率观察

- • 微血管和组织结构的细节展示

卫星和遥感图像 🛰️

提升地球观测和地理信息系统的分析能力:

- • 农作物监测与分析

- • 城市规划与土地利用研究

- • 灾害评估与环境监测

文物数字化与艺术修复 🖼️

帮助保存和研究珍贵文化遗产:

- • 古籍文献的高清数字化

- • 历史绘画的细节恢复

- • 文物表面微小刻痕的放大观察

消费级应用 📱

改善日常图像处理体验:

- • 老照片修复与增强

- • 社交媒体图像质量提升

- • 手机摄影后期处理

⚠️ 技术局限与未来展望

虽然CoZ技术令人印象深刻,但它也存在一些局限性:

已知局限

- 1. 错误累积 - 多次迭代可能会放大早期步骤中的微小错误

- 2. 计算需求 - 仍然需要强大的GPU资源

- 3. 处理时间 - 多次递归需要较长的处理时间

- 4. 可能生成不存在的细节 - 在极高放大倍数下,模型可能"想象"出原图中不存在的细节

未来改进方向

研究团队指出了几个有前途的改进方向:

- 1. 📈 自适应尺度选择 - 开发智能算法自动决定每次放大的最佳尺度因子

- 2. 🎯 领域特定优化 - 为医疗、卫星等特定领域定制奖励函数和提示生成

- 3. 🔄 端到端训练 - 研究整个CoZ框架的联合优化方法

- 4. ⏱️ 时间效率优化 - 提高推理速度,特别是在内存受限情况下

Chain-of-Zoom只是超分辨率技术发展的一个里程碑,而不是终点。未来还有更多激动人心的创新等待我们去探索!

📚 参考资料

- 1. Chain-of-Zoom 官方项目主页[1]

- 2. Chain-of-Zoom GitHub 仓库[2]

- 3. Chain-of-Zoom 论文[3]

- 4. Stable Diffusion v3[4]

- 5. Qwen2.5-VL-3B-Instruct[5]

你对这项突破性的超分辨率技术有什么看法?你会在哪些场景中使用它?欢迎在评论区分享你的想法和问题!如果你觉得这篇文章有用,别忘了点赞和转发给可能感兴趣的朋友。

👆 扫码关注【AI健自习室】,获取更多前沿AI技术解析和实用工具推荐!

引用链接

[1] Chain-of-Zoom 官方项目主页: bryanswkim.github.io/chain-of-zo…

[2] Chain-of-Zoom GitHub 仓库: github.com/bryanswkim/…

[3] Chain-of-Zoom 论文: arxiv.org/abs/2505.18…

[4] Stable Diffusion v3: huggingface.co/stabilityai…

[5] Qwen2.5-VL-3B-Instruct: huggingface.co/Qwen/Qwen2.…

.preview-wrapper pre::before { position: absolute; top: 0; right: 0; color: #ccc; text-align: center; font-size: 0.8em; padding: 5px 10px 0; line-height: 15px; height: 15px; font-weight: 600; } .hljs.code__pre > .mac-sign { display: flex; } .code__pre { padding: 0 !important; } .hljs.code__pre code { display: -webkit-box; padding: 0.5em 1em 1em; overflow-x: auto; text-indent: 0; }

本文使用 文章同步助手 同步