一、对话模型和推理模型的区别概述

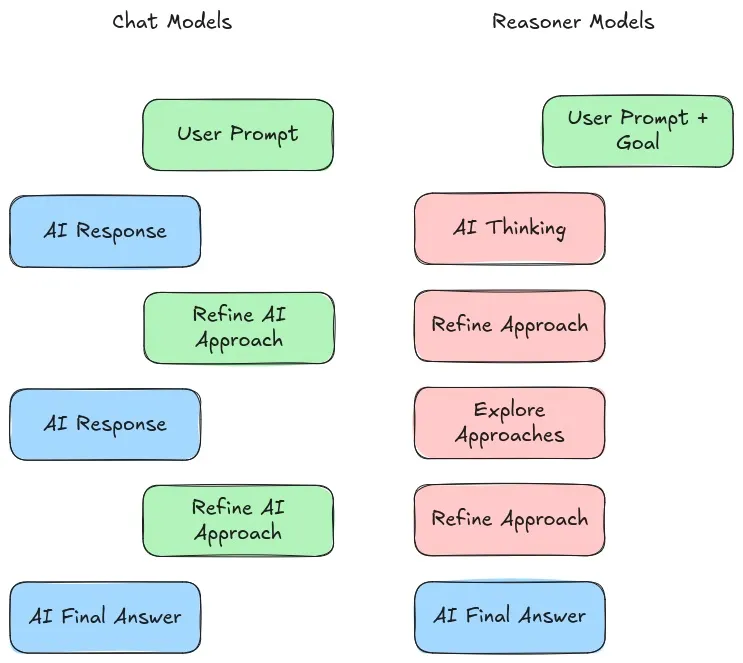

对话模型是专门用于问答交互的语言模型,符合人类的聊天方式,返回的内容可能仅仅只是一个简短的答案,一般模型名称后面会带有「chat」字样。

推理模型是比较新的产物,没有明确的定义,一般是指输出过程中带有<think>和</think>或其他表示思考过程的模型,在返回的内容中可以明确看到模型自身存在思考和反思行为。

两者的区别可以概括如下:

| 维度 | 推理模型 | 对话模型 |

|---|---|---|

| 核心目标 | 解决复杂逻辑推理、数学计算、因果推断等 | 生成符合人类语言习惯的自然交互 |

| 适用场景 | 数学问题、数据分析、代码生成 | 写作、聊天等非数理场景 |

| 能力侧重 | 精确性、逻辑严谨性 | 流畅性、上下文连贯性 |

| 代表模型 | OpenAI o1、DeepSeek r1 | OpenAI GPT4、DeepSeek V3 |

二、技术架构与训练过程

对话模型架构

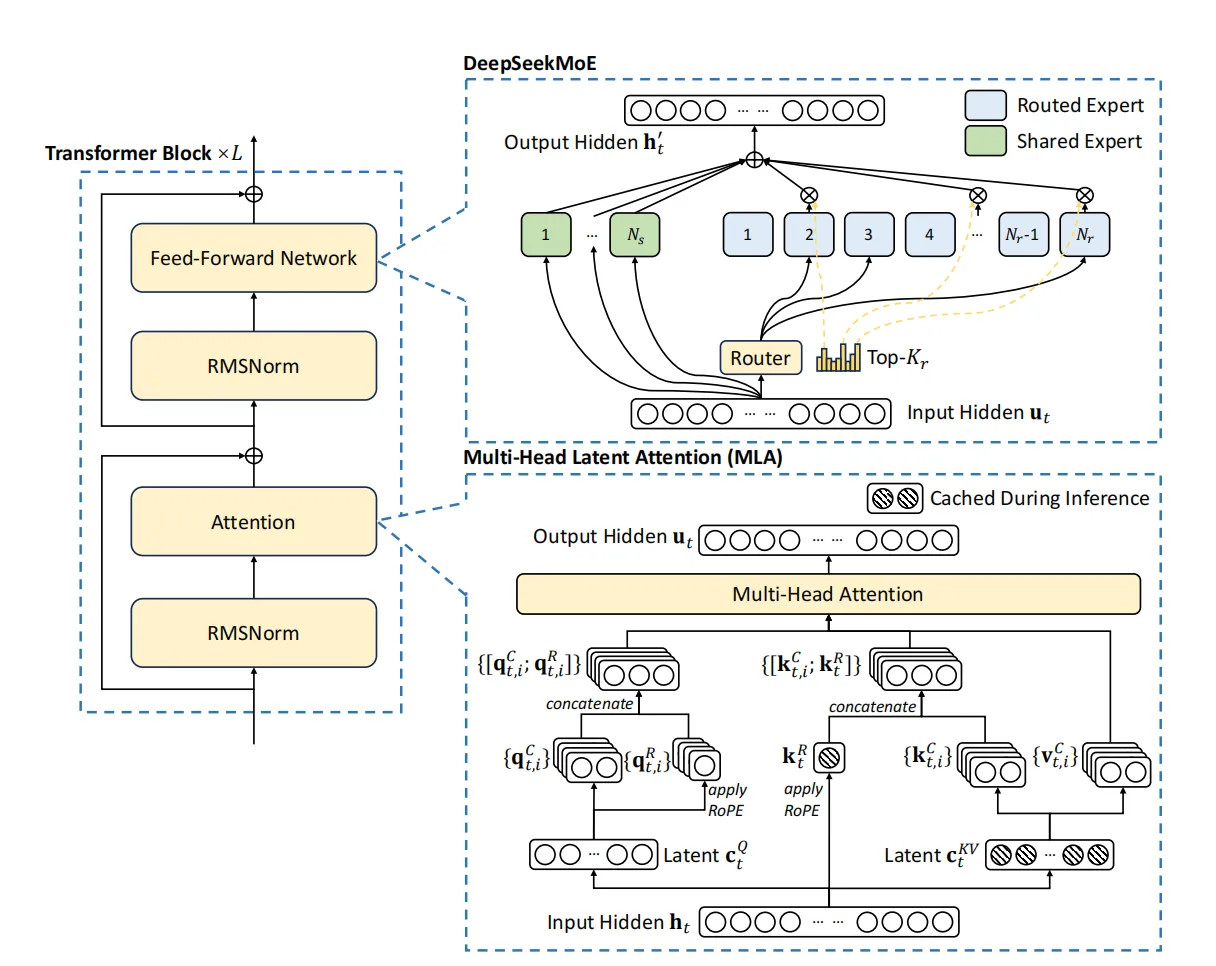

主流对话模型基于是Dense架构实现的,即典型的Transformer Decoder-Only架构, 而DeepSeek V系列模型采取了MoE架构,主要区别在于把前馈网络替换为专家网络,在推理时仅激活少量的专家,大幅度减少计算量。同时基于多头潜在注意力机制和分块技术,优化了显存占用和计算速度。

对话模型的训练过程一般包含了预训练、SFT以及模型对齐等。

预训练是整个训练流程中最重要的部分,也是消耗成本最多的环节。在这个阶段需要利用大量高质量数据进行模型的训练,一般需要万亿级别的Token,同时需要大量的GPU进行分布式训练,训练时间在几天至数月不等。

微调阶段旨在让模型掌握特定的输出样式。预训练阶段得到的模型一般称为基座模型,即只能进行上下文填充的模型,如果想让模型掌握对话能力,则需要对基座模型进行微调。一般是利用少量问答对数据进行训练,通过这部分数据让模型掌握问答对话能力。

模型对齐主要是让模型输出的内容更加安全可控,符合人类的习惯。这个阶段一般会训练一个奖励模型,通过该模型对不同的输出结果进行微调,得到高奖励值的输出。

如何得到推理模型

OpenAI的推理模型o1和o3并没有公开实现细节,工作原理尚不可知,这里仅利用DeepSeek团队公开的技术文档进行阐述。

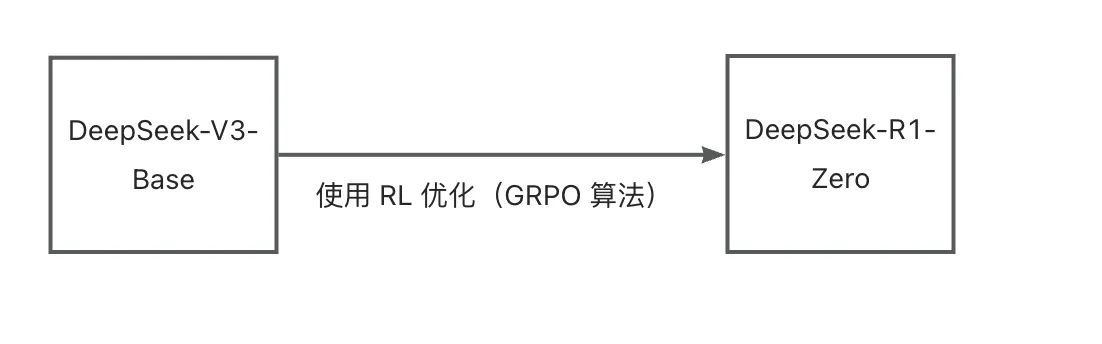

纯强化学习

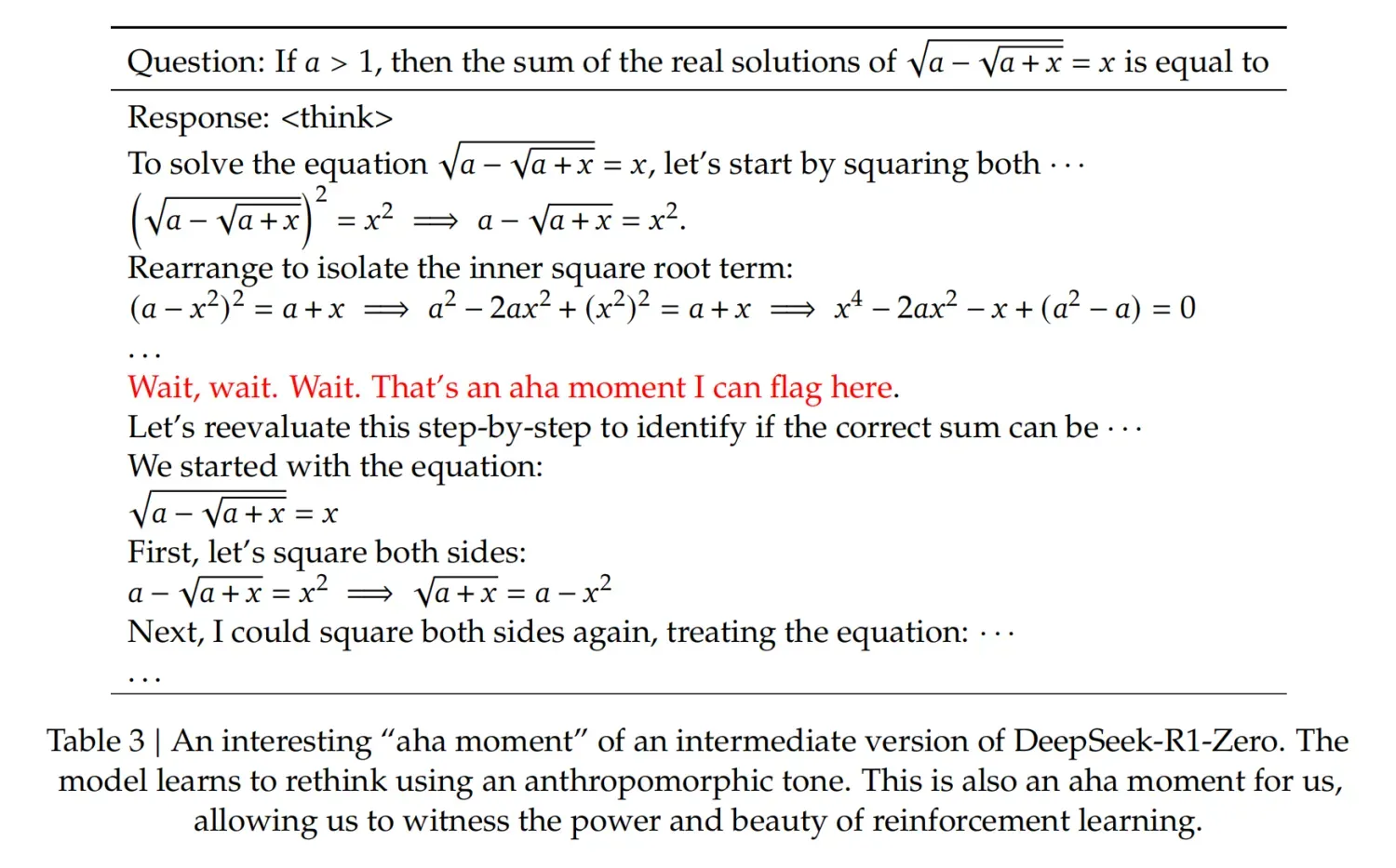

DeepSeek R1的技术报告证明了推理能力可以从纯的强化学习中学习。DeepSeek-R1-Zero仅使用强化学习进行训练,没有初始的SFT阶段,其训练过程如下图所示。

不同于传统的强化学习方法,Zero模型没有使用基于人类偏好的训练奖励模型,仅使用了两种奖励规则:准确性和格式奖励,通过该方式得到的模型具备了一定程度的推理能力,模型的推理过程包含在<think>标签之间。

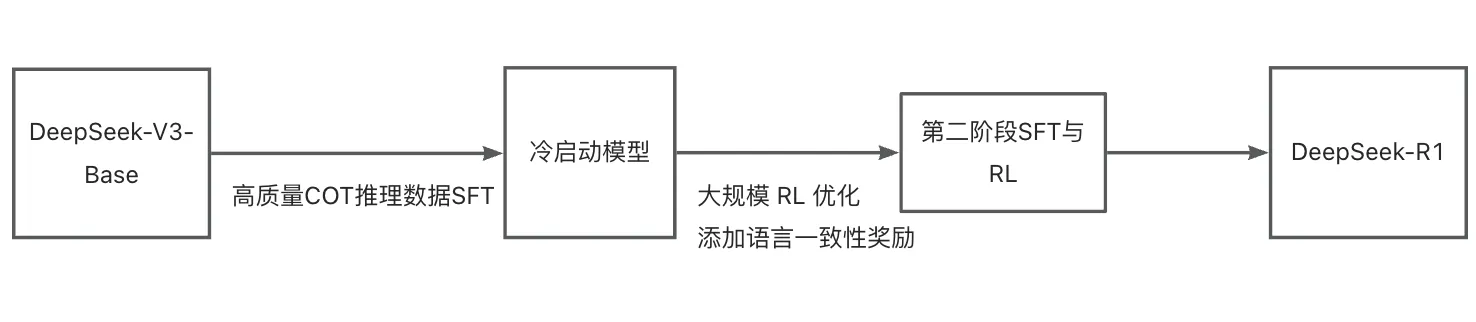

参数微调和强化学习

在DeepSeek-V3基础上,通过两个阶段的SFT和RL得到推理模型R1,其训练过程如下图所示。

更详细的内容可以查看之前的文章: xxxxxxxxxxxxxxx

基于参数微调和强化学习是构建高性能推理模型的关键方法,相比纯强化学习的方法,不仅实现了更加强大的推理性能,同时也解决纯强化学习方式得到的模型在可读性和语言一致性方面存在的问题。综合目前已经公开的技术来看,OpenAI的o1很可能是使用类似的方法训练的。

结合上述分析,推理模型与对话模型在模型的架构层面没有明显不同。主要区别在于推理模型一般需要再经过RL和推理数据SFT得到。

三、推理模型时代,Prompt工程是否有效?

提示词工程

自从ChatGPT3.5发布以来,Prompt工程逐渐进入到了实用阶段,甚至产生了Prompt Enginer这种新兴岗位,足以见得Prompt工程的重要性。

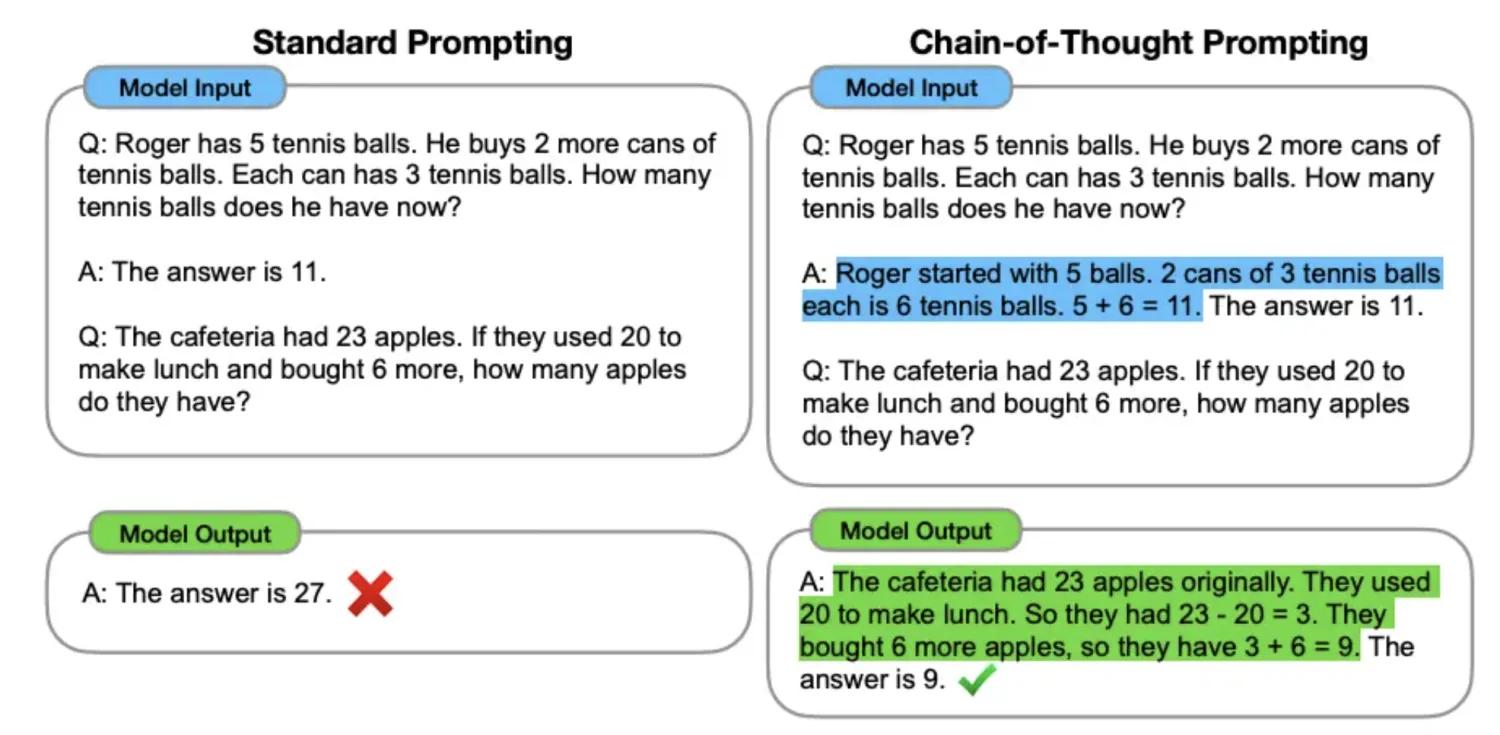

在经典的对话场景中,因为模型固有的随机性和不确定性,在简单任务下回答尚可,但是在复杂场景中可能会导致无法回答用户想要的答案。因此,prompt工程常来提高大语言模型处理复杂任务场景的能力,如问答和算术推理能力。

更多技巧和场景可以查看OpenAI官方发布的提示词工程教程: platform.openai.com/docs/guides…

1. 用“描述”代替提示词

在与对话模型交互时,一般如果输入的信息不够,模型会要求用户重新输入,或者通过调用工具自动获取相关的上下文,直到能回答用户的问题。

在整个过程中,用户需要不断与模型互动,纠正它的错误并补充更多细节,直到它给出用户满意的结果。模型会从用户的问题中提取上下文,帮助用户更好地完成任务。

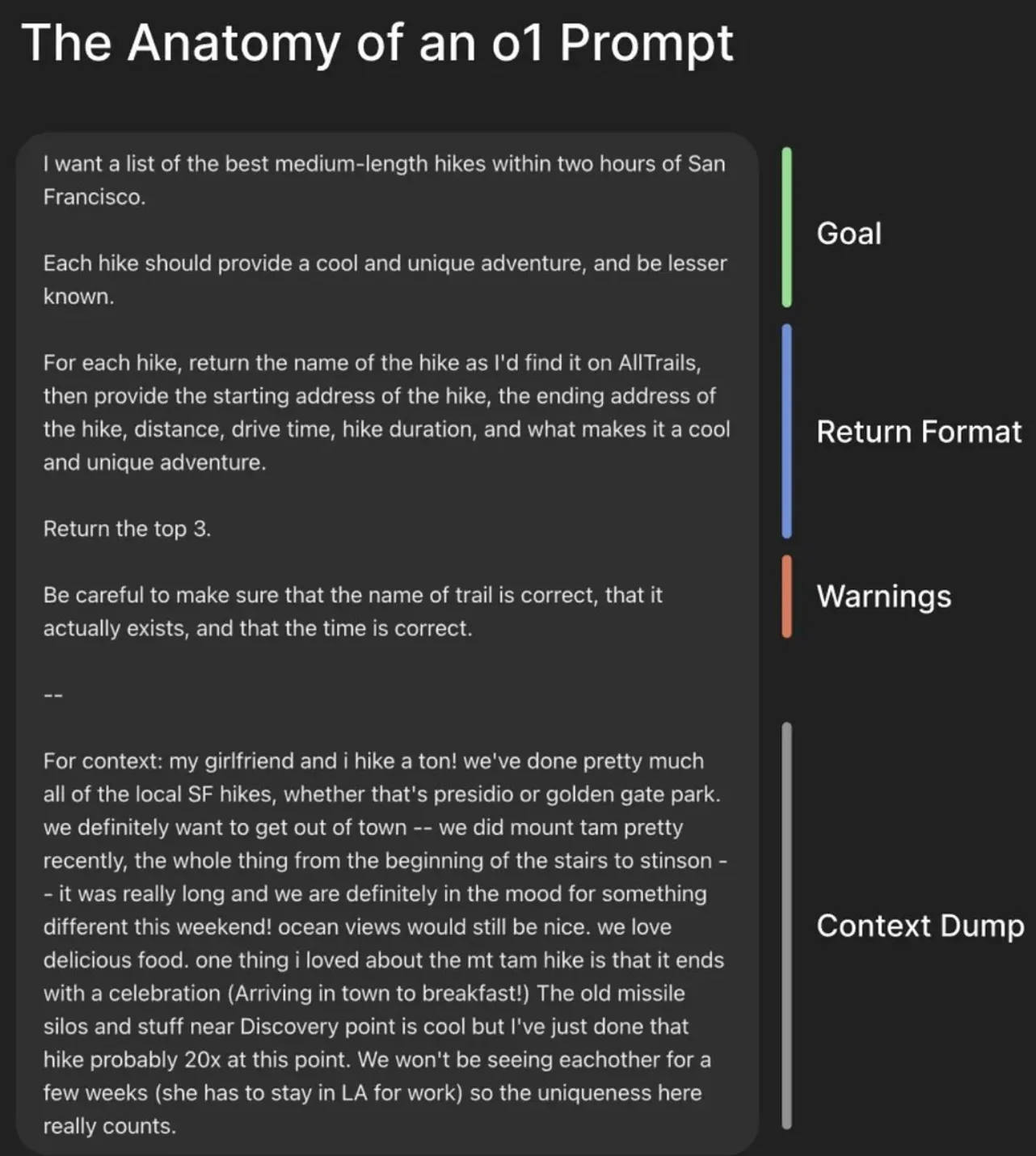

而对于推理模型而言,模型不会主动从问题中提取上下文,而是需要用户主动提供尽可能多的背景信息。简单来说,就是把模型当成一个一次性的报告生成器,这个模型会不断思考、迭代、并产生最终的结果。

上述针对o1模型的提示词可以分为:目标、格式、规则、上下文这4部分,这与传统的提示词结构基本是一致的。

2. 明确具体的目标而非实现的细节

在与推理模型交互时,明确表达想要的结果(WHAT),而不是过多地指导模型如何实现这个结果(HOW)。例如,如果想让模型写一篇文章,直接告诉它“写一篇关于气候变化的文章”,而不是详细指导它“先写引言,再写背景,最后写结论”。

传统上,我们可能会告诉模型“你是一个专家,慢慢仔细地思考”,但这种方式对于推理模型而言并不高效。像o1、r1这样的模型具有自主推理能力,能够自己规划并解决问题。如果过多地指导它“如何做”,反而可能限制它的潜力,因此一旦提供了足够的上下文,不要过多地干预模型的思考过程,而是让它自主推理和规划步骤。

总结

对于推理模型,Promot工程同样并未失效,相反,Prompt工程中很多原则依旧不可忽视,如:清晰描述清楚需求。

但是,由于推理模型自身的运行机制,需要提供比对话模型更加详细的上下文信息,同时明确表达想要的结果,不要过多指导模型的实现过程。

四、写在最后

目前推理模型还处于发展初期,相信今年会有更多杰出和激动人心的研究成果发布。

开源的影响

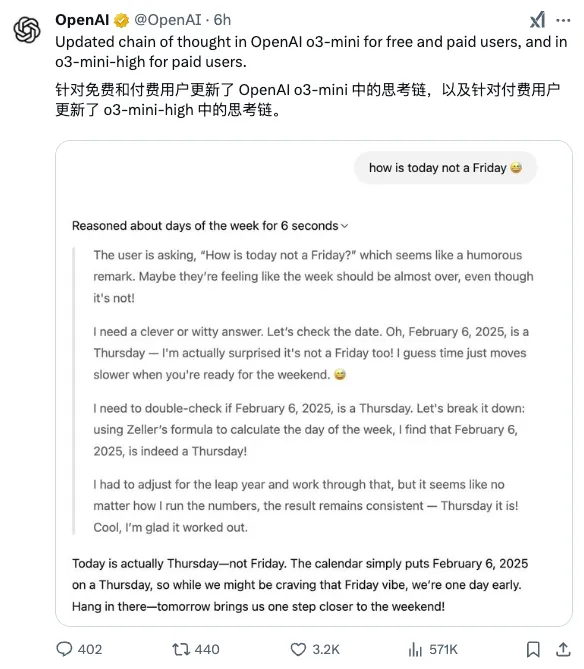

在DeepSeek席卷全球的浪潮下,OpenAI终于感受到了压力,“部分开放”出o3-mini模型的思考过程。之所以称之为部分开放,是因为这个思考过程并不是模型原始的CoT,而是一个经过处理后再展示出来的结果。可以看出尽管OpenAI不情愿,但还是被迫作出了改变。希望国内厂商再接再厉,把价格和性能再卷一卷,苦一苦国外这些巨头。

低成本的推理模型

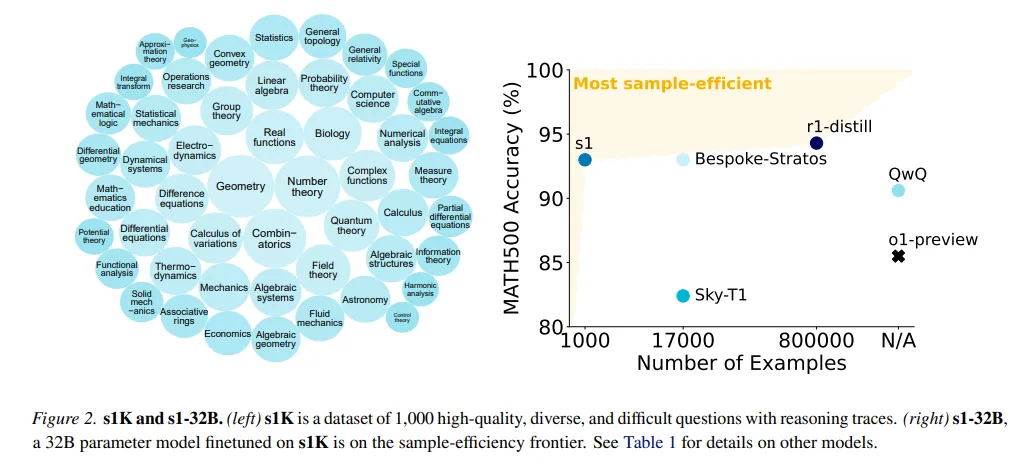

DeepSeek的研究报告表明可以通过蒸馏技术让模型产生一定程度的推理能力,该方法兼顾经济效益和性能,此后已经有不少类似的研究成果,比如李飞飞团队的《s1: Simple test-time scaling》号称50美元训练出的模型在某些测试场景中超过了o1-preview。

用更少的成本和芯片训练出更强大的模型,这是一个正确的方向,如果陷入到堆模型堆算力的误区,恐怕国产大模型只能一直当追随者。