因果推断建模流程里,构建好了贝叶斯网络结构图,下一步是要做贝叶斯网络的概率计算。概率计算环节,往往会涉及到一些经典的概率分布,这篇文章主要是为了复习下常用的概率分布。

Bernoulli Distribution(伯努利分布)

考虑把1个小球(1个随机变量),放入2个箱子的概率。若小球在箱子1的概率为p,则小球在箱子2的概率为1−p。

Categorical Distribution(类别分布)

考虑把1个小球(1个随机变量x),放入K个箱子的概率。若小球在箱子k的概率为θk,即P(xk=1)=θk,其中∑k=1kθk=1。故,

p(x∣θ)=k=1∏Kθkxk

Multinomial Distribution (多项分布)

考虑把N个小球(N个随机变量),放入K个箱子的概率。若小球在箱子k的概率为θk,其中

k=1∑Kθk=1

N个小球可以看成N个独立的观测变量D={x1,x2,…,XN},则N个小球的分布

p(D∣θ)=m1!…mK!N!k=1∏Kθkmk

其中,m1表示在 箱子1内的小球数,...,mK表示在 箱子K内的小球数,概率即为CNm1CN−m1m2…Cmkmkθ1m1θ2m2…θKmK其中,CNm1CN−m1m2…Cmkmk表示,从N个小球里 选m1个放到箱子1,从N−m1个小球里 选m2个放到箱子2...化简过程,如下:

CNm1CN−m1m2…Cmkmk=m1!(N−m1)!N!m2!(N−m1−m2)!(N−m1)!…

公众号原文 概率分布复习:因果推断的统计学基础

Dirichlet Distribution(狄利克雷分布)

Dirichlet分布,如下:

Dir(θ∣α)=Γ(α1)…Γ(αK)Γ(∑k=1Kαk)k=1∏Kθkαk−1

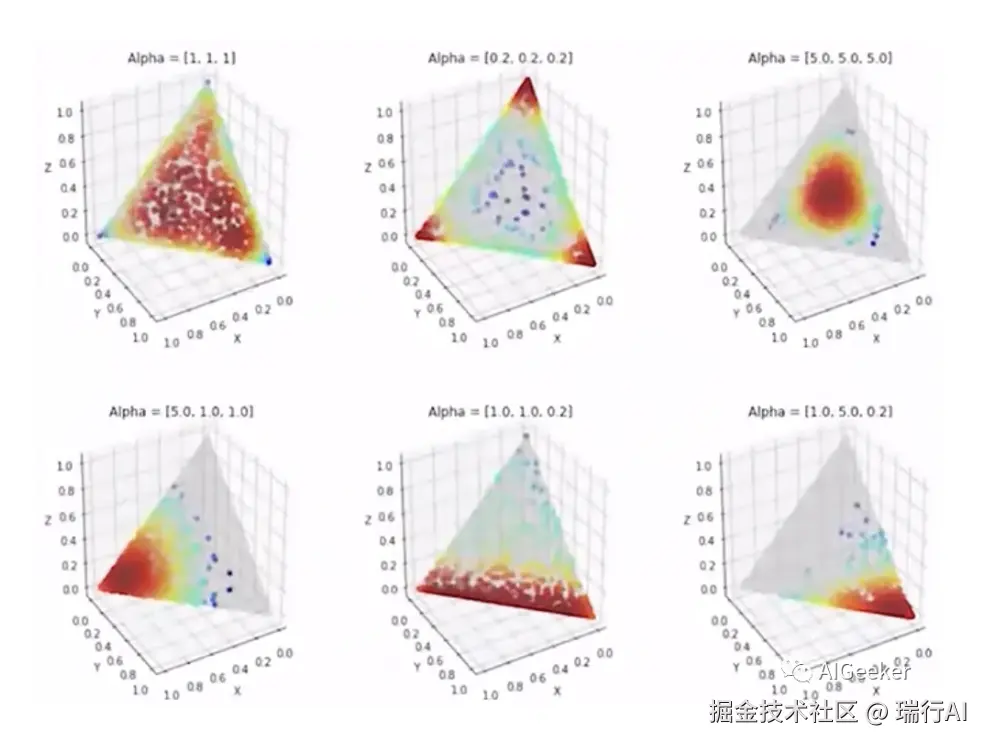

其中,θk是k维随机变量,∑k=1Kθk=1,θk≥0 ; α是k维参数,每一维都是非负的。下图是k=3时,不同α1,α2,α3取值组合,对应的θ分布:

贝叶斯公式

p(θ∣x)=p(x)p(x∣θ)p(θ)

其中,p(θ∣x)是后验分布,p(x∣θ)是似然函数,p(θ)是先验分布。

(1)似然分布:

p(D∣θ)=i=1∏Np(xi∣θ)=i=1∏Nk=1∏Kθkxi,k=k=1∏Kθk∑xi,k=k=1∏Kθkmk

(2)先验分布p(θ)是每个小球被放入每个箱子的概率,p(xi∣θ)服从Categorical Distribution的,θ=(θ1,θ2,…,θK)的每个维度θk表示小球被放入第k个箱子的概率,满足∑k=1Kθk=1,其中θk≥0。

可以假设θ=(θ1,θ2,…,θK)服从Dirichlet Distribution, 也就是

p(θ∣α)=Dirichlet(θ∣α)=C(α)k=1∏Kθkαk−1

根据贝叶斯公式,对单个观察变量有p(θ∣x,α)∝p(x∣θ)p(θ∣α),则对全部观测变量有p(θ∣D,α)∝p(D∣θ)p(θ∣α):似然分布

p(D∣θ)=k=1∏Kθkmk∼Dirichlet(m)

是Dirichlet Distribution;先验分布

p(θ∣α)=C(α)k=1∏Kθkαk−1

根据贝叶斯公式,可得后验分布

p(D∣θ)p(θ∣α)=k=1∏Kθkmk⋅C(α)k=1∏Kθkαk−1∝k=1∏Kθkαk+mk−1

服从Dirichlet Distribution,即

k=1∏Kθkαk+mk−1∼Dirchilet(α+m)

公众号原文 概率分布复习:因果推断的统计学基础

Gamma Distribution(伽马分布)

Gamma函数

Beta Distribution (贝塔分布)

Beta函数

B(a,b)=∫10xa−1(1−x)b−1dx,a>0,b>0

性质:

(1.)B(a,b)=B(b,a)

(2.)B(a,b)=Γ(a+b)Γ(a)Γ(b)

Beta分布

p(x)={B(a,b)1xa−1(1−x)b−1,0,0<x<1其他

关于概率分布的复习基本完了,对相关主题感兴趣的读者欢迎留言交流讨论。更多优质内容请欢迎扫码关注 瑞行AI: