安装完成后,我们可以开始编写网络爬虫代码。

二、使用Requests库发送HTTP请求

使用Requests库发送HTTP请求是网络爬虫的一种常见做法。通过使用Requests库,我们可以发送GET或POST请求,获取网页的HTML内容。下面是一个使用Requests库获取网页内容的示例代码:

import requests

url = 'www.example.com' response = requests.get(url) html_content = response.text

print(html_content)

在上述代码中,我们首先导入了requests库,然后指定了要爬取的网页URL。使用requests.get()函数发送GET请求,并将返回结果保存在response变量中。我们可以使用response.text属性来获取网页的HTML内容。

三、解析网页内容

解析网页内容是网络爬虫的另一个重要工作。BeautifulSoup是Python中常用的HTML解析库,它可以帮助我们轻松地从HTML文档中提取出我们需要的数据。下面是一个使用BeautifulSoup库解析HTML内容的示例代码:

from bs4 import BeautifulSoup

假设html\_content是之前获取到的网页HTML内容

soup = BeautifulSoup(html_content, 'html.parser')

使用soup对象提取我们需要的数据

title = soup.title.text links = soup.find_all('a')

print(title) print(links)

在上述代码中,我们首先导入了BeautifulSoup库,并创建了一个BeautifulSoup对象,用于解析HTML内容。使用soup.title.text可以获取网页的标题,使用soup.find\_all(‘a’)可以获取所有的链接。

四、使用Scrapy库构建爬虫

除了使用Requests和BeautifulSoup库进行网络爬虫操作外,我们还可以使用Scrapy库来更高效地构建和管理爬虫。Scrapy提供了一套强大的工具和框架,用于实现高性能的爬虫。它提供了方便的命令行工具,可以自动生成爬虫模板,并提供了丰富的功能和机制,如自动处理网页链接、持久化存储数据等。

使用Scrapy构建爬虫的过程大致如下:

定义Item:表示要爬取的数据结构;

定义Spider:定义爬取规则和如何解析响应;

定义Pipeline:处理爬取到的数据;

配置Scrapy:指定一些必要的配置项。

五、遵守法律法规和道德准则

在进行网络爬虫操作时,需要遵循相关的法律法规和道德准则,尊重网站的隐私和使用条款,避免对网站造成不必要的压力或损害。以下是一些需要注意的事项:

### 最后

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

#### 👉Python所有方向的学习路线👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

#### 👉Python必备开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

#### 👉Python全套学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

#### 👉实战案例👈

学python就与学数学一样,是不能只看书不做题的,直接看步骤和答案会让人误以为自己全都掌握了,但是碰到生题的时候还是会一筹莫展。

因此在学习python的过程中一定要记得多动手写代码,教程只需要看一两遍即可。

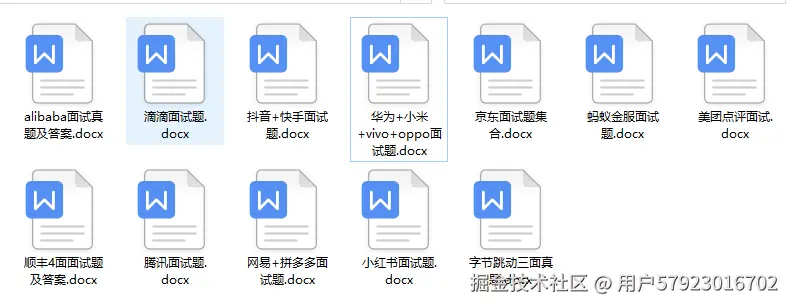

#### 👉大厂面试真题👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

**了解详情:https://docs.qq.com/doc/DSnl3ZGlhT1RDaVhV**