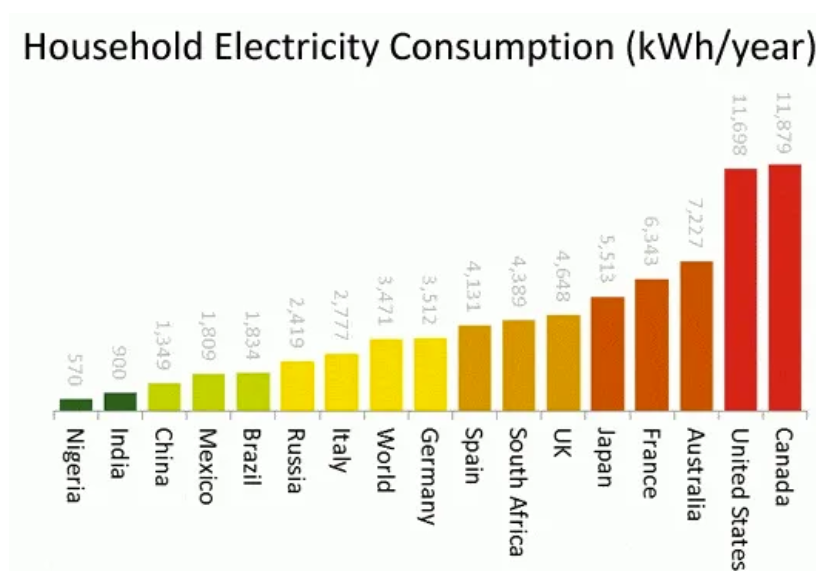

AI耗电高这个大家是公认的,其实暴露出一个更大的问题,那就是美国家庭用电也太狠了吧。

你看下面这个图,美国家庭年用电达到11698度电,

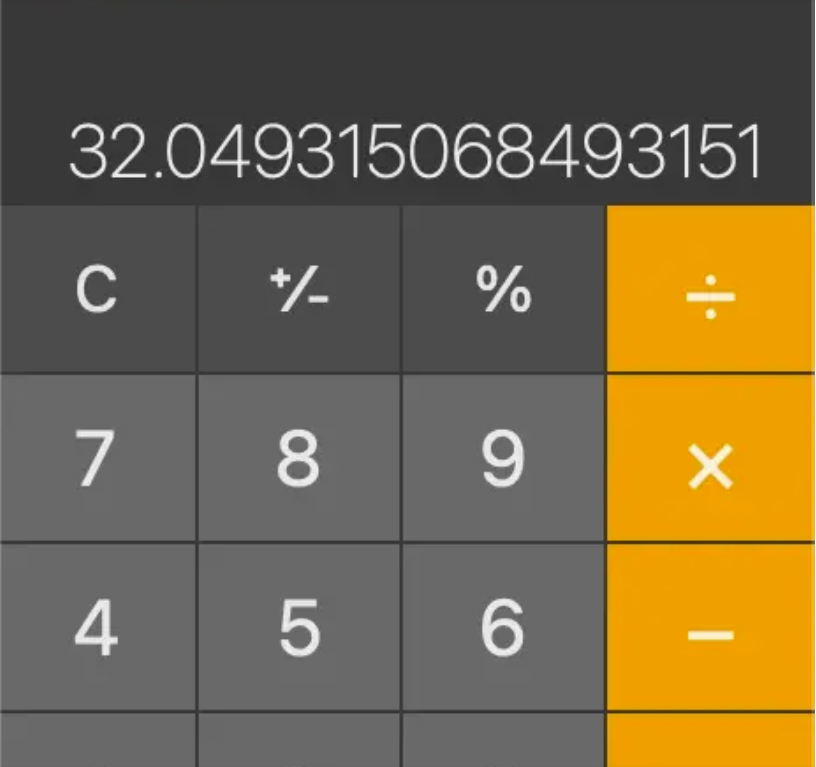

平均一天32度,跟上面的数据差不太多。

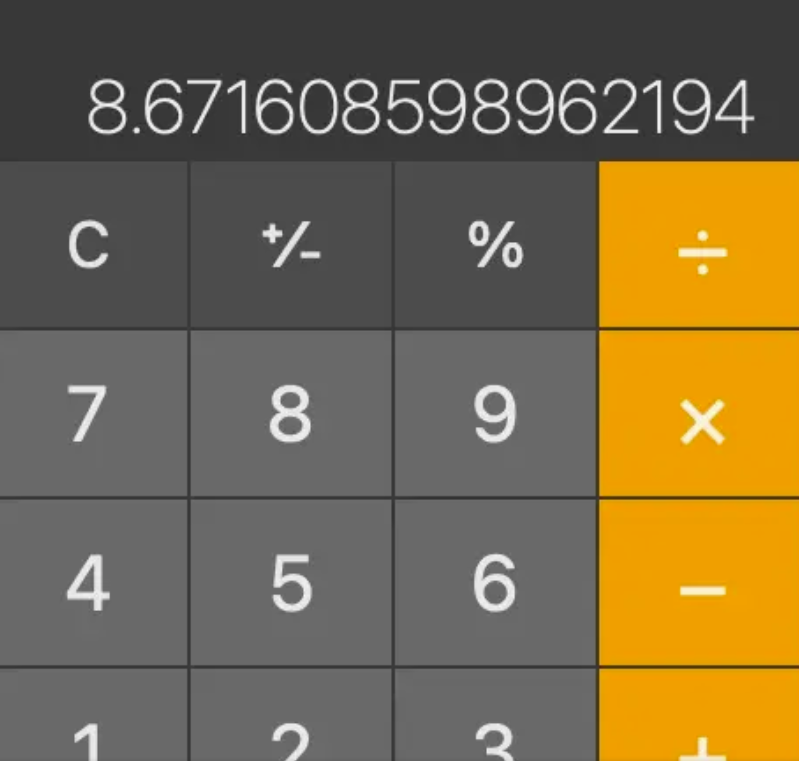

而中国呢,年平均用电1349度,是美国的8.67分之一。

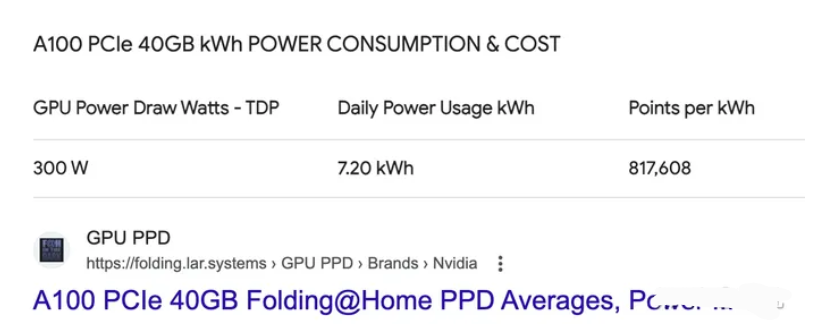

而ChatGPT看起来日平均用电=1.7万个美国家庭,反而看起来不多,因为ChatGPT的运行背后靠的是显卡,而显卡运行起来非常耗电。

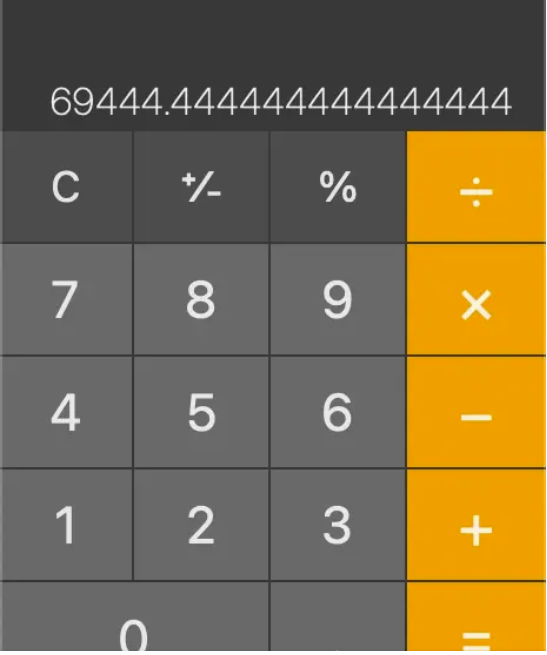

我们就按A100 40GB显存这张卡来算,它每天消耗7.2度电。

那每天50万度电,A100每天不间断的运行,需要69444张显卡。

这夸张吗,其实一点儿也不夸张。

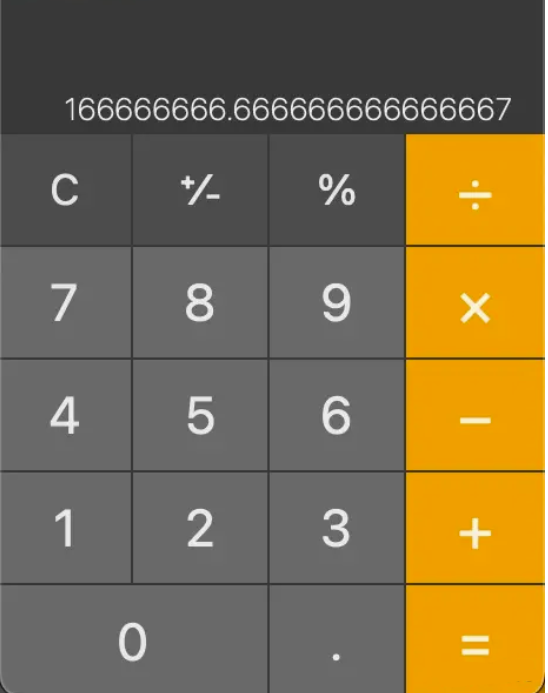

因为早在去年就有人说了,ChatGPT处理一个请求大概需要0.00396度电,现在估计优化了不少,比如ChatGPT3.5和GPT4的用电肯定不一样,就算处理一个请求耗费0.003度电。

那500000/0.003=1.66亿。

跟ChatGPT说的每天处理2亿个请求差不太多。

我只能说这个ChatGPT的耗电量是正常的,不正常的是美国人均的耗电量,真的夸张。只能说GPT在国外真的已经特别常用,如果你还没跟上时代的浪潮用上GPT4.0的话,得赶快补上 我推荐你看一下这篇文章 GPT注册升级教程 带你走进GPT4.0

本文由mdnice多平台发布