💡 这节课会带给你

- 如何选择 GPU 和云服务厂商,追求最高性价比

- 如何部署自己 fine-tune 的模型,向业务提供高可用推理服务

- 如何控制内容安全,做好算法备案,确保合规

开始上课!

硬件选型

当我们为模型训练及推理做硬件选型时,NVIDIA 几乎是唯一选择。

这是一家全球知名的图形处理器(GPU)公司,成立于 1993 年。

因为在 GPU 领域,尤其 AI 领域芯片的垄断性优势,其创始人黄仁勋被坊间称为「黄教主」。

什么是 GPU?

Graphical Processing Units (GPUs)

- 图形处理单元(GPU)是一种功能强大的电子芯片,用于在沉浸式视频游戏、电影和其他视觉媒体中呈现丰富的 2D/3D 图形和动画

- 因其超越 CPU 的并行矩阵运算性能,所以也被广泛应用于人工智能相关的各种系统,包括机器视觉、NLP、语音识别、自动驾驶等

CUDA 核心和 Tensor 核心

CUDA 核心:

- 是 NVIDIA 开发的并行计算平台和编程模型,用于 GPU 上的通用计算,就像是万能工人,可以做很多不同的工作

- 适合游戏和图形渲染、天气预测、电影特效等场景

Tensor 核心:

- 中文叫:张量核心

- 专门设计用于深度学习中的矩阵运算,加速深度学习算法中的关键计算过程

- 适合语音助手、人脸识别等场景

案例 1:视频渲染 当一个电影制片公司决定制作一部具有高度视觉效果的 3D 电影时,他们需要大量的计算能力来渲染每一帧。这里,CUDA 核心非常有用,因为它们能够处理大量的细节,如光线追踪、纹理和阴影。例如,当一束光从一个光源反射到一个物体上,然后反射到摄像机上,CUDA 核心可以用来计算这个光线路径上的所有细节,确保最终的图像看起来真实并且美观。

案例 2:面部识别 安全系统、智能手机和许多应用程序现在都使用面部识别技术。这需要通过深度学习模型来识别人的面部特征。Tensor 核心在这里发挥关键作用,它们可以迅速地处理神经网络中的大量矩阵乘法和加法,确保面部识别既准确又快速。

AI 领域常用 GPU

这个表格依据价格进行排序,价格从低到高。

| 显卡 | 目标市场 | 性能 | 应用场景 | 价格 |

|---|---|---|---|---|

| T4 | 企业/AI 推理 | 适中 | AI 推理, 轻量级训练, 图形渲染 | 7999(14G) |

| 4090 | 消费者 | 非常高 | 通用计算, 图形渲染, 高端游戏, 4K/8K 视频编辑 | 14599(24G) |

| A10 | 企业/图形 | 适中 | 图形渲染, 轻量级计算 | 18999(24G) |

| A6000 | 企业/图形 | 适中 | 图形渲染, 轻量级计算 | 32999(48G) |

| V100 | 数据中心/AI | 高 | 深度学习训练/推理, 高性能计算 | 42999(32G) |

| A100 | 数据中心/AI | 高 | 深度学习训练/推理, 高性能计算 | 69999(40G) |

| A800 | 数据中心/AI | 中等 | 深度学习推理, 高性能计算, 大数据分析 | 110000 |

| H100 | 数据中心/AI | 高 | 深度学习训练/推理, 高性能计算, 大数据分析 | 242000 |

- 有些在京东就能买到:item.jd.com/10065826100…

- 美国商务部限制 GPU 对华出口的算力不超过 4800 TOPS 和带宽不超过 600 GB/s,导致最强的 H100 和 A100 禁售。黄教主随后推出针对中国市场的 A800 和 H800。

参考:

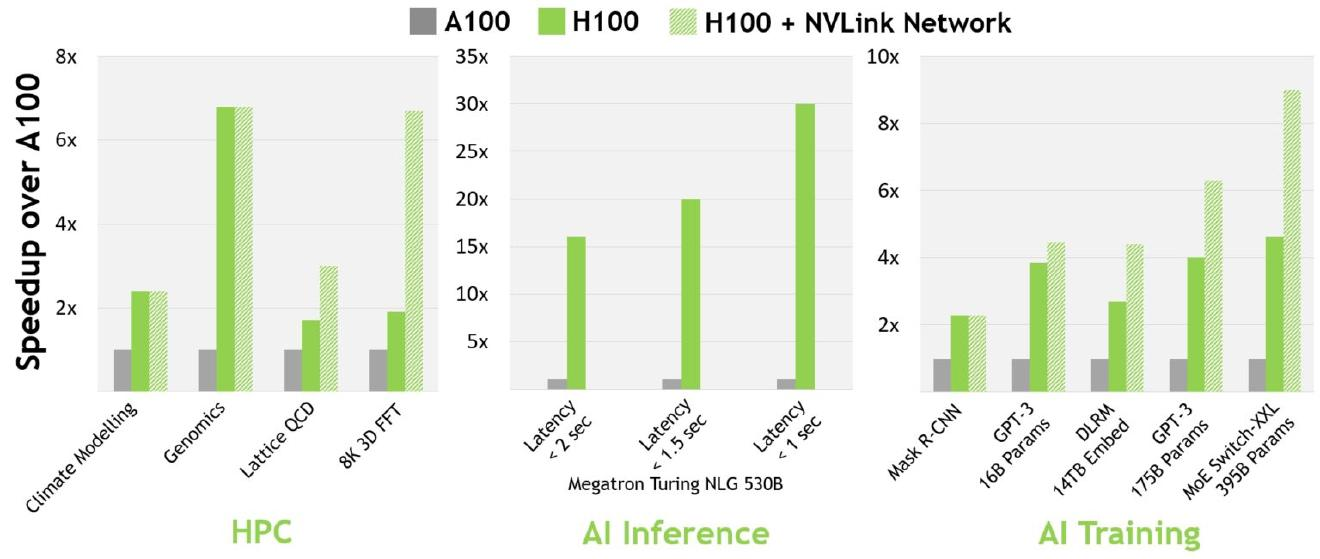

H100 与 A100:H100 比 A100 快多少?

16-bit 推理快约 3.5 倍,16-bit 训练快约 2.3 倍。

参考资料:timdettmers.com/2023/01/30/…

物理机 vs. 云服务

- 如果经常做微调实验,有自己的物理机会方便很多很多

- 提供推理服务,首选云服务

- 如果有自建机房或 IDC,请随意

云服务厂商对比

国内主流

- 阿里云:www.aliyun.com/product/ecs… (可申请免费试用)

- 腾讯云:cloud.tencent.com/act/pro/gpu…

- 火山引擎:www.volcengine.com/product/gpu

国外主流

- AWS:aws.amazon.com

- Vultr:www.vultr.com

- TPU:cloud.google.com/tpu

TPU 是 Google 专门用于加速机器学习的硬件。它特别适合大规模深度学习任务,通过高效的架构在性能和能源消耗上表现出色。

它的优点和应用场景:

-

高性能和能效: TPU 可以更快地完成任务,同时消耗较少的能源,降低成本。

-

大规模训练: TPU 适用于大规模深度学习训练,能够高效地处理大量数据。

-

实时推理: 适合需要快速响应的任务,如实时图像识别和文本分析。

-

云端使用: Google Cloud 提供 TPU 服务,允许用户根据需求使用,无需购买硬件。

适用于图像处理、自然语言处理、推荐系统等多个领域。

在国外,科研机构、大公司和初创企业普遍使用 TPU。

下面是对两款 NVIDIA GPU 在他主流厂商的价格进行对比:

- A100:在云服务中,A100 是顶级的企业级 GPU,适用于高性能计算需求。

- T4:相比之下,T4 更为经济,适合日常模型微调和推理任务。

NVIDIA A100:

| 云服务提供商 | GPU 型号 | CPU 核心数 | 内存(GiB) | 价格(元/小时) |

|---|---|---|---|---|

| 火山引擎 | A100 | 14 核 | 245 | 40.39 |

| 阿里云 | A100 | 16 vCPU | 125 | 34.742 |

| 腾讯云 | A100 | 16 核 | 96 | 28.64 |

NVIDIA T4:

| 云服务提供商 | CPU 核心数 | 内存(GiB) | GPU 型号 | 价格(元/小时) |

|---|---|---|---|---|

| 阿里云 | 4 vCPU | 15 | T4 | 11.63 |

| 火山引擎 | 4 核 | 16 | T4 | 11.28 |

| 腾讯云 | 8 核 | 32 | T4 | 8.68 |

算力平台

主要用于学习和训练,不适合提供服务。

- Colab:谷歌出品,升级服务仅需 9 美金。colab.google.com

- Kaggle:免费,每周 30 小时 T4,P100 可用。www.kaggle.com

- AutoDL:价格亲民,支持 Jupyter Notebook 及 ssh,国内首选。www.autodl.com

建议:若需高速下载,尤其依赖于 GitHub 或 Docker 官方镜像,建议选择国外服务器。

根据场景选择GPU

以下是我们为您提供的,基于显卡 4090 上的 chatglm 和 chatglm2 模型的 Fine tuning 实验数据概览:

| 模型 | 数据条数 | 时长 | 技术 |

|---|---|---|---|

| chatglm | 9999 | 1:42:46 | pt2 |

| chatglm | 39333 | 6:45:21 | pt2 |

| chatglm | 9999 | 1:31:05 | Lora |

| chatglm | 39333 | 5:40:16 | Lora |

| chatglm2 | 9999 | 1:50:27 | pt2 |

| chatglm2 | 39333 | 7:26:25 | pt2 |

| chatglm2 | 9999 | 1:29:08 | Lora |

| chatglm2 | 39333 | 5:45:08 | Lora |

下面是 llm-utils 上一些选型的建议

- Falcon 是目前为止huggingface上排行榜第一的模型

根据不同的使用情境,以下是使用的建议GPU:

| 用例 | 显卡要求 | 推荐显卡 |

|---|---|---|

| Running Falcon-40B | 运行 Falcon-40B 所需的显卡应该有 85GB 到 100GB 或更多的显存 | See Falcon-40B table |

| Running MPT-30B | 当运行 MPT-30B 时,显卡应该具有80GB的显存 | See MPT-30B table |

| Training LLaMA (65B) | 对于训练 LLaMA (65B),使用 8000 台 Nvidia A100 显卡。 | Very large H100 cluster |

| Training Falcon (40B) | 训练 Falcon (40B) 需要 384 台具有 40GB 显存的 A100 显卡。 | Large H100 cluster |

| Fine tuning an LLM (large scale) | 大规模微调 LLM 需要 64 台 40GB 显存的 A100 显卡 | H100 cluster |

| Fine tuning an LLM (small scale) | 小规模微调 LLM 则需要 4 台 80GB 显存的 A100 显卡。 | Multi-H100 instance |

- 对于本地个人研发项目,GeForce RTX 4090 等消费级 GPU 足以满足中等规模的需求。

- 对于公司的大规模数据和复杂模型,推荐使用如 NVIDIA A100 的高性能 GPU。

- 数据规模小时,可考虑预算内的 A10 或 T4 型号。

- 如果追求性价比,可以选择把 4090 显卡搭建服务器使用,也可以选择市面的第三方服务,比如:AutoDL 的 4090 服务

参考资料:

后记

📢博客主页:manor.blog.csdn.net

📢欢迎点赞 👍 收藏 ⭐留言 📝 如有错误敬请指正!

📢本文由 Maynor 原创,首发于 CSDN博客🙉

📢不能老盯着手机屏幕,要不时地抬起头,看看老板的位置⭐

📢专栏持续更新,欢迎订阅:blog.csdn.net/xianyu120/c…

本文由mdnice多平台发布