一、介绍

1.一般形式

指数族分布有:高斯分布、伯努利分布、二项分布、泊松分布、beta分布、Dirichlet分布、gamma分布等。

指数族分布的一般形式:

P(x∣η)=h(x)exp{ηTϕ(x)−A(η)}

其中:

- η:参数向量;

- ϕ(x):充分统计量,Sufficient statistic;

- A(η):log partition function(log配分函数)

- h(x):不很重要,通常取1。

2.配分函数

P(x∣θ)=z1P^(x∣θ)

通常如果我们得到一个可以表达分布的函数 P^(x∣θ) 但是其积分不为 1 ,需要除以一个归一化 因子 z 来将其归一,这个归一化因子 z 就是配分函数, z 取值为 P^(x∣θ) 的积分:

∫P(x∣θ)dx=∫z1P^(x∣θ)dx⇒1=z1∫P^(x∣θ)dx⇒z=∫P^(x∣θ)dx

解释一下为什么 A(η) 叫log配分函数:

P(x∣η)=P(x∣η)=h(x)exp{ηTϕ(x)}exp{−A(η)}=exp{A(η)}1P^(x∣θ)h(x)exp{ηTϕ(x)}

因此 exp{A(η)} 就是配分函数, A(η) 就是log配分函数。

3.指数族分布的特点、模型和应用

ϕ(x)是充分统计量。

什么是充分统计量?举例来说,对于从一些从高斯分布中抽取出来的样本x1,x2,⋯,xN,以下统计量就是充分统计量:

ϕ(x)=(∑i=1Nxi∑i=1Nxi2)

因为通过上述统计量可以计算样本的均值和方差进而得到其明确的分布。

有了充分统计量就可以将样本丢掉,从而节省了空间,对online learning有重要意义。

P(z∣x)=∫zP(x∣z)P(z)dzP(x∣z)P(z)

在上面的贝叶斯公式中由于分母 ∫zP(x∣z)P(z)dz 积分难或者 P(z∣x) 的形式太复杂,因 此直接求 P(z∣x) 是很困难的,因此求 EP(z∣x)[f(z)] 也是很困难的,所以人们想了很多办法 比如近似推断 (变分推断、MCMC等),这些方法的提出都是因为上述积分难的问题。

共轭的概念是指在给定一个特殊的似然 (P(x∣z)) 的情况下,后验 (P(z∣x)) 与先验 ( P(z)) 会有一个形式相同的分布,这也就解决了上述积分困难的问题,避免了求分母上的积分项常数。

举个例子:

Beta P(z∣x)∝二项式分布 Beta P(x∣z)P(z)

给出先验 P(z) 的一些方法包括:

①共轭 → 计算上的方便;

②最大熵 → 无信息先验;

③Jerrif。

最大熵原理给出了一种定义先验的方式,可以使得参数更加地随机。

广义线性模型中出现的一些概念:

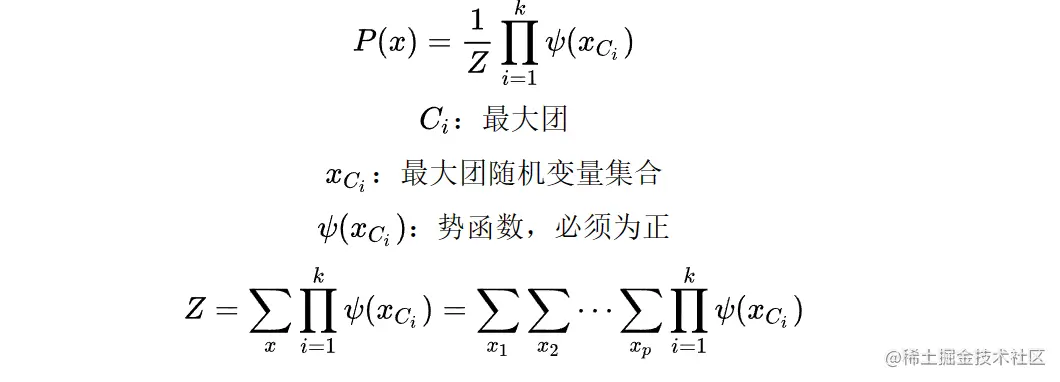

无向图中的RBM(限制玻尔兹曼机)应用到了指数族分布。

二、高斯分布的指数族分布形式

以一维高斯分布为例,将高斯分布整理成指数族分布的形式:

P(x∣θ)=2πσ1exp{−2σ2(x−μ)2}θ=(u,σ2)=2πσ21exp{−2σ21(x2−2μx+μ2)}=exp{log(2πσ2)−21}exp{−2σ21(x2−2μx)−2σ2μ2}=exp{log(2πσ2)−21}exp{−2σ21(−2μ1)(xx2)−2σ2μ2}=exp⎩⎨⎧ηT(σ2μ−2σ21)ϕ(x)(xx2)−A(η)(2σ2μ2+21log2πσ2)⎭⎬⎫

然后即可获得η和θ的关系:

η=(η1η2)=(σ2μ−2σ21){η1=σ2μη2=−2σ21⇒{μ=−2η2η1σ2=−2η21

将η代入A(η)可以得到如下结果:

A(η)=−4η2η12+21log(2π⋅−2η21)=4η2η12+21log(−2η2π)

由此就将高斯分布整理成了指数族分布的形式:

P(x∣θ)=h(x)exp{ηTϕ(x)−A(η)}h(x)=1η=(η1η2)=(σ2μ−2σ21)ϕ(x)=(xx2)A(η)=4η2η12+21log(−2η2π)

三、对数配分函数与充分统计量

通过对指数族分布的通用形式进行整理,可以得出对数配分函数与充分统计量

的特定关系:

P(x∣η)=h(x)exp{ηTϕ(x)−A(η)}=exp{A(η)}1h(x)exp{ηTϕ(x)}由前面介绍的内容可知配分函数exp{A(η)}=∫h(x)exp{ηTϕ(x)}dx⇒∂η∂exp{A(η)}=∂η∂(∫h(x)exp{ηTϕ(x)}dx)⇒exp{A(η)}A′(η)=∫h(x)exp{ηTϕ(x)}ϕ(x)dx⇒A′(η)=exp{A(η)}∫h(x)exp{ηTϕ(x)}ϕ(x)dx=∫P(x∣η)h(x)exp{ηTϕ(x)−A(η)}ϕ(x)dx=∫P(x∣η)ϕ(x)dx=EP(x∣η)[ϕ(x)]

类似地,继续对A(η)求二阶导数:

A′′(η)=∂η∂(∫h(x)exp{ηTϕ(x)−A(η)}ϕ(x)dx)=∫P(x∣η)h(x)exp{ηTϕ(x)−A(η)}(ϕ(x)−A′(η))ϕ(x)dx=∫P(x∣η)(ϕ(x)−EP(x∣η)[ϕ(x)])ϕ(x)dx=∫P(x∣η)ϕ2(x)−EP(x∣η)[ϕ(x)]P(x∣η)ϕ(x)dx=∫P(x∣η)ϕ2(x)dx−EP(x∣η)[ϕ(x)]∫P(x∣η)ϕ(x)dx=EP(x∣η)[ϕ2(x)]−EP(x∣η)2[ϕ(x)]=VarP(x∣η)[ϕ(x)]由于方差≥0,则A′′(η)≥0,因此A(η)是凸函数。

四、极大似然估计与充分统计量

上述推导都是在无样本条件下进行的,在有样本的情况下我们也可以通过极大似然估计法来获得一些特定的关系,假设有如下数据:

D={x1,x2,⋯,xN}

然后使用极大似然估计法求解η:

ηMLE=ηargmaxlogP(D∣η)=ηargmaxlogi=1∏NP(xi∣η)=ηargmaxi=1∑NlogP(xi∣η)=ηargmaxi=1∑Nlog[h(xi)exp{ηTϕ(xi)−A(η)}]=ηargmaxi=1∑N[与η无关logh(xi)+ηTϕ(xi)−A(η)]=ηargmaxi=1∑N[ηTϕ(xi)−A(η)]∂η∂∑i=1N[ηTϕ(xi)−A(η)]=i=1∑N∂η∂[ηTϕ(xi)−A(η)]=i=1∑N[ϕ(xi)−A′(η)]=i=1∑Nϕ(xi)−NA′(η)=0⇒A′(ηMLE)=N1i=1∑Nϕ(xi)

ηMLE 就可以通过求 A′(η) 的反函数求出来。这说明 ϕ(xi) 是充分统计量,因为只需要记录 N1∑i=1Nϕ(xi) 这一个值就可以求出 η ,进而通过 η 求出所有的参数。

五、最大熵

1.概述

首先定义信息量和熵:

信息量:−logp(x)熵:H[P]=E[−logp(x)]=∫−p(x)logp(x)dx(连续)H[P]=E[−logp(x)]=−i=1∑Np(x)logp(x)(离散)

2.离散情况下的最大熵

假设x是离散的:

| x | 1 | 2 | ⋯ | k |

|---|

| P | p1 | p2 | ⋯ | pk |

通过求解以下约束优化问题可以求得使得离散情况下熵最大的分布:

{maxH[P]=max−∑i=1kpilogpis.t.∑i=1kpi=1⇔{min∑i=1kpilogpis.t.∑i=1kpi=1

使用拉格朗日乘子法进行求解:

L(P,λ)=i=1∑kpilogpi+λ(1−i=1∑kpi)∂pi∂L=logpi+pipi1−λ=logpi+1−λ=0⇒p^i=exp(λ−1)也就是说每个p^i都等于exp(λ−1),由i=1∑kpi=1可以得到:p^1=p^2=⋯=p^k=k1∴P(x)是均匀分布。

离散情况下均匀分布会使得熵最大。也就是说在没有任何已知条件约束的情况下均匀分布的熵最大。

3.最大熵原理

上一部分得出在无任何已知的情况下的最大熵对应的分布为均匀分布,而在满足一定的约束(已知事实)的条件下就要使用最大熵原理来进行求解。

首先要说明已知事实指的就是我们已经有了一部分数据:

Data={x1,x2,⋯,xN}

然后根据数据我们可以定义其经验分布(empirical distribution):

p^(x=n)=p^(n)=Ncount(n)

通过该分布可以获得数据的一些属性,比如 Ep^[x],Varp^[x],⋯ 。另外我们假设 f(x) 是任意关于 x 的函数向量,满足:

Ep^[f(x)]=Δ 其中 f(x)=⎝⎛f1(x)f2(x)⋮fQ(x)⎠⎞Δ=⎝⎛Δ1Δ2⋮ΔQ⎠⎞

也就是说现在需要满足上述约束条件,于是在该约束下求解最大熵的分布就转换成了一个约束优化问题:

⎩⎨⎧min∑xp(x)logp(x) s.t. ∑xp(x)=1Ep[f(x)]=Ep^[f(x)]=Δ

然后就可以使用拉格朗日乘子法进行求解,首先定义拉格朗日函数:

L(P,λ0,λ)=x∑p(x)logp(x)+λ0(1−x∑p(x))+λT(Δ−Ep[f(x)])

接着对 p(x) 进行求导,这里指的是对每个 p(xi) 进行求导:

∂p(x)∂L=x∑(logp(x)+p(x)p(x)1−λ0−λT∂p(x)∂∑xp(x)f(x))=x∑(logp(x)+1−λ0−λTf(x))=0⇒logp(x)=λTf(x)+λ0−1⇒p(x)=exp{λTf(x)−(1−λ0)}

显示 p(x) 是一个指数族分布,因此对于连续变量 x ,其在满足既定事实的条件下对应的最大熵的分布是一个指数族分布。

六、总结

更多其他概率分布不再进行一一推导,总结一下服从指数族分布的建模场景:

1.伯努利分布:对0、1问题建模

2.多项式分布:对有K个离散结果事件建模

3.泊松分布:对计数过程进行建模。如网站访问量,商店顾客数量等。

4.指数分布与伽马分布:对有间隔的正数进行建模

5.贝塔分布:对小数建模

6.Dirichlet分布:对概率分布建模

7.Wishart分布:协方差矩阵的分布

8.高斯分布:对连续问题建模

“开启掘金成长之旅!这是我参与「掘金日新计划 · 2 月更文挑战」的第 5 天,点击查看活动详情”