3.1-基本形式

3.1.1-基本形式

f(x)=w1x1+w2x2+⋯+wdxd+b(3.1)

其中 x 为一共 d 个属性的示例,xi 为 x 的第 i 个属性。f(x) 为预测函数。w可以代表各属性在预测中的重要性

3.1.1-向量形式

f(x)=wTx+b(3.2)

3.2-线性回归

给定数据集 D={(x1,y1),(x2,y2),…(xd,yd)},其中 xi=(xi1;xi2;…;xid),y∈R

线性回归试图习得一个预测函数 f(xi)=wxi+b

使得

f(xi)≃yi(3.3)

3.2.1-性能度量

至于如何确定 w 和 b,

2.3 节介绍过,均方误差(2.2) 是回归任务中最常用的性能度量,因此我们可试图让均方误差最小化

(w∗,b∗)=(w,b)argmini=1∑m(f(xi)−yi)2=(w,b)argmini=1∑m(yi−wxi−b)2.(3.4)

最后用最小二乘法解得

w=∑i=1mxi2−m1(∑i=1mxi)2∑i=1myi(xi−xˉ)(3.7)

b=m1i=1∑m(yi−wxi)(3.8)

3.2.2-多元线性回归

更一般的情形是如本节开头的数据集 D , 样本由 d 个属性描述.此时我们

试图学得

f(xi)=wTxi+b, 使得 f(xi)≃yi

这称为“多元线性回归”

把数据集 D 表示为一个 m×(d+1) 大小的矩阵 X

X=⎝⎛x11x21⋮xm1x12x22⋮xm2……⋱…x1dx2d⋮xmd11⋮1⎠⎞=⎝⎛x1Tx2T⋮xmT11⋮1⎠⎞

Y 写成:y=(y1;y2;…;ym)

那么:

w^∗=argmin(y−Xw^)T(y−Xw^)(3.9)

求导得:

∂w^∂Ew^=2XT(Xw^−y)(3.10)

若X为正定矩阵或者满秩矩阵,可以直接解得

w^∗=(XTX)−1XTY

反之能够解出很多个 w^

这个时候需要正则化处理

3.2.3-广义线性模型

在这里,我们不会逼近 y,反而逼近y的某个函数,如 lny 或者 y2

一般表示成:

y=g−1(wTx+b)

3.3-对数几率回归

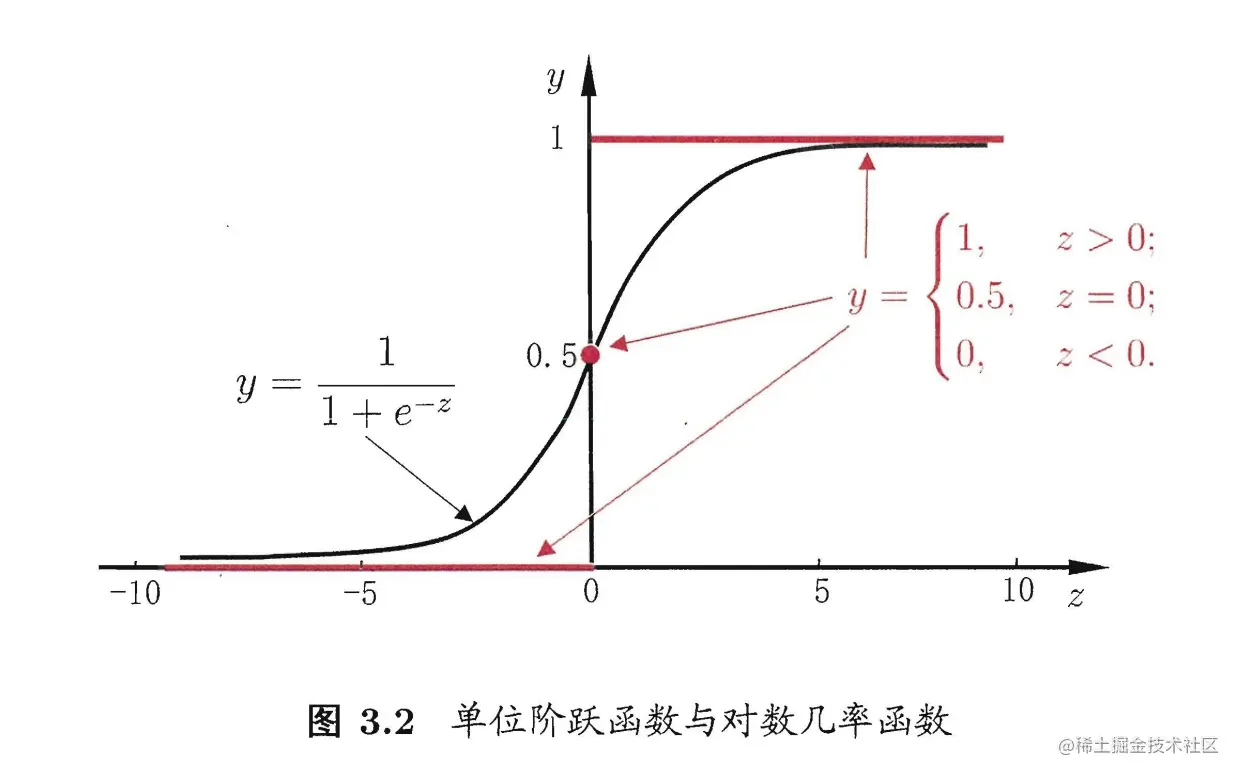

假设现有一模型(其实叫单位阶跃函数)

y=⎩⎨⎧0,0.5,1,z<0z=0z>0(3.16)

这个函数既不连续也不可微1,那么有没有一个连续可微的替代呢?

有,sigmod函数

其含义是越靠近中心点的概率越高,越远离中心点的概率越低,但是函数预测的确定性越高。

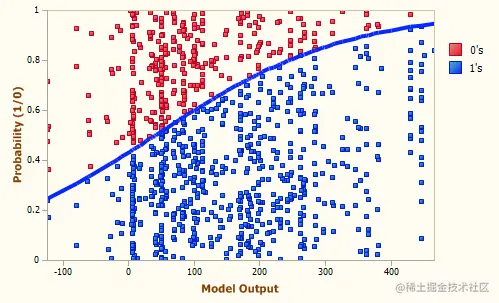

因此, “对数几率回归”(Logistic Regression)做的事情是对分类的可能性建模, 而不是去预测样本的y值2

以下面这张图为例,x 越大,那么预测为蓝色的概率越高,反之越低

3.4-线性判别分析

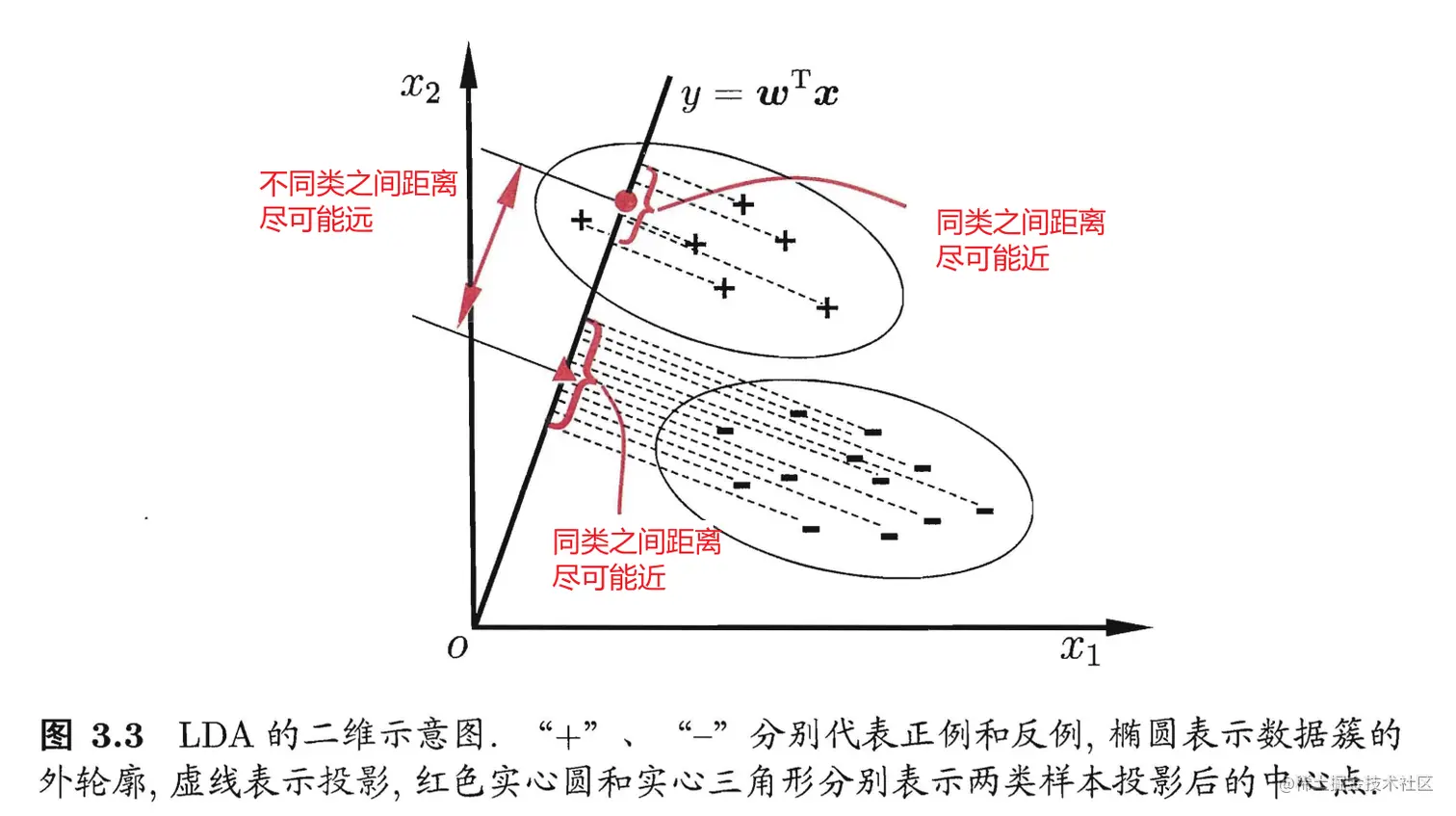

线性判别分析:Linear Discriminant nalys ,简称 LDA

其思想是:最大化类间均值,最小化类内方差。意思就是将数据投影在低维度上,并且投影后同种类别数据的投影点尽可能的接近,不同类别数据的投影点的中心点尽可能的远3。

3.5-多分类学习

对于多个分类的问题,可以将多分类问题转化为多个二分类问题

MvM的正反类构造有特殊要求

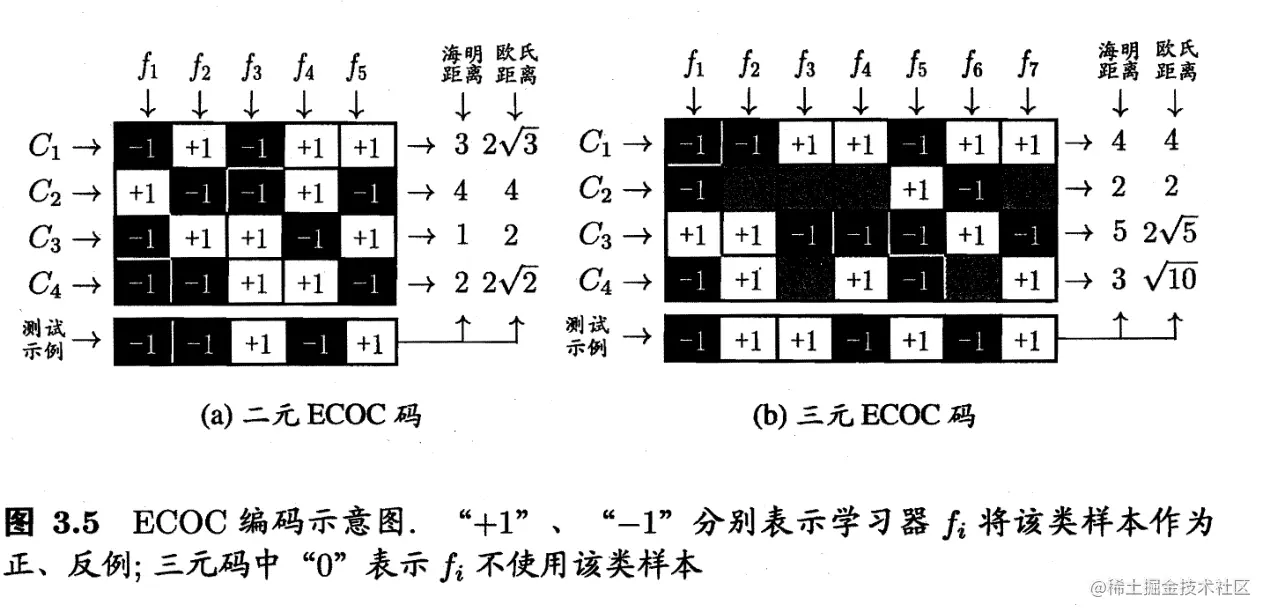

3.5.1-ECOC

纠错输出码:Error Correcting Output Codes

- 编码:对 N 个类别做 M 次划分, 每次划分将一部分类别划为正类,一部分划为反类,从而形成一个二分类训练集;这样一共产生 M 个训练集,可训练出 M 个分类器.

- 解码:M 个分类器分别对测试样本进行预测,这些预测标记组成一个编码.将这个预测编码与每个类别各自的编码进行比较,返回其中距离最小的类别作为最终预测结果.

3.6-类别不平衡问题

假设正例有999个,但是反例只有一个,那么只需要将所有的例子都输出为正例行。但是我们其实更加看重那一个反例,而非另外的999个正例。

可以给回归的函数设置权重,原先不是 1−yy>1 就输出为正例吗?

现在时代变了,需要 1−yy>m−m+ 才能输出为正例,这里的 m+− 代表正例个和反例个数。这称为阔值移动

碎碎念

-

对数几率回归 —— Logistic Regression - 知乎 (zhihu.com)

-

#8 究竟什么是"逻辑回归", "对数几率回归"

-

线性判别分析LDA原理及推导过程(非常详细) - 知乎 (zhihu.com)