| criterion | 字符型,可不填,默认基尼系数('gini") 用来衡量分枝质量的指标.即衡量不纯度的指标,输入'gini'用基尼系数,或输入’entropy' 使用信息增益(Information Gain) |

| splitter | 字符型,可不填,默认最佳分枝('best') 确定每个节点的分枝策略 输入"best"使用最佳分枝,或输入"random"使用最佳随机分枝 |

| max_depth | 整数或None,可不填,默认None 树的最大深度。如果是None,树会持续生长直到所有叶子节点的不纯度为0,或者直到每个叶子节点所含的样本量都小于参数min_ samples_ split中输入的数字 |

| min_samples_split | 整数或浮点数,可不填,默认=2 一个中间节点要分枝所需要的最小样本量。如果一个节点包含的样本量小于 min_ samples_ split中填写的数字,这个节点的分枝就不会发生,也就是说,这个节点一定会成为一个叶子节点 1) 如果输入整数,则认为输入的数字是分枝所需的最小样本量 2) 如果输入浮点数则认为输入的浮点数是比例.输入的浮点数 * 输入模型的数据集的样本量(n_samples)是分枝所需的最小样本量 |

| min_sample_leaf | 整数或浮点数,可不填,默认=1 一个叶节点要存在所需要的最小样本量。一个节点在分枝后的每了子节点中,必须要包含至 少min_sample_leaf个训练样本,否则分枝就不会发生.这个参数可能会有着使模型更平滑的效果,尤其是在回归中 1) 如果输入整数,则认为输入的数字是叶节点存在所需要的最小的样本量 2) 如果输入浮点数,则认为输入的浮点数是比例 输入的浮点数 * 输入模型的数据集的样本量(n_samples)是叶节点存在所需的最小样本量 |

| min_weight_fraction_leaf | 浮点数,可不填,默认0 一个叶节点要存在所需要的权重占输入模型的数据集的总权重的比例。 总权重由fit接口中的sample_weight参数确定当sample_weight是None时,默认到有样本的权重相同 |

| max_feature | 整数,浮点数,字符型或None,可不填,默认None 在做最佳分枝的时候,考虑的特征个数 1) 输入整数,则每一次分枝都考虑max_features个持征 2) 输入浮点数,则认为输入的浮点数是比例,每次分枝考虑的特征的数目是max_features 输入模型的数据集的特征个数(n_features) 3)输入auto",采用n_features的平方根作为分枝时考虑的特征数目 4)输入‘'sqrt,采用n_features平方根作为分枝时考虑的特征数目 5)输入‘log2',采用log2 (n_features)作为分枝时考虑的特征数目 6)输入“None,n_features就是分枝时考虑的特征数目 注意:如果在限制的max_features中,决策树无法找到节点样本上至少一个有效的分枝,那对分枝的搜索不会停止决策树将会检查比限制的max_features数目更多的特征 |

| random_state | 整数,sklearn中设定好的RandomState实例,或None,可不填,默认None 1) 输入整数,random state是由随机数生成器生成的随机数种子 2) 输入RandomState实例则random_ state是一个随机数生成器 3) 输入None,随机数生成器会是np.random模块中的一个Randomstate实例 |

| max_leaf_nodes | 整数或None,可不填默认None 最大叶节点数量。在最佳分枝方式下以max_leaf_nodes为限制来生长树。如果是None, 则没有叶节点数量的限制。 |

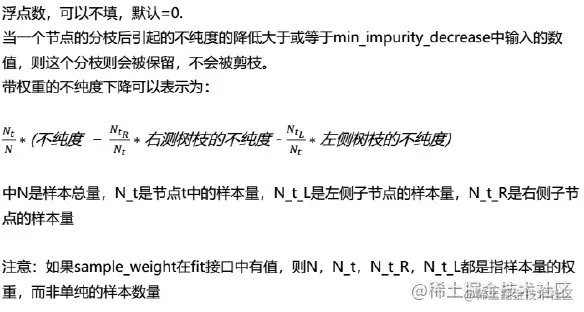

| min_impurity_decrease |  |

| min_impurity_split | 浮点数 防止树生长的阈值之一,如果一个节点的不纯度高于min_impurity_split,这个节点就会被分枝否则的话这个节点就只能是叶子节点. |

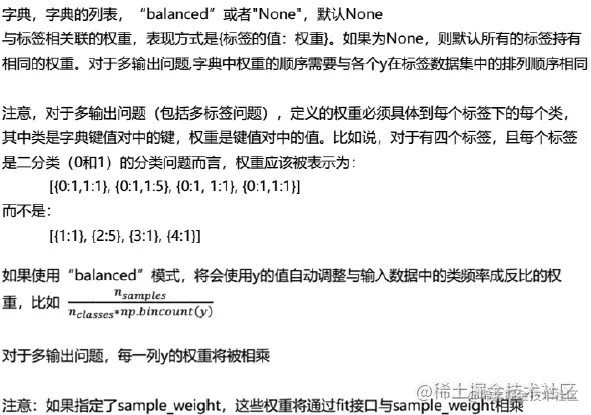

| class_weight |  |

| warm_start | 布尔值,可不填,默认是False 设置为True时候,使用上一次实例化中得到的树模型来fit并以此向整体添加更多的估算器,否则,重新建立一棵树来训练。 |

| verbose | 整数,可不填,默认是0 在拟合和预测时控制树的复杂度 |

| n_jobs | 整数或None,可不填,默认是None 训练(fit)和预测(predict)并行运行的worker数,None表示1除非None是标注在参数joblib.parallel_backend context中,-1表示使用整个处理器来运行 |

| boostrap | 布尔值,可不填,默认是True 在建树过程中,是否使用可放回样本抽样的方式。 |

| oob_score | 布尔值,默认是False 在建树过程中,是否使用袋外样本来预测模型的泛化精确性。 |