关于周志华老师的《机器学习》这本书的学习笔记

记录学习过程

本博客记录Chapter12

1 基础知识

计算学习理论(computational learning theory):关于通过“计算”来进行“学习”的理论,即关于机器学习的理论基础,其目的是分析学习任务的困难本质,为学习算法体统理论保证,并根据结果指导算法设计。

对于二分类问题,给定样本集{(x1,y1),(x2,y2),⋯,(xm,ym)},yi∈{−1,+1}。假设所有样本服从一个隐含未知的分布D,所有样本均独立同分布(independent and identically distributed)。

令h为样本到{−1,+1}上的一个映射,其泛化误差为

E(h;D)=Px∼D(h(x)=y)

h在D上的经验误差为

E^(h;D)=m1i=1∑mⅡ(h(xi)=yi)

由于D是D的独立同分布采样,因此h的经验误差的期望等于其泛化误差。 在上下文明确时,我们将E(h;D)和E^(h;D)分别简记为E(h)和E^(h)。 令ϵ为E(h)的上限,即E(h)≤ϵ;我们通常用ϵ表示预先设定的学得模型所应满足的误差要求,亦称“误差参数”。

我们将研究经验误差和泛化误差之间的逼近程度;若h在数据集上的经验误差为0,则称h与D一致,否则称其不一致。对于任意两个映射h1,h2∈X→Y,用不合(disagreement)来度量他们之间的差别:

d(h1,h2)=Px∼D(h1(x)=h2(x))

我们将会用到几个常见的不等式:

-

Jensen不等式:对任意凸函数,有

f(E(X))=E(f(x))

-

Hoeffding不等式:若x1,x2,…,xm为m个独立随机变量,且满足0≤xi≤1,对任意ϵ>0,有

P(m1i=1∑mxi−m1i=1∑mE(xi)≥ϵ)≤e−2mϵ2P(∣m1i=1∑mxi−m1i=1∑mE(xi)∣≥ϵ)≤2e−2mϵ2

-

McDiarmid不等式:若x1,x2,…,xm为m个独立随机变量,且满足1≤i≤m,函数f满足:

x1,⋯,xm, xi′sup∣f(x1,⋯,xm)−f(x1,⋯,xi−1,xi′,xi+1,⋯,xm)∣≤ci,

则对任意ϵ>0,有

P(f(x1,⋯,xm)−E(f(x1,⋯,xm))≥ϵ)≤exp(∑ici2−2ϵ2)P(∣f(x1,⋯,xm)−E(f(x1,⋯,xm))∣≥ϵ)≤2 exp(∑ici2−2ϵ2)

2 PAC学习

概率近似正确理论(Probably Approximately Correct,PAC):

-

首先介绍两个概念:

- C:概念类。表示从样本空间到标记空间的映射,对任意样例,都能使得c(x)=y。

- H:假设类。学习算法会把认为可能的目标概念集中起来构成H。

- 若c∈H,则说明假设能将所有示例按真实标记一致的方式完全分开,称为该问题对学习算法而言是”可分的“;否则,称为”不可分的“

-

对于训练集,我们希望学习算法学习到的模型所对应的假设h尽可能接近目标概念c。我们是希望以比较大的把握学得比较好的模型,也就是说,以较大的概率学得误差满足预设上限的模型,这就是"概率近似正确"的含义。形式化地说,令δ表示置信度,可定义:

-

PAC辨识:对0≤ϵ,δ<1,所有的c∈C和分布D,若存在学习算法,其输出假设h∈H满足:

P(E(h)≤ϵ)≥1−δ

则称学习算法能从假设空间H中PAC辨识概念类C。这样的学习算法能以较大的概率(至少1−δ) 学得目标概念c的近似 (误差最多为ϵ)。在此基础上可定义:

-

PAC可学习:令m表示从分布D中独立同分布采样得到的样例数目,0<ϵ,δ<1,对所有分布D,若存在学习算法和多项式函数poly(1/ϵ,1/delta,size(x),size(c))(样例数目m与误差ϵ、置信度1−δ、数据本身的复杂度size(x)、目标概念的复杂度size(c)都有关),使得对于任何m≥poly(1/ϵ,1/delta,size(x),size(c)) ,学习算法能从假设空间中PAC辨识概念类C,则称概念类C对假设空间而言是PAC可学习的,有时也简称概念类C是PAC 可学习的。

-

PAC学习算法:满足PAC可学习的算法。(假定学习算法处理每个样本的时间为常数,因此C的时间复杂度等价于样本复杂度。于是,我们对算法时间复杂度的关心就转化为对样本复杂度的关心)

-

样本复杂度(Sample Complexity):满足m≥poly(1/ϵ,1/δ,size(x),size(c))的最小的m。

-

PAC学习中一个关键因素是假设空间H的复杂度。H包含了学习算法所有可能输出的假设,若在PAC学习中假设空间与概念类完全相同,即H=C,这称为"恰PAC可学习" (properly PAC learnable)。直观地看,这意味着学习算法的能力与学习任务”恰好匹配“。

然而,这种让所有候选假设都来自概念类的要求看似合理,但却并不实际,因为在现实应用中我们对概念类C通常一无所知,更别说获得一个假设空间与概念类恰好相同的学习算法。显然,更重要的是研究假设空间与概念类不同的情形,即H=C。 一般而言,H越大,其包含任意目标概念的可能性越大,但从中找到某个具体目标概念的难度也越大。∣H∣有限时,我们称究为"有限假设空间",否则称为"无限假设空间"。

3 有限假设空间

3.1 可分情形

对于PAC来说,只要训练集D的规模能使得学习算法以概率1−δ找到目标假设的ϵ近似即可。

先估计泛化误差大于ϵ但在训练集上仍表现完美的假设出现的概率。假定h的泛化误差大于ϵ,对分布D上随机采样而得到的任何样例(x,y),有:

P(h(x)=y)=1−P(h(x)=y) =1−E(h) ≤1−ϵ

由于D中包含m个样例,因此,h与D表现一致的概率为:

P((h(x1)=y1)(h(x2)=y2)⋯(h(xm)=ym))<(1−ϵ)m

我们事先不知道学习算法会输出那个假设,但仅需要保证泛化误差大于ϵ,且在训练集上变现完美的多有假设出现概率之和不大于δ即可。

P(h∈H:E(h)>ϵ ∩ E^(h)=0)<∣H∣(1−ϵ)m<∣H∣e−mϵ

令上式不大于δ

∣H∣e−mϵ≤δ

可得

m≥ϵ1(ln∣H∣+lnδ1)

由此可知,有限假设空间H都是PAC可学习的,所需的样例数目如上式所示,输出假设h的泛化误差随样例数目的增多而收敛到 0,收敛速率为 O(m1)。

3.2 不可分情形

当c∈/H时,我们的学习算法无法学习到目标概念c的ϵ近似,但是当假设空间给定时,必定存在一个泛化误差最小的假设,找出此假设的ϵ近似也不失为一种较好的目标。

H中泛化误差最小的假设是argminh∈HE(h),以此为目标可将PAC学习推广到c∈/H的情况,称为**”不可知学习“**(agnostic learning)。其概念如下:

令m表示从分布D中独立同分布采样得到的样例数目,0<ϵ,δ<1,对所有分布D,若存在学习算法和多项式函数poly,使得对于任何m≥poly(1/ϵ,1/δ,size(x),size(c)),学习算法能从假设空间中输出满足下式的假设h:

P(E(h)−h′∈HminE(h′)≤ϵ)≥1−δ

则称假设空间是不可知PAC学习的。

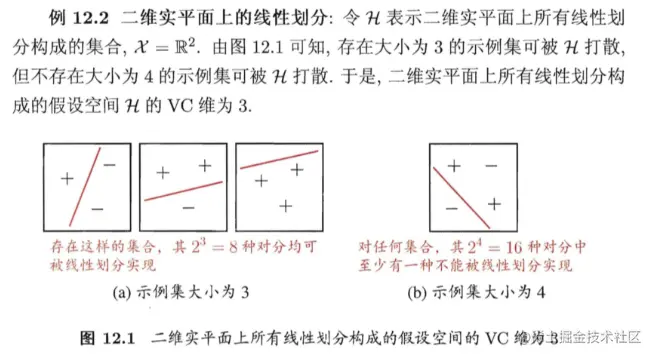

4 VC维

VC维:假设空间H的VC维是能被H打散的最大示例集的大小:

VC(H)=max{m:ΠH(m)=2m}

例如对二分类问题来说,m个样本最多有2m个可能结果,每种可能结果称为一种“对分”,若假设空间能实现数据集D的所有对分,则称数据集能被该假设空间打散。VC维指能被H打散的最大示例集的大小。

应注意到,VC维与数据分布D无关!在数据分布未知时,仍能计算出假设空间的VC维。

若假设空间H的VC维是d,则对任意整数m>d,有:

ΠH(m)≤(de⋅m)d

同时任何VC维有限的假设空间H都是(不可知)PAC学习的。

5 Rademacher复杂度

Rademacher 复杂度 (Rademacher complexity) 是另一种刻画假设空间复杂度的途径,与VC维不同的是,它在一定程度上考虑了数据分布。

考虑实值函数空间F→R,令Z={z1,z2,⋯,zm}。函数空间F关于Z的经验Rademacher复杂度

R^Z(F)=Eσ[f∈Fsupm1i=1∑mσif(zi)]

经验Rademacher复杂度衡量了函数空间F与随机噪声在集合Z中的相关性。通常我们希望了解函数空间F在Z上关于分布D的相关性,因此,对所

有从D独立同分布采样而得的大小为m的集合Z求期望可得

Rm(F)=EZ⊆Z:∣Z∣=m[R^Z(F)]

假设空间H的Rdemacher复杂度Rm(H)与增长函数ΠH(m)满足

Rm(H)≤m2lnΠH(m)

6 稳定性

顾名思义,算法的“稳定性”考察的是算法在输入发生变化时,其输出是否会随之发生较大的变化。学习算法的输入是训练集,因此下面我们先定义训练集的两种变化:

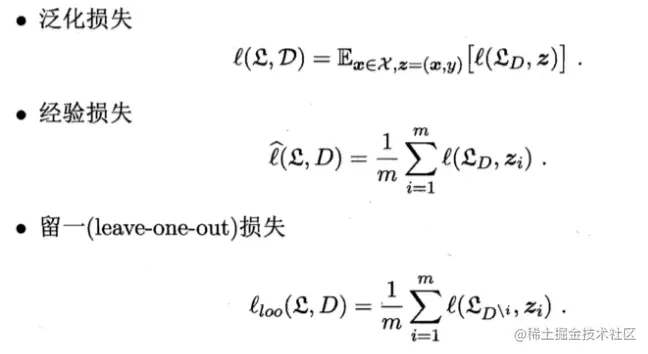

损失函数刻画了预测标记和真实标记的差别:

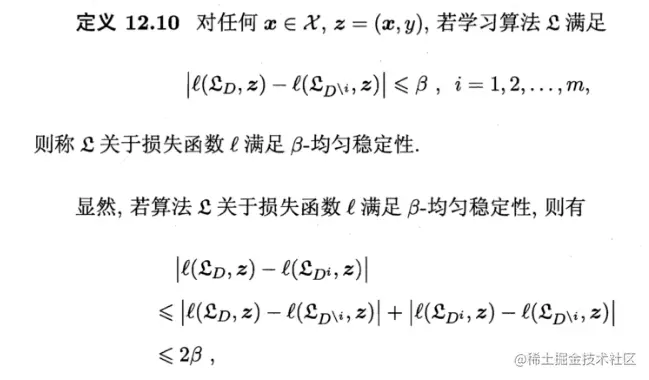

算法的均匀稳定性:

因此,移除示例的稳定性包含了替换示例的稳定性。

若学习算法符合经验风险最小化原则(ERM)且稳定的,则假设空间H是可学习的。稳定性通过损失函数与假设空间的可学习联系在了一起。