李宏毅机器学习笔记——深度学习简介与反向传播

1、深度学习的三个步骤

1.1 神经网络模型

- 隐藏层的本质:通过隐藏层进行特征转。把隐藏层通过特征提取来替代原来的特征工程,这样在最后一个隐藏层输出的就是一组新的特征(相当于黑箱操作)而对于输出层,其实是把前面的隐藏层的输出当做输入(经过特征提取得到的一组最好的特征)然后通过一个多分类器(可以是softmax函数)得到最后的输出y。

- 神经网络的结构决定了函数集(function set),所以说网络结构(network structured)很关键。

- 网络结构多少层? 每层有多少神经元? 这个问我们需要用尝试加上直觉的方法来进行调试。对于有些机器学习相关的问题,我们一般用特征工程来提取特征,但是对于深度学习,我们只需要设计神经网络模型来进行就可以了。对于语音识别和影像识别,深度学习是个好的方法,因为特征工程提取特征并不容易。

- 结构可以自动确定吗? 有很多设计方法可以让机器自动找到神经网络的结构的,比如进化人工神经网络(Evolutionary Artificial Neural Networks)但是这些方法并不是很普及 。

- 我们可以设计网络结构吗? 可以的,比如 CNN卷积神经网络(Convolutional Neural Network )

1.2 模型评估

- 损失函数采用交叉熵(cross entropy)函数

1.3 选择最优函数

- 具体流程:θ\thetaθ是一组包含权重和偏差的参数集合,随机找一个初试值,接下来计算一下每个参数对应偏微分,得到的一个偏微分的集合∇L\nabla{L}∇L就是梯度,有了这些偏微分,我们就可以不断更新梯度得到新的参数,这样不断反复进行,就能得到一组最好的参数使得损失函数的值最小

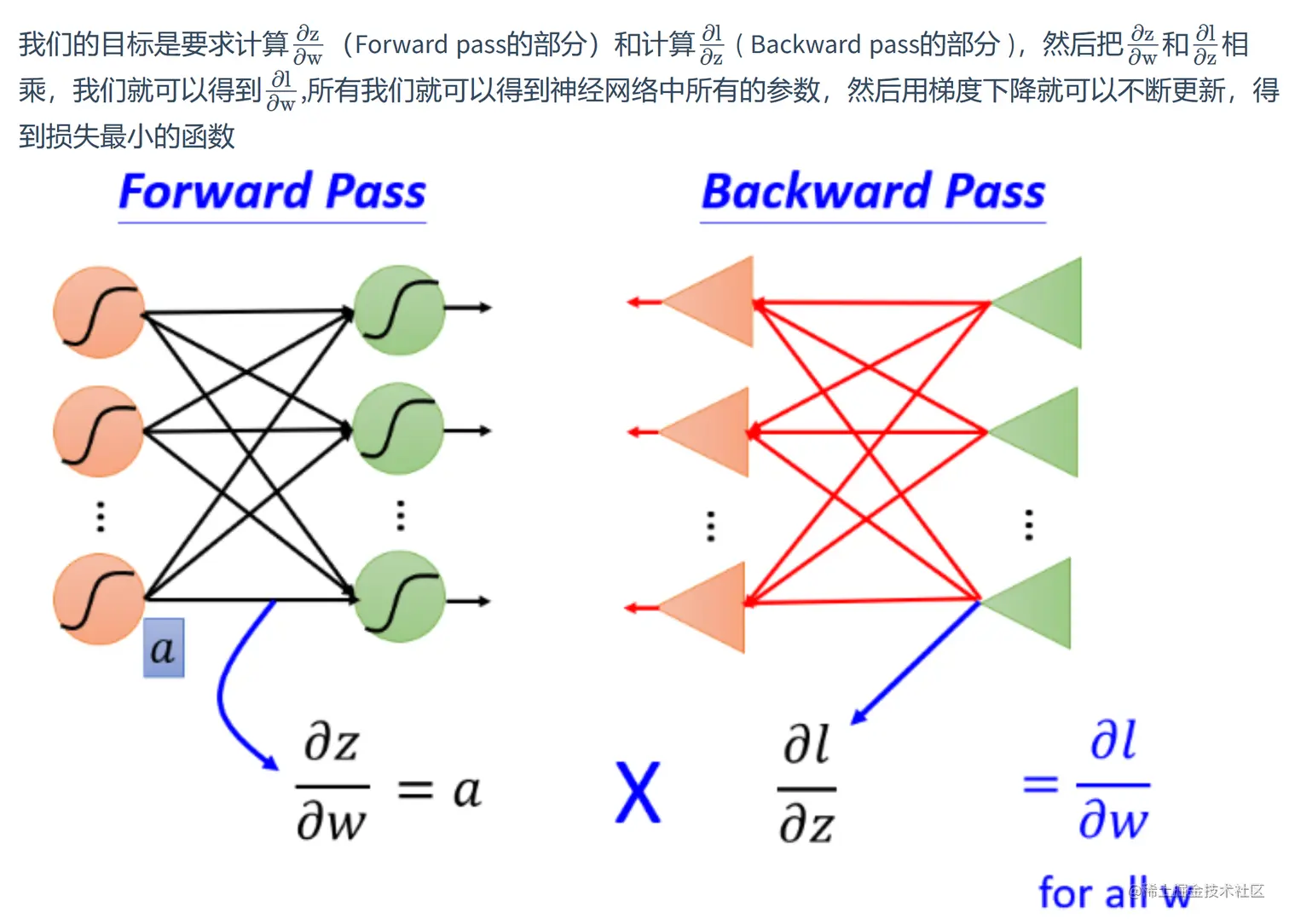

2、反向传播

- 反向传播(Backpropagation)是一个计算梯度下降(Gradient) 的损失函数的高效方法

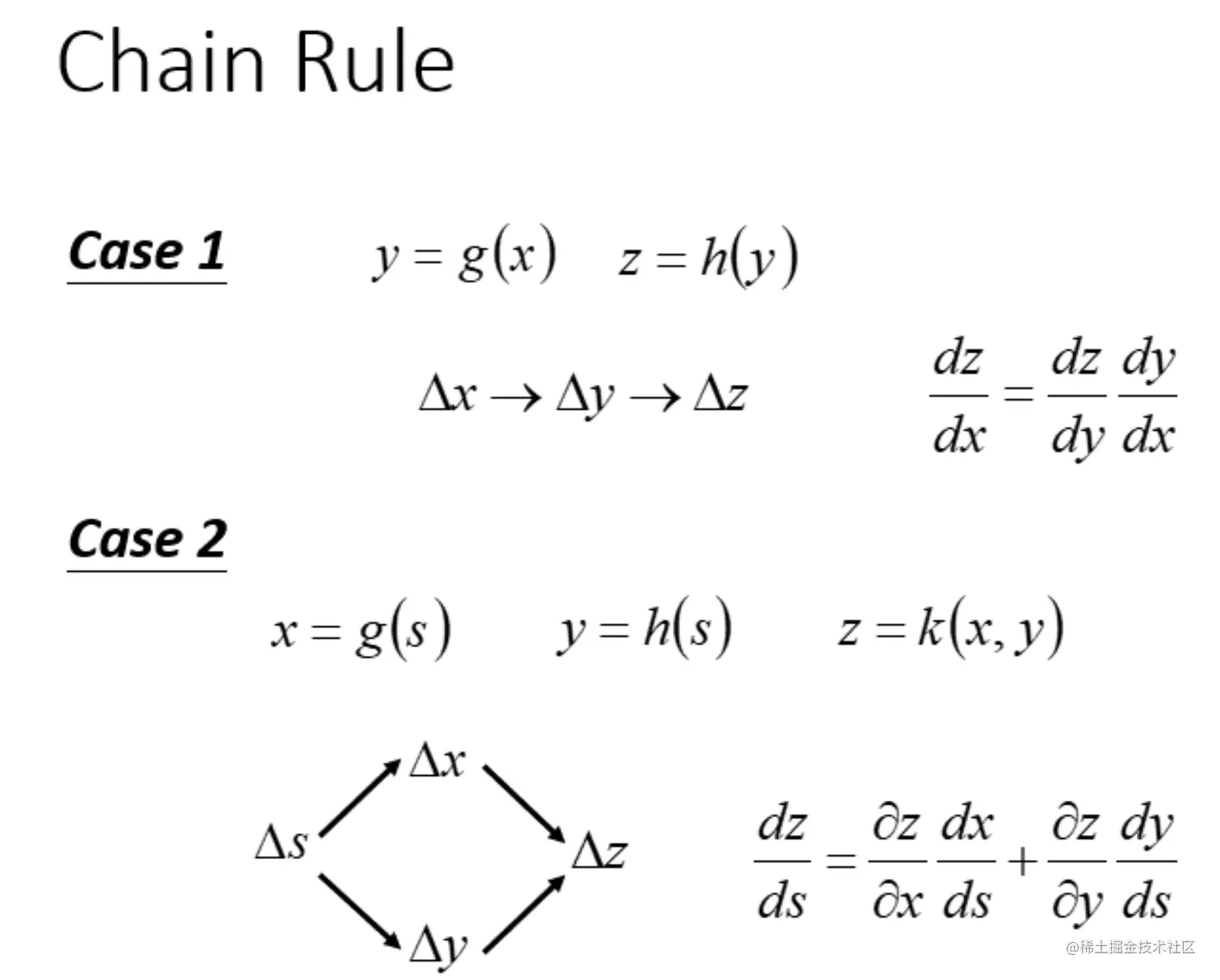

- 背景:梯度下降,链式法则