使用docker快速开发了一个单节点的hadoop

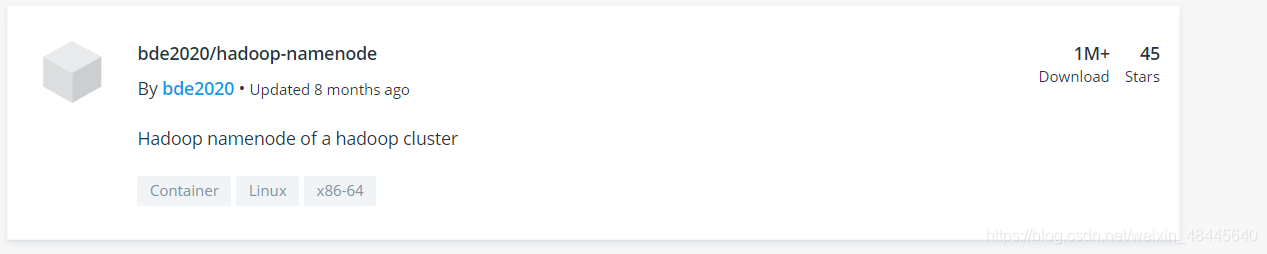

首先去docker hub上搜索hadoop

使用hadoop3.1.3的TAG即可,分别拉去datanode和namenode的镜像到本地

官方提供了修改配置文件的方法:

拉取完成后分别执行如下命令:

docker run -d \

--name hadoopmaster \

--hostname hadoopmaster \

-e CLUSTER_NAME=xxx \ #该镜像需要填写cluster_name才能创建

-e CORE_CONF_fs_defaultFS=hdfs://hadoopmaster:8020 \ #修改core-site.xml 的配置项(这里要和datanode对应一样,才能让datanode注册到该namenode上)

-e HDFS_CONF_dfs_namenode_datanode_registration_ip___hostname___check=false \ (此添加项改为false,否则会报Datanode denied communication with namenode because hostname cannot xxx 的异常)

-e CORE_CONF_hadoop_tmp_dir=/hadoop/dfs/data -v

-e HDFS_CONF_dfs_permissions_enabled=false \(将权限关闭,否则hbase连接时会报写入权限问题)

/home/xxx/hadoop1/name:/hadoop/dfs/data \

-P -p 8020:8020 你的imageID(namenode)

docker run -d --name datanode01 --hostname datanode01 --link hadoopmaster(必须加上才能通信到上面创建的镜像) -e CORE_CONF_fs_defaultFS=hdfs://hadoopmaster:8020 -e CORE_CONF_hadoop_tmp_dir=/hadoop/dfs/data \

-e HDFS_CONF_dfs_namenode_datanode_registration_ip___hostname___check=false \

-e HDFS_CONF_dfs_permissions_enabled=false \(将权限关闭,否则hbase连接时会报写入权限问题) \

-v /home/xxx/hadoop1/data1:/hadoop/dfs/data -P 你的imageID(datanode)

注:最开始启动时会报出域名解析问题(通过docker logs 镜像id查看)

由于配置hadoop没有使用host+hostname的配置方式,所以hadoop无法解析DataNode,从而注册出了问题。

解决方法是在hdfs-site.xml中添加,也就是上面的响应-e 修改配置参数

<property>

<name>dfs.namenode.datanode.registration.ip-hostname-check</name>

<value>false</value>

</property>

这里还要注意一点没有改workers文件是因为直接单启动,不是群起,只要fs_defaultFS一样即可以注册上