论文链接:arxiv.org/pdf/1802.03…

关键词:Donut算法

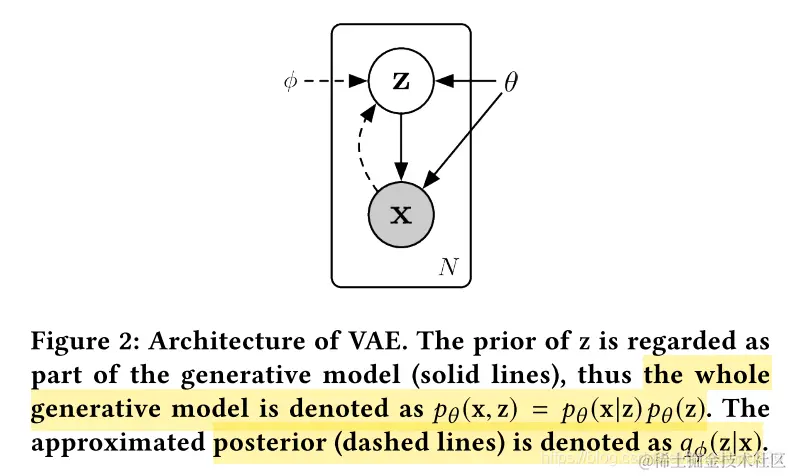

网络结构和随机变量

- prior:

- z: pθ(z)∼N(0,I)

- x: vector of : xt−W+1,...,xt

- posterior:

- x: pθ(x∣z)=N(μx,σx2I)

- z: qϕ(z∣x)=N(μz,σz2I)

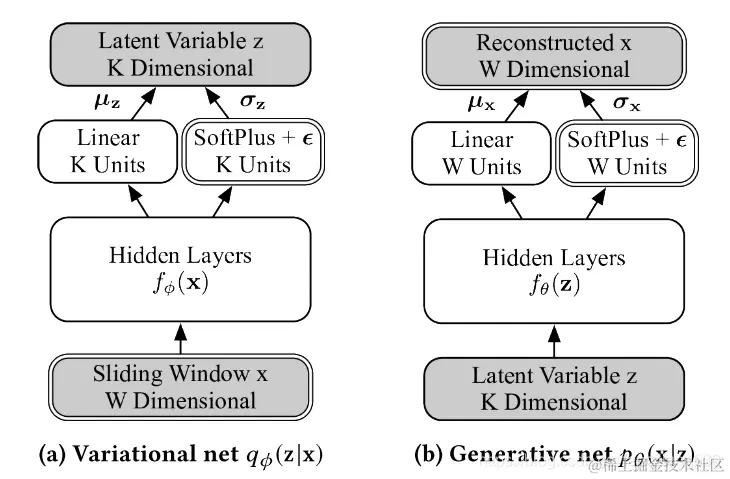

- hidden features:(通过Hidden Layers--full-connected layer【简单的结构可以更好的解释网络】进行提取)

- x:fϕ(x)

- z: fθ(z)

- Gaussian parameters:(通过hidden feature进行生成)

- linear layers:

- μx=WμxTfθ(z)+bμx

- μz=WμzTfϕ(x)+bμz

- SoftPlus:(加上一个很小的非负数ϵ)

- σx=SoftPlus[WσxTfθ(z)+bσx]+ϵ

- σz=SoftPlus[WσzTfϕ(x)+bσz]+ϵ

- SoftPlus[a]=log[exp(a)+1]

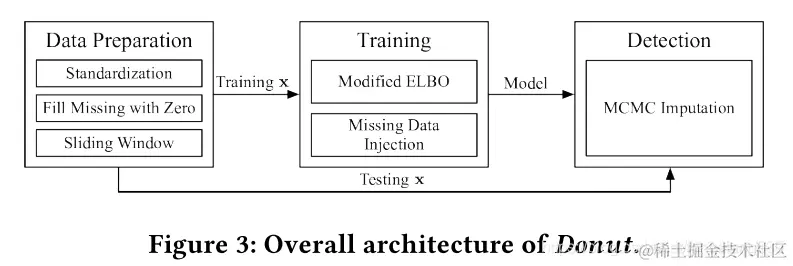

模型重构常规模式的步骤:

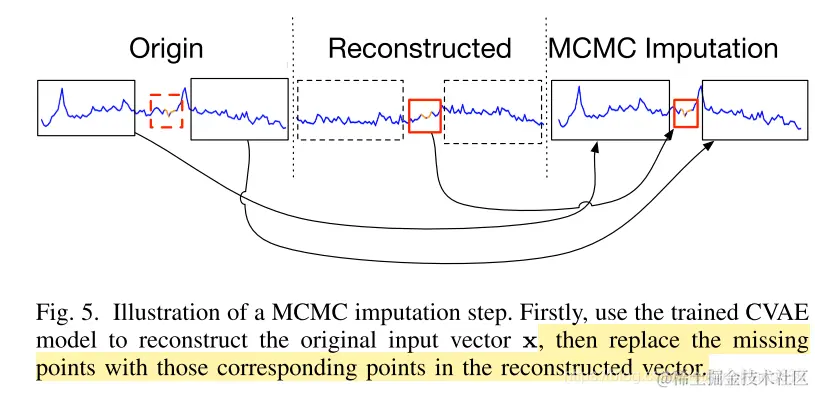

这幅图体现的过程是,通过使用模型,对测试集中有missing points的数据进行重构还原,更具体的细节可以在Bagel算法论文中看到,如下图:

- 在训练过程中,并注入数据填补缺失的内容,而是简单的将其值设置为0

- 上面的数据注入,实在测试集上,仅当模型训练完,才进行缺失数据的注入(使用Donut生成的片段)

训练细节

- SGVB 算法

- re-paramerterization:

- 原本: z∼N(μz,σz2I)

- 改为:ξ∼N(0,I),z(ξ)=μz+ξ⋅σz

目标函数:

L(x)=Eqϕ(z∣x)[w=1∑Wαwlogpθ(xw∣z)+βlogpθ(z)−logqϕ(z∣x)]

- αw=1时表示xw不是异常或者缺失点;αw=0,则表示xw是非正常点,直接将异常排除

- β=(∑w=1Wαw)/W,当正常点越多,噪点所起作用也越大

- 注意到,αw 其实表示人为的标注,为0的值越多表示人工标注越多,当然如果没有任何标注,算法也能继续运行。这一点使得该算法能很好的处理少量标注的情况

- 函数E的计算方式如下:Eqϕ(z∣x)[x]=N1∑iNxi, N为qϕ(z∣x)的样本数