IEEE Transactions on Circuits and Systems for Video Technology 2019 Yanwei Pang , Senior Member, IEEE, Jin Xie , and Xuelong Li , Fellow, IEEE

简介

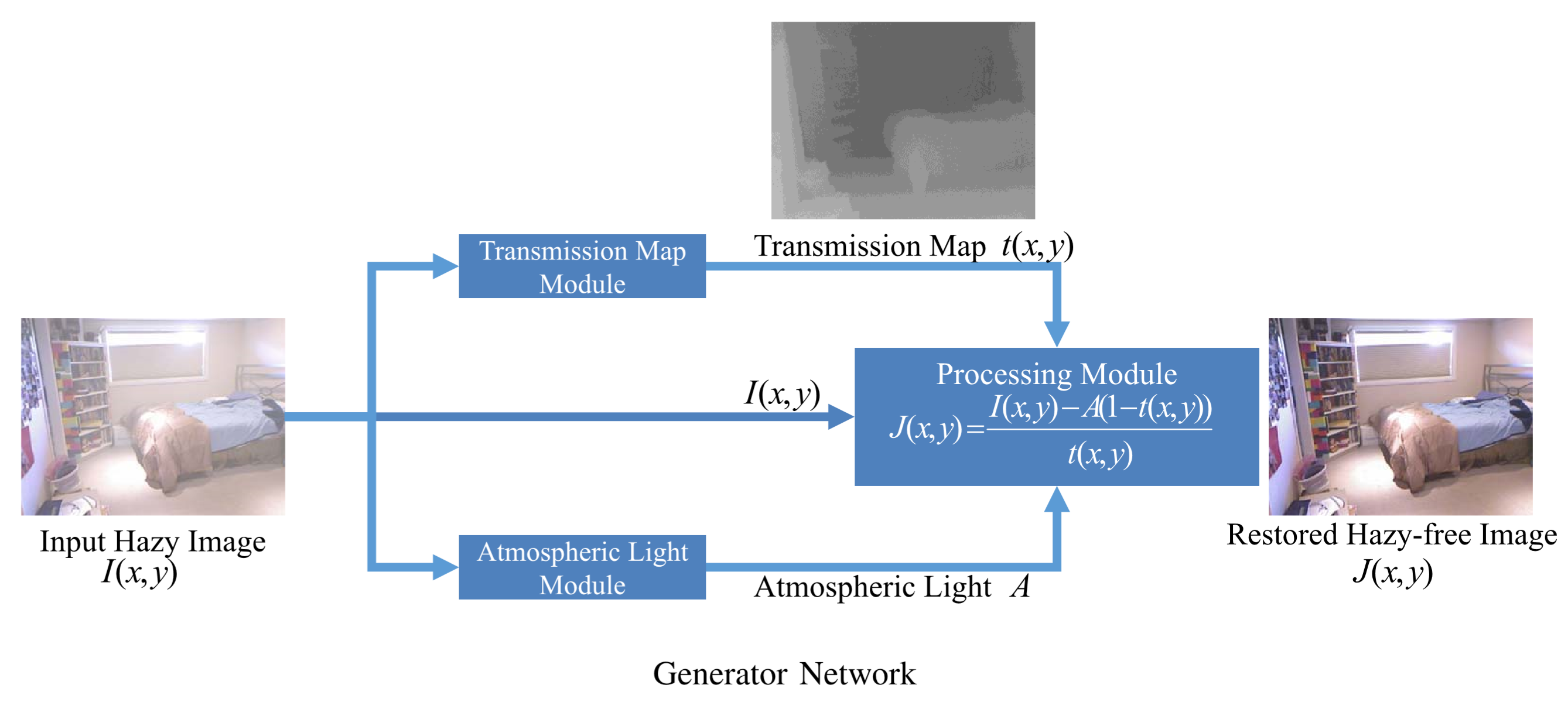

文章对于去雾问题提出了名为HRGAN的新网络,顾名思义是生成器-鉴别器的对抗式生成网络。HRGAN能够联合估计大气散射模型中A,t和去雾结果J。生成器部分称为UNTA,意味联合了A,t来估算最终去雾结果J。鉴别器负责区分生成器的去雾结果和Gth。文章使用了像素损失(pixel-wise loss),感知损失(perceptual loss),对抗损失(adversarial loss)。

motivation

首先文章认为以往的基于学习的去雾一般为,估计A,估计t,然后就反向传播了。这样的计算方式孤立了A和t的估计,如果能够对它的去雾结果J计算一个loss来反向传播会更好。

model

生成器(Generator)

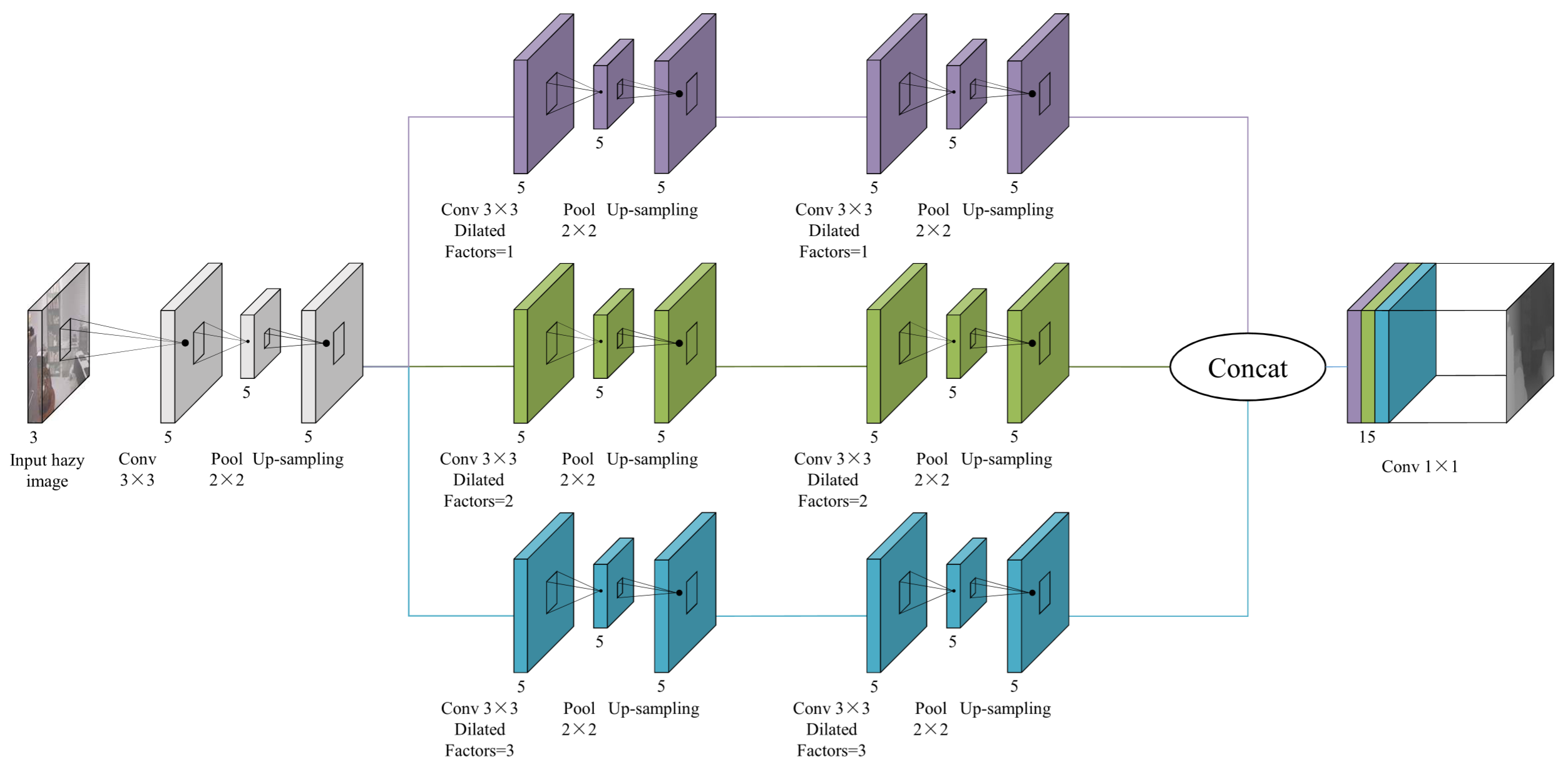

Transmission Map Module

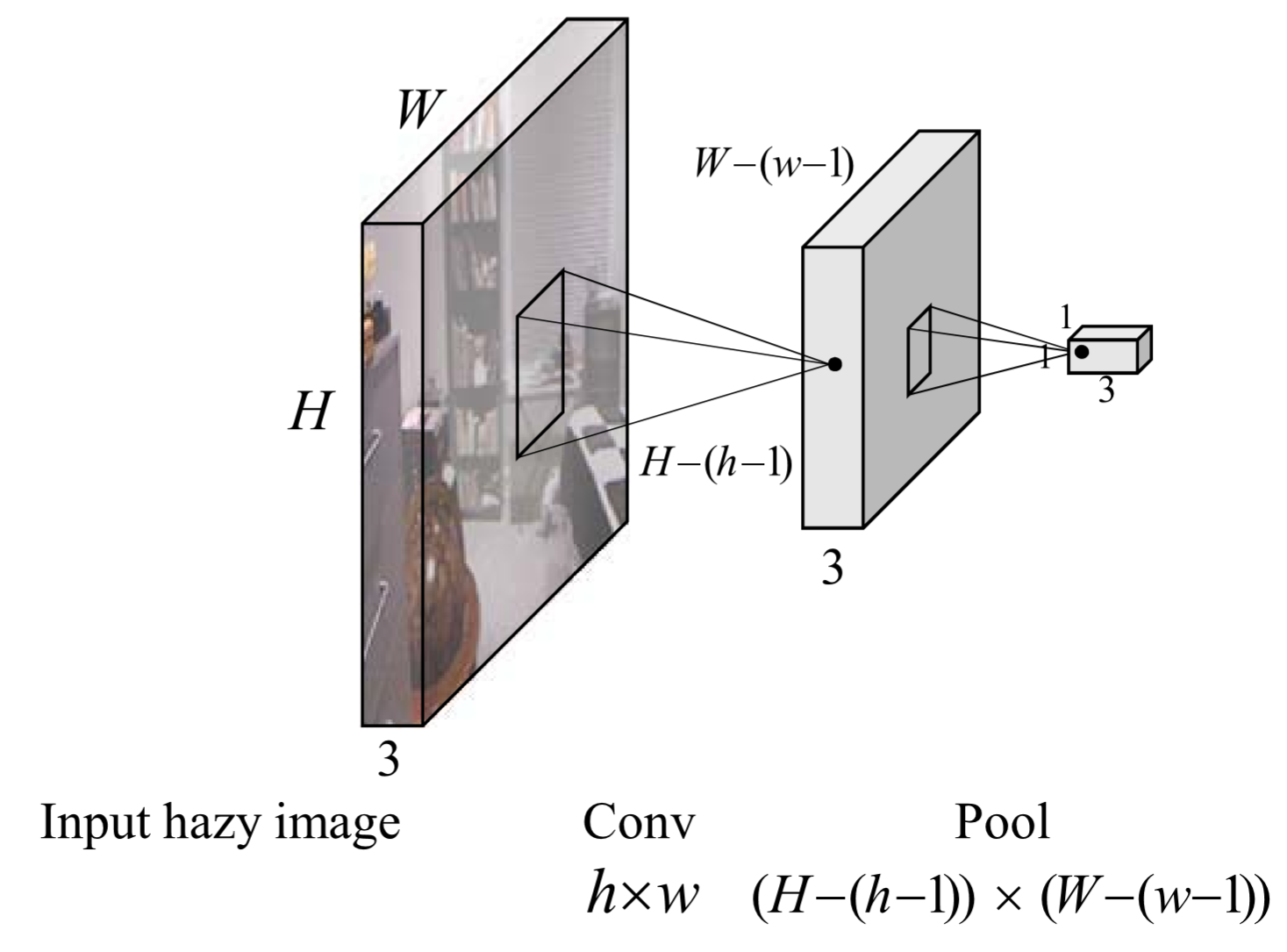

Atmospheric Light Module

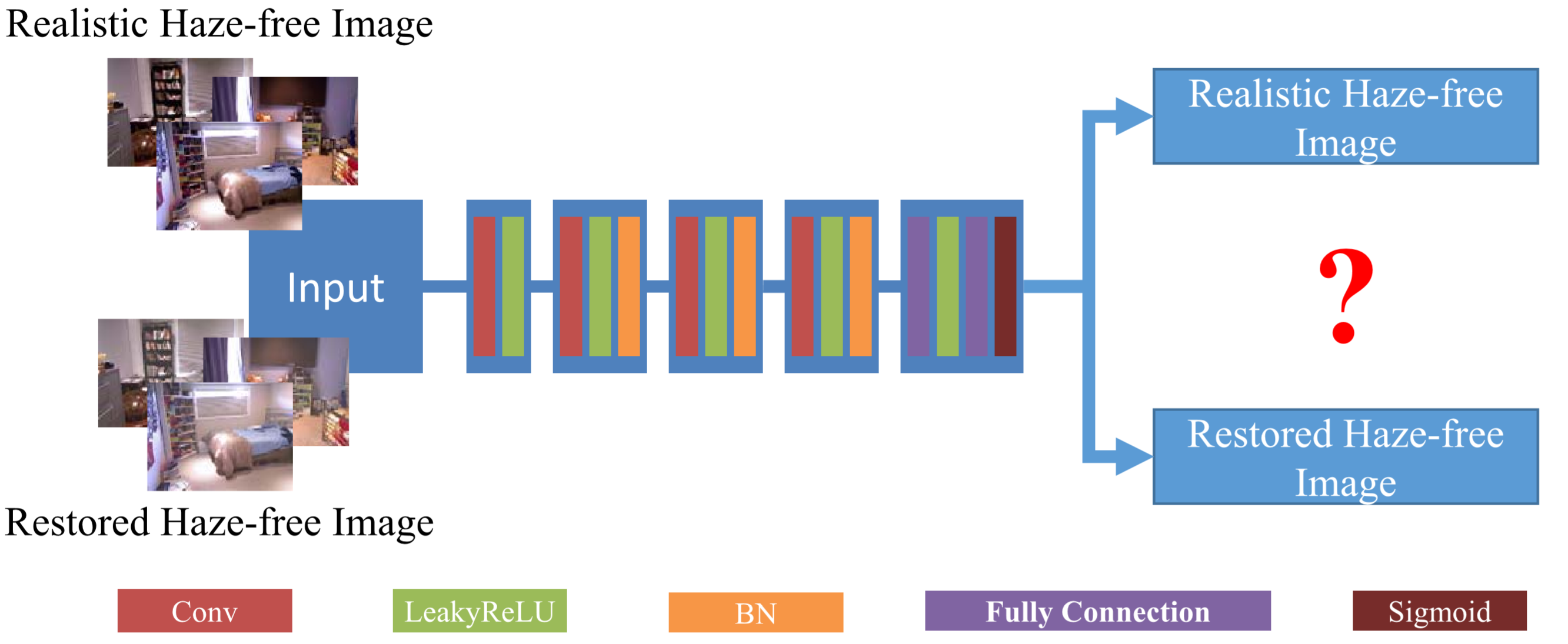

鉴别器(Discriminator)

生成器和鉴别器通过以下这条公式来轮流更新权重:

鉴别器的结果是处于的范围内的。故以上表达式为负。鉴别器D的任务是最大化该公式,使

,能使该表达式达到最大值0。反之,鉴别器的任务是使

尽可能的和

一样,让鉴别器难以区分,从而得到

,使该上述表达式变小。

一次只输入一张图像,输出结果是判断输入图像是真实场景的图像还是去雾网络的去雾结果。

Loss Function

损失函数公式表达如下:

,

,

分别为像素损失(pixel-wise loss),对抗损失(adversarial loss),感知损失(perceptual loss)。其中

,

像素损失(pixel-wise loss)

该损失函数为去雾结果和无雾图以及估计的t图和Gth的t图的损失。其中

对抗损失(adversarial loss)

感知损失(perceptual loss)

是VGG-16网络的某一层特征层。感知损失能够比像素损失更好的衡量图像的视觉相似性。

数据和训练

数据集

- 训练集使用NYU-Depth V2合成的有雾图像。其中

,

。从用NYU-Depth V2选择1000张无雾图,随机选择10组

和

合成1W张训练图像。

- 从Middlubury立体数据集中获得300张室内合成图像作为测试集1

- 从SOTS数据集中获得500张室外合成图像作为测试集2

训练设置

- 图像大小为

- batch-size=10

- 传输图估计模块学习率为

- 大气光估计模块学习率为

- 共训练80个epoch

- 在训练20个epoch后,学习率均下降为原来的0.1

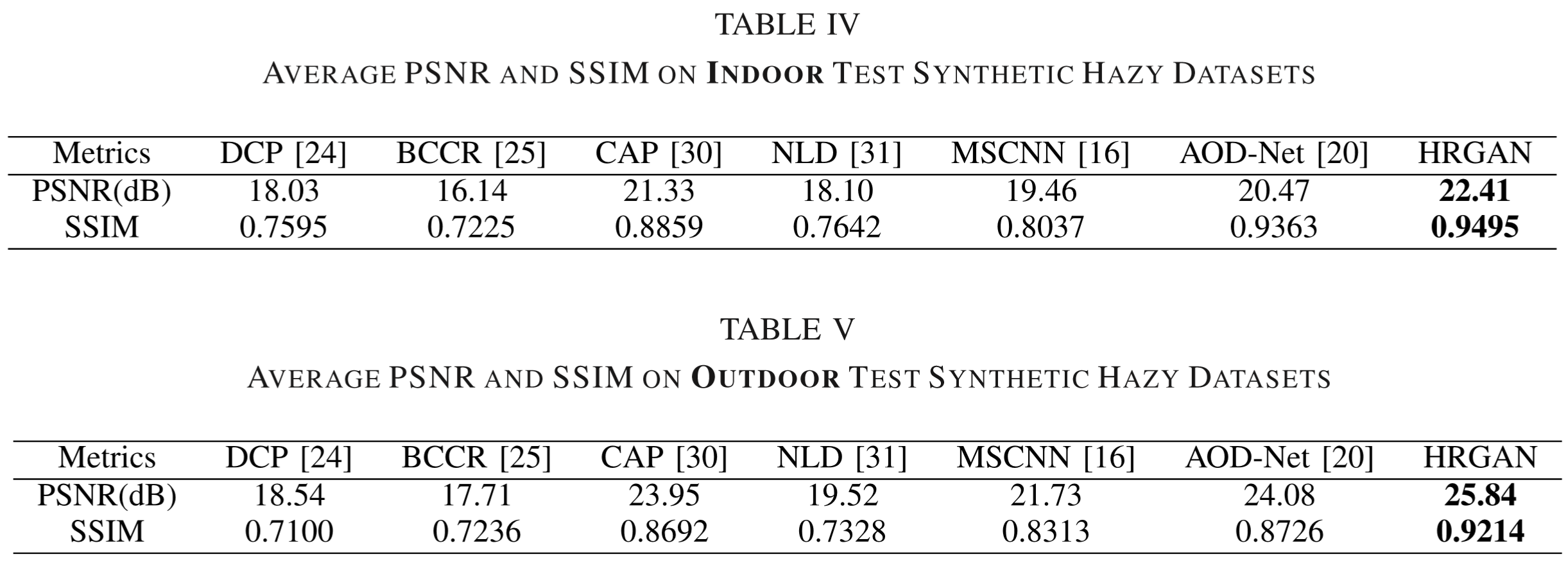

对比和测试

测试指标

- PSNR

- SSIM

- MSE

合成有雾指标对比

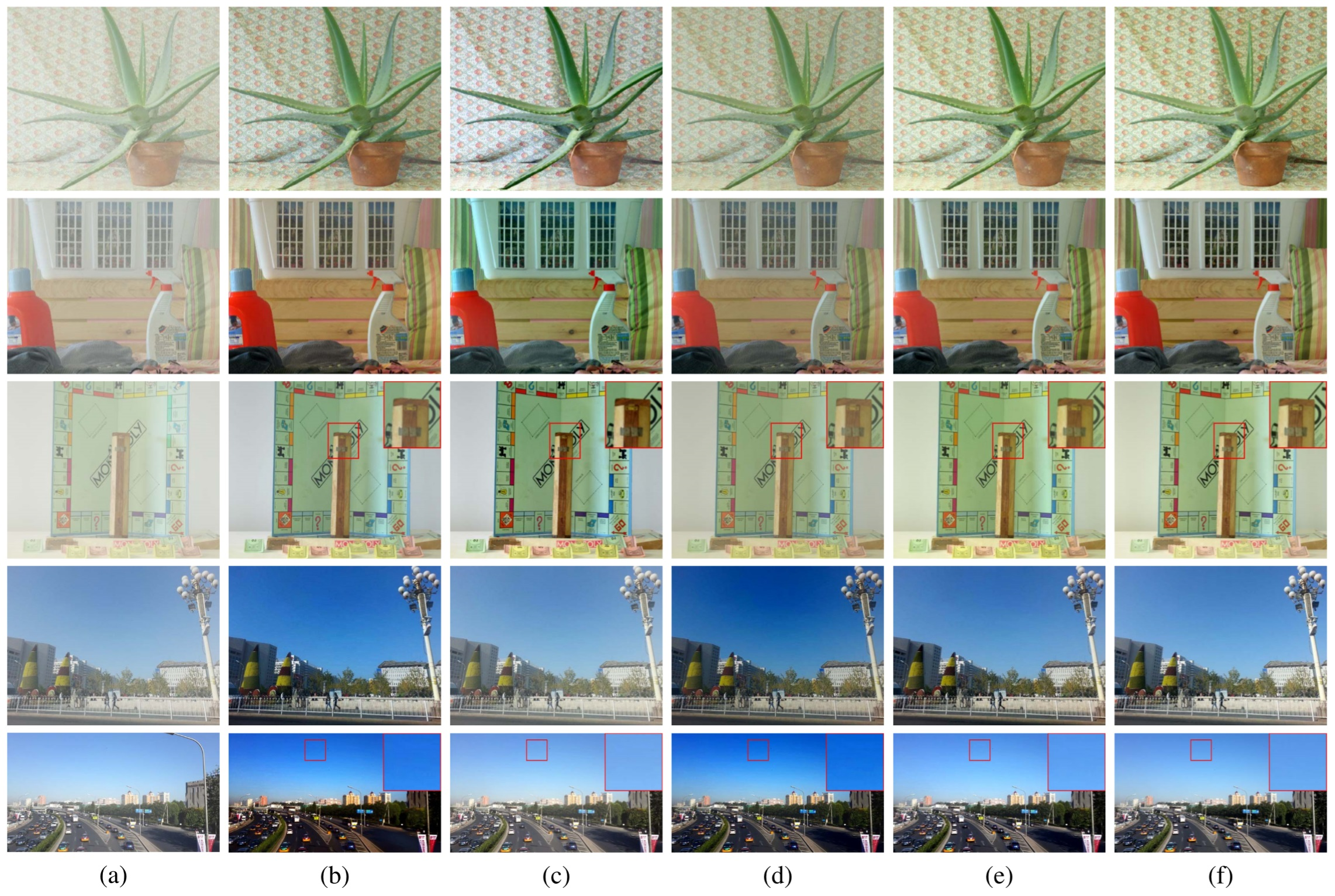

合成有雾测试结果展示

- (a) 合成有雾图像

- (b) CAP

- (c) MSCNN

- (d) AOD-Net.

- (e) HRGAN

- (f) Ground-truth images

真实有雾测试结果展示

- (a) 真实有雾图像

- (b) CAP

- (c) DehazeNet

- (d) MSCNN

- (e) AOD-Net

- (f) HRGAN