铜灵 发自 凹非寺

量子位 出品 | 公众号 QbitAI

这一次AI自己给AI论文生成了一次摘要。

今天,一个可为长文自动生成总结的Transformer语言模型论文在推特火了起来。

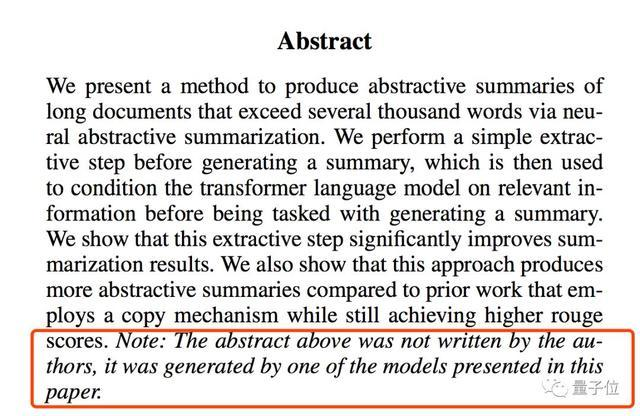

细心了网友看到论文摘要结尾,才发现一个斜体备注中写着:上面的摘要不是作者写的,而是由研究中展示的一个模型自动生成的。

以假乱真的生成质量,让不少网友大吃一惊。并且,其生成方式也不一般:

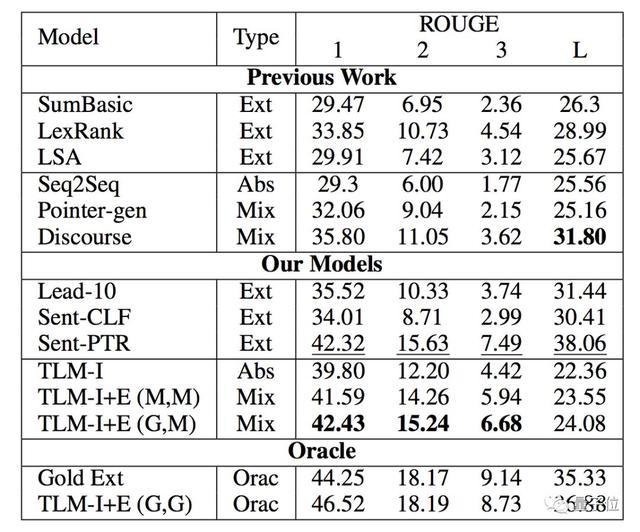

研究证明了,即使没有复制机制,Transformer语言模型在总结长篇科学文章方面也非常有效,并且效果优于传统的seq2seq方法。

并且,与先前使用复制机制的研究相比,新方法生成的摘要更全,在用于评估自动生成的摘要和翻译水平的ROUGE评测上,获得了更高的分数。

这项研究被OpenAI研究科学家、牛津大学人类未来研究所研究员Miles Brundage的推荐和转发,不到一天时间获赞近2000,网友戏称为这是一项“摘要图灵测试”。

还有网友表示,在未来十年内,我们或许能看到第一篇transformer写出的研究论文了。

所以,这个让网友大吃一惊的总结摘要生成模型,到底是如何以假乱真的?

请看摘要↓

非复制机制

我们提出了一种新的方法,通过神经摘要式总结,可以为篇幅超过上千字的长文档自动生成摘要。我们展示了一种在生成总结前的简单提取步骤,在执行生成摘要任务前,会根据相关信息,将其用于Transformer语言模型,帮助模型进行条件设置。实验结果表明,这个步骤显著提高了总体结果。我们还证明了,与之前使用复制机制(copy mechanism)的工作相比,这种方法生成了抽象的总结,并且还能取得更高的Rouge分数。

此前,摘要提取方法大多依据的是序列到序列(seq2seq)的学习方法,将关键词识别定义为生成问题,输出时将关键短语看作为词序列。

为了这其中的控制参数数量只会选取其中出现频率较高的词汇,于是相对低频且重要的词汇就会在提取过程中被遗漏,于是就诞生了“复制机制”。

通过复制机制,模型解码器的部分隐藏状态当成特定的位置,不通过生成过程定义关键词,而是直接复制。

这样一来,就能保留原始文章中的重要信息了,进而在输出端生成出摘要。

而在这篇论文中提到,不通过复制机制也可以准确提取重点信息。这是怎么做到的?

Transformer语言模型

在论文On Extractive and Abstractive Neural Document Summarization with Transformer Language Models中,研究人员具体介绍了模型的架构。

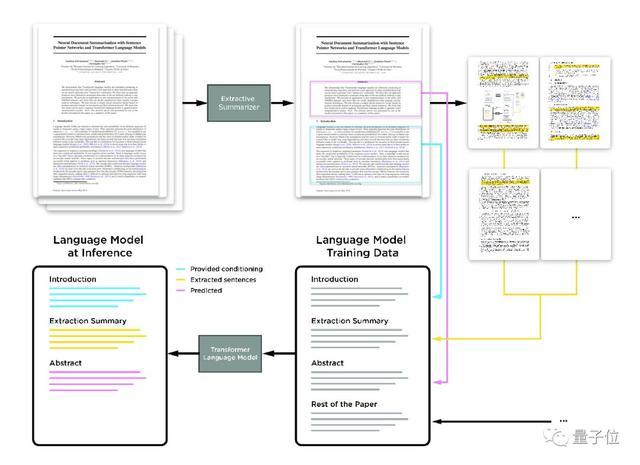

这个模型提取科学论文的摘要是分阶段的。

首先,句子指针网络(pointer network)从论文中提取出重要信息。

接下来,这些提取过的句子会随着完整文章一起按照顺序进行排列:引言、抽取的句子、摘要和论文其他内容。Transformer语言模型就是在以这种格式组织的论文上进行训练的。

在推理过程中,引言和提取的句子将作为上下文提供给语言模型,最终生成摘要。在新闻和专利领域,引言部分将被全文替代。

与此前大多数神经抽象概括方法不同,这种方法没有使用带有显式编码器和解码器的seq2seq公式来生成单词。

具体来说,研究人员使用单个类似GPT的Transformer 语言模型(TLM)进行训练,在推理阶段根据文档从语言模型中生成摘要。

研究人员将这个任务一分为二,即提取步骤(extractive step)和抽象步骤。

为了处理超过几千个单词的超长文档,他们先使用两个不同的分层文档模型对句子进行提取,一个基于指针网络,另一个基于句子分类器,这样的结构保证在生成摘要前更好地调整Transformer语言模型的相关信息。

研究人员选取了四种不同的大型长文档摘要数据集,分别为arXiv、PubMed 、bigPatent和Newsroom,对模型进行测试,并用Rouge指标进行测试。

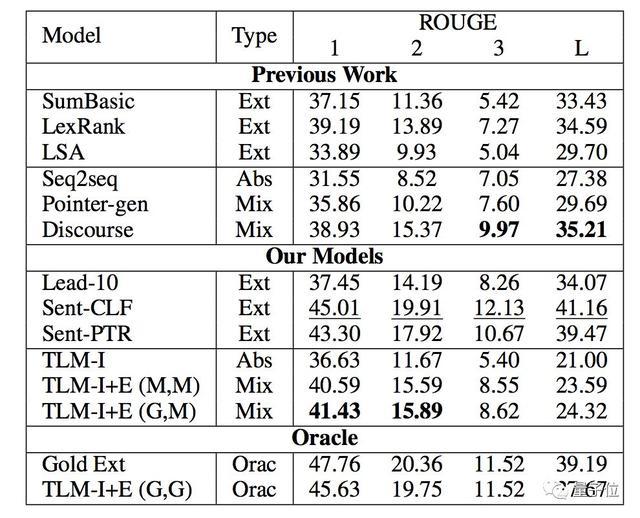

无论是针对arXiv上的科学论文:

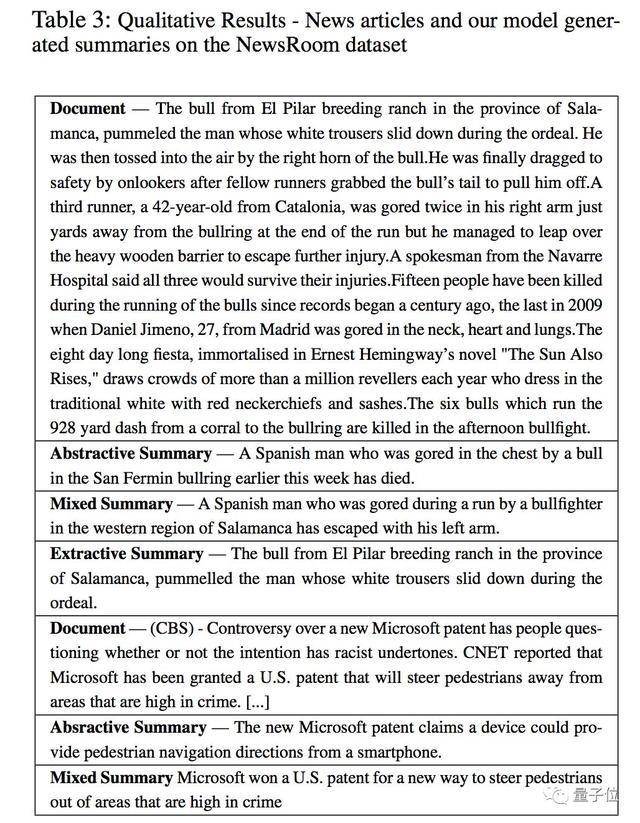

还是NewsRoom上的新闻:

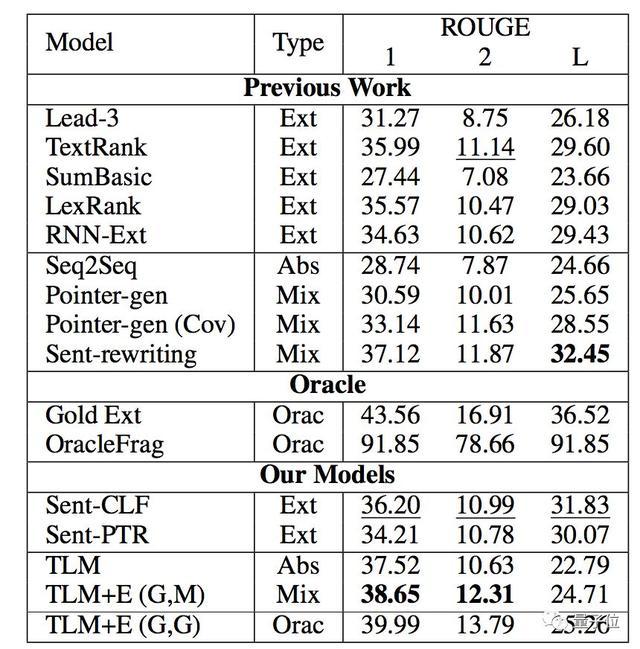

甚至是PubMed上的生物医学方面的论文:

还是130万份美国专利文献记录bigPatent :

新方法TLM均优于此前摘要提取的baseline,并超越了先前提取结果。

作者介绍

这篇论文的共同一作共有三位,均来自Element AI。

包括蒙特利尔学习算法研究所的Sandeep Subramanian,Raymond Li和蒙特利尔大学的Jonathan Pilault及Christopher Pal。

Element AI想必大家不会陌生,这是图灵奖得主、蒙特利尔大学计算机系教授Yoshua Bengio创办的创业孵化器,帮助来自蒙特利尔大学和McGill大学的AI创业者施展拳脚。

传送门

On Extractive and Abstractive Neural Document Summarization with Transformer Language Models

On Extractive and Abstractive Neural Document Summarization with Transformer Language Modelsarxiv.org— 完 —

量子位 · QbitAI

վ'ᴗ' ի 追踪AI技术和产品新动态

戳右上角「+关注」获取最新资讯↗↗

如果喜欢,请分享or点赞吧~比心❤