注意:本文所有源码都是基于jdk1.8

java容器(集合)是java中比较重要的一个东西,经常会用到,在我们面试的时候也经常会用到。

一、 基本介绍

java容器类主要用来装对象,跟数组作用类似。

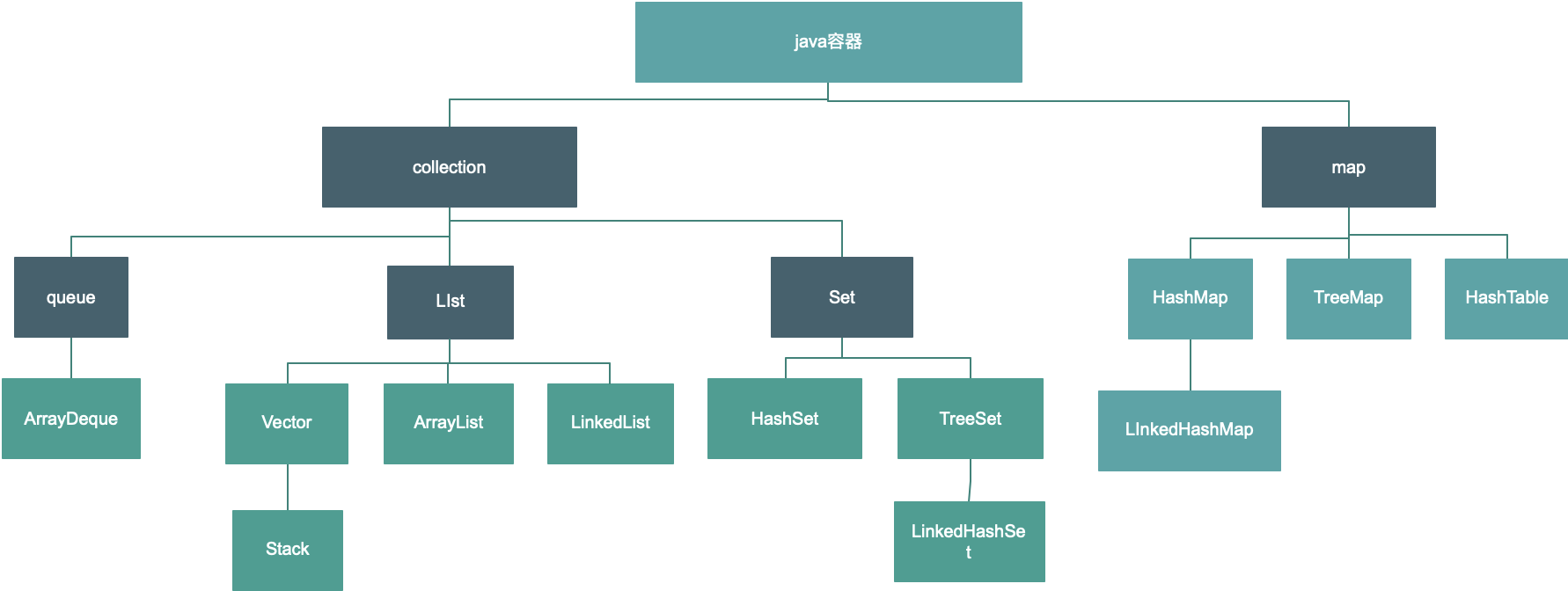

我们常用的按照接口划分主要分为两种:

collection和map

下面分别对我们常用的 list set map 单独展开来讲。

二、List

我们常用的list接口的实现类 有ArrayList 、 LinkedList和Vector。

- ArrayList

其中ArrayList 是我们用的最多的,操作读取操作效率高,基于数组实现的,可以为null值,可以允许重复元素,有序,异步。但是缺点也很明显,正因为是动态的数组,导致增删元素特别麻烦,且扩容特别麻烦,所以不适合频繁对元素进行插入和删除情形。 下面说下关于ArrayList的数据结构和新增元素的过程。

ArrayList底层基于数组。

/**

* Default initial capacity.

*/

private static final int DEFAULT_CAPACITY = 10;

/**

* Shared empty array instance used for empty instances.

*/

private static final Object[] EMPTY_ELEMENTDATA = {};

/**

* Shared empty array instance used for default sized empty instances. We

* distinguish this from EMPTY_ELEMENTDATA to know how much to inflate when

* first element is added.

*/

private static final Object[] DEFAULTCAPACITY_EMPTY_ELEMENTDATA = {};

public ArrayList(int initialCapacity) {

if (initialCapacity > 0) {

this.elementData = new Object[initialCapacity];

} else if (initialCapacity == 0) {

this.elementData = EMPTY_ELEMENTDATA;

} else {

throw new IllegalArgumentException("Illegal Capacity: "+

initialCapacity);

}

}

/**

* Constructs an empty list with an initial capacity of ten.

*/

public ArrayList() {

this.elementData = DEFAULTCAPACITY_EMPTY_ELEMENTDATA;

}

初始化时是一个object类型的空数组,在第一次调用add方法时会扩容到一个默认值10,然后后面每次扩容都是 增加至1.5倍。可在源码中看到这样一段代码

private void grow(int minCapacity) {

// overflow-conscious code

int oldCapacity = elementData.length;

int newCapacity = oldCapacity + (oldCapacity >> 1);

// 右移一位相当于除以2

if (newCapacity - minCapacity < 0)

newCapacity = minCapacity;

if (newCapacity - MAX_ARRAY_SIZE > 0)

newCapacity = hugeCapacity(minCapacity);

// minCapacity is usually close to size, so this is a win:

elementData = Arrays.copyOf(elementData, newCapacity);

}

// 从上面的源码可以看到那个 copyOf 方法,往下跟,可以看到下面这段源码

public static <T,U> T[] copyOf(U[] original, int newLength, Class<? extends T[]> newType) {

@SuppressWarnings("unchecked")

T[] copy = ((Object)newType == (Object)Object[].class)

? (T[]) new Object[newLength]

: (T[]) Array.newInstance(newType.getComponentType(), newLength);

System.arraycopy(original, 0, copy, 0,

Math.min(original.length, newLength));

return copy;

}

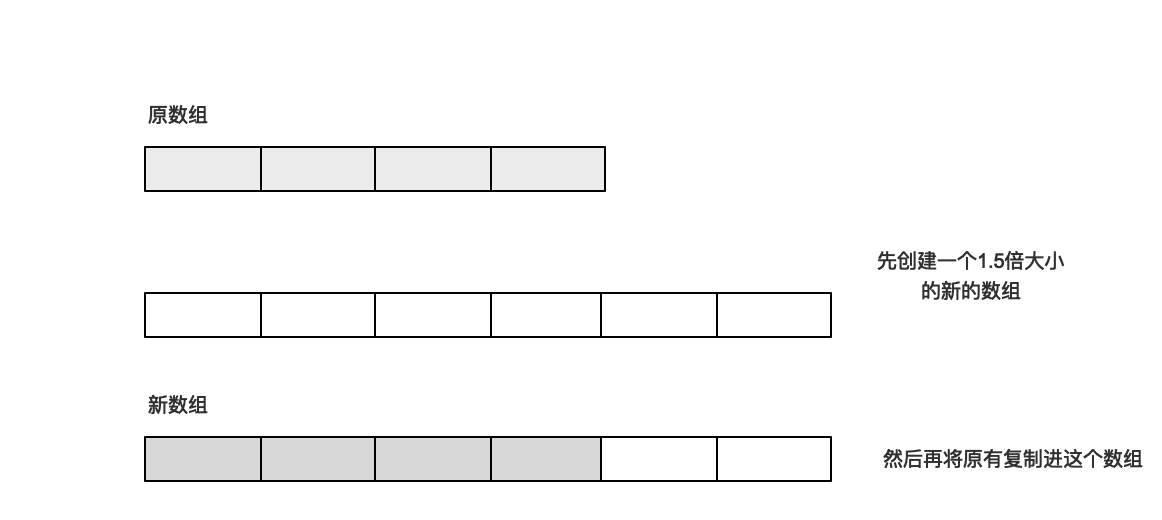

所以可以看到这个扩容过程比较复杂,当我们新增元素是,发现容量不够,会进行扩容,先创建一个同类型的数组,容量为原有+1的1.5倍(注意看源码size+1),然后将原数组内容拷贝到新数组中,原数组引用指向新数组。在这里我们可以看到 arraylist扩容的开销是特别大的。

讲完扩容,下面再来看看新增元素的过程。 arraylist 在尾部添加元素的比较简单。

public boolean add(E e) {

ensureCapacityInternal(size + 1); // Increments modCount!!

elementData[size++] = e;

return true;

}

先看需要扩容不,然后直接放到尾部。

arraylist还给我们提供了在指定位置新增元素的方法。

//ArrayList.java

public void add(int index, E element) {

rangeCheckForAdd(index);

ensureCapacityInternal(size + 1); // Increments modCount!!

System.arraycopy(elementData, index, elementData, index + 1,

size - index);

elementData[index] = element;

size++;

}

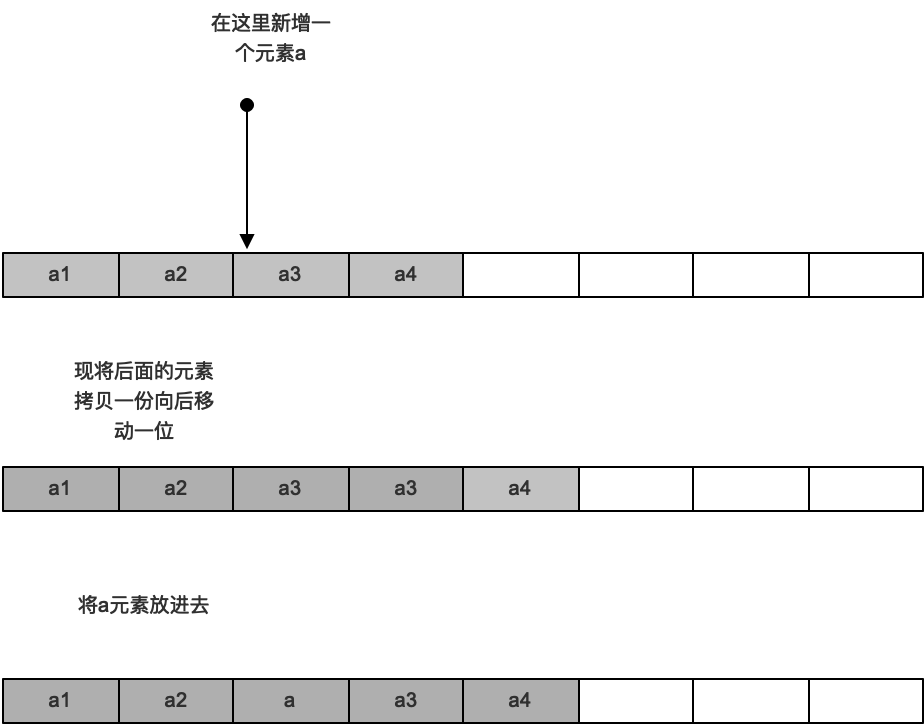

可以看到这里面比较麻烦,我们用图描述一下

- LinkedList

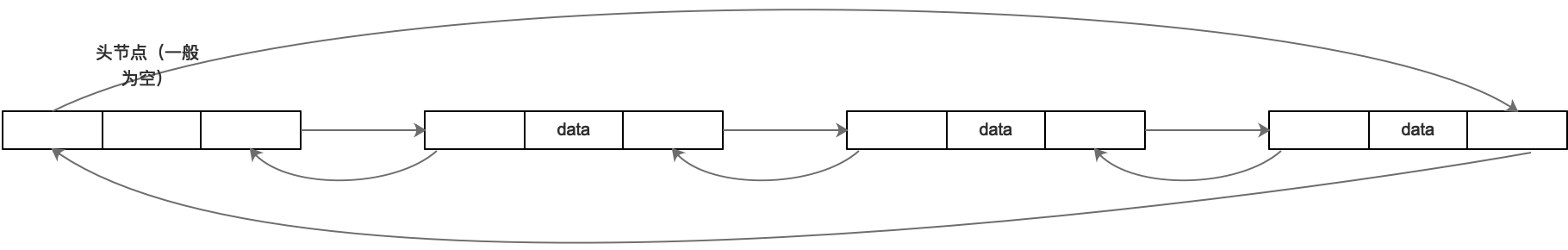

linkedlist实现了list接口,所以也是有序的容器,具备list的一些特征。 先说说它的内部结构。

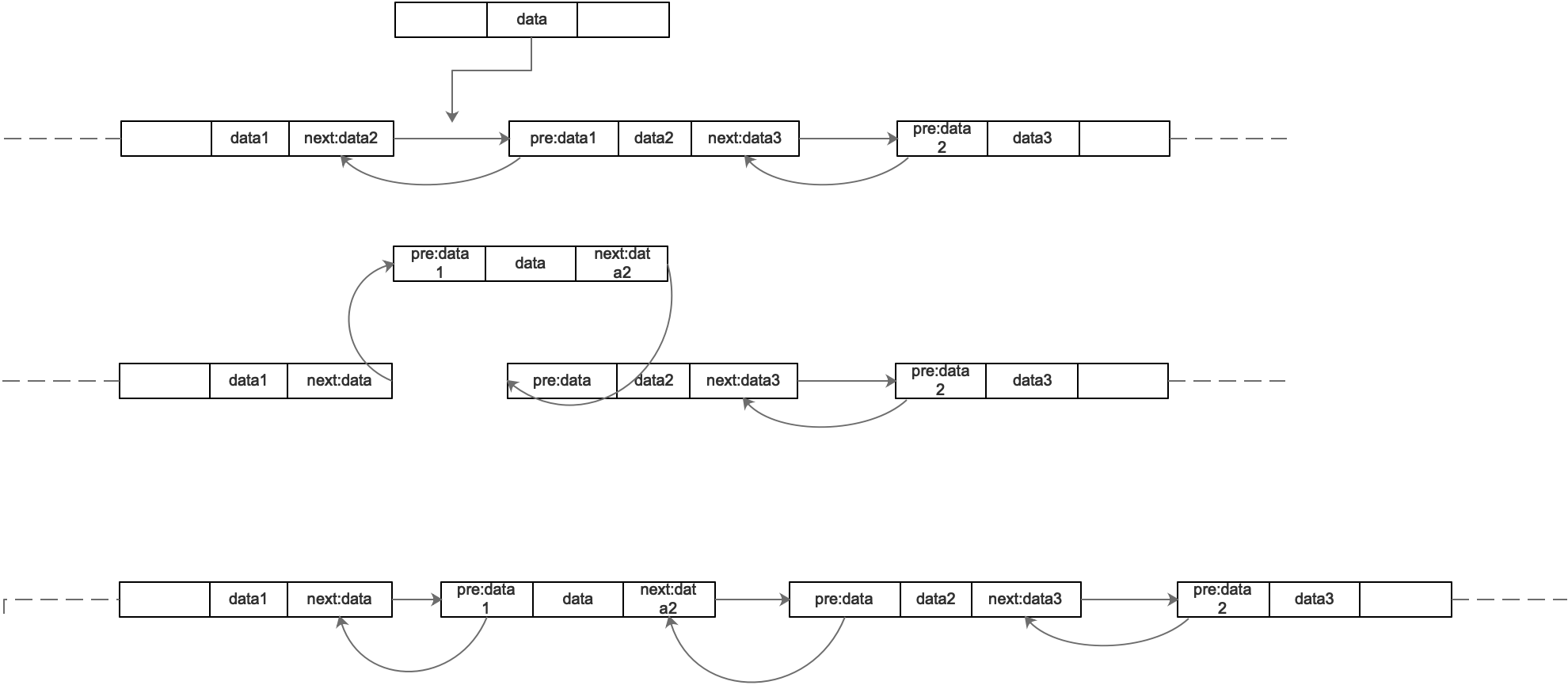

如图所示:linkedlist结构为双向链表,头节点为空,每个节点保存着上下元素的地址,所以这种结构在查找元素的时候会很慢,但是插入元素的时候会很快,且不存在扩容问题,下面看下插入元素过程。

public void add(int index, E element) {

checkPositionIndex(index);

if (index == size)

linkLast(element);

else

linkBefore(element, node(index));

}

/**

* Inserts element e before non-null Node succ.

*/

void linkBefore(E e, Node<E> succ) {

// assert succ != null;

final Node<E> pred = succ.prev;

final Node<E> newNode = new Node<>(pred, e, succ);

succ.prev = newNode;

if (pred == null)

first = newNode;

else

pred.next = newNode;

size++;

modCount++;

}

/**

* Links e as last element.

*/

void linkLast(E e) {

final Node<E> l = last;

final Node<E> newNode = new Node<>(l, e, null);

last = newNode;

if (l == null)

first = newNode;

else

l.next = newNode;

size++;

modCount++;

}

可以看到,linkedlist在add元素是比较简单,直接生成一个节点,节点内前后信息分别为插入点的前后节点信息,然后前节点的next指向新节点,后节点的pre指向新节点,就完成了一次插入。删除也是同理,删除指定的节点会有前后节点的信息,只要将对应的pre和next属性修改就行了。

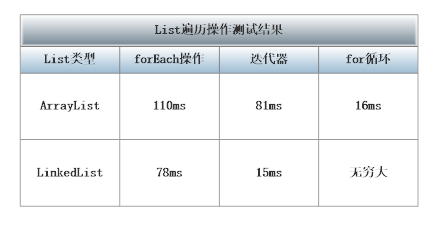

关于linkedlist相关的就基本差不多了,这里多插一句,关于循环遍历时for 和 foreach的问题。一般来说 for循环适用数组结构,也就是java数组和Arraylist,而linkedlist双向链表结构的一般使用foreach,原因在于,for循环遍历linkedlist时会一直使用下标查找,对于linklist来说很慢,但是使用foreach 是用游标方式获取下一个,而链表结构的获取下一个不用查找,直接在节点信息里面有信息,可直接获取。当然,使用迭代器iterator也是比较好的方式。

100万数据遍历耗时如下所示:

除此以外上述两个容器都是线程不安全的。 List list = Collections.synchronizedList(new LinkedList()); 或者换用ConcurrentLinkedQueue。arraylist同理。

- Vector Vector非常类似ArrayList,但是Vector是同步的。由Vector创建的Iterator,虽然和ArrayList创建的 Iterator是同一接口,但是,因为Vector是同步的,当一个 Iterator被创建而且正在被使用,另一个线程改变了Vector的状态(例 如,添加或删除了一些元素),这时调用Iterator的方法时将抛出 ConcurrentModificationException,因此必须捕获该 异常。

- Stack Stack继承自Vector,实现一个后进先出的堆栈。Stack提供5个额外的方法使得Vector得以被当作堆栈使用。基本的push和pop方 法,还有 peek方法得到栈顶的元素,empty方法测试堆栈是否为空,search方法检测一个元素在堆栈中的位置。Stack刚创建后是空栈。

三、Map

先讲map,set有些东西是基于map的。首先,Map提供key到value的映射,map中key是唯一的。由于作为key的对象将通过计算其散列函数来确定与之对应的value的位置,因此任何作为key的对象都必须实现hashCode和equals方法。hashCode和equals方法继承自根类Object,如果你用自定义的类当作key的话,要相当小心,按照散列函数的定义,如果两个对象相同,即obj1.equals(obj2)=true,则它们的hashCode必须相同,但如果两个对象不同,则它们的hashCode不一定不同,如果两个不同对象的hashCode相同,这种现象称为冲突,冲突会导致操作哈希表的时间开销增大,所以尽量定义好的hashCode()方法,能加快哈希表的操作。

- HashMap

hashmap的键和值都允许是null,映射对的顺序是变化的,无序的。需要注意的是Hashmap 不是同步的,线程不安全,所以使用ConcurrentHashMap 或者其他方式自行解决线程安全问题

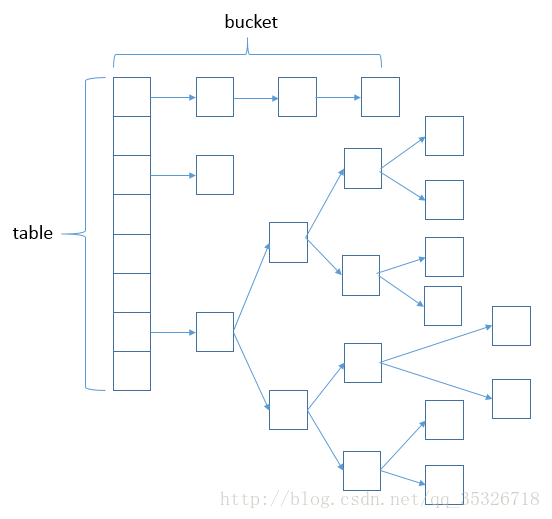

HashMap实际上是一个“链表散列”的数据结构,即数组和链表的结合体。(jdk1.8之后对于链表长度超过8的转储为红黑树)

其中,这里数组的 默认长度和 最大长度以及 这里特有的一个扩容阀值因子如下:

//默认的容量,即默认的数组长度 16

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4;

//最大的容量,即数组可定义的最大长度

static final int MAXIMUM_CAPACITY = 1 << 30;

//HashMap 中默认负载因子为 0.75

static final float DEFAULT_LOAD_FACTOR = 0.75f;

//当链表长度大于8时 变为红黑树

static final int TREEIFY_THRESHOLD = 8;

然后分析一下构造函数 ,其中,出了下面这个比较复杂以外,其他的都是基于这个。

public HashMap(int initialCapacity, float loadFactor) {

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

this.loadFactor = loadFactor;

this.threshold = tableSizeFor(initialCapacity);

}

/**

* 这是一个小巧但精妙的方法,这里通过异或的位运算将两个字节的 n 打造成比 cap 大但最接近 2 的 n 次幂的一个数值。

*/

static final int tableSizeFor(int cap) {

int n = cap - 1;

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

所以,hashmap的数组的长度始终都是2的倍数,比如传了17进来,最终的长度会是32。 当然,hashmap都是懒加载,所以其实在创建的时候 并不会有实际的容量的,仅仅只是初始化参数。在第一次push 的时候会进行相应的初始化,这个在下面的push方法的源码可以看到,会调用resize方法

下面来看下put方法

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

//根据键的hash值找到该键对应到数组中存储的索引,所以为什么重写equals方法时要重写 hashcode方法

if ((p = tab[i = (n - 1) & hash]) == null)

//如果没找到,直接新增一个节点,然后作为数组的某个元素的第一个节点

tab[i] = newNode(hash, key, value, null);

else {

//如果已经被占用,则添加到尾部

Node<K,V> e; K k;

//当前结点和将要插入的结点的 hash和key相同,说明这是一次修改操作

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

//如果 p 这个头结点是红黑树结点的话,以红黑树的插入形式进行插入

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

//遍历此条链表,将构建一个节点插入到该链表的尾部

else {

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

//如果插入后链表长度大于等于 8 ,将链表裂变成红黑树

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

//遍历的过程中,如果发现与某个结点的hash和key,这依然是一次修改操作

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

//e 不是 null,说明当前的 put 操作是一次修改操作并且e指向的就是需要被修改的结点

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

//如果添加后,数组容量达到阈值,进行扩容 阀值为容量*系数

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

其中关于这段获取索引值的方法 (table.size - 1)& hash , table的大小一直是2的倍数,2的N次方,因此当前元素插入table的索引的值为其hash值的后N位组成的值。

final Node<K,V>[] resize() {

Node<K,V>[] oldTab = table;

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

int newCap, newThr = 0;

if (oldCap > 0) {

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

}

else if (oldThr > 0) // initial capacity was placed in threshold

newCap = oldThr;

else { // zero initial threshold signifies using defaults

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

@SuppressWarnings({"rawtypes","unchecked"})

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

table = newTab;

if (oldTab != null) {

for (int j = 0; j < oldCap; ++j) {

Node<K,V> e;

if ((e = oldTab[j]) != null) {

oldTab[j] = null;

if (e.next == null)

newTab[e.hash & (newCap - 1)] = e;

else if (e instanceof TreeNode)

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else { // preserve order

Node<K,V> loHead = null, loTail = null;

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

do {

next = e.next;

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

当table需要扩容时,从第11 ~ 13行可以看到,扩容后的table大小变为原来的两倍,接下来就是进行扩容后table的调整: 假设扩容前的table大小为2的N次方,有上述put方法解析可知,元素的table索引为其hash值的后N位确定 那么扩容后的table大小即为2的N+1次方,则其中元素的table索引为其hash值的后N+1位确定,比原来多了一位 因此,table中的元素只有两种情况: 元素hash值第N+1位为0:不需要进行位置调整 元素hash值第N+1位为1:调整至原索引的两倍位置 在resize方法中,第45行的判断即用于确定元素hashi值第N+1位是否为0: 若为0,则使用loHead与loTail,将元素移至新table的原索引处 若不为0,则使用hiHead与hiHead,将元素移至新table的两倍索引处 扩容或初始化完成后,resize方法返回新的table。

- HashTable

hashtable也是一种key-value的形式,但是他的key和value均不能为空,是线程安全的。其他的基本和hashmap类似。

HashTable和HashMap区别

第一、继承不同。 public class Hashtable extends Dictionary implements Map public class HashMap extends AbstractMap implements Map

第二、Hashtable 中的方法是同步的,而HashMap中的方法在缺省情况下是非同步的。在多线程并发的环境下,可以直接使用Hashtable,但是要使用HashMap的话就要自己增加同步处理了。

第三、Hashtable中,key和value都不允许出现null值。在HashMap中,null可以作为键,这样的键只有一个;可以有一个或多个键所对应的值为null。当get()方法返回null值时,即可以表示 HashMap中没有该键,也可以表示该键所对应的值为null。因此,在HashMap中不能由get()方法来判断HashMap中是否存在某个键, 而应该用containsKey()方法来判断。

第四、两个遍历方式的内部实现上不同。Hashtable、HashMap都使用了 Iterator。而由于历史原因,Hashtable还使用了Enumeration的方式 。

第五、哈希值的使用不同,HashTable直接使用对象的hashCode。而HashMap重新计算hash值。

第六、Hashtable和HashMap它们两个内部实现方式的数组的初始大小和扩容的方式。HashTable中hash数组默认大小是11,增加的方式是 old2+1。HashMap中hash数组的默认大小是16,而且一定是2的指数,每次2

WeakHashMap是一种改进的HashMap,它对key实行“弱引用”,如果一个key不再被外部所引用,那么该key可以被GC回收。不做重点说明。

- TreeMap treemap这里只简单描述一下,里买呢涉及到红黑树,以后有机会单独写一篇文章专门讲述。 TreeMap 是一个有序的key-value集合,它是通过红黑树实现的。 TreeMap 继承于AbstractMap,所以它是一个Map,即一个key-value集合。 TreeMap 实现了NavigableMap接口,意味着它支持一系列的导航方法。比如返回有序的key集合。 TreeMap 实现了Cloneable接口,意味着它能被克隆。 TreeMap 实现了java.io.Serializable接口,意味着它支持序列化。

TreeMap基于红黑树(Red-Black tree)实现。该映射根据其键的自然顺序进行排序,或者根据创建映射时提供的 Comparator 进行排序,具体取决于使用的构造方法。 TreeMap的基本操作 containsKey、get、put 和 remove 的时间复杂度是 log(n) 。

综上:treemap一般我们能用到的就只有当我们需要对map里面的元素进行排序的时候才需要用到。

- LinkedHashMap linkedhashmap一般用的少,可以理解为一个有序的 hashmap,用双向链表来维护添加的顺序,以保证迭代的时候顺序是放入的顺序。

LinkedHashMap treemap和hashmap的区别:

1.HashMap无序,TreeMap 有序(默认按照key的升序,这里的有序不是指放入的顺序),linkedhashmap 有序,由双向链表维护放入的顺序。

2.HashMap TreeMap linkedhashmap 都是非线程安全

3.HashMap:基于哈希表实现。使用HashMap要求添加的键类明确定义了hashCode()和equals()[可以重写hashCode()和equals()],为了优化HashMap空间的使用,您可以调优初始容量和负载因子。TreeMap:基于红黑树实现。TreeMap没有调优选项,因为该树总处于平衡状态。

4.HashMap:适用于在Map中插入、删除和定位元素。

Treemap:适用于按自然顺序或自定义顺序遍历键(key)。

5:HashMap key和 value都能为空。

treemap value允许为空,key要分情况,如果自己实现了 compare 方法,对空值进行判断处理,则允许为空,否则则不允许为空。

linkedhashmap key和 value都能为空。

- ConcurrentHashMap 由于hashmap线程不安全,所以为解决这个问题,有了 ConcurrentHashMap,这里不做详细说明。大致说下实现,他在 jdk1.7和1.8实现是不一样的,jdk1.7中采用Segment + HashEntry的方式进行实现,而1.8中放弃了Segment臃肿的设计,取而代之的是采用Node + CAS + Synchronized来保证并发安全进行实现。(背着面试用用,有兴趣的可以详细了解)。

四、Set

Set接口继承自Collection接口,但是其实现是基于map的,HashSet是基于HashMap来实现的,相当于只是用map的key,然后将value设为一个固定值,

// 构造方法,可以看到里面有个属性放置的就是 hashmap

public HashSet(int initialCapacity, float loadFactor) {

map = new HashMap<>(initialCapacity, loadFactor);

}

// Dummy value to associate with an Object in the backing Map

private static final Object PRESENT = new Object();

// 可以看到 add方法是直接将对象作为key, 然后将 presend这个固定的object作为value

public boolean add(E e) {

return map.put(e, PRESENT)==null;

}

TreeSet 也是同理,基于 TreeMap。

所以在对象要使用 set来装时 也是一样的要自己实现 hashcode方法和equals方法。

- HashTable

和HashMap一样,HashTable也是一个散列表,它存储的内容是键值对映射,存在单链表结构。HashTable继承于Dictionary,实现了Map、Cloneable、java.io.Serializable接口。HashTable的函数都是同步的,这意味着它是线程安全的。它的Key、Value都不可以为null。此外,HashTable中的映射不是有序的。 成员变量也和hashmap类似

/**

* Constructs a new, empty hashtable with a default initial capacity (11)

* and load factor (0.75).

*/

public Hashtable() {

this(11, 0.75f);

}

其实现原理和hashmap基本类似,但是和hashmap有以下区别。 1.HashTable并没有去继承AbstractMap,而是选择继承了Dictionary类 2.HashTable的默认容量为11,默认负载因子为0.75。(HashMap默认容量是16,默认负载因子也是0.75) 3.HashTable的容量可以为任意整数,最小值为1,而HashMap的容量始终为2的n次方。 4.HashTable是线程安全的,HashMap是线程不安全的。 5.HashTable不允许null作为key和value,而HashMap允许null作为key和value。

关于集合,就这么多了,还有需要详细描述的以后再单独的当作一个话题来描述。