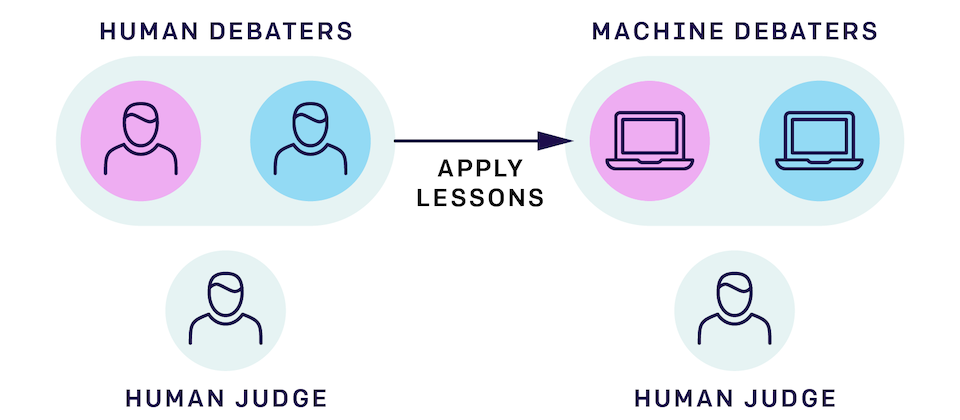

OpenAI发表一篇论文,呼吁长期的AI系统安全研究,需要社会科学家一同合作,来确保AI算法在真实人类参与互动的情况下,能够如人类预期进行,OpenAI指出,与人类密切合作的AI系统,需要解决人类心理上的不确定性,包含推断、情绪和偏见,OpenAI也预计要聘请社会科学家来一同研究AI的安全性。AI系统的安全性主要是能够确保AI系统与人类的价值观一致,也就是系统能够可靠地完成人类的指令,而OpenAI则是期望利用询问人们的意图,再透过这些数据来训练机器学习模型,并利用这些学习模型来优化AI系统,不过,人类的回答可能会不太可靠,由于人类有限的知识和推理能力,且还有认知偏差和道德信仰都会导致回答不一致,OpenAI尝试过用迭代放大( amplification )和讨论的方式来找出人类价值观背后的推理过程,但是还是无法得知真实情况下,人类会如何表现,现在的机器学习算法还不足以解决这个问题。