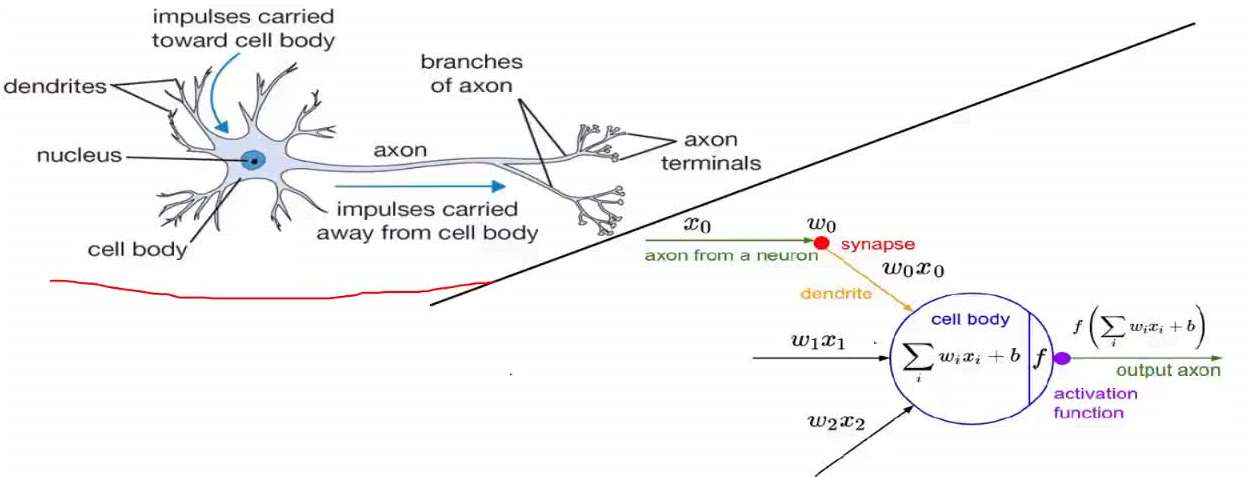

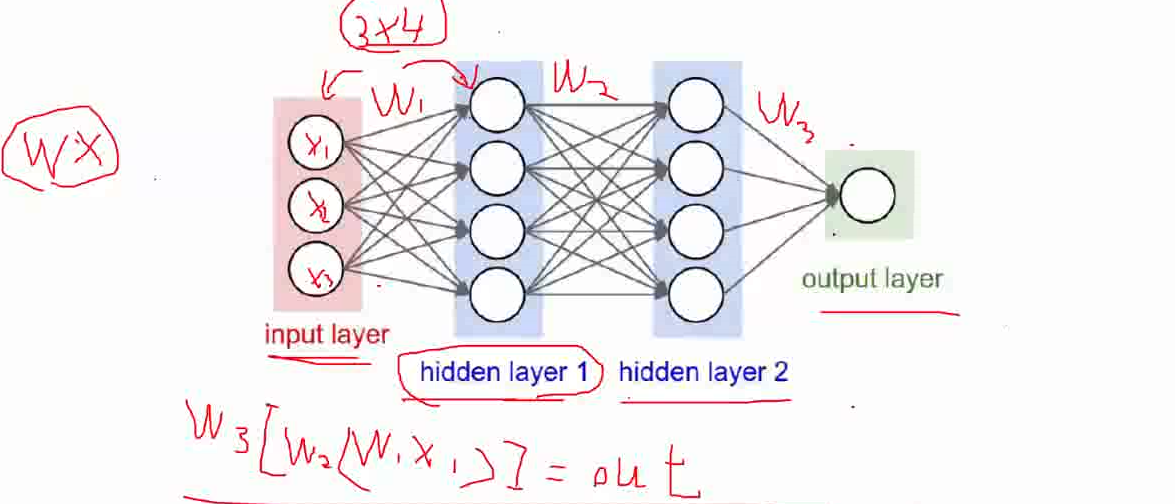

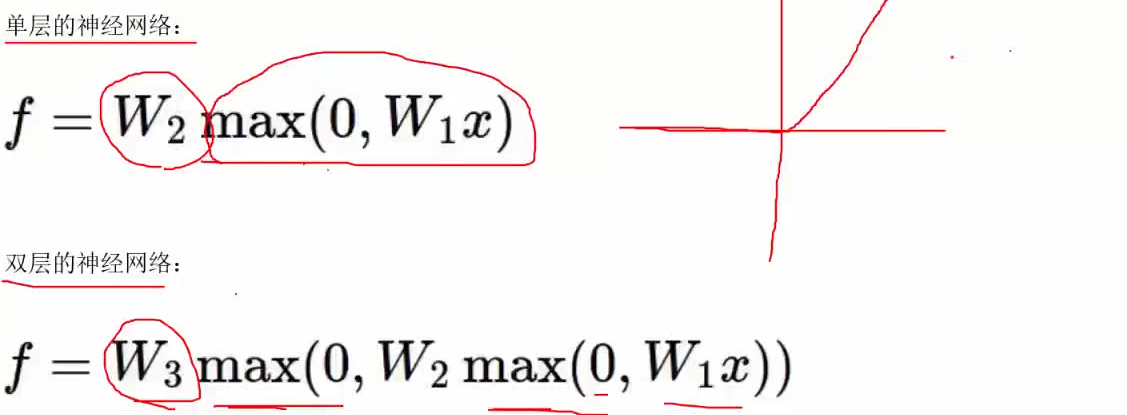

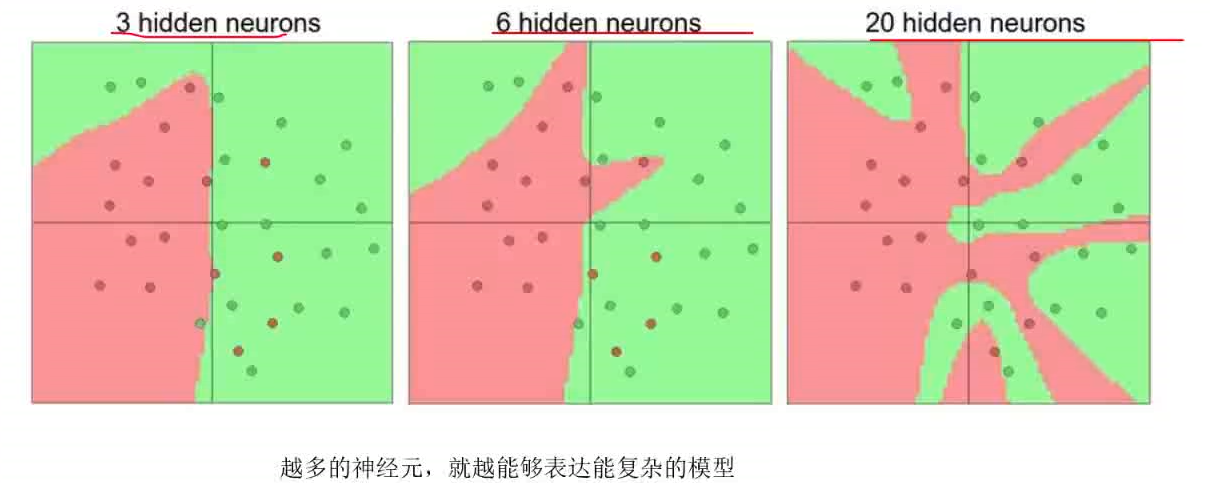

神经元就是模型中的权重参数

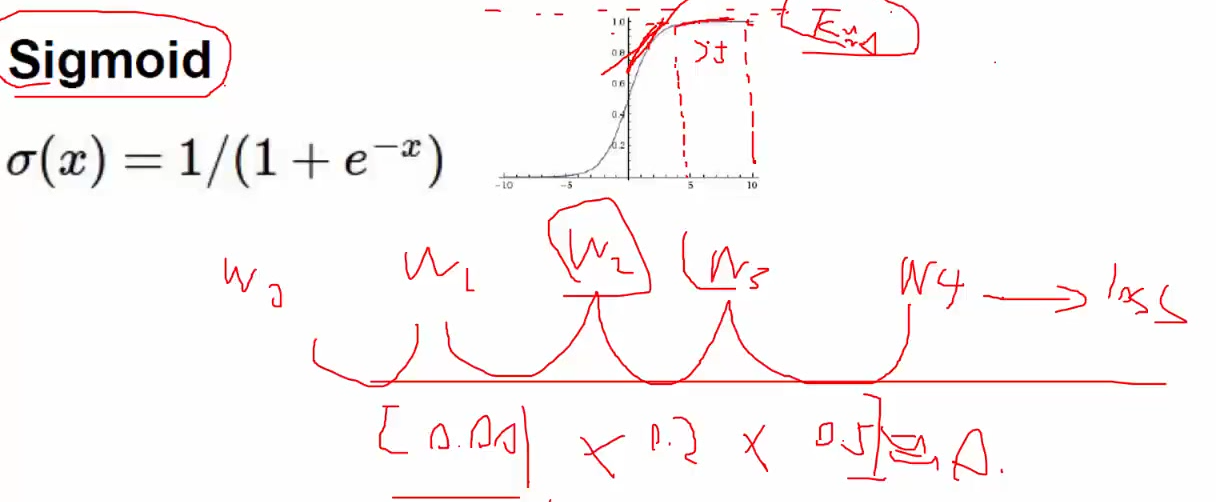

激活函数

Sigmoid当激活函数有没有什么问题?梯度是个累乘的过程,当Sigmoid的函数的输入值大于5的时候,它的导数会趋于0,这时根据链式求导法则在进行梯度累乘时会出现梯度消失的情况。当神经网络的层数比较多的时候非常容易发生梯度消失。 Sigmoid激活函数被遗弃的原因就在此。

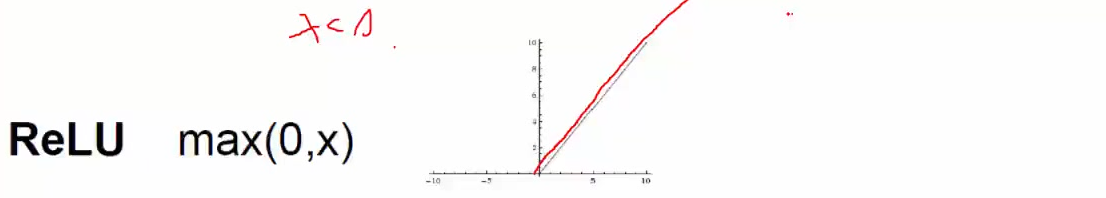

ReLU这个激活函数可以避免梯度消失的情况,也是现在神经网络中首选的激活函数。

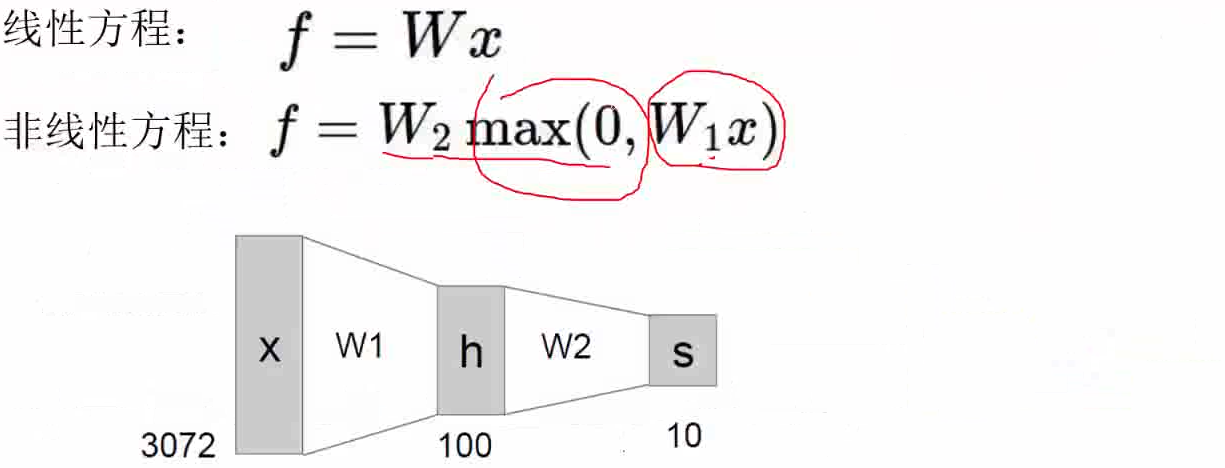

神经网络为什么不能替换传统的机器学习算法?

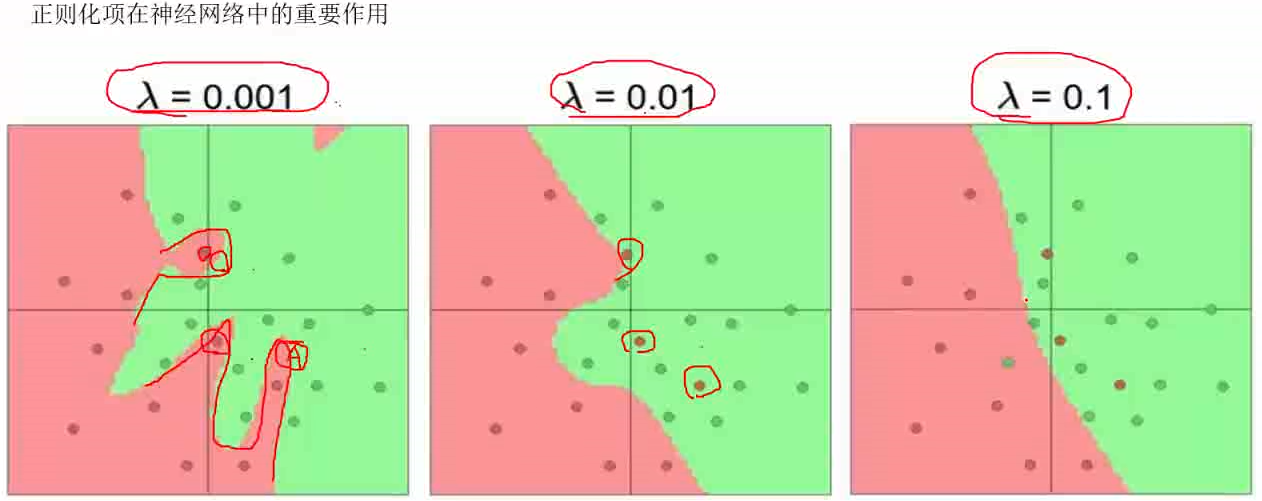

神经网络最大的问题是非常容易出现过拟合,这是神经网络最头痛的地方。

神经网络的权重W不具有解释性,神经网络的内部是个黑盒。

过拟合

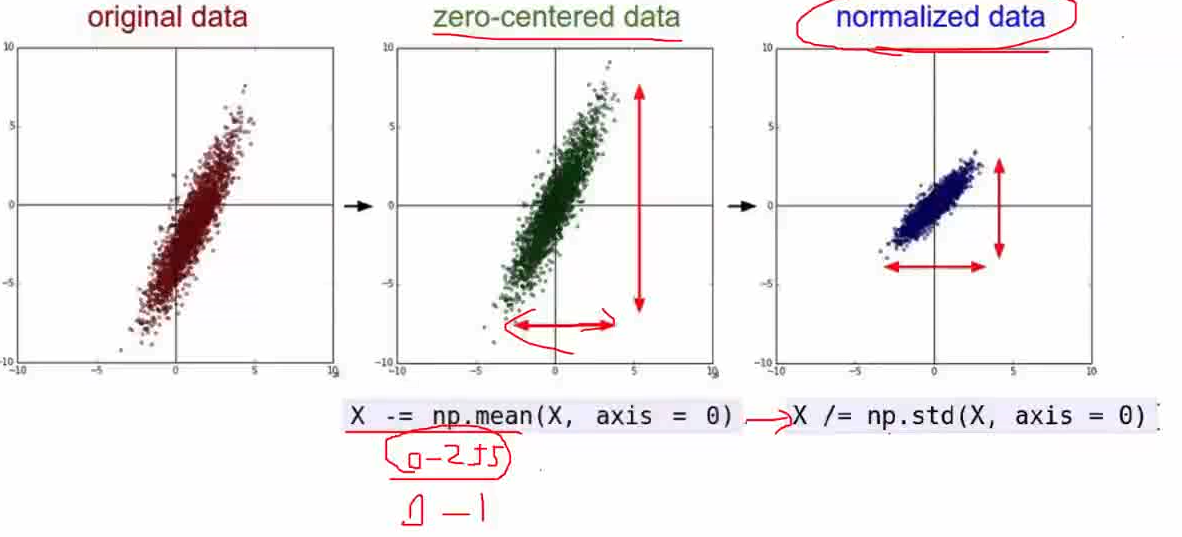

数据预处理

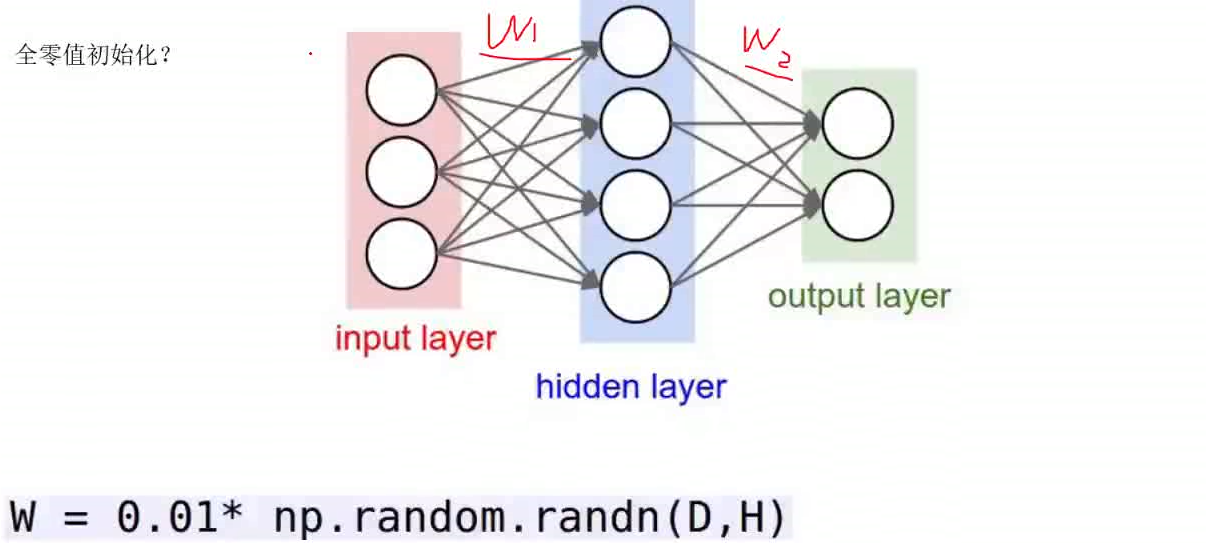

权重初始化

如果用0当初始值有木有什么问题?迭代一次后权重依然是0,白玩!!

采用的策略一般是随机初始化一些权重值。

偏置相b的初始化采用0值初始化就可以。

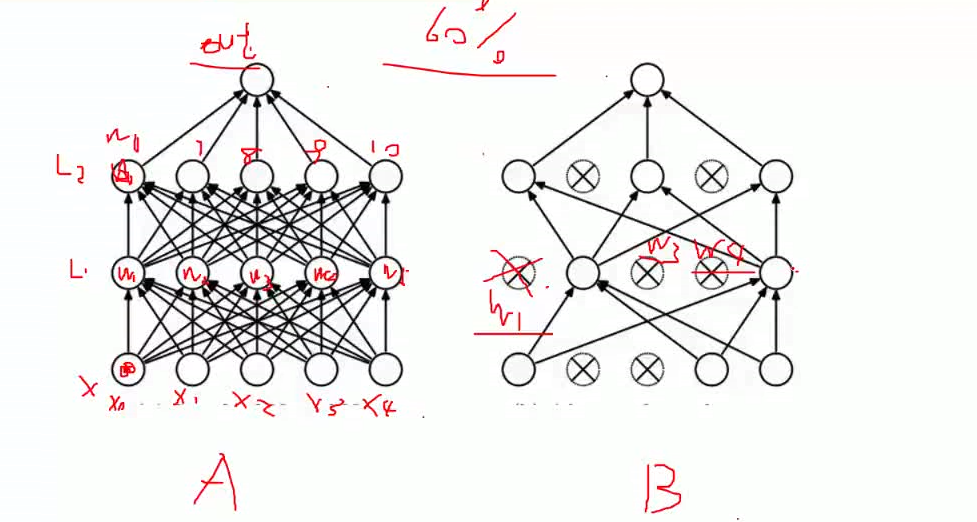

Drop-out

全部采用全连接层容易产生过拟合。

DROP-OUT在进行一次神经网络迭代的时候,可以随机屏蔽掉一些神经元。

DROP-OUT使得神经网络不会显得那么臃肿。

如果神经网络在训练的过程中没有出现过拟合现象,那这个模型是极有可能存在问题的。

DROP-OUT在数据量少的情况下,可以用迭代次数去弥补(上万次迭代)。