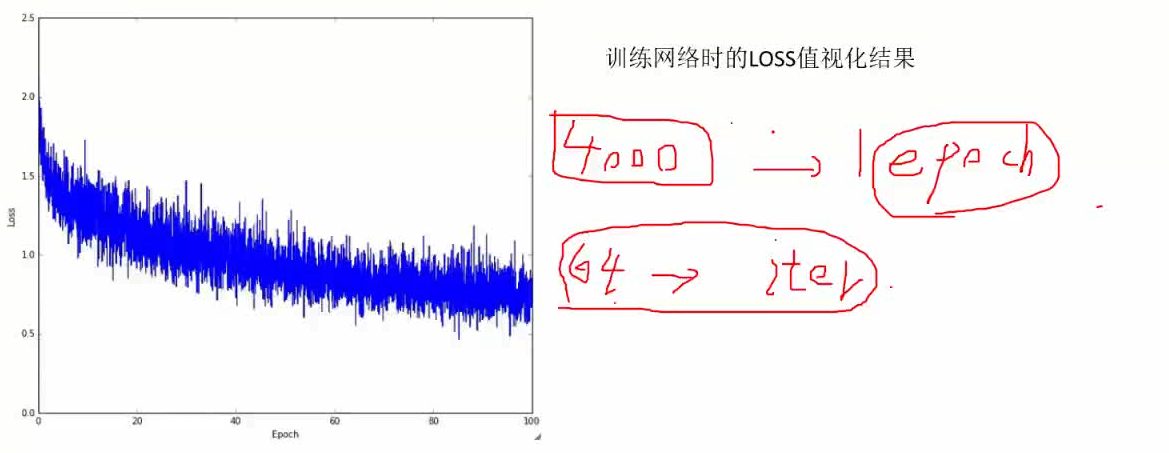

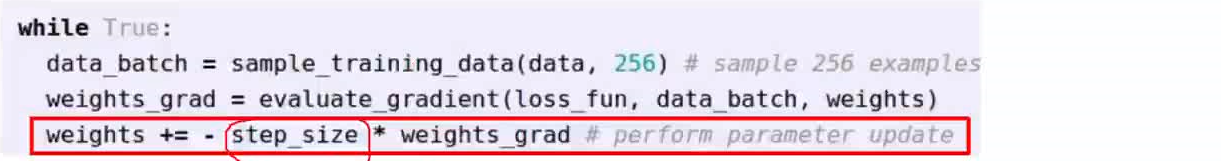

batchsize批处理的大小一般是2的整数倍(32,64,128),64和128居多。

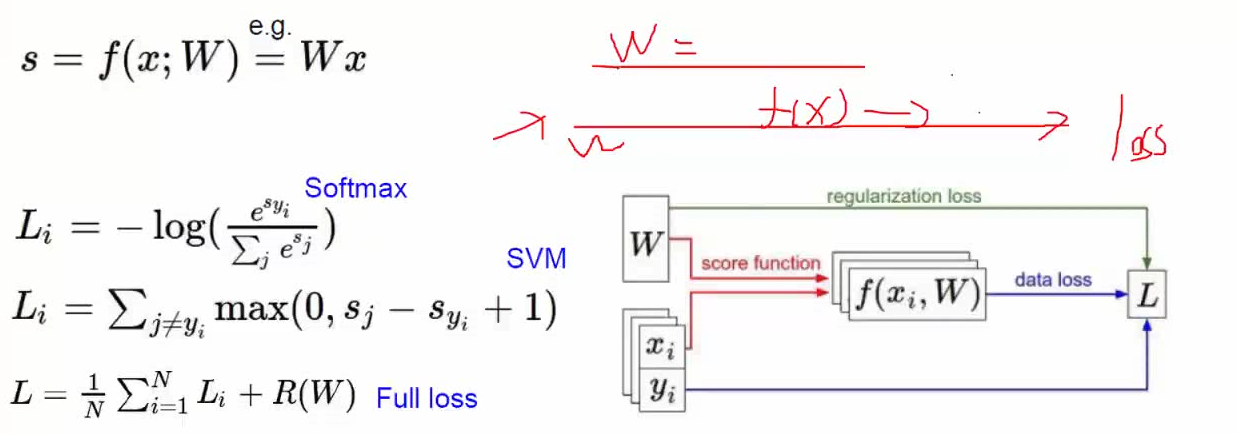

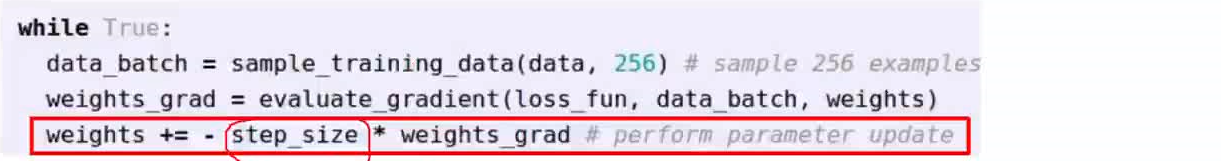

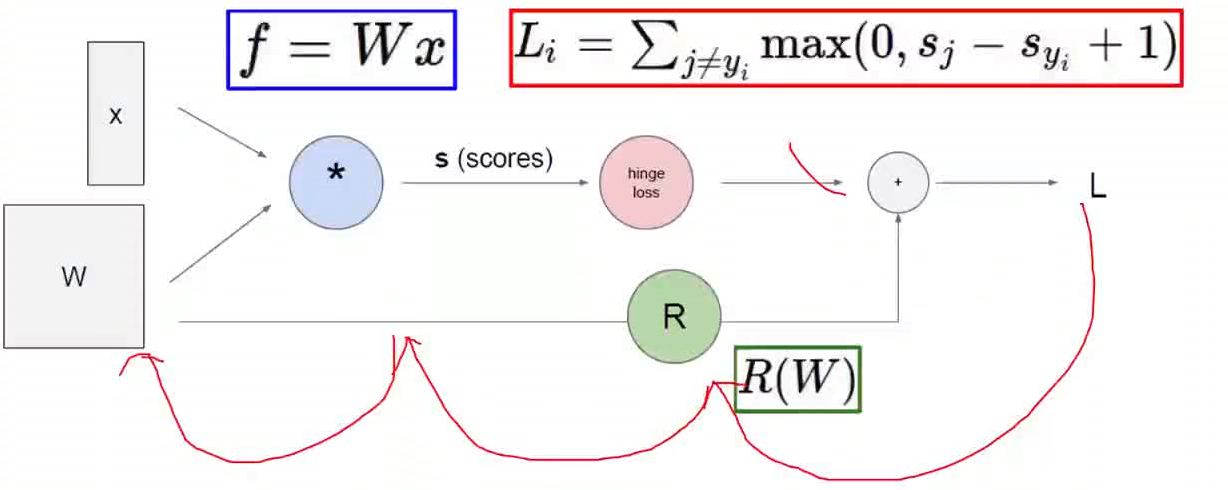

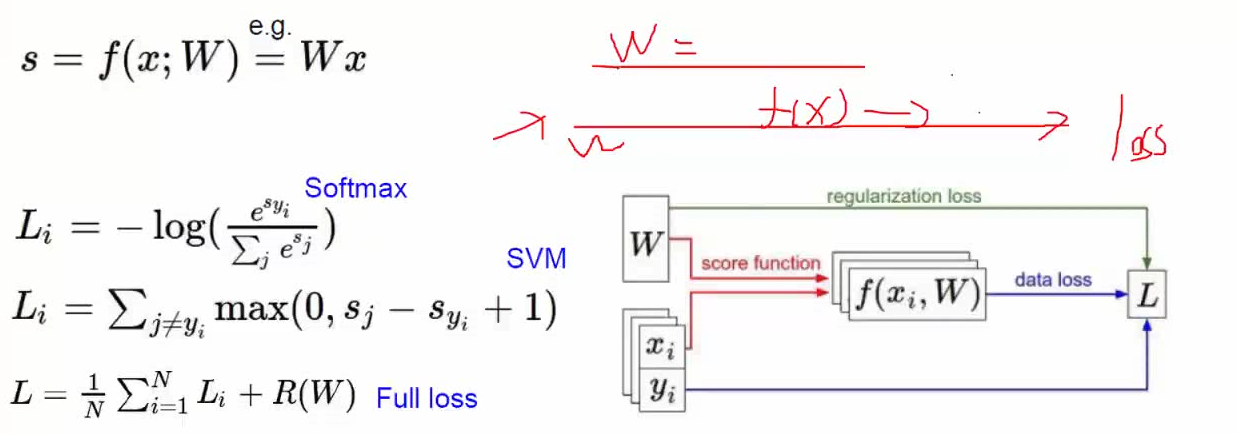

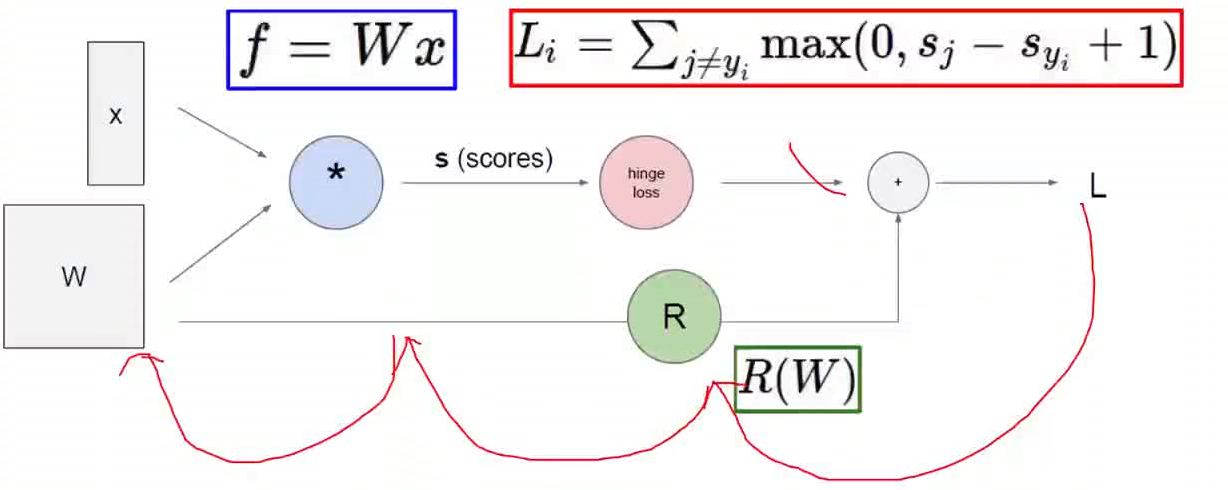

梯度下降

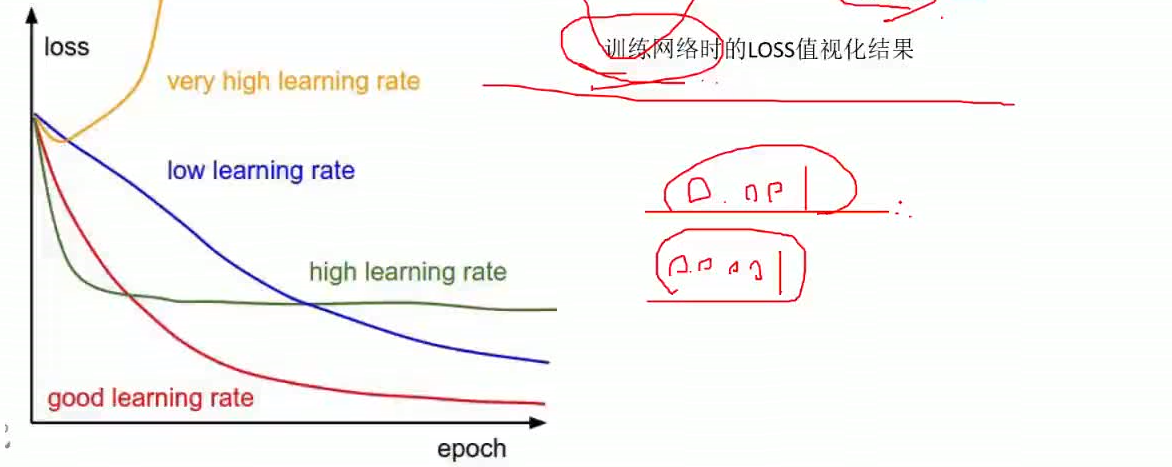

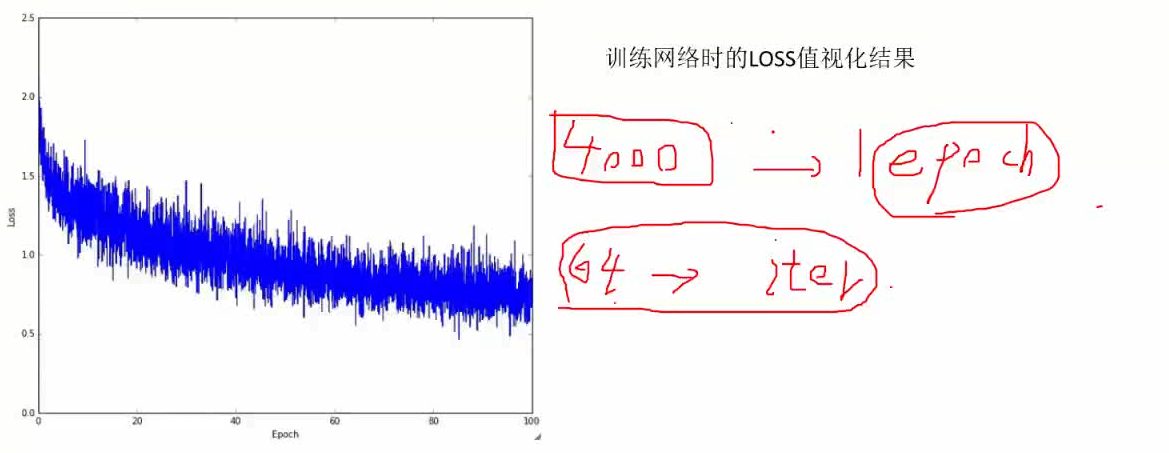

图中的loss出现上下浮动是非常正常的。通常情况下需要看第1万次,2万次,3万次迭代的效果。

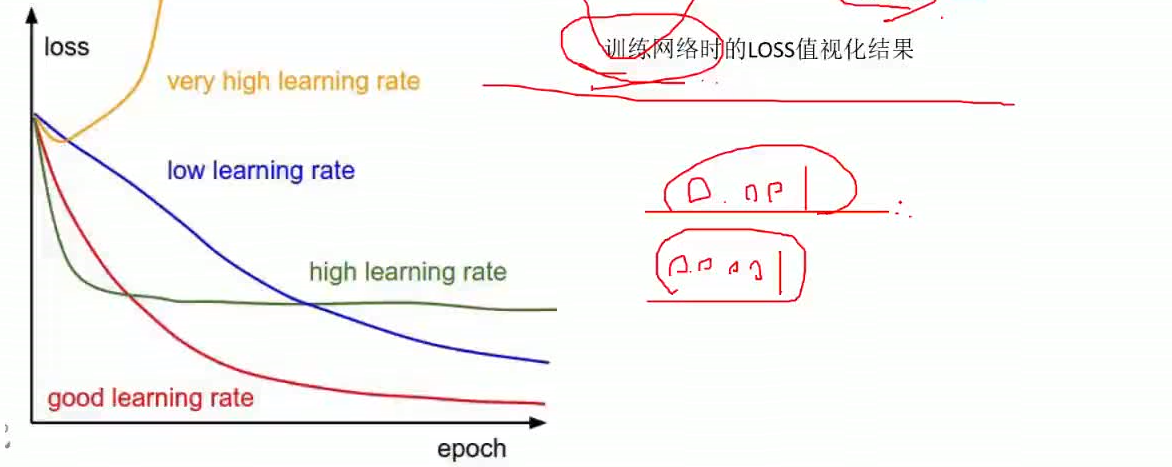

学习率

通常情况我们不会把学习率设置的太大,一般会设置的小一些比如:0.001,0.0001

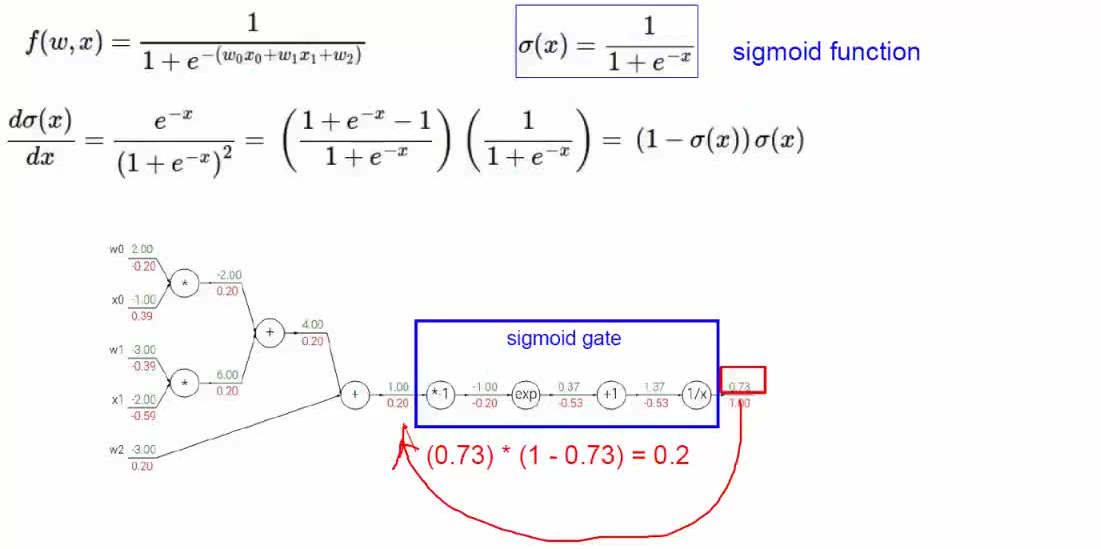

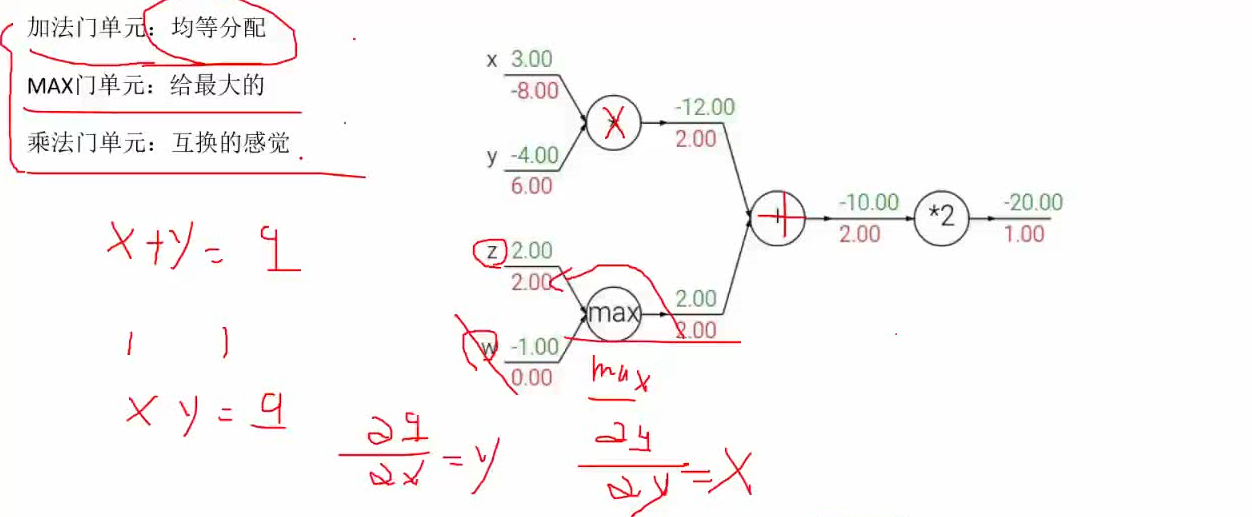

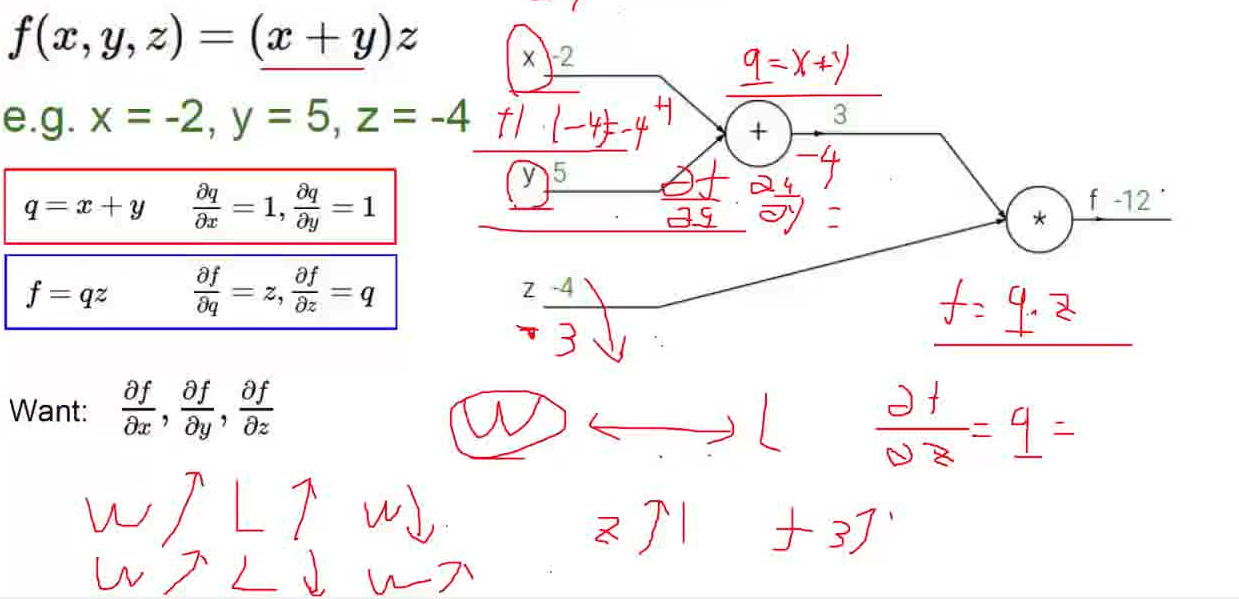

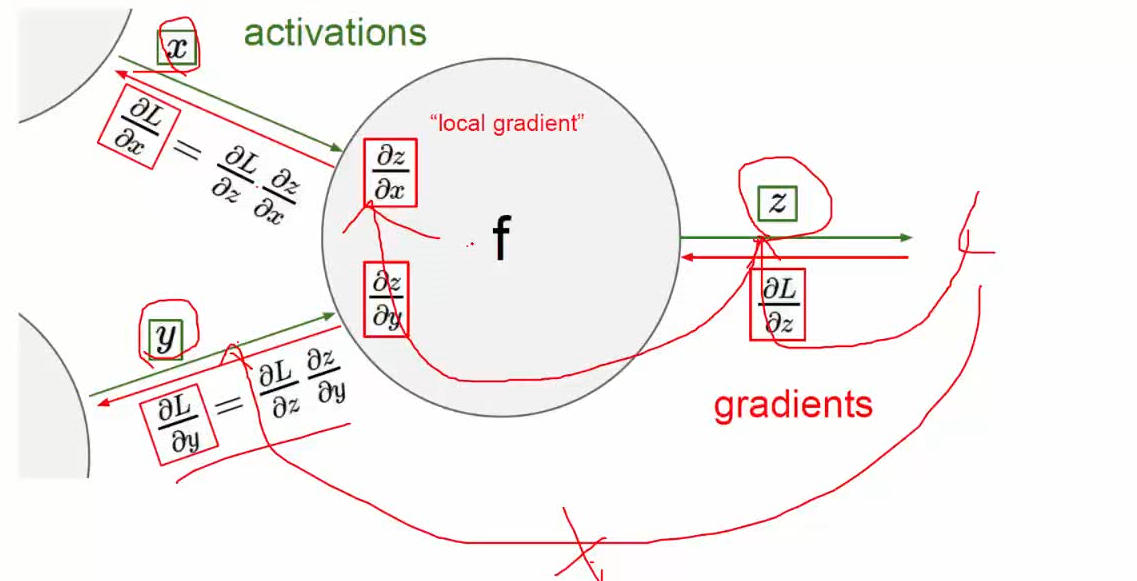

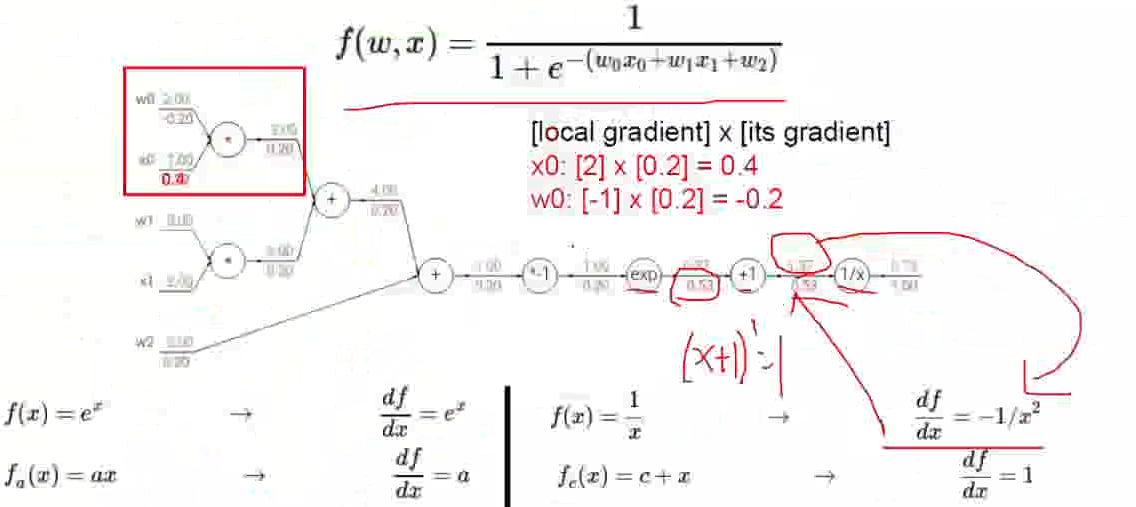

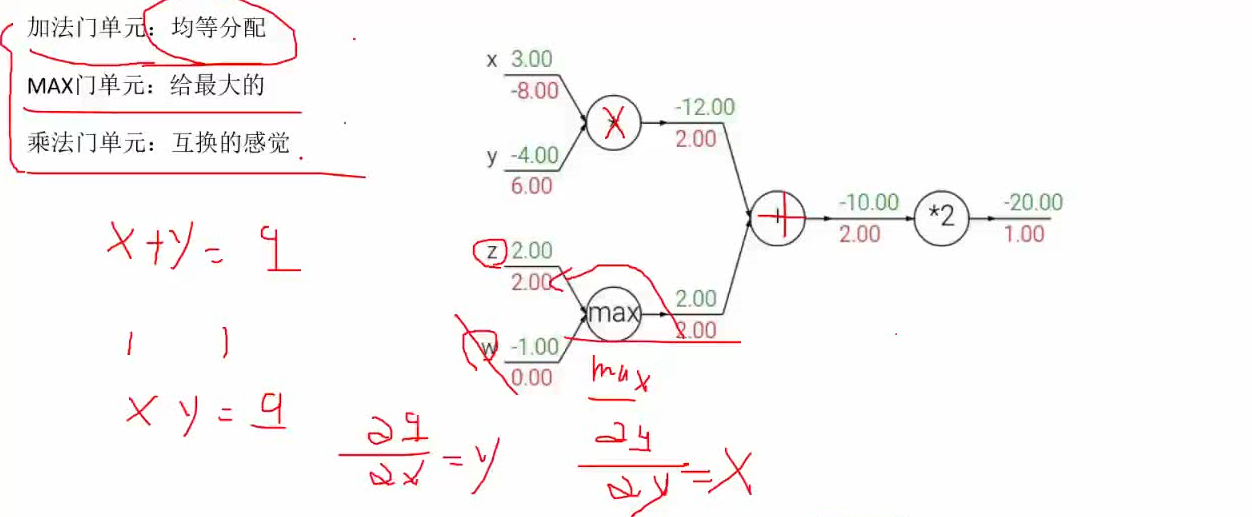

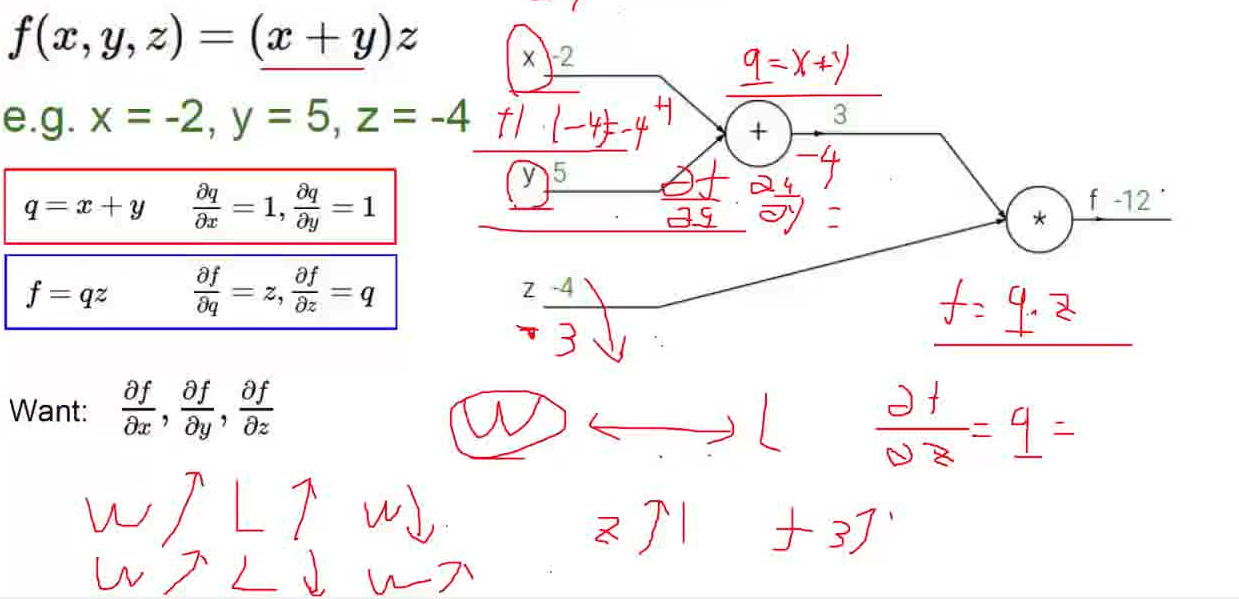

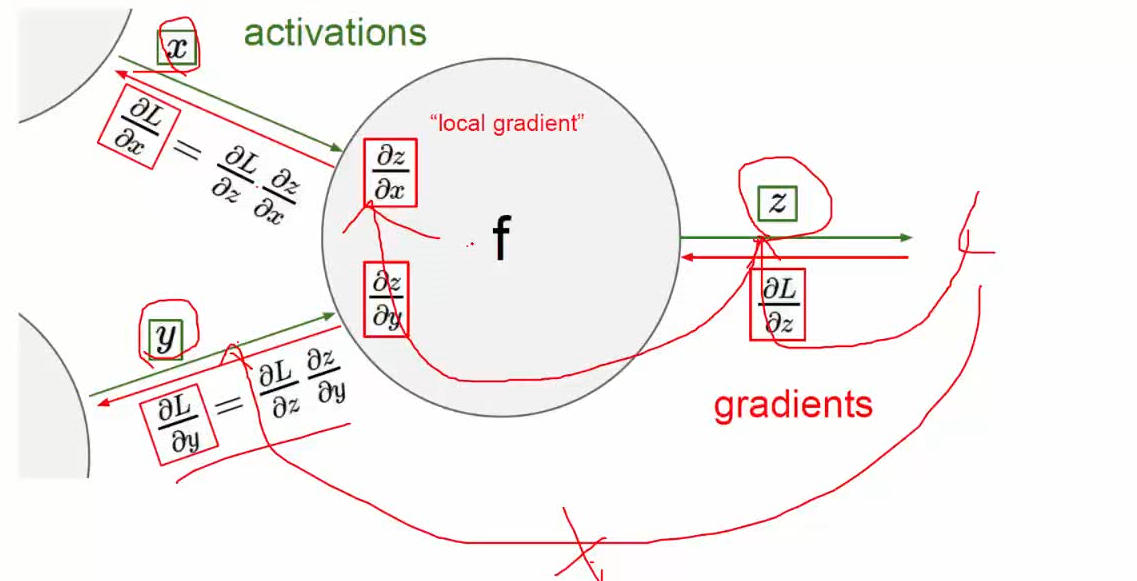

反向传播

这种一层层传播能不能得到优化?

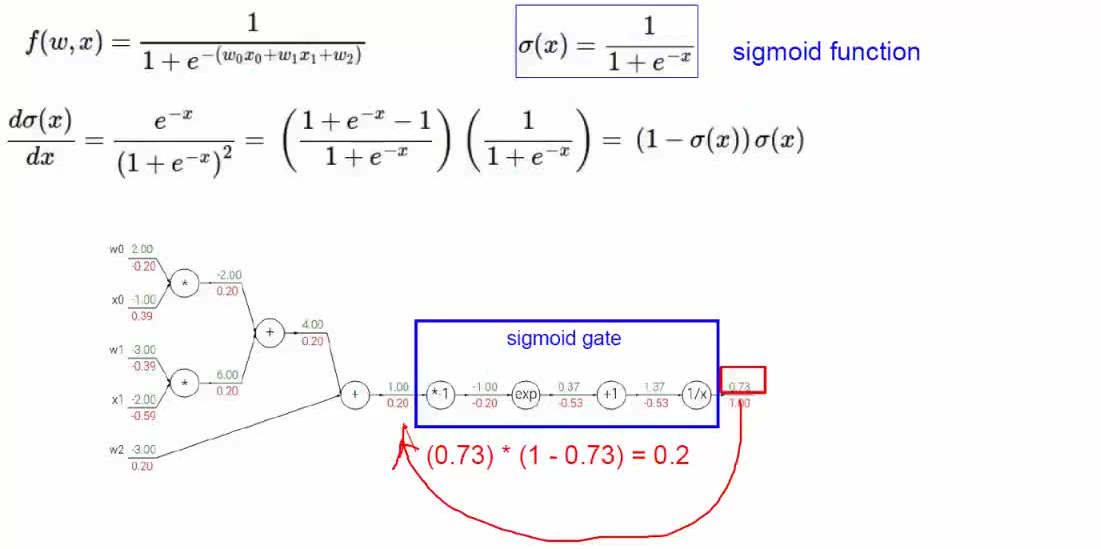

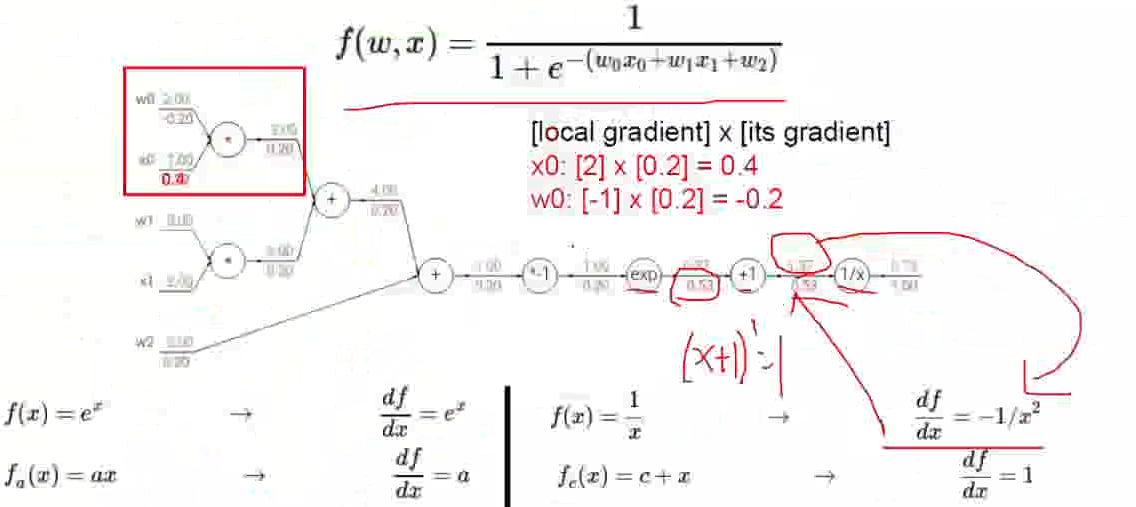

可以通过对Sigmoid函数整体求导。在反向传播的过程中能整体求导的就对其整体求导。

batchsize批处理的大小一般是2的整数倍(32,64,128),64和128居多。

通常情况我们不会把学习率设置的太大,一般会设置的小一些比如:0.001,0.0001

可以通过对Sigmoid函数整体求导。在反向传播的过程中能整体求导的就对其整体求导。