访问flyai.club,一键创建你的人工智能项目

这两天,被这篇BERT的paper刷屏了,这个横扫11项记录,"阅读理解超过人类"的模型到底是个啥?

BERT的全称是Bidirectional Encoder Representation from Transformers,即Transformer的双向编码表示来改进基于架构微调的方法。是一个语言表征模型(language representation model),通过超大数据、巨大模型、和极大的计算开销训练而成,在11个自然语言处理的任务中取得了最优(state-of-the-art, SOTA)结果。

简单来说,BERT 的作者认为,单向预测(unidirectional)及双向预测(bi-directional)均不能完整地理解整个语句的语义,更好的办法是用上下文全向来预测这样一来,可以同时启用多个聚焦点,不局限于从前往后,或者从后往前。而是使用两个新型无监督预测任务:

1.在一篇文章中随机遮盖15%的词汇,模型的任务是根据上下文正确的预测被遮盖的词,以此来初步训练模型的参数。

2.在一定数量的文章中随机挑选两种语句,一种是两句连续,另一种是不连续,让模型判断是否是连续语句来进一步修正参数。

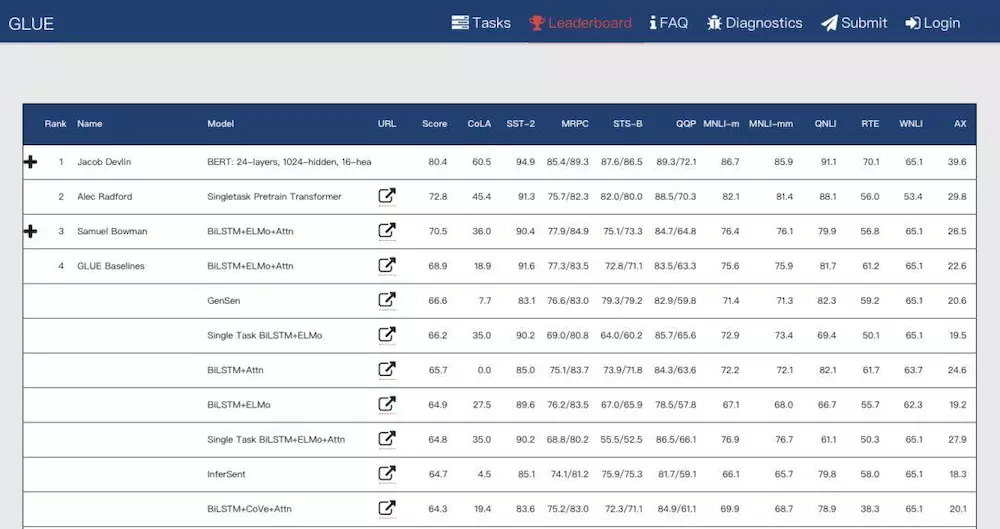

BERT已拔得头筹,来源:gluebenchmark.com

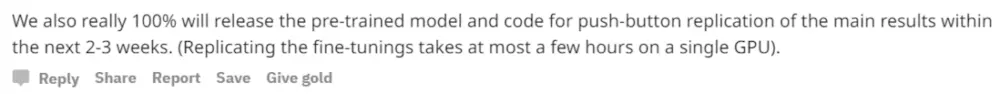

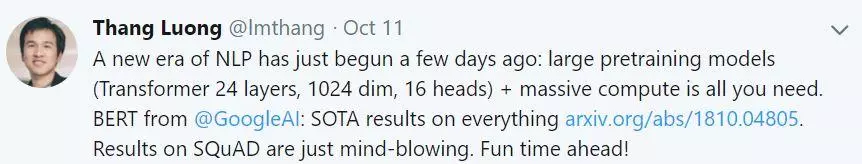

来源:reddit

接下来 Google 将发布全部经过预训练的模型和代码,我们将持续关注。

总的来说,Google 到底还是 Google,

Google is all you need.

NLP的新时代几天前才刚刚开始,Google团队的Thang Luong如是说

想要获取paper原文pdf,公众号后台回复 BERT 即可

教程 | Jupyter Notebook初级教程——迷死人的基础操作

教程 | Jupyter Notebook基础教程——快捷键的使用

教程 | Python之Numpy ndarray 基本介绍 1

教程 | Python之Numpy ndarray 基本介绍 2

教程 | Python之Numpy ndarray 基本介绍 3

教程 | Python之Numpy ndarray 基本介绍 4

点击阅读原文,了解更多

— End —