Google今天发布了TensorFlow Fold,利用动态计算图来解决因多个输入大小结构不同无法自然地批处理到一起,而导致的处理器、内存和高速缓存利用率差的问题。

你可能注意到了“动态”这两个字。

上个月,Facebook发布了开源深度学习框架PyTorch,让它广受赞誉的,便是“动态”这个特性。PyTorch采用动态计算图,比使用静态计算图的TensorFlow、Caffe、CNTK等框架更易于调试和推导,使用者在修改神经网络,比如说新加一层时,不需要像在其他框架中一样全部推倒重来。

当时,对PyTorch的溢美之词充满网络,我们甚至想知道Facebook此举能否撼动Google在深度学习框架领域的统治地位。

然而,云知声资深AI技术专家、NLP负责人刘升平博士对『量子位』表示,Beta阶段的PyTorch还缺乏一些关键特性,短期难以撼动TensorFlow的地位。另外,他还表示,框架的竞争还会继续下去。

(在公众号会话界面回复“框架战争”阅读我们对PyTorch的解读)

20天不到,TensorFlow已经追了上来。

“追上来”这种说法可能并不准确,在查看TensorFlow动态计算图的论文时,『量子位』发现这篇论文向ICLR提交的时间是2016年11月5日,比PyTorch发布还早了两个多月。可见“动态”是个好东西,它所带来的易用性,每个框架都想早早拥有。

在两家大公司先后涉足这一领域之前,就已经有很多“动态”深度学习库涌现出来,例如PyTorch的老师Chainer,卡内基梅隆大学的DyNet等。

接下来,我们看看Google官方对TensorFlow Fold的介绍。以下内容译自Google Research Blog,译者量子位+GNMT

在机器学习中,用于训练和推断的数据通常需要经过预处理环节,在这个环节中,多端输入的数据(例如图像)被缩放到相同的规格并堆叠成批。然后,TensorFlow这样的高性能深度学习库才能够在批处理的全部输入数据上并行运行相同的计算图。

批处理利用现代GPU和多核CPU的SIMD(单指令多数据)功能来加快执行速度。然而,在很多问题域中,输入数据的大小和结构都不同,诸如自然语言理解中的解析树,源代码中的抽象语法树,网页的DOM树等。在这些情况下,不同的输入具有不同的计算图,无法自然地批处理到一起,导致处理器、内存和高速缓存利用率都很差。

今天,我们发布了TensorFlow Fold来应对这些挑战。TensorFlow Fold使得对不同大小和结构的数据进行操作的深度模型更易于实现。此外,TensorFlow Fold为在这些模型中进行批处理带来了好处,与其他实现相比,CPU上运行的速度提高了10倍以上,GPU上提高了100倍。“动态批处理”使这些成为可能,我们在论文《带有动态计算图的深度学习》中有详细介绍。

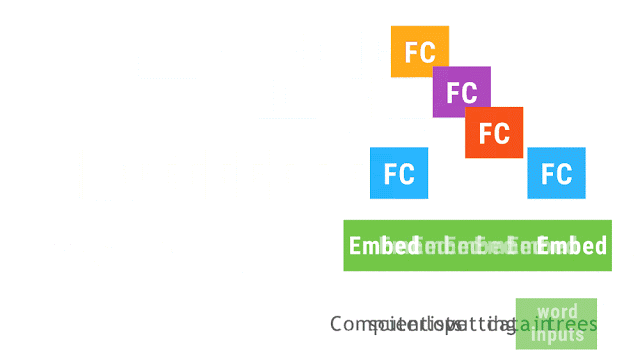

△ 此动画显示了使用了动态批处理的递归神经网络。相同颜色的操作分批在一起,这使TensorFlow能够更快地运行它们。Embed操作将单词转换为向量表示;完全连接(FC)操作组合字向量以形成短语的向量表示;网络的输出是整个句子的向量表示。尽管我们仅展示了句子的单个解析树,但是相同的网络可以在任意形状和大小的多个解析树上运行并对操作进行批处理。

TensorFlow Fold库最初将从每个输入构建单独的计算图。因为各个输入可能具有不同的大小和结构,计算图也一样。动态批处理随后自动组合这些计算图,以利用在输入内和输入之间进行批处理的机会,并插入附加指令以在批处理操作之间移动数据(参见我们的论文的技术细节)。

要了解更多,请访问我们的github网站。我们希望TensorFlow Fold对于在TensorFlow中使用动态计算图来实现神经网络的研究人员和从业者将是有用的。

论文地址:https://openreview.net/pdf?id=ryrGawqex

代码地址:https://github.com/tensorflow/fold

致谢

这项工作是在Peter Novig的监督下完成的。