神仙又打起来了:要不要继续做深度学习?

又吵起来了。

我说的是Gary Marcus,这位纽约大学的心理学和神经科学教授,日前在arXiv上传了一篇论文,列举深度学习十大局限[1],说DL其实并没有解决什么问题,引发了不小的讨论。

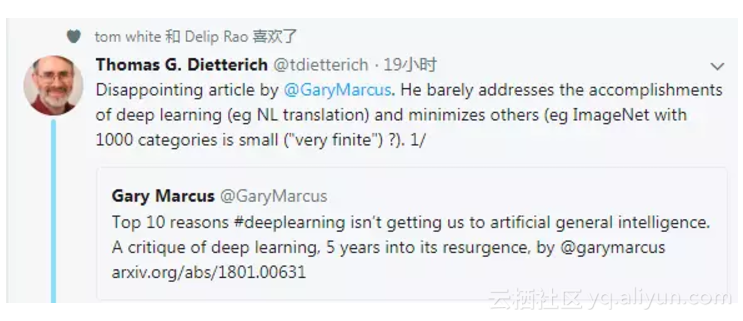

很快,著名机器学习专家、AAAI前主席Thomas Dietterich连发10条Twitter,一一驳斥Marcus列出的“十大罪状”,并且说Marcus的批评“十分令人失望”。

Marcus看到后,愤怒回应:

Dietterich混淆概念,误读我的观点,你等着,我接下来会写(偏技术的)文章进行回应!

对此,大神Yann LeCun甩下一句评论,拍到Marcus脸上——Tom(指Dietterich)说的实际上才是对的,你懂不懂啊。

为什么要关注这场争议?深度学习可以说是驱动最新一波人工智能热潮的关键,我们都知道它有用,但也十分清楚,它的理论根基还存在一些问题。

正如此前NIPS 2017“深度学习炼金术之争”讨论的那样,如果真的有其他方法可以达到深度学习模型的效果,而且具有更好的可解释性,那么很多研究人员将会再度弃深度学习而去。不过,现在这样的方法还不存在。

那么,要不要继续做深度学习?

正反双方“辩手”,还有积极保卫深度学习的LeCun

长期以来,Marcus作为认知心理学家,一直高调参与人工智能辩论,他创立的机器学习公司Geometric Intelligence被Uber收购。在个人也上,Marcus将自己称为“AI contrarian”。什么是“contrarian”?就是专门反对或批评流行观点的人。在这里案例中,所谓的“流行观点”,自然就是深度学习。

Marcus的研究和理论侧重于生物学与心理学的交叉。他在人类言语习得过程中,采取一种天赋主义的立场,认为AI研究人员需要去探讨在机器学习中嵌入先天机制会如何。Marcus也挑战连接主义理论,他认为心智(Mind)只是随机排列的神经元。

另一方面,Thomas Dietterich作为机器学习先驱,是国际机器学习学会IMLS创始会长。Dietterich并不是盲目支持深度学习的人,对于此前NIPS 2017闹得沸沸扬扬的“深度学习炼金术”之争,他实际上是站在将深度学习比作炼金术的Ali Rahimi这边。他告诉新智元,

我同意Rahimi所说的,我们需要更多的研究,包括实验研究和理论研究,重点提高我们对深度网络如何有用以及为什么有用的理解。

深度CNN在图像和语音任务中展现了卓越的性能,这很自然地催生了大量实验性的工作,人们希望将其应用到许多其他的问题当中。同时,这也吸引了很多没有接受过正式培训的人从事机器学习,包括学生和软件工程师。

在很多情况下,人们确实可以用深度网络来解决问题,但这都是在过度的试错和调参之后才实现的。这恰恰标志着领域的不成熟,作为一门科学不成熟,作为一门工程学科也不成熟。

Dietterich表示,尽管缺乏科学上的成熟度,但重要的是继续尝试不同的网络结构和新的任务,或者就像Rahimi说的那样,继续从事“炼金术”。但是,做实验来理解为什么我们的方法会有用也非常重要,因为这将帮助我们改进现有的方法。“了解系统的弱点也至关重要,因为投入实用的应用程序需要比当前纯深度学习解决方案更强大才行。”他说。

至于Yann LeCun,我相信不用多说。作为深度学习三大神之一,LeCun积极参与各种人工智能辩论,最近因为在NIPS上积极“保卫深度学习”,还被一些业内人士评价为“过于防守”,“没有安全感”。

实际上,LeCun以前也跟Marcus有过多次辩论,或许正因如此,他这次才懒得多说……

在这样的背景下,让我们来看看正反双方的观点。

深度学习十大局限?

新智元编译了Marcus论文中第三节“深度学习局限”里列出的10个问题,以及Diettrich的观点。了解更多可以根据文末链接,查看英文原文。

Thomas Dietterich:

1、Gary Marcus的文章令人失望。他几乎绝口不提深度学习取得的成就(例如自然语言翻译),并且最大限度地贬低了其他的成就(例如说有1000个类别ImageNet“非常有限”)。

2、DL不仅学习表示(representation),也学习映射(mapping)。深度机器翻译读取源语句,将其表示在memory中,然后生成输出语句。这种机制比以前的任何老式符号主义(GOFAI)的方法都要好

3、马库斯抱怨DL不能外插(extrapolate),但没有任何方法是可以外插的。从X到Y的外插似乎是使X和Y看起来相同的表示中的内插(interpolation)。逻辑推理相比联结主义方法更是这样。

4、DL能够比以前的任何学习方法更好地学习这样的表示。但是我认为,这些只是向学习更高层次抽象迈出的第一步,可以实现马库斯追求的“外插”。

5、我对最近在学习disentangled representations方面的工作感到兴奋,尤其是beta-VAE(ICLR2017),以及Achille和Soatto关于压缩和极小解缠的理论(arxiv1706.01350)。

6、我也对元学习(meta-learning)方法感兴趣,这些meta-learning方法反映在低层的深度学习表示上。也许它们将能够学习更高层次的抽象?

7、我相信,学习正确的抽象将解决马库斯提到的关键问题:数据饥饿,对抗样本的脆弱性,不能外插,缺乏透明度。

8、DL本质上是一种新的编程方式——“可微分编程”——而且这个领域正试图用这种方式来制定可重用的结构。DL还有:卷积,池化,LSTM,GAN,VAE,memory单元,routing单元等等。

9、但没有人认为我们已经有一个完整的集合。没有人知道可微分式编程的极限。但是这个领域在继续快速发展,理论认识也在提高。

10、我们当然需要更多的理论和更好的工程,同时也已经有很多很有前景的研究想法。

Gary Marcus:

1、深度学习缺少通过明确的、言语定义学习抽象概念的机制。目前的深度学习仍然需要大量数据,人类通过几次尝试就能学会抽象的关系,而且在学习时,既可以通过明确的定义(explicit definition),也可以通过更为隐含的手段(implicit means)。深度学习目前缺少通过明确的、言语定义学习抽象概念的机制,而且机器却必须经过成千上万的训练才能发挥最好效果。

2、深度学习并没有理解抽象的概念。DeepMind用深度强化学习玩“打砖块”游戏,但系统并不知道什么是隧道、什么是墙,它所学会的,只是特定场景下的一个特定动作。深度学习目前没有足够的能力进行迁移。

3、深度学习还不能自然地处理层级结构。当前大多数基于深度学习的语言模型,都将句子视为词的序列。在遇到陌生的句子结构时,循环神经网络(RNN)无法系统地展示句子的递归结构。深度学习习得的特征之间的关联是平面的,没有层级关系。

4、深度学习目前还无法进行开放式推理。系统无法理解“John promised Mary to leave”和“John promised to leave Mary”之间的细微差别,机器也就无法推断出谁要离开谁,或者接下来会发生什么。

5、深度学习还不够透明,神经网络的“黑箱”性质一直是过去几年人们讨论的重点。这个问题对于深度学习在金融交易、医学诊断上是致命的。

6、深度学习还没有很好地与先验知识相结合,部分原因是深度学习系统中表示的知识主要涉及特征之间的(很大程度上是不透明的)相关性,而不是像量化的陈述那样的抽象(例如,“人终有一死”)。深度学习适合的问题更多与分类有关,而与常识推理相关的问题几乎都超出了深度学习的解决范围。

7、目前,深度学习还无法区分因果关系和相关关系,粗略地说,深度学习学习输入和输出特征之间的复杂相关性,但没有内在的因果关系表示。例如,一个深度学习系统可以很容易地学习,在整个人口中,身高和词汇有相关关系的,但不太容易发现这种相关性来自人成长和词汇量发展(孩子们在学习更多的词汇的同时长得越来越高,但这并不意味着长高促使他们学习更多的单词,也不是学习新单词能够长高)。因果关系在人工智能的其他一些方法(Pearl,2000)中是关键要素,但深度学习很少有工作试图解决这个问题。

8、深度学习假设世界是大体稳定的,但实际并非如此。深度学习在高度稳定的世界中表现很好,例如“围棋”这类有固定规则的棋盘游戏,但在政治和经济等不断变化的系统中,深度学习的表现并不好。

9. 目前,深度学习只是一种近似,但其答案并不完全可信。前面也提到,深度学习系统在某个特定领域很大程度上表现是相当好的,但这个系统容易被欺骗。有很多研究揭示了这种脆弱性,例如错误地将停车标志识别为限速标志,将海龟识别为步枪。Szegedy等人(2013年)大概是第一个提出深度学习系统的“可欺骗性”的,但4年过去了,尽管有很多积极的研究,但没有得出可靠的解决方案。

10. 目前,深度学习很难在工程中使用。上面提出的所有问题指出的另一个事实是,用深度学习很难做强健的工程。正如谷歌工程师Peter Norvig(2016)指出的,机器学习仍然缺乏经典编程的渐进性,透明性和可调试性,在实现稳健性方面面临挑战。

原文发布时间为:2018-01-05

本文作者:文强

本文来自云栖社区合作伙伴新智元,了解相关信息可以关注“AI_era”微信公众号