一、概述

线性回归的数据如下所示:

D={(x1,y1),(x2,y2),⋯,(xN,yN)}xi∈Rp,yi∈R,i=1,2,⋯,NX=(x1,x1,⋯,xN)T=⎝⎛x1Tx2T⋮xNT⎠⎞=⎝⎛x11x21⋮xN1x12x22⋮xN2⋯⋯⋱⋯x1px2p⋮xNp⎠⎞N×pY=⎝⎛y1y2⋮yN⎠⎞N×1

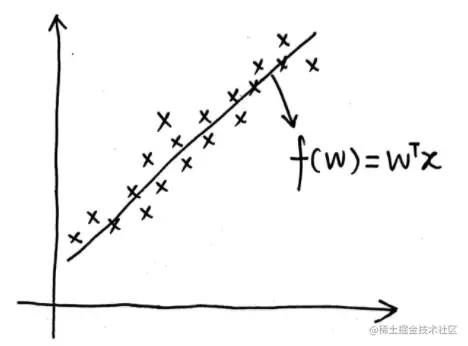

对于线性回归问题,假设:

f(x)=wTxy=f(x)+εε∼N(0,σ2)

其中w是参数,ε是噪声。以二维的数据为例,其图像如下:

从几何角度出发求解线性回归问题,可以使用最小二乘估计(Least Square Estimate,LSE),而从概率角度来看也就是噪声为高斯分布的极大似然估计(Maximum Likelihood Estimate,MLE),公式为:

wMLE=wargmaxP(Data∣w)

为了防止过拟合的问题,采用了正则化的最小二乘估计的方法,包括Lasso正则化和Ridge正则化两种方式,这种方法从概率角度来看也就是最大后验估计(Maximum a Posteriori Estimation,MAP),其噪声也是高斯分布,这里参数w的后验满足:

P(w∣Data)∝P(Data∣w)⋅P(w)

因此最大后验估计的公式也就是:

wMAP=wargmaxP(w∣Data)=wargmaxP(Data∣w)⋅P(w)

这里的P(w)也就是参数w的先验,如果P(w)服从高斯分布,则对应Lasso正则化,如果P(w)服从拉普拉斯分布,则对应Ridge正则化。

对于上述方法的详细解释,可以参考链接:线性回归 。

上述方法都是点估计方法,而在贝叶斯线性回归中我们希望利用贝叶斯学派的方法来求解出后验概率分布P(w∣Data)。

二、推断与预测

1.推断

贝叶斯线性回归的推断(Inference)任务也就是求解参数w的后验分布P(w∣Data)。首先,进行以下变换:

P(w∣Data)=P(w∣X,Y)=P(Y∣X)P(w,Y∣X)=∫P(Y∣w,X)⋅P(w∣X)dwP(Y∣w,X)⋅P(w∣X)

对于上面得到的式子,分子中P(Y∣w,X)相当于似然,P(w∣X)也就是先验P(w)(因为w和X没有关系),另外分母是一个常数,因此我们可以得到:

P(w∣Data)∝P(Y∣w,X)⋅P(w)

对于似然P(Y∣w,X),由于之前定义的y和x之间的关系是一个线性高斯模型,因此可以得到:

P(Y∣w,X)=i=1∏NP(yi∣w,xi)=i=1∏NN(yi∣wTxi,σ2)

对于先验P(w),是人为指定的,只要合理就可以任意给定这个分布,通常我们选择高斯分布,注意这里是一个多维的高斯分布,我们选择的高斯分布均值为0,方差矩阵用Σp来表示:

P(w)=N(0,Σp)

因此也就得到:

P(w∣Data)∝i=1∏NN(yi∣wTxi,σ2)⋅N(0,Σp)

由于似然P(Y∣w,X)和先验P(w)都是高斯分布,利用共轭的知识(高斯分布是自共轭的),我们也可以得到P(w∣Data)也是一个高斯分布,推断任务也就是求解这个高斯分布的均值和方差,我们用μw和Σw来表示这个高斯分布的均值和方差:

P(w∣Data)∼N(μw,Σw)

将似然P(Y∣w,X)做进一步的变换,我们可以得到这个概率的均值和方差:

P(Y∣w,X)=i=1∏N(2π)1/2σ1exp{−2σ21(yi−wTxi)2}=(2π)N/2σN1exp{−2σ21i=1∑N(yi−wTxi)2}

上式中红色的部分可以写成矩阵相乘的形式:

i=1∑N(yi−wTxi)2=YT−wTXT(y1−wTx1y2−wTx2⋯yN−wTxN)⎝⎛y1−wTx1y2−wTx2⋮yN−wTxN⎠⎞=(YT−wTXT)(Y−Xw)=(Y−Xw)T(Y−Xw)

因此也就有:

P(Y∣w,X)=(2π)N/2σN1exp{−2σ21i=1∑N(yi−wTxi)2}=(2π)N/2σN1exp{−2σ21(Y−Xw)T(Y−Xw)}=(2π)N/2σN1exp{−21(Y−Xw)Tσ−2I(Y−Xw)}=N(Xw,σ2I)

至此似然P(Y∣w,X)就表示成了标准的高斯分布的形式,代入后验中我们可以得到:

P(w∣Data)∝N(Xw,σ2I)⋅N(0,Σp)∝exp{−21(Y−Xw)Tσ−2I(Y−Xw)}⋅exp{−21wTΣp−1w}=exp{−2σ21(Y−Xw)T(Y−Xw)−21wTΣp−1w}=exp{−2σ21(YTY−2YTXw+wTXTXw)−21wTΣp−1w}

对于上面的式子我们可以写出它的指数的关于w的二次项和一次项:

二次项:−2σ21wTXTXw−21wTΣp−1w=−21wT(σ−2XTX+Σp−1)w一次项:−2σ21(−2YTXw)=σ−2YTXw

对于一个多维的高斯分布的指数部分,将其展开可以得到:

exp{−21(X−μ)TΣ−1(X−μ)}=exp{−21(XTΣ−1−μTΣ−1)(X−μ)}=exp⎩⎨⎧−21(二次项XTΣ−1X一次项−2μTΣ−1X+μTΣ−1μ)⎭⎬⎫

而这里的有关于X的二次项和一次项为:

二次项:−21XTΣ−1X一次项:μTΣ−1X

通过二次项也就可以得到后验P(w∣Data)的精度矩阵Λw(这是一个对称矩阵):

Λw=Σw−1=σ−2XTX+Σp−1

由一次项可以得出:

μwTΣw−1=μwTΛw=σ−2YTX⇒Λwμw=σ−2XTY⇒μw=σ−2Λw−1XTY

如此我们最终就求得了后验P(w∣Data)的均值和方差:

μw=σ−2Λw−1XTYΣw=Λw−1其中Λw=σ−2XTX+Σp−1

2.预测

预测(Prediction)问题是利用已经求解出来的贝叶斯线性回归模型,在给定x∗的前提下,求解y∗。要注意,由于这里的w服从后验分布P(w∣Data),因此需要求解的是分布P(y∗∣Data,x∗)。

首先对于f(x∗),有f(x∗)=(x∗)Tw,而w服从后验分布N(μw,Σw),x∗可以看做一个常数,因此就有:

f(x∗)=(x∗)Tw∼N((x∗)Tμw,(x∗)TΣwx∗)

另外有y∗=f(x∗)+ε,ε∼N(0,σ2),因此就有(两个高斯分布随机变量相加后的概率分布相当于将两个高斯分布的均值和方差均相加得到的高斯分布):

P(y∗∣Data,x∗)=N((x∗)Tμw,(x∗)TΣwx∗+σ2)

综合一下,具体的过程为:

P(y∗∣Data,x∗)=∫wP(y∗∣w,X,Y,x∗)P(w∣X,Y,x∗)dw=∫wP(y∗∣w,x∗)P(w∣X,Y)dw=N((x∗)Tμw,(x∗)TΣwx∗+σ2)

三、总结

本文是从贝叶斯的角度解释线性回归,可以发现,在数学的世界中,虽然可能每一派对方法的定义不同,但道路殊途同归,工具是用来解决问题的,各有各的好坏之分。

频率主义方法解决了这个问题,但忽略了一些关键信息;答案的不确定性,但是我们看到贝叶斯方法不仅会给出最可能的答案,还会告诉我们这个答案的不确定程度。

“本文正在参加 人工智能创作者扶持计划”