最近(确切地说是昨天),有人发布了使用深度学习技术进行文本翻译的 Python 库,调用起来非常方便,基于 Facebook AI 提出的多语种翻译模型,支持 50 种语言,简直是文字工作者的福音,我立马上去查看了一下,写了篇文章,来帮助大家使用。

注意:使用它可能不需要对深度学习有所了解,但是需要了解基础的 Python 知识。

使用方式

安装

安装它非常简单,只需要执行这行代码:

pip install dl-translate

但是建议新建一个环境安装,该库基于最新版的 PyTorch,没有在别的版本上测试。为了不扰乱系统内的环境(懂的都懂),还是新建一个环境比较好。

conda create -n torch1.8 python=3.8

conda activate torch1.8

pip install dl-translate

使用

官方指南中给出的使用代码,只有四行,就能完成翻译,非常的方便:

import dl_translate as dlt

mt = dlt.TranslationModel() # 定义模型

text_hi = "संयुक्त राष्ट्र के प्रमुख का कहना है कि सीरिया में कोई सैन्य समाधान नहीं है"

mt.translate(text_hi, source=dlt.lang.HINDI, target=dlt.lang.ENGLISH)

注意第一次使用需要下载模型,可能会比较慢,因为模型支持翻译 50 种语言,所以模型非常大, 有 2.3G 。如果需要的话,我可以帮助大家下载下来传到百度网盘。

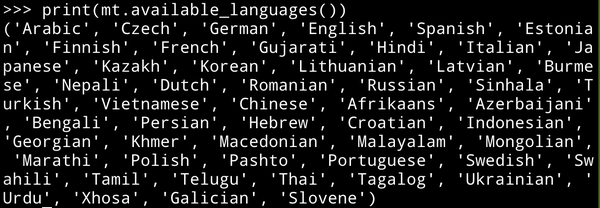

查看模型支持的语言:

对于比较长的一段话,翻译起来可能非常慢,所以建议先将它分为句子的形式,然后再一句一句翻译,对于英文,可以使用 nltk 包进行分句,然后将各个句子的翻译结果合并起来。

import nltk

nltk.download("punkt")

text = "Mr. Smith went to his favorite cafe. There, he met his friend Dr. Doe."

sents = nltk.tokenize.sent_tokenize(text, "english") # don't use dlt.lang.ENGLISH

" ".join(mt.translate(sents, source=dlt.lang.ENGLISH, target=dlt.lang.FRENCH))

批量翻译

在翻译过程中,我们可以利用 GPU 并行计算的优势进行翻译,调整 batch_size,当然前提是你的 GPU 能放得下这么多句子。

...

mt = dlt.TranslationModel()

mt.translate(text, source, target, batch_size=32, verbose=True)

这里的输入 text ,既可以是一个字符串列表,也可以是一个单独的字符串,都会给出对应的结果。

性能测试

因为这个模型非常大,我所用的 GPU (2080ti)放不下这么大的模型,所以以下测试基于 CPU,有条件使用 GPU 的话速度按理说会快不少。在测试中,我将这句话翻译了100遍,来统计所用时间:

Many technical approaches have been proposed for ensuring that decisions made by AI systems are fair, but few of these methods have been applied in real-world settings.

它对应的谷歌翻译的效果:

已经提出了许多技术方法来确保AI系统做出的决策是公平的,但是这些方法中很少有在现实环境中应用的。

测试所用代码:

import dl_translate as dlt

import time

from tqdm import tqdm

time_s = time.time()

mt = dlt.TranslationModel(model_options=dict(cache_dir="./")) # Slow when you load it for the first time

time_e = time.time()

time_takes = time_e - time_s

print("Loading model takes {:.2f} seconds".format(time_e - time_s))

text_english = "Many technical approaches have been proposed for ensuring that decisions made by AI systems are fair, but few of these methods have been applied in real-world settings."

text_chinese = mt.translate(text_english, source=dlt.lang.ENGLISH, target=dlt.lang.CHINESE)

print(text_chinese)

time_s = time.time()

texts = [text_english for i in range(100)]

for t in tqdm(texts):

mt.translate(t, source=dlt.lang.ENGLISH, target=dlt.lang.CHINESE)

time_e = time.time()

print("It takes {:.2f} seconds to translate 100 sentences, with an average of {:.2f} seconds each.".format(t ime_e - time_s, (time_e - time_s) / 100))

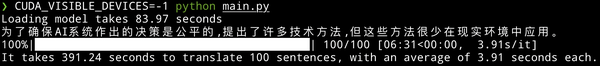

测试结果:

可以看到,加载模型花费了将近一分半的时间,翻译一句有 27 个词的英文,要花费约 4 秒的时间,这个时间很大程度上依赖于句子的长度。虽然翻译的结果和谷歌翻译的比起来,不够自然,但是对于一个能够离线使用的翻译器来说已经够好了。

参考链接:

- dl-translate:github.com/xhlulu/dl-t…

- 使用指南:xinghanlu.com/dl-translat…

- mBART50 模型 :huggingface.co/facebook/mb…

- 背后的论文:Multilingual Translation with Extensible Multilingual Pretraining and Finetuning

写在最后:如果觉得这篇文章对您有帮助,欢迎点赞收藏评论支持我,谢谢!

我的公众号:算法小哥克里斯,欢迎来撩!