-

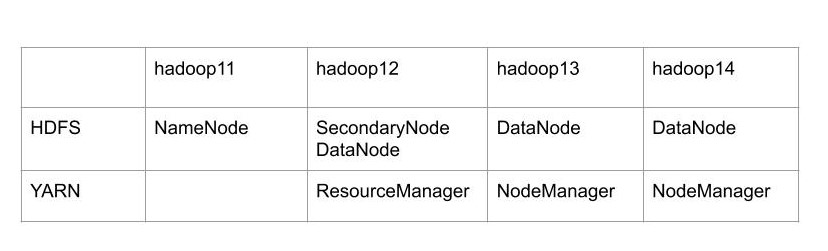

集群规划

-

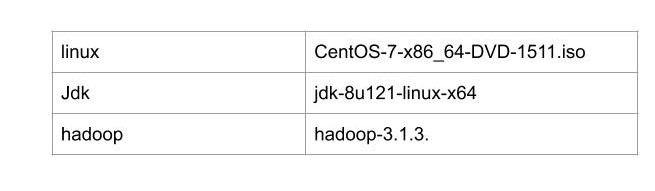

使用版本

-

上传hadoop、jdk到hadoop11节点上

-

HDFS修改

-

修改core-site.xml

<!-- 指定namenode节点--> <property> <name>fs.defaultFS</name> <value>hdfs://hadoop11:9820</value> </property> <!--指定文件的存储目录--> <property> <name>hadoop.tmp.dir</name> <value>/opt/modules/hadoop/data/tmp</value> </property> -

修改hdfs-site.xml

<!--副本数--> <property>` <name>dfs.replication</name> <value>3</value> </property> <!--secondarynamenode节点--> <property> <name>dfs.namenode.secondary.http-address</name> <value>hadoop12:9868</value> </property> -

hadoop-env.sh

export JAVA_HOME=/opt/modules/jdk export HDFS_NAMENODE_USER=can export HDFS_DATANODE_USER=can export HDFS_SECONDARYNAMENODE_USER=can -

workers

hadoop12

hadoop13

hadoop14

-

-

YARN修改

-

yarn-env.sh

export JAVA_HOME=/opt/modules/jdk -

yarn-site.xml

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property>

-

-

MapReduce

-

mapred-env.sh

export JAVA_HOME=/opt/modules/jdk -

mapred-site.xml

<property> <name>mapreduce.framework.name</name> <value>yarn</value> </property>

-

-

向其他节点分发文件

使用scp 或者 rsync 都可以

-

启动

-

第一次启动需要格式化NameNode

bin/hdfs namenode -format -

启动hdfs

sbin/start-dfs.sh

-

启动yarn(resourcemanager节点启动)

sbin/start-yarn.sh

-

-

测试

浏览器打开hadoop11:9870 可以看到HDFS概况

-