- 论文题目:Addressing Function Approximation Error in Actor-Critic Methods

所解决的问题?

value-base的强化学习值函数的近似估计会过估计值函数(DQN),作者将Double Q-Learning处理过拟合的思想引入actor critic算法中。(过估计的问题就在于累计误差会使得某些不好的state的value变地很高(exploration 不充分所导致的))。还花了很大的心血在处理过估计问题修正后带来的方差过高的问题。

作者将过估计的问题引入到continuous action space中,在continuous action space中处理过估计问题的难点在于policy的change非常缓慢,导致current和target的value差距不大, too similar to avoid maximization bias。

背景

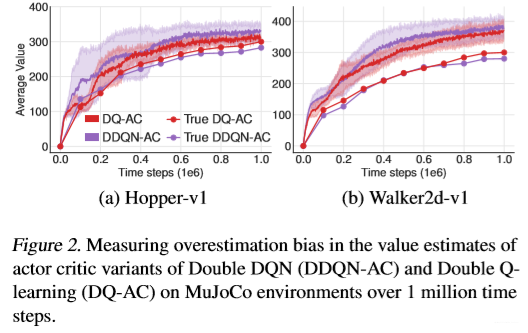

以往的算法解决过估计问题的就是Double Q Learning那一套,但是这种方法虽然说会降低bias但是会引入高的variance(在选择下一个时刻s‘的action的时候,不确定性变得更大才将以往DQN中max这一步变得不是那么max,与之带来的问题就是方差会变大),仍然会对policy的优化起负面作用。作者是用clipped double q learning来解决这个问题。

所采用的方法?

作者所采用的很多components用于减少方差:

DQN中的target network用于variance reduction by reducing the accumulation of errors(不使用target network的使用是振荡更新的)。- 为了解决

value和policy耦合的关系,提出了延迟更新(delaying policy updates)的方式。(to address the coupling of value and policy, we propose delaying policy updates until the value estimate has converged) - 提出了

novel regularization的更新方式SARSA-style( the variance reduction by averaging over valueestimates)。这种方法参考的是18年Nachum的将值函数smooth能够减少方差的算法。

- Nachum, O., Norouzi, M., Tucker, G., and Schuurmans, D. Smoothed action value functions for learning gaussian policies. arXiv preprint arXiv:1803.02348, 2018.

当然multi-step return也能够去权衡方差与偏差之间的关系,还有一些放在文末扩展阅读里面了。

作者将上述修正方法用于Deep Deterministic Policy Gradient算法中并将其命名为Twin Delayed Deep Deterministic policy gradient (TD3)算法中。一种考虑了在policy和value 函数近似过程中所带来的一些误差对AC框架所带来的影响。

前人算法回顾

首先回顾一下DPG算法的更新公式:

其中 ,

可以用参数

近似,在

DQN中还使用了frozen target network ,更新的目标为:

如果受误差 干扰,则有:

在AC框架下,用表示

actor能获得近似值函数的近似策略参数(

所对应的那个策略参数),

表示actor能获得真实准确

的参数(which is not known during learning)。

其中 ,

是梯度归一化参数,有

。这里做归一化的原因就是更容易保证收敛(Without normalized gradients, overestimation bias is still guaranteed to occur with slightly stricter conditions. )。

由于梯度方向是局部最大化的方向,存在一个足够小的 ,使得

时

approximate value of 会有一个下界

approximate value of (

approximate 会存在过估计问题,就是下面这个式子所描述的)。

相反的,存在一个足够小的 使得

时,

the true value of 会有一个上界

the true value of (

approximate policy所得出来的动作在真实的action value function中无法达到最优):

the value estimate 会大于等于true value ,三式联立有:

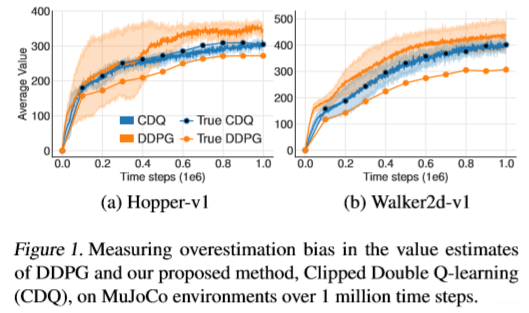

Clipped Double Q-Learning

Double DQN中的target:

Double Q-learning :

Clipped Double Q-learning:

这里的指的是

target actor(可参见伪代码,只用了一个actor)。这种方法会underestimation bias,由于underestimation bias 这种方法就需要加大探索度,不然算法的效率就会很低。

如果 ,那么就相当于辅助的

没用到,那么就

no additional bias;如果 那么就会取到

,作者原文附录里面有证明收敛性。

Addressing Variance

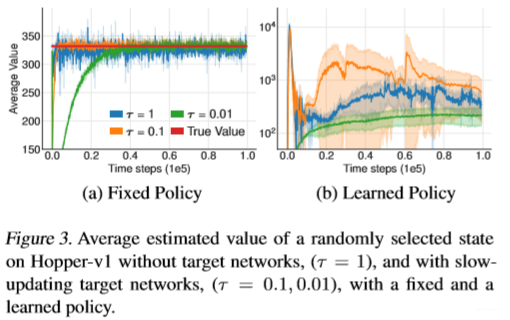

设置target network用于减小policy更新所带的的方差,不然state value approx会很容易发散,不收敛。

作者使用policy相比于value做延迟更新(Delayed Policy Updates),这样保证策略更新的时候,先将TD误差最小化,这样不会使得policy更新的时候受误差影响,导致其方差高。

Target Policy Smoothing Regularization

作者认为similar actions should have similar value,所以对某个action周围加上少许噪声能够使得模型泛化能力更强。

相似的想法在Nachum et al.(2018)上也有设计,不过是smoothing ,不是

。

- Nachum, O., Norouzi, M., Tucker, G., and Schuurmans, D. Smoothed action value functions for learning gaussian policies. arXiv preprint arXiv:1803.02348, 2018.

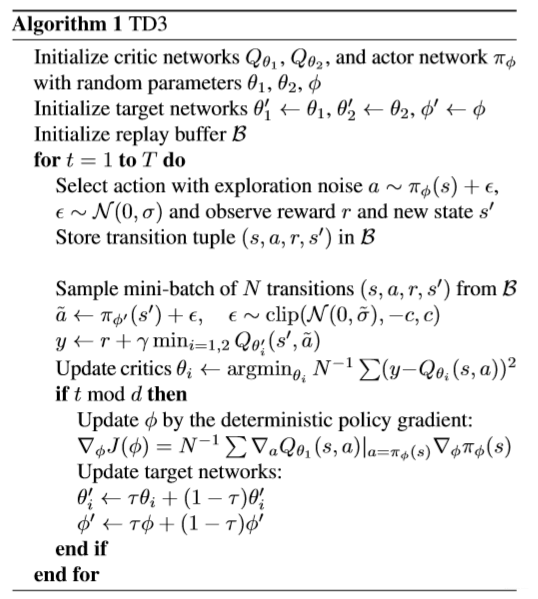

算法伪代码:

取得的效果?

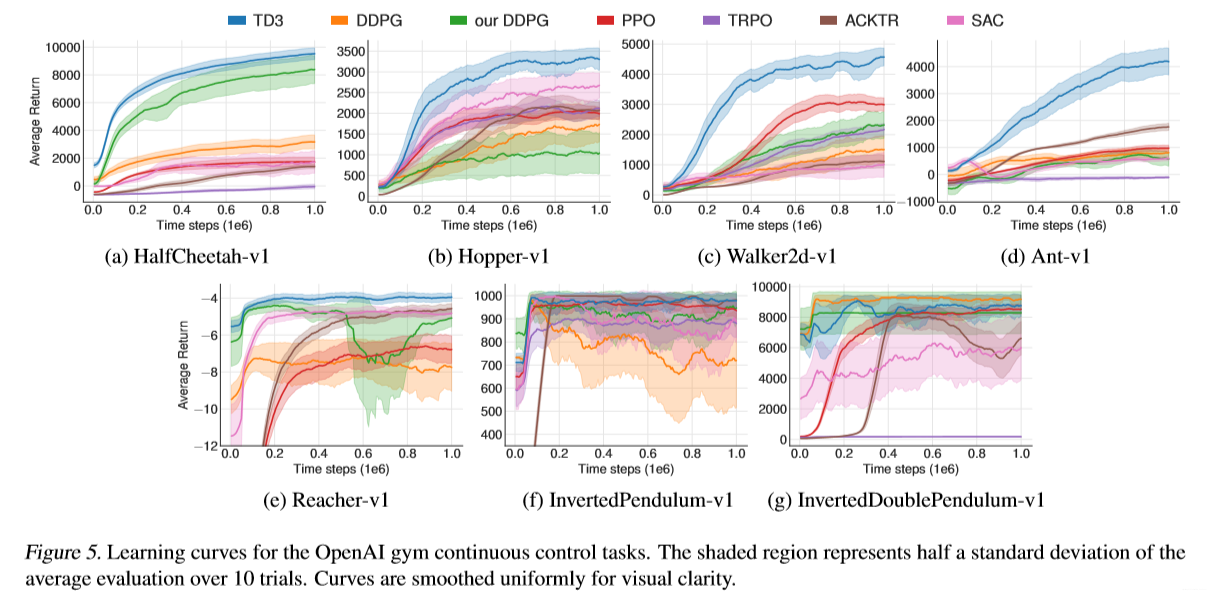

作者与当前的sota算法对比,结果如下:

作者还验证了target neteork对收敛性的影响:

最终的实验:

所出版信息?作者信息?

ICML2018上的一篇文章,Scott Fujimoto is a PhD student at McGill University and Mila. He is the author of TD3 as well as some of the recent developments in batch deep reinforcement learning.

他还有俩篇论文比较有意思:Off-Policy Deep Reinforcement Learning without Exploration;Benchmarking Batch Deep Reinforcement Learning Algorithms。

扩展阅读

作者为了验证论文的复现性,参考了2017年Henderson, P的文章实验了很多随机种子。

- 参考文献:Henderson, P., Islam, R., Bachman, P., Pineau, J., Precup, D., and Meger, D. Deep Reinforcement Learning that Matters. arXiv preprint arXiv:1709.06560, 2017

还有一些平衡bias和variance的方法,比如:

- importance sampling

- Precup, D., Sutton, R. S., and Dasgupta, S. Off-policy temporal-difference learning with function approximation. In International Conference on Machine Learning, pp. 417–424, 2001.

- Munos, R., Stepleton, T., Harutyunyan, A., and Bellemare, M. Safe and efficient off-policy reinforcement learning. In Advances in Neural Information Processing Systems, pp. 1054–1062, 2016.

- distributed methods

- Mnih, V., Badia, A. P., Mirza, M., Graves, A., Lillicrap, T., Harley, T., Silver, D., and Kavukcuoglu, K. Asynchronous methods for deep reinforcement learning. In Internationa lConference on Machine Learning, pp.1928– 1937, 2016.

- Espeholt, L., Soyer, H., Munos, R., Simonyan, K., Mnih, V., Ward, T., Doron, Y., Firoiu, V., Harley, T., Dunning, I., et al. Impala: Scalable distributed deep-rl with importance weighted actor-learner architectures. arXiv preprint arXiv:1802.01561, 2018.

- approximate bounds

- He, F. S., Liu, Y., Schwing, A. G., and Peng, J. Learning to play in a day: Faster deep reinforcement learning by optimality tightening. arXiv preprint arXiv:1611.01606, 2016.

- reduce discount factor to reduce the contribution of each error

- Petrik, M. and Scherrer, B. Biasing approximate dynamic programming with a lower discount factor. In Advancesin Neural Information Processing Systems, pp. 1265–1272, 2009.

我的微信公众号名称:深度学习与先进智能决策 微信公众号ID:MultiAgent1024 公众号介绍:主要研究分享深度学习、机器博弈、强化学习等相关内容!期待您的关注,欢迎一起学习交流进步!