其它机器学习、深度学习算法的全面系统讲解可以阅读《机器学习-原理、算法与应用》,清华大学出版社,雷明著,由SIGAI公众号作者倾力打造。

本文PDF全文链接:机器学习与深度学习中的数学

清华科技大讲堂是清华大学出版社创建的直播栏目,每周邀请业界知名的教授、专家针对前沿技术、IT 人才培养等话题与观众进行深入交流。雷明老师近日受邀在清华大学出版社参加直播录制,借助此次活动,与大家一起探讨机器学习与深度学习中的数学部分。很多同学都观看了直播,热度非常高,特此将直播讲稿发布,希望能帮助同学们更快进步。

雷明清华大学出版社《机器学习-原理、 算法与应用》作者

2009年毕业于清华大学计算机系,研究方向为计算机视觉/机器学习, 发表论文数篇,曾就职于百度,任软件工程师/项目经理;zmodo/meshare, 任CTO(创业)2018年创立SIGAI,致力于研发机器视觉、深度强化学习框架, 用标准化的算法为各个行业赋能,目前已经应用于物流,商业,国防等领域

内容提要

需要哪些数学知识

微积分

线性代数与矩阵论

概率论

信息论

最优化方法

随机过程

图论

需要哪些数学知识

现状分析

数学是给机器学习、 深度学习的初学者和进阶者造成困难的主要原因之一

国内本科数学教学方式、 学生学习质量上存在的不足-过于抽象,偏重于计算,忽视了对数学思维、 建模能力的培养-清华大学换用国外线性代数教材事件, 如果结合一些具体的例子来讲解会好很多

某些数学知识超出了本科一般理工科专业的范畴 - 矩阵论/矩阵分析,信息论,最优化方法,随机过程,图论

通常情况下, 高校、 其他机构在教《机器学习》 、《深度学习》 之前不会为学生把这些数学知识补齐学生普遍对数学存在一种恐惧心理, 数学自信的人只占少部分

究竟需要哪些数学知识?

1.微积分-一元函数微积分,多元函数微积分, 是整个高等数学的基石

2.线性代数与矩阵论-矩阵论本科一般不讲

3.概率论-内容基本已经覆盖机器学习的要求

4.信息论 - 一般专业不会讲,如果掌握了概率论, 理解起来并不难

5.最优化方法 - 学了这门课的学生非常少, 但对机器学习、深度学习非常重要,几乎所有算法归结为求解优化问题

6.随机过程-本科一般不学,但在机器学习中经常会使用,如马尔可夫过程,高斯过程,后者应用于贝叶斯优化

7.图论-计算机类专业本科通常会学,但没有学谱图理论

第1部分-微积分

为什么需要微积分?

研究函数的性质 - 单调性, 凹凸性

求解函数的极值

概率论、 信息论、 最优化方法等的基础

一元函数微积分

极限 - 微积分的基石, 数列的极限, 函数的极限

函数的连续性与间断点

上确界与下确界

Lipschitz连续性

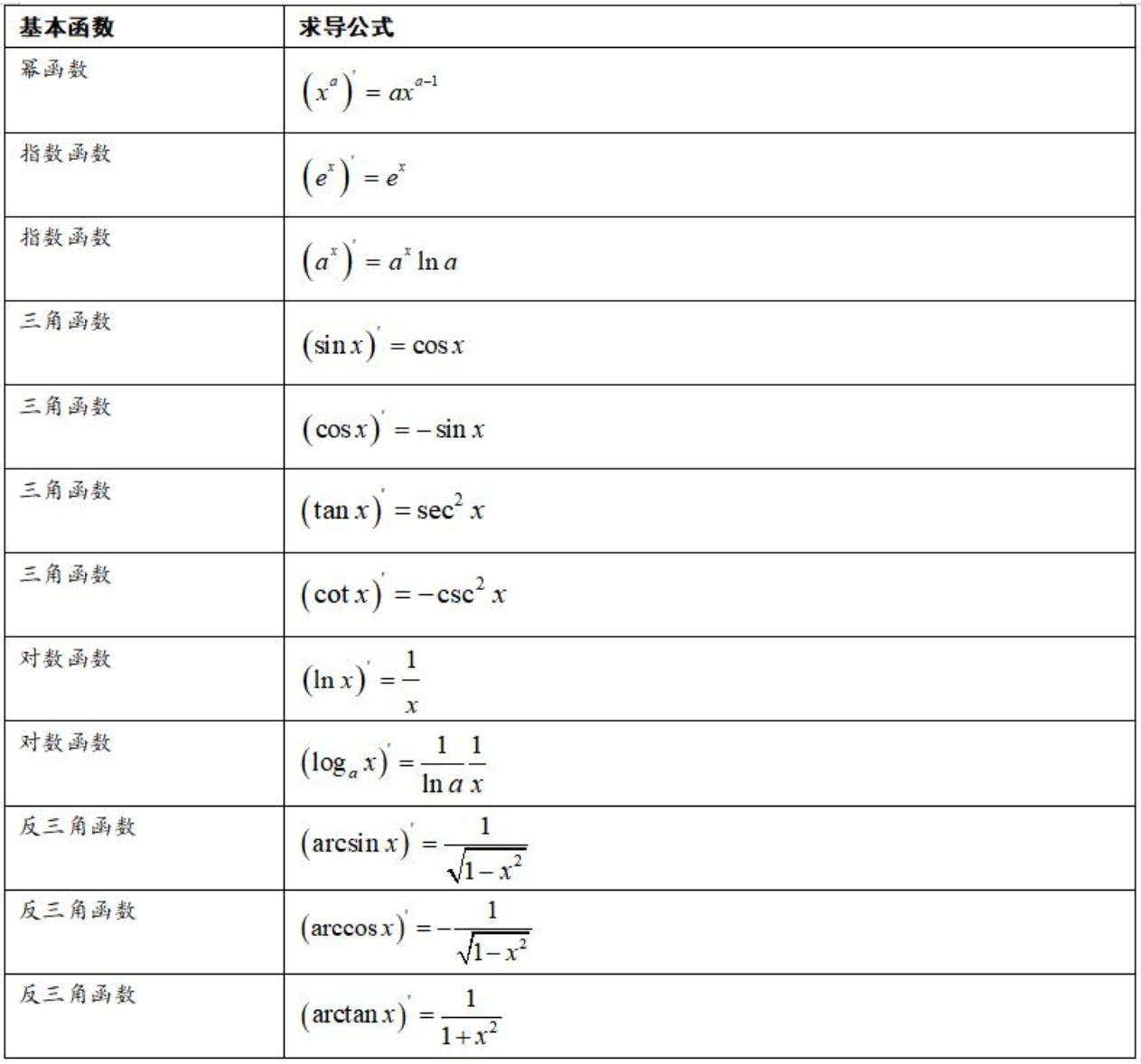

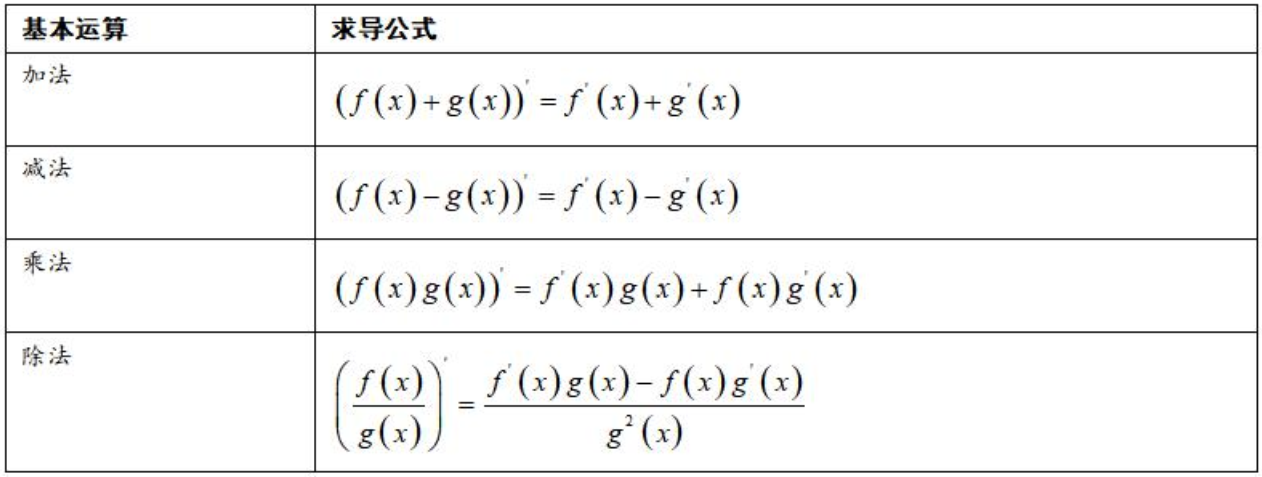

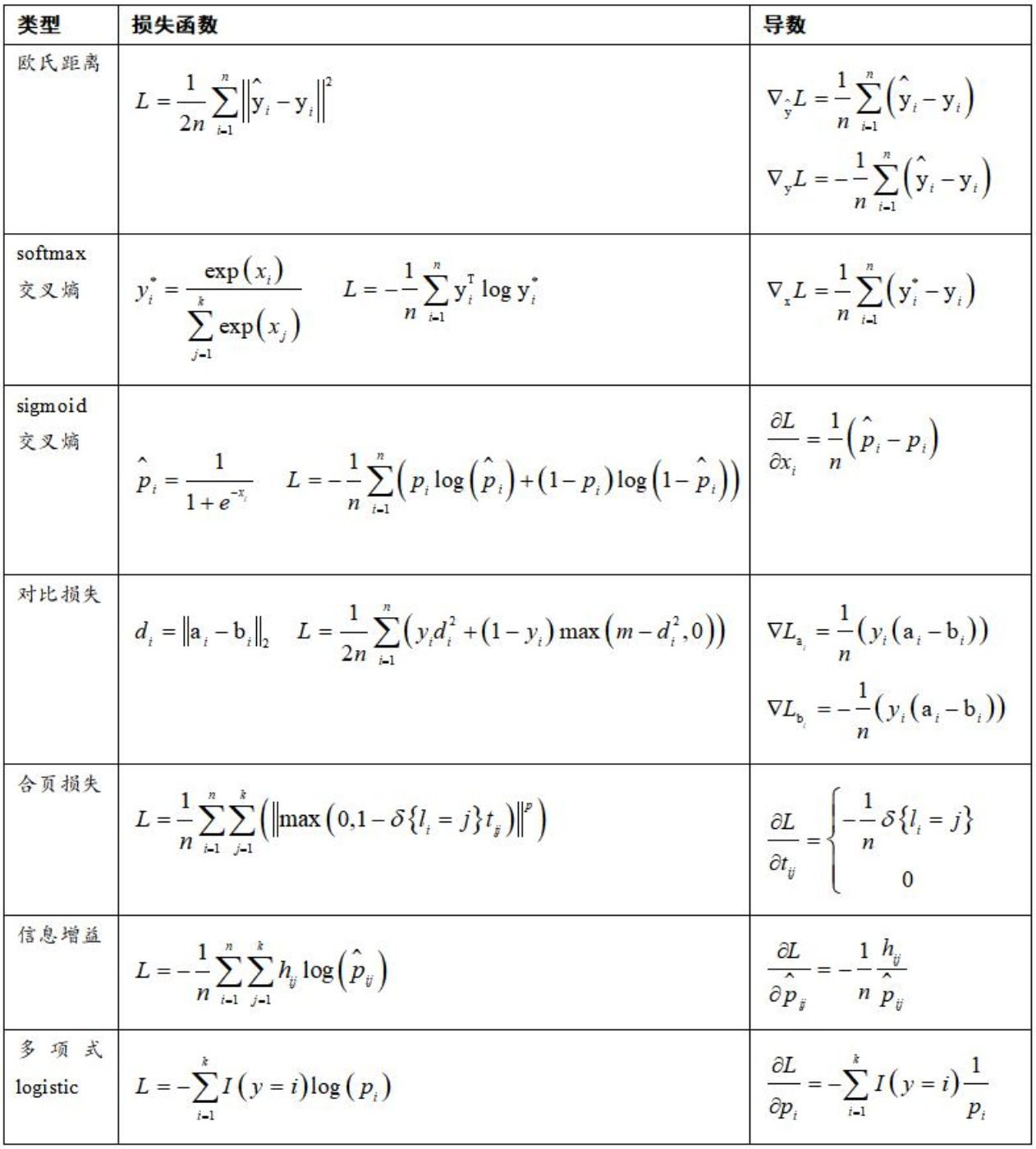

导数,一阶导数,高阶导数,导数的计算-符号微分,数值微分,自动微分

导数与函数的性质,单调性,极值,凹凸性

泰勒公式

不定积分及其计算

定积分及其计算

广义积分及其计算

常微分方程的基本概念

常系数线性微分方程的求解

复合函数的求导公式

一元函数的泰勒公式-连接一元函数微分学各知识点的桥梁

多元函数微积分

偏导数的定义与计算

梯度的定义与性质

方向导数的定义与性质

高阶偏导数的计算

链式法则 - 熟练计算多元函数的偏导数

雅克比矩阵 - 链式法则的矩阵形式

Hessian矩阵与多元函数的极值, 凹凸性

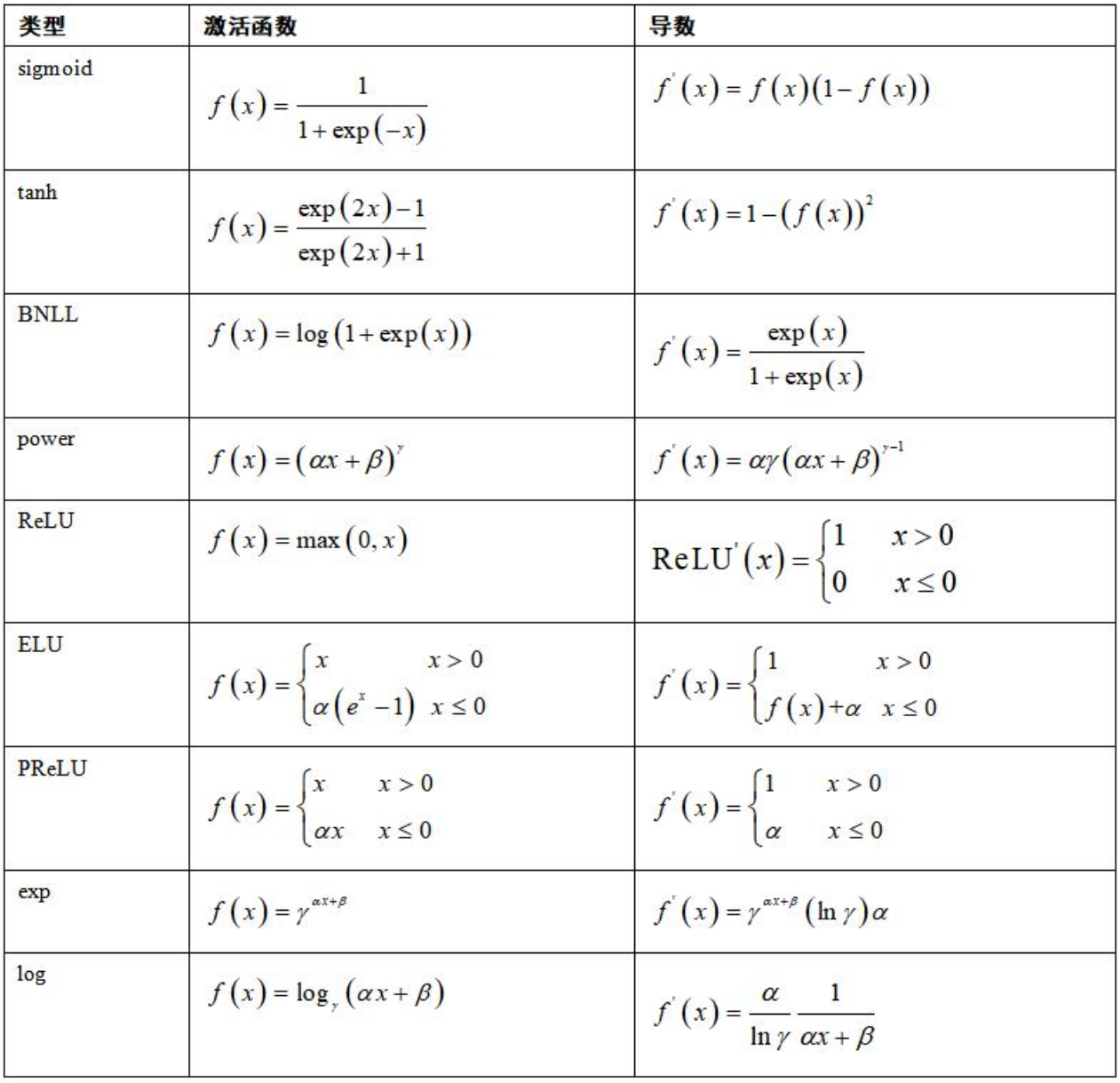

向量与矩阵求导公式

多元函数的泰勒公式

重积分 二重积分,三重积分,n重积分,多重积分的坐标变换

偏微分方程的基本概念

链式法则的矩阵形式

多元函数的泰勒公式-连接多元函数微分学各知识点的桥梁

第2部分-线性代数与矩阵论

为什么需要线性代数?

机器学习算法的输入、输出、中间结果,通常为向量,矩阵,张量

简化问题的表达

与微积分结合, 研究多元函数的性质, 也是概率论中随机向量的基础

在图论中亦有应用 - 图的拉普拉斯矩阵

在随机过程中同样有应用 - 状态转移矩阵

向量的定义与基本运算,向量的范数

线性相关性

向量空间

矩阵的定义及其运算

矩阵的范数

线性变换

行列式的定义与计算

线性方程组 齐次,非齐次

特征值与特征值向量

广义特征值

Rayleigh商

谱与条件数

二次型与标准型

Cholesky分解

特征值分解

奇异值分解

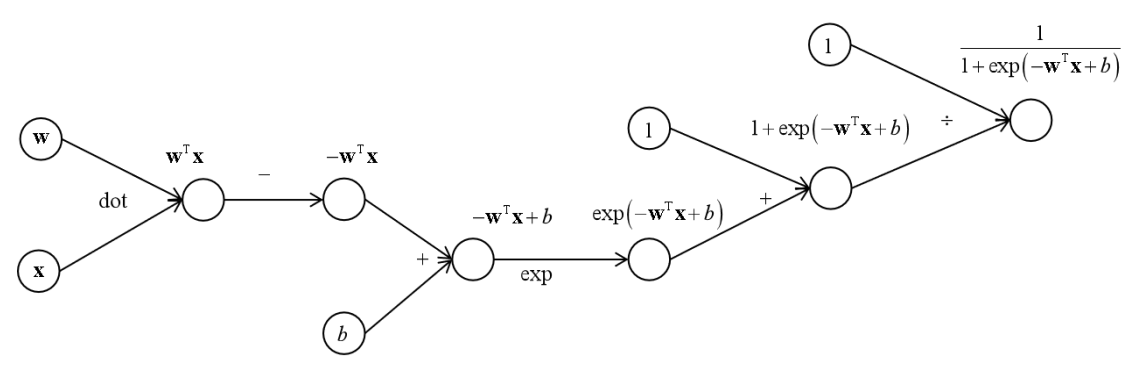

正向传播算法

反向传播算法

主成分分析

拉普拉斯特征映射

局部保持投影

第3部分-概率论

为什么需要概率论?

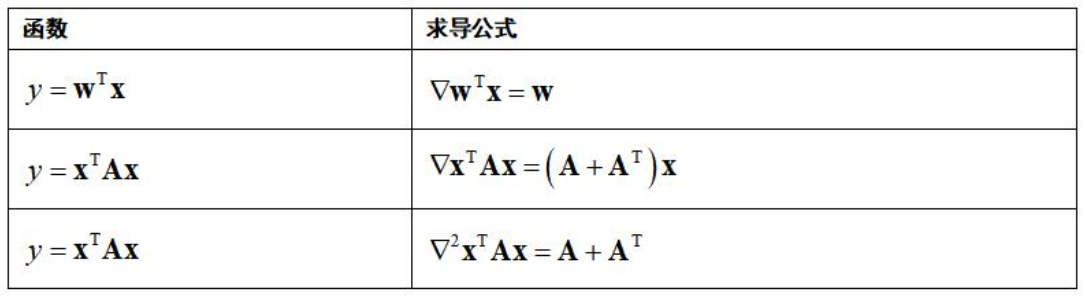

将机器学习算法的输入、输出看作随机变量/向量, 用概率论的观点进行建模

对不确定性进行建模

挖掘变量之间的概率依赖关系

随机算法 - 蒙特卡洛算法, 遗传算法

随机数生成 - 基本随机数生成, 采样算法

随机事件与概率

条件概率

全概率公式

贝叶斯公式

条件独立

离散型随机变量

连续型随机变量

数学期望与方差,标准差

Jesen不等式

Hoeffding不等式

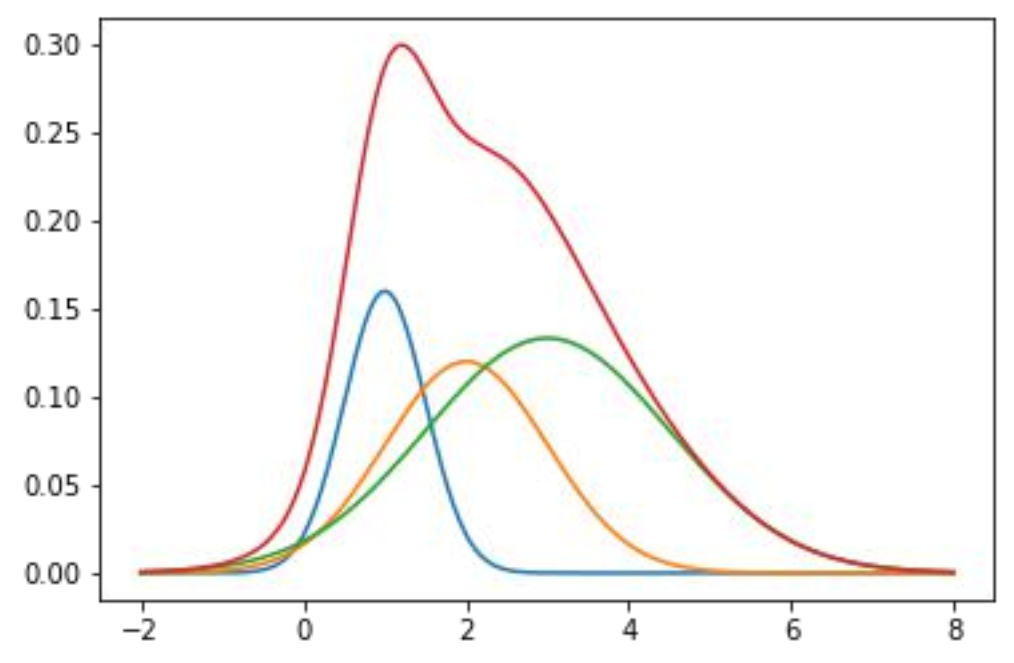

常用概率分布 均匀分布,伯努利分布,二项分布, 多项分布,正态分布,狄拉克分布, t分布

随机变量函数

逆变换算法

离散型随机向量

连续型随机向量

联合期望

协方差

常用概率分布 均匀分布,正态分布

分布变换

极限定理 切比雪夫不等式, 大数定律, 中心极限定理

参数估计 最大似然估计,最大后验概率估计, 贝叶斯估计,核密度估计

随机算法 基本随机数生成, 遗传算法, 蒙特卡洛算法

采样算法 拒绝采样,重要性采样

贝叶斯分类器

第4部分-信息论

香浓熵

交叉熵

KL散度

JS散度

联合熵

互信息

条件熵

softmax回归

流形学习-SNE降维

生成对抗网络

第5部分-最优化方法

基本概念 问题定义, 迭代法的基本思想

梯度下降法

最速下降法

梯度下降法的各种改进 AdaGrad,AdaDelta, Adam

随机梯度下降法

牛顿法

拟牛顿法 DFP, BFGS, L-BFGS

分治法 坐标下降法, 分阶段优化

凸优化 定义与性质

拉格朗日乘数法

拉格朗日对偶

KKT条件

多目标优化 基本概念, 求解算法

泛函与变分

Euler-Lagrange方程

神经网络的训练

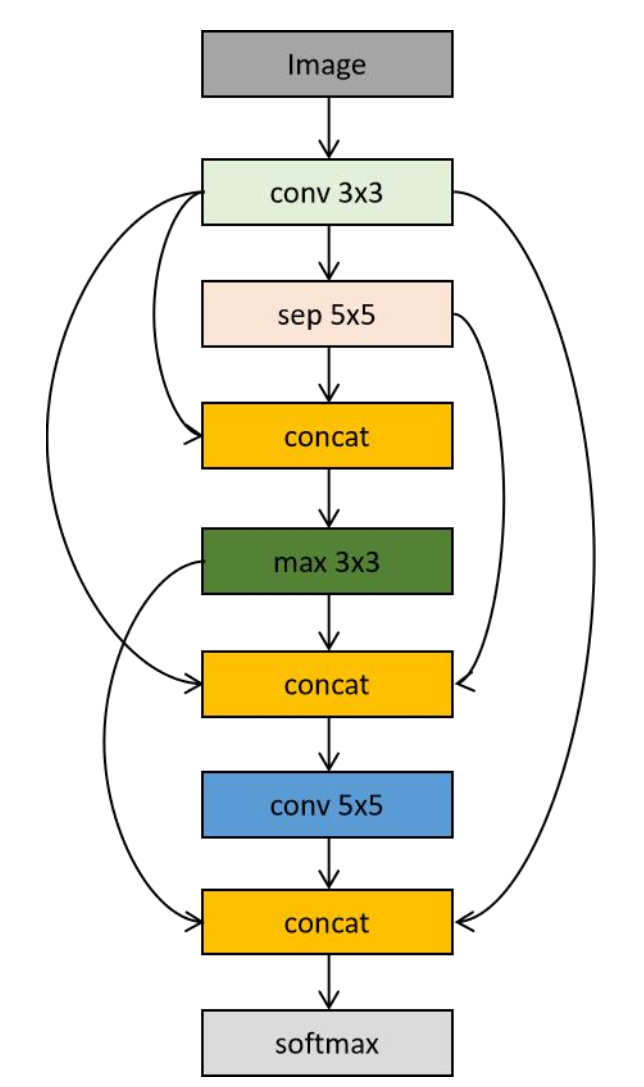

多目标神经结构搜索

证明两点之间直线最短

第6部分-随机过程

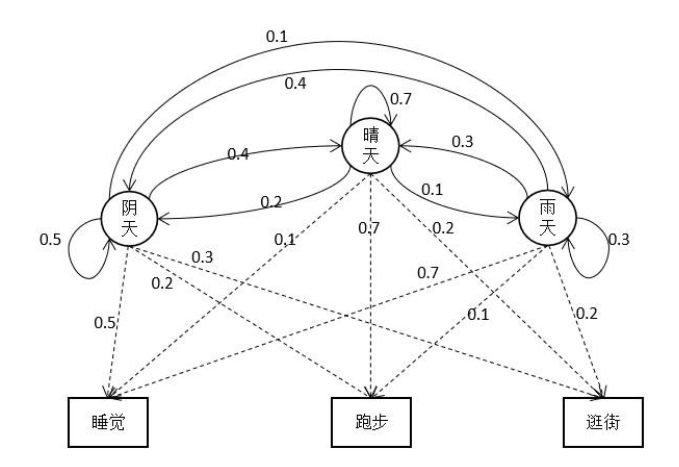

马尔可夫性

马尔可夫链

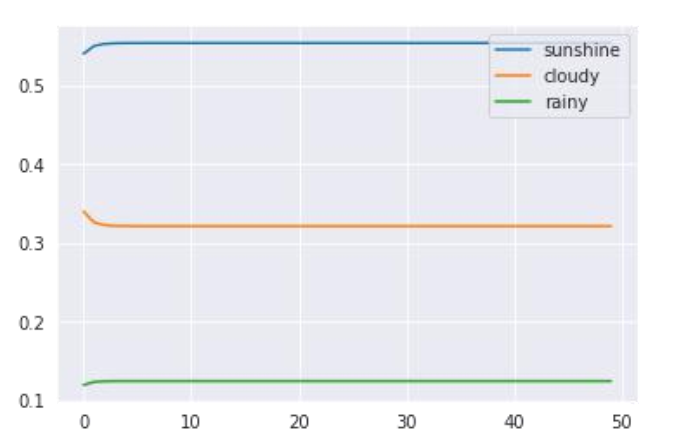

平稳分布

细致平稳条件

马尔可夫链采样算法

Metropolis-Hastings算法

Gibbs采样

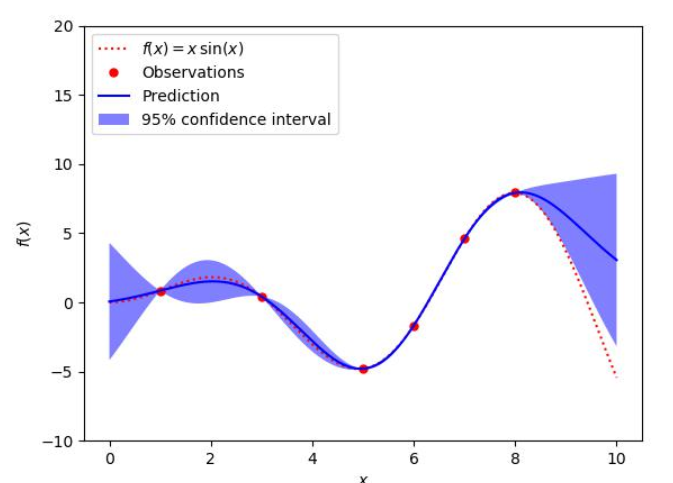

高斯过程

高斯过程回归

贝叶斯优化

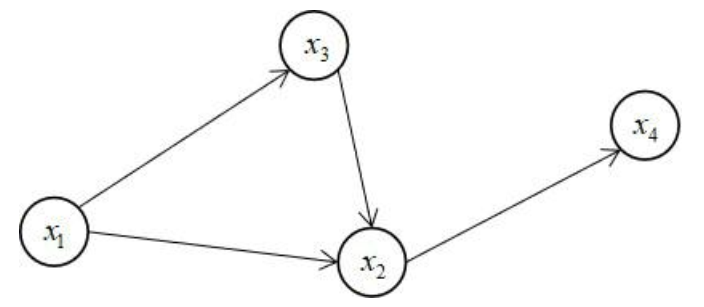

第7部分-图论

基本概念

图的矩阵表示

特殊的图 联通图, 二部图, 有向无环图

Dijkstra算法

拉普拉斯矩阵

归一化拉普拉斯矩阵

本文可以配合《机器学习-原理,算法与应用》一书阅读,本文列出的数学知识点已经写成了《机器学习的数学教程》,以后有机会的话可能会出版,以帮助大家学习。此讲稿可用于高校的机器学习与深度学习中的数学部分教学并免费提供给高校教师使用,以及在职人员面试准备时使用。