在 GDG 组织的 DevFest 2018 上,声网Agora 首席科学家钟声与在座的上千位开发者分享了演讲《Deep Learning for MobilePlatforms: Complexity and Performance Analysis》。以下是由 GDG 整理发布的演讲实录。

欢迎访问 RTC 开发者社区,与更多实时音视频、编解码技术开发者交流经验。

关于演讲者

演讲实录

开场白

最近在微信群里看到一张很有意思的图,大家应该都见过大街小巷地铁站旁边的手机贴膜吧?但这张图的牌子上写的不是「手机贴膜」而是「模型调参」。用这个例子虽然有些不恰当,但人工智能学习算法确实正在成为我们生存的必杀技,可见人工智能有多火。

从 AI 的应用开始

回到我们今天的主题,我想问,今天的午餐和深度学习有什么共同之处?餐盒和黑盒,都是盒子。餐盒有一个沙拉、主菜和餐后的水果。黑盒子打不开、看不到。

今天的演讲试图稍稍进入黑盒里能看一下,作为工程师,我们都想知其然,也知其所以然。我就基于我们所做的工作稍稍解密一下深度学习某些方面。

声网主要提供实时音视频通信传输服务、编解码及前后处理等等,我们更多的聚焦在通信实时交互领域。

现在的社交娱乐应用里面有很多 AI 的应用。美颜,贴纸,包括一些交互动作的识别,变脸、变声都是属于风格转换,AI 算法在这些方面有很好的应用。

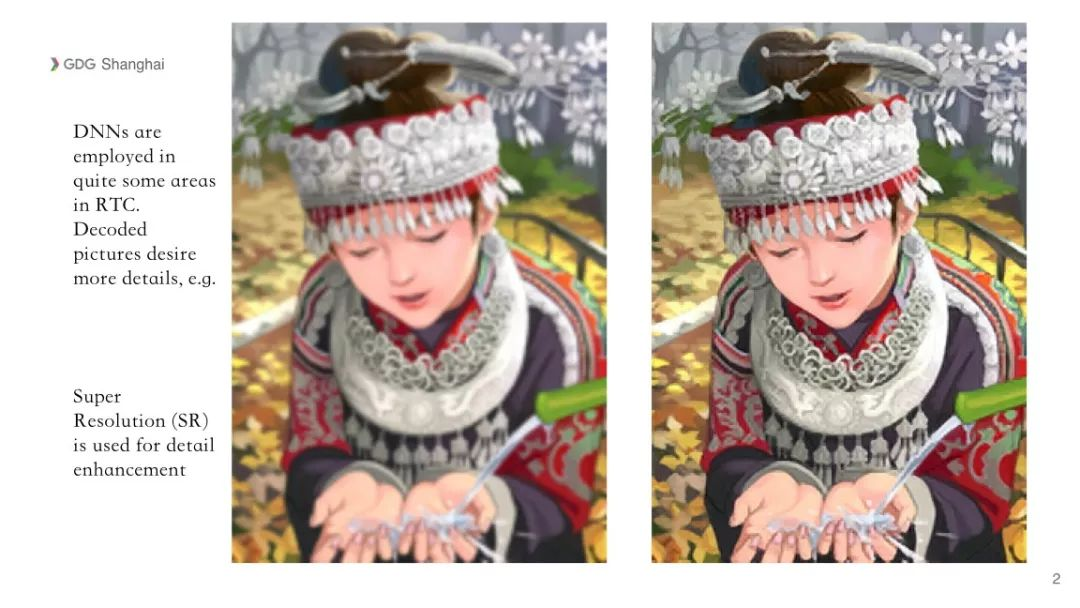

除了这些,AI 在后处理端也有很多应用。比如如何提升比较模糊的图像的细节,更清晰地呈现给大家,提高收视的体验;又比如由于网络传输线路上有丢包,接收的数据有失真,这个也可以利用 AI 算法来补偿。

AI 在云端也有更多的应用,比如内容的监管,比如黄色图片的鉴别,以及识别暴力图像,还有语音变成文本,以及情感计算等等,这些很多在实时通信领域里有非常好的应用。

超分辨率恢复模糊图像

下面以恢复模糊图像作为一个例子,介绍人工智能的深度算法和应用。

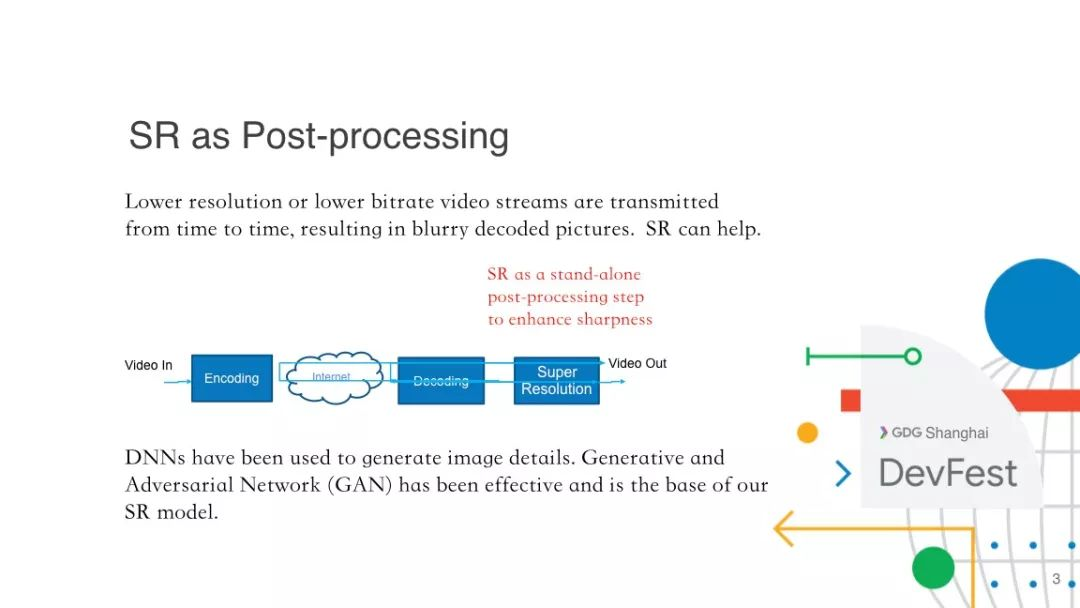

我们都知道超分辨率(超分,SR)对恢复细节有帮助。在我们的场景下,由于网络带宽受限,会产生丢包,因而此时会以低码率压缩和传输图像,解码出来的图像通常是会模糊一点,影响收视体验。尤其是在直播应用里,用户希望看到清晰的面容和听到清晰的声音。

超分是我们后处理的一步,作为跟前面的处理不相关的一个处理,这一步放在最后。视频源经过编码在网络上传输,解码器收到后经过解码出来是一个模糊的图像,经过超分辨率处理把细节提升或者放大,再显示出来。

深度神经网络已经被证明了可以较好地生成图像的细节。GAN 模型是一个非常有效的模型,它也是我们超分算法的基础模型,接下来主要是以 GAN 来做性能和复杂度的分析。

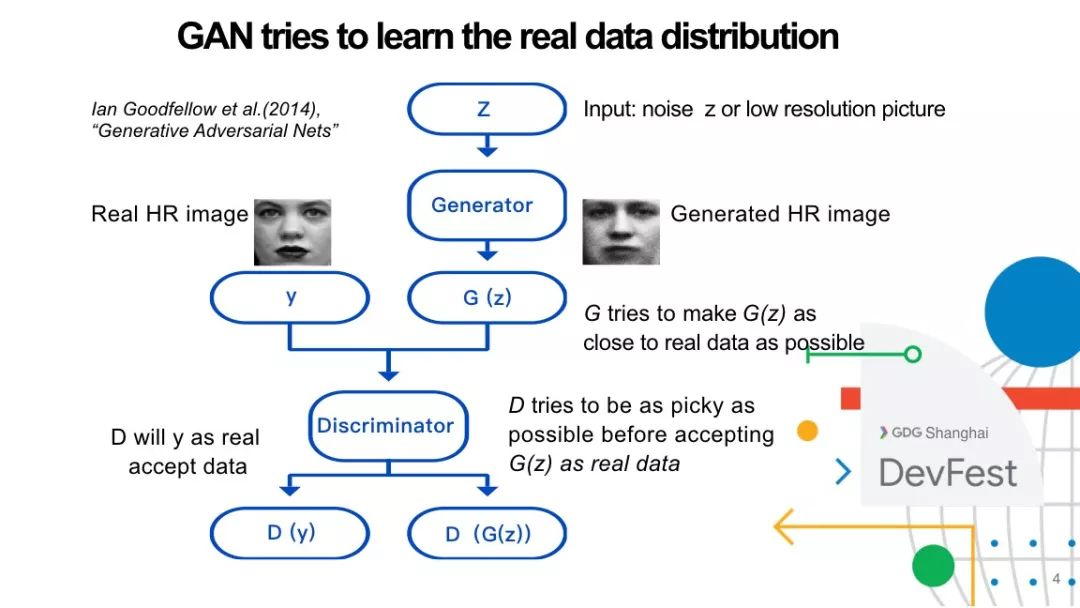

GAN 模型

下面介绍一下GAN 的基本思路。它通常包含两个网络,一个是生成器,一个是判别器,这两个模型以又合作又对抗的方式运作,最后达到一个平衡,使得生成器能够产生以假乱真的数据,例如:

当判别器接收到的是真实的图像数据,判别器会把它接受为一个真实的数据。

当生成器输入的是一个低分辨率的数据,我们想生成高清的数据,希望生成器出来的数据像真的一样。但判别器的任务正好相反,它尽量不让生成的数据蒙混过关,并且要把它踢出去。

一旦被区别出来之后,生成器会反复训练、调参,使得生成的数据更像真的;判别器也会反复训练、努力提高自己的能力,鉴别假数据的能力越来越强。可谓道高一尺魔高一丈,最后二者收敛的时候判别器再也不能区分生成器生成出来的数据是真的还是假的,这个时候的结果就被判别器接受了。

最近几年在顶级 AI 会议上,三分之二以上的文章可能跟GAN有关的。

如何设计小且优的深度学习模型?

众所周知深度学习最好的结果是采用比较大的模型,在比较大的机器平台,比如说服务器,有成千上万的 GPU作并行处理来训练,并且需要有非常大量的训练数据集。

但是现在针对移动设备的应用很多,我们做移动社交、做直播、通讯,面临的挑战是要设计一个小的模型,最好能满足下面三个条件:

这个小模型能够在移动设备上实时地跑,并且不会消耗太多功耗,不会引起发热等等问题。

另外它的结果还要足够好,不能因为模型做小了而没有效果,这个没有意义。

训练要能够基于比较合理数量的数据集就能够取得好的效果,要上百万个甚至上千万个数据往往不够现实,因为数据收集的成本太高。

接下来我们作复杂性分析,我们的目标是缩小模型。来看一些典型的模型,经典的一些作图像分析和识别的深度神经网络,像 VGG 模型,是很大的模型,它的参数个数,也就是权重的个数,是衡量这个模型复杂性的一个重要指标。

VGG16 模型有一亿多个参数。为了在移动平台能够运行,业界做了大量的工作,这些工作包括把这个模型做剪枝、压缩和重新训练模型等,也有通过更复杂的技术,比如通过强化学习来达成一个更小的模型。这些方法都有一些潜在的问题,比如最终出来的结构不够简单,计算量仍然不够少,或者不易于并行实现等。

谷歌在这方面也做了很好的工作,最新的结果是 MobileNet v2 的 340 万个参数,不到 VGG16 参数个数的 3%,缩小了很多,将近两个数量级,非常小。但是对我们来说,340 万个参数的模型还是很大,尤其在移动设备上以软件实现仍不是很理想,当然我们的任务有点不一样,我们是做图像超分,而上述模型是做做物体识别的。

基于 ReLU 的 CNN

我们来看一下基于 ReLU 的 CNN,实际上是分段线性函数,这个很容易理解,尤其是当stride 为1的时候,分段线性的映射还是保持的。

为了更好地理解下面的内容,我再介绍一个概念,就是流型。举个例子来说流型比较容易理解,比如关于人脸的图像,虽然可以是在 1000×1000 个大的尺寸上,有一百万个像素点,但真正表征人脸不需要一百万个点,一两百个参数就可以,实际上在比较低维的一个空间里即可以表征出来,这个过程就是从它的背景空间映射到它的参数空间,或者称为隐空间的过程,这实际上是一个编码的过程,是一个降维处理。

反过来从这个低维空间到高维空间是一个解码的过程,是一个生成器。一般来说编码是把数据压缩到更低维的参数空间,叫隐空间。存在一个映射,从高维流型到低维的空间之间,正映射和逆映射都是连续的,这就是同胚映射。我们想隐空间这个低维的参数空间里做些操作。

刚才说过深度学习实际上是一个分段线性的映射,它是对流型的一个分段线性的逼近,比如这个模型比较简单的时候,它是以两条线来逼近,模型复杂的时候以四条线來逼近,这时逼近的程度更高。实际上一个更复杂的深度学习网络能产生的效果更好,逼近的精度更高,当然它的复杂度也更高。

另外,不同的逼近方法达到的效果也不一样,换一个方式可能逼近的更好,实际上不同的权重对应不同的映射,对应不同的逼近效果,我们训练的过程就是在找一个最优化的逼近,至少是找一个局部最优化的逼近过程,使得它达到的效果某种意义上是最优的。精度是由逼近的质量来衡量的。

我把我们的结果报告一下,最后做到了只有万级的参数个数,比谷歌的用于移动设备的 MobileNet v2 模型还小了两个多数量级。声网模型不到它的 1%,进一步小了非常多。通常模型变小之后会有一个问题,GAN 本身隐含的问题就变得更突出,模式坍塌就是其中一个问题。

模式坍塌

模式坍塌是什么问题?生成器很难学习多模态的分布。举一个在圆环上的八个高斯分布的例子。生成器想学习这个分布,但是在一个简单模型的训练的过程及最后结果都只能收敛到其中一个高斯分布。用在实际应用的例子上,比如生成数字,我们期望它像第一行图像中这样能生成 0-9 的各个数字,但是很容易它就像第二行这样只能生成其中一个数字,比如总生成 1 或者某个含混难辩的数字,因为 1 容易在判别器那里蒙混过关,这虽然做对了,但是它生成不了别的数字,用处不大。

如何解决这个问题或者缓解这个问题呢?我们做了一系列的工作,简单来说,我们加了一些约束,加了对局域的约束,加了对切空间的约束,再加了对隐空间的优化,接下来不能一一讲述,就简单讲解一下对隐空间的优化。

隐空间的优化

刚才我提到过 DNN 实际上是把一个流型往隐空间或者参数空间做映射。一个图像通常被编码到一个低维的空间,就是隐空间。这里给大家做一个直观的解释,我们直接在这个编码空间,即隐空间里来做恢复,先在隐空间里均匀的去采样一些点,然后再通过这些点输入到生成器,生成器重构出来的图像点,把它们重叠到原来的图像上,有些恢复出来的点很密,但是有些地方比如头部脸部就很稀疏,这就意味着头部的恢复很差。生成器坍塌到一个局部最优,这个重构是很难或者不太容易得到很好的结果。当然我们可以更密集的取些采样点,最终头部也被覆盖到,但是代价会很大。

我们可以把这个隐空间先做优化,再在上面做均匀抽样,再把它输入进生成器,生成器出来,抽样点还是这么多,重构图像出来的重构点也是均匀的,也就是从这个点云里出来的东西也是均匀的。

打个比方,我们拿一张平的纸,使用各种不规则的方式任意折叠起来很多遍,你被要求在折叠起来的一团纸上抽取一定的采样点,然后把纸展开恢复平整后要求这些采样点是均匀的。这个很难,一般做不到,除非用暴力取足够多的点出来。但那样复杂性很高,与我们的目标相悖。我们想同时控制复杂性又控制效果。我们把类似的隐空间优化应用到了我们的模型训练里。因为我们最终模型的参数非常小,所以功耗在 iPhone7 上很少,另外手机也不会发热。效果基本上我们能做到,比如说一个 360P 的视频,出来的效果能够达到在 720P 的效果,能得到一个高清的效果。

我们未来还想从数学更多的理解一些深度网络,对某个点、某个问题上能够用数学的方式来描述,来进一步提高图像清晰度。这是我们未来要做的工作,谢谢大家。

最后给希望开发实时音视频App,或希望学习 WebRTC 的开发者推荐一些博文与资料